【NLP基础与技巧】:Scikit-learn中文本分析实战

发布时间: 2024-11-22 03:00:27 阅读量: 36 订阅数: 37

4wb044-基于springboot的智能笔记的开发与应用小程序_vue+uniapp.zip

# 1. NLP基础与技巧简介

自然语言处理(NLP)是计算机科学和人工智能中的一个分支,其目标是使计算机能够理解、解释和生成人类语言。NLP在信息检索、机器翻译、情感分析、聊天机器人等领域中具有广泛的应用。本章将概述NLP的基础知识,包括语言学基础、文本分析基本步骤和一些常用技巧。

## 1.1 NLP的基本概念

NLP的基本任务包括分词(Tokenization)、词性标注(Part-of-Speech Tagging)、命名实体识别(Named Entity Recognition, NER)、依存句法分析(Dependency Parsing)等。这些任务是后续复杂NLP应用的基础,例如,机器翻译和情感分析。

## 1.2 NLP的技术栈

在NLP技术栈中,除了经典的机器学习算法外,近年来深度学习技术,特别是基于Transformer的预训练模型(例如BERT、GPT等)已经取得了突破性的进展。这些模型能够学习丰富的语言特征并被用于下游NLP任务中。

## 1.3 NLP的实际应用

NLP技术已经广泛应用于多个实际场景中。例如,智能助手能够理解用户的语音指令并执行任务,情感分析帮助品牌理解消费者对其产品的看法,而机器翻译则促进了不同语言间的交流。

在接下来的章节中,我们将深入探讨如何使用Scikit-learn库来进行文本分析,包括文本预处理、特征提取、分类、聚类和主题模型等关键步骤。我们还将探讨NLP在深度学习方面的扩展应用以及Scikit-learn的高级功能。

# 2. Scikit-learn库与文本分析概述

## 2.1 NLP与机器学习的融合

### 2.1.1 NLP在机器学习中的重要性

自然语言处理(NLP)与机器学习的融合,为理解人类语言和执行相关任务打开了大门。NLP允许计算机从原始文本数据中提取有用信息、进行语言翻译、情感分析、文本分类以及构建智能聊天机器人等。这些任务的实现依赖于机器学习算法,它们可以从大量的语料中学习语言模式,并将其应用于新的语境中。

### 2.1.2 文本分析的机器学习方法

文本分析中常用的机器学习方法包括监督学习和无监督学习。监督学习方法如朴素贝叶斯、支持向量机(SVM)和随机森林等被用于文本分类任务,而无监督学习如K-Means聚类和主题模型LDA常用于发现文档集合中的主题和模式。Scikit-learn库为这些方法提供了丰富的实现,极大地简化了在文本数据上应用机器学习的过程。

## 2.2 Scikit-learn库的安装与配置

### 2.2.1 安装Scikit-learn的步骤

在开始使用Scikit-learn之前,确保你已经安装了Python环境。可以通过以下步骤安装Scikit-learn:

```bash

pip install -U scikit-learn

```

对于使用conda的用户,可以通过conda进行安装:

```bash

conda install scikit-learn

```

### 2.2.2 配置开发环境和验证安装

安装完Scikit-learn之后,配置开发环境并进行安装验证。在Python解释器中,尝试导入Scikit-learn并打印版本号:

```python

import sklearn

print(sklearn.__version__)

```

如果未出现错误,并且能够打印出版本号,说明Scikit-learn已正确安装。

## 2.3 Scikit-learn在文本分析中的角色

### 2.3.1 基本文本预处理工具

Scikit-learn为文本预处理提供了多种工具,例如`CountVectorizer`和`TfidfVectorizer`,它们可以将文本数据转换为数值型特征向量,从而适用于机器学习模型。下面是`CountVectorizer`的一个简单示例:

```python

from sklearn.feature_extraction.text import CountVectorizer

# 示例文本数据

documents = ['The sky is blue.', 'The sun is bright.', 'The sun in the sky is bright.']

# 创建向量化器实例

vectorizer = CountVectorizer()

# 将文本数据转换为词频矩阵

X = vectorizer.fit_transform(documents)

print(X.toarray())

```

### 2.3.2 文本特征提取方法

在特征提取方面,Scikit-learn提供了多种方式,如词袋模型、TF-IDF和Word Embeddings等。以下是一个使用TF-IDF特征提取的例子:

```python

from sklearn.feature_extraction.text import TfidfVectorizer

# 示例文本数据

documents = ['The sky is blue.', 'The sun is bright.', 'The sun in the sky is bright.']

# 创建TF-IDF向量化器实例

tfidf_vectorizer = TfidfVectorizer()

# 将文本数据转换为TF-IDF矩阵

X_tfidf = tfidf_vectorizer.fit_transform(documents)

print(X_tfidf.toarray())

```

通过这些文本分析的基木工具,我们能够轻松地将原始文本数据处理为适合机器学习模型的格式。

# 3. 文本预处理和特征提取

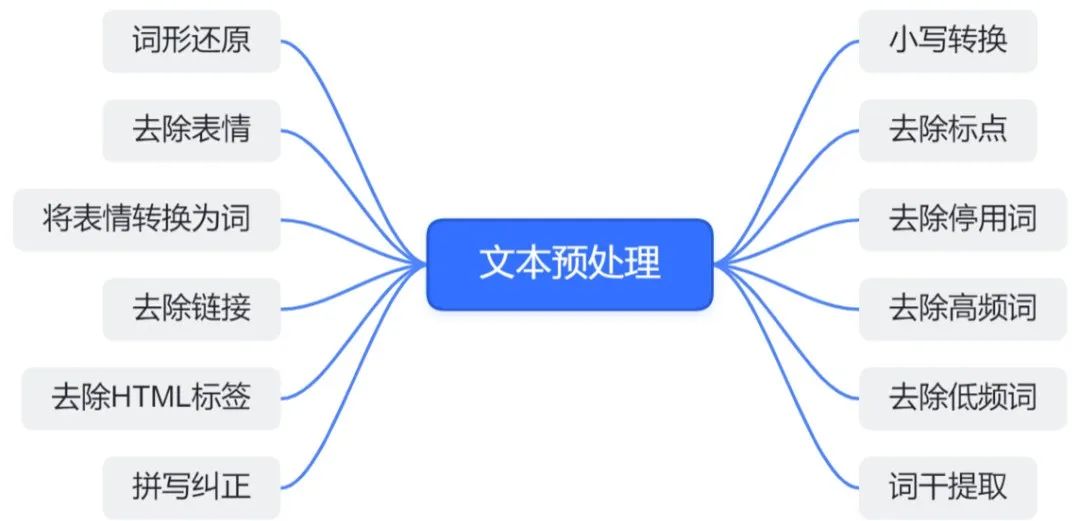

在深入探讨NLP(自然语言处理)和机器学习结合的实际应用之前,我们必须首先了解和掌握文本数据的预处理和特征提取技术。这是因为原始文本数据通常包含大量杂乱无章的信息,需要经过精心处理才能被机器学习模型所理解。预处理和特征提取是将非结构化文本数据转换为可利用的结构化数据的关键步骤,它们直接影响到后续模型的性能。

## 3.1 文本清洗和分词

### 3.1.1 清除噪音数据

文本数据中通常包含许多与分析任务无关的信息,例如HTML标签、特殊符号、无关字符以及大小写不一致等。这些噪音数据如果不加以处理,将干扰模型学习到的特征。因此,在预处理的第一步,我们通常需要对文本进行清洗,去除这些噪音信息。

在Python中,可以使用正则表达式和标准库函数来完成这一任务。例如,下面的代码片段展示了如何使用正则表达式移除HTML标签和特殊字符:

```python

import re

def clean_text(text):

# 移除HTML标签

text = re.sub(r'<.*?>', '', text)

# 移除特殊字符

text = re.sub(r'[^\w\s]', '', text)

return text

# 示例文本

sample_text = "<html>Today's weather is nice, isn't it? Let's go outside.</html>"

cleaned_text = clean_text(sample_text)

print(cleaned_text) # 输出清洗后的文本

```

参数说明:

- `re.sub(pattern, repl, string, count=0, flags=0)`: 此函数用于替换字符串中的某些部分。第一个参数`pattern`是需要查找的模式(正则表达式),第二个参数`repl`是替换文本,第三个参数`string`是原始字符串,`count`用于限制替换次数(默认不限),`flags`用于修改正则表达式的行为。

- `[^\w\s]`: 正则表达式中的字符类,匹配任何非字母数字字符以及非空白字符。

### 3.1.2 中文分词技术

中文文本预处理与英文不同之处在于中文没有明显的单词分隔符,如空格。中文分词是将连续的文本切分成有意义的词汇序列的过程。这一步骤对于后续的文本分析至关重要。

现在有一些非常流行的中文分词工具,例如jieba和HanLP。下面的代码展示了如何使用jieba进行中文分词:

```python

import jieba

def chinese_tokenizer(text):

# 使用jieba进行中文分词

seg_list = jieba.cut(text)

return list(seg_list)

# 示例文本

chinese_text = "今天天气不错,适合出去散步。"

tokenized_text = chinese_tokenizer(chinese_text)

print(tokenized_text) # 输出分词结果

```

参数说明:

- `jieba.cut`: jieba库中用于分词的函数,它将文本切分成一个一个的词汇。

## 3.2 文本向量化表示

### 3.2.1 词袋模型与TF-IDF

文本数据需要转换为数值型特征向量,以便能够应用各种机器学习算法。词袋模型(Bag of Words, BoW)是一种常用的文本向量化表示方法,它忽略了单词的顺序和语法,但保留了词频信息。

TF-IDF(Term Frequency-Inverse Document Frequency)是一种用于信息检索和文本挖掘的常用加权技术,用于评估一个词对于一个文档集或一个语料库中的其中一份文档的重要性。权重通常由词频(TF)和逆文档频率(IDF)两个统计指标计算而来。

下面的代码展示了如何使用Scikit-learn库实现词袋模型和TF-IDF转换:

```python

from sklearn.feature_extraction.text import CountVectorizer, TfidfVectorizer

# 用于词袋模型的向量化

vectorizer = CountVectorizer()

# 用于TF-IDF的向量化

tfidf_vectorizer = TfidfVectorizer()

# 示例文本

texts = ['Today is a good day for NLP tasks.',

'Natural Language Processing has many applications.']

# 词袋模型转换

bag_of_words = vectorizer.fit_transform(texts)

# TF-IDF转换

tfidf = tfidf_vectorizer.fit_transform(texts)

# 输出转换结果

print(bag_of_words.toarray())

print(tfidf.toarray())

```

参数说明:

- `CountVectorizer()`: Scikit-learn提供的词袋模型向量化工具,它会返回一个矩阵,其中行表示文档,列表示词汇,元素值表示词频。

- `TfidfVectorizer()`: Scikit-learn提供的TF-IDF向量化工具,返回的矩阵与词袋模型类似,但元素值表示TF-IDF权重。

- `fit_transform()`: 该方法会根据提供的文本数据学习词汇并转换为数值型特征矩阵。

### 3.2.2 实现向量化与转换

文本数据的向量化是将非数值型的文本数据转换为数值型特征向量的过程。这一过程对于模型训练至关重要,因为大多数机器学习算法无法直接处理原始的文本数据。

为了向量化文本数据,我们通常使用Scikit-learn库中的`CountVectorizer`或`TfidfVectorizer`。这两个函数都提供了相似的接口,但它们的实现细节和转换结果不同。`CountVectorizer`仅根据词汇出现的频次进行向量化,而`TfidfVectorizer`则根据词汇的TF-IDF权重进行向量化。

下面是具体的代码实现:

```python

from sklearn.feature_extraction.text import CountVectorizer

# 定义一组示例文本

corpus = [

'The sky is blue.',

'The sun is bright.',

'The sun in the sky is bright.',

'We can see the shining sun, the bright sun.'

]

# 初始化一个向量化器

vectorizer = CountVectorizer()

# 对文本数据进行向量化

vectorized_data = vectorizer.fit_transform(corpus)

# 将稀疏矩阵转换为数组形式,以便查看结果

data_array = vectorized_data.toarray()

# 打印转换后的矩阵

p

```

0

0