【降维技术精要】:PCA与t-SNE案例应用解析

发布时间: 2024-11-22 02:52:19 阅读量: 59 订阅数: 40

# 1. 降维技术概述与应用场景

在处理高维数据时,降维技术是数据科学中的一个重要工具,它通过减少数据的维度来简化问题,并且提高模型的效率和解释性。本章节首先从降维技术的基本概念出发,探讨其在数据分析和机器学习中的重要性。随后,将介绍降维技术的基本原理和应用场景,从而为读者提供一个关于如何在实际问题中应用降维技术的初步理解。

## 1.1 降维技术的定义

降维技术是指通过数学变换,将原始数据在高维空间中的分布映射到低维空间中,同时尽可能保留数据的原始结构和重要特征。这通常涉及消除数据中的冗余信息和噪声,使得模型可以更容易地识别数据之间的内在联系。

## 1.2 降维技术的作用

在高维数据集中,数据点之间可能存在紧密的关联性,这会导致计算复杂度增加以及模型的过拟合问题。降维技术的作用主要体现在以下几个方面:

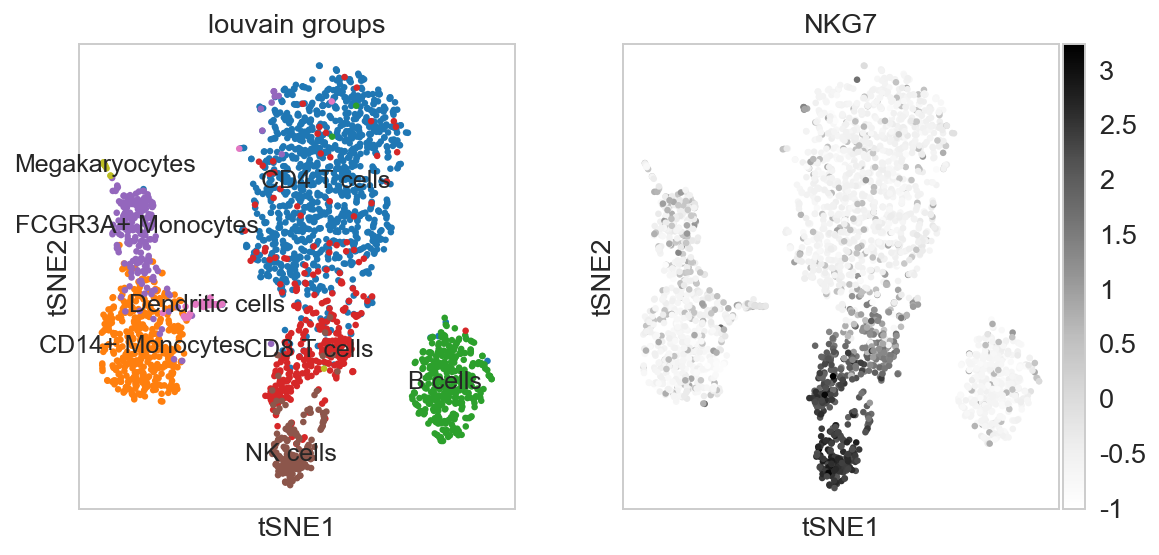

- **数据可视化**:降维能够将高维数据转换成可以在二维或三维空间中直观展示的图表,使得数据的内在结构一目了然。

- **特征提取**:识别并保留对分析任务最为关键的数据特征,去除不重要的特征,减少计算复杂度。

- **数据压缩**:减少数据存储空间的需求,并且可以加快数据传输速率。

- **提高模型性能**:简化数据结构,去除噪声,有助于提高机器学习模型的泛化能力和分类准确性。

在下一章节中,我们将深入探讨主成分分析(PCA)算法,这是降维技术中最为广泛使用的一种线性降维方法。

# 2. 主成分分析(PCA)理论与实践

### 2.1 主成分分析基本原理

#### 2.1.1 数据的特征值与特征向量

主成分分析(PCA)是一种统计技术,通过正交变换将一组可能相关的变量转换为一组线性不相关的变量,这些新变量称为主成分。在PCA中,数据的变换是基于数据的协方差矩阵或相关矩阵的特征值和特征向量来完成的。

特征值表示了数据在特征向量方向上的方差大小。具有最大特征值的特征向量,对应着数据方差最大的方向,这个方向被称为第一主成分。依次类推,每个后续的主成分都是在与前面所有的主成分不相关的条件下,拥有最大的方差的方向。

数据的中心化是PCA分析的前置步骤,即从每个变量中减去其均值。数学上,若原始数据矩阵为X,中心化后的数据矩阵表示为X̄。

```mermaid

graph TD

A[原始数据] --> B[中心化]

B --> C[计算协方差矩阵]

C --> D[求解特征值与特征向量]

D --> E[特征值排序]

E --> F[提取主成分]

```

#### 2.1.2 方差最大化与主成分提取

PCA通过选择数据集中方差最大的方向来提取主成分,这样做的目的是为了确保数据的主要结构被保留下来,同时去除数据中的噪声和冗余信息。在数据分析中,数据的方差代表了信息量,因此,最大化方差实际上意味着最大化信息的保留。

对于第一主成分,我们希望它能够解释尽可能多的数据变异性,这样剩下的主成分对于总方差的贡献将会减少。在实际操作中,我们通常保留前几个主成分,它们加起来能够解释原始数据集大部分的变异性,而忽略那些贡献较小的主成分。

### 2.2 PCA的数学推导

#### 2.2.1 协方差矩阵的计算与性质

PCA分析的基础是数据的协方差矩阵。协方差矩阵的每个元素表示两个变量之间的协方差,其数学定义为:

\Sigma = \frac{1}{n-1} X^T X

其中,X是中心化后的数据矩阵,n是数据点的个数。协方差矩阵是实对称矩阵,所以它可以被分解为一组正交的特征向量和对应的特征值。

该协方差矩阵的一个重要性质是:它的特征向量对应的方向是数据方差最大的方向,而特征值代表了在该方向上的方差大小。

#### 2.2.2 主成分得分的计算方法

一旦我们有了特征向量和特征值,我们就可以计算每个数据点的主成分得分。主成分得分是原始数据在特征向量方向上的投影值。为了计算主成分得分,我们将中心化后的数据矩阵X与特征向量矩阵相乘:

T = X \cdot V

其中T是主成分得分矩阵,V是包含所有特征向量的矩阵,即协方差矩阵的特征向量组成的矩阵。每个主成分得分列向量都是原始数据的加权和,权重为对应的特征向量中的元素。

### 2.3 PCA在数据分析中的应用

#### 2.3.1 数据降噪与特征提取实例

在数据分析中,PCA经常被用来去除噪声和提取数据的主要特征。数据降噪的一个关键步骤是选取能够解释数据大部分方差的主成分,通常选取累计贡献率达到某个阈值(如95%)的主成分。

在特征提取方面,PCA可以将原始数据转换成一个新的特征空间,在这个新空间中,数据的维度被降低,而且保留了数据的主要结构。这样的转换有助于后续的数据处理和分析,比如在机器学习模型中作为特征输入使用。

#### 2.3.2 面向机器学习的数据预处理

在机器学习任务中,高维数据常常会导致过拟合和计算复杂度的增加。PCA作为数据预处理步骤,可以有效地减少特征空间的维度,从而避免这些问题。

使用PCA作为预处理步骤的典型流程包括:

1. 对数据进行中心化处理。

2. 计算中心化后数据的协方差矩阵,并找到其特征值和特征向量。

3. 按特征值大小排序,并选择前k个特征向量用于构建投影矩阵。

4. 将原始数据矩阵乘以投影矩阵,得到降维后的数据。

5. 使用降维后的数据进行机器学习模型的训练和预测。

通过这种方法,我们可以减小数据维度,并且保留大部分有用的信号,为后续的分析和模型训练提供一个更加高效和鲁棒的数据集。

# 3. t-SNE算法深入解析

## 3.1 t-SNE算法原理精讲

### 3.1.1 高维空间到低维空间的映射

t-SNE,全称t-distributed Stochastic Neighbor Embedding,是一种常用于高维数据可视化的非线性降维技术。其核心思想是基于概率分布来表示高维数据点之间的相似度,并尝试在低维空间中保持这种相似度,从而实现数据的可视化。

t-SNE通过两个步骤来实现高维到低维空间的映射:首先,构建一个高维空间中的概率分布,这个分布基于数据点间的距离;然后,构建一个低维空间中的概率分布,使得高维空间中的数据点在低维空间中保持相似性。这一过程通过一个特定的代价函数来实现,其目标是使得两个空间的概率分布尽可能相似。

### 3.1.2 条件概率分布与相似度度量

为了实现上述映射,t-SNE定义了两个条件概率分布:高维空间的条件概率分布 \( p_{ij}^h \) 和低维空间的条件概率分布 \( q_{ij}^l \)。高维空间的条件概率分布 \( p_{ij}^h \) 基于高斯分布来构建,表示高维空间中任意

0

0