【IT故障诊断的艺术】:CNN-BiLSTM模型的优化与部署策略

发布时间: 2024-11-17 01:03:44 阅读量: 32 订阅数: 44

BO-CNN-BiLSTM/Bayes-CNN-BiLSTM,基于贝叶斯优化CNN-BiLSTM多特征分类预测(MATLAB完整

# 1. IT故障诊断的艺术概述

IT故障诊断是确保网络与系统稳定运行不可或缺的一部分。它依赖于精密的技术和丰富的经验。本章节将探讨故障诊断的基础理论与实践方法,揭示其复杂性以及掌握它的艺术性。我们将从故障诊断的定义出发,逐步深入到它在IT行业中的重要性,以及正确执行诊断流程所需考虑的关键因素。

## 1.1 故障诊断的定义与目的

故障诊断是识别和解决问题的过程,旨在减少系统停机时间,确保业务连续性。它的目标是快速定位问题根源,并提供有效的解决方案。

## 1.2 故障诊断的重要性

在一个高度依赖技术的企业环境中,故障诊断不仅是一个技术挑战,也是一个业务问题。快速准确地诊断出问题,可大幅降低经济损失,并提高客户满意度。

## 1.3 故障诊断流程

故障诊断通常遵循以下步骤:

1. 问题识别:记录错误信息,确定问题的症状。

2. 初步分析:通过日志、监控系统等工具收集数据。

3. 深入诊断:利用专业工具和测试来分析问题。

4. 问题解决:实施解决方案并测试以确保问题已解决。

5. 文档记录:记录故障处理过程,为以后提供参考。

通过掌握这些基本步骤,IT从业者可以有效地定位和解决技术问题,提高整体的故障处理效率和质量。本章旨在提供一个坚实的基础,为后续章节中更高级的技术分析与应用打下基础。

# 2. CNN-BiLSTM模型的基础理论

## 2.1 CNN-BiLSTM模型架构简介

### 2.1.1 CNN基础与工作原理

卷积神经网络(Convolutional Neural Networks, CNN)是一种深度学习架构,特别适用于图像和视频数据的处理。CNN的核心思想是利用局部感受野、权值共享和池化操作来提取输入数据的特征。

- **局部感受野**:每个神经元不是与上一层的所有神经元相连,而只是与其临近的区域相连。这种连接方式模仿了生物视觉系统的结构。

- **权值共享**:在处理图像等网格状数据时,相同的过滤器(filter)或卷积核(kernel)会应用到整个输入数据的不同区域,这样可以大幅减少参数的数量。

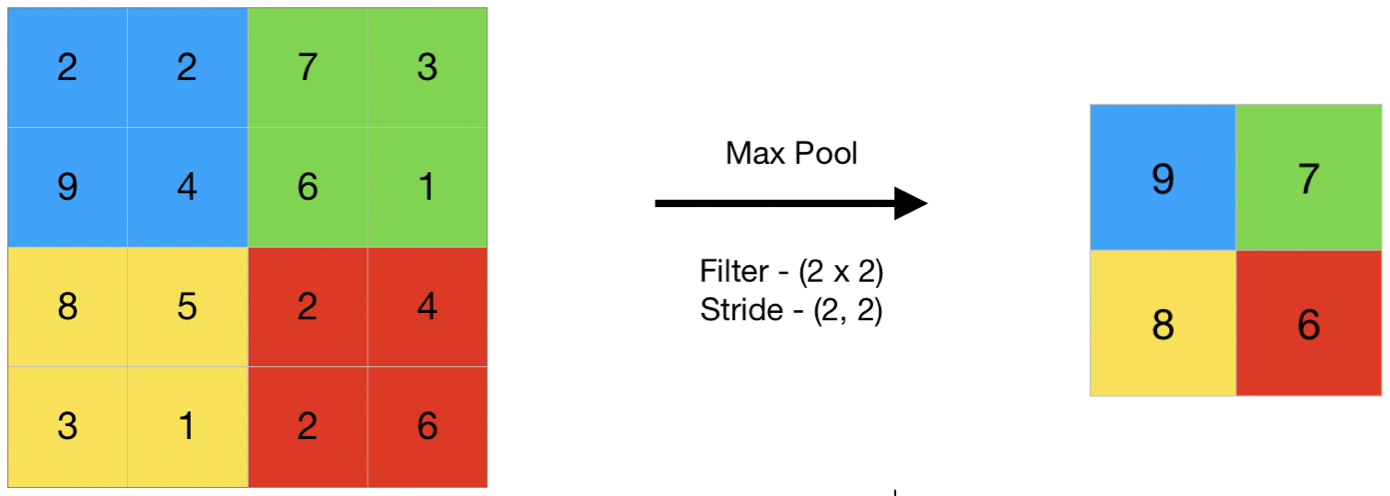

- **池化(Pooling)操作**:池化通常用于降低特征的空间尺寸,同时保留其最重要的信息。常见的池化操作有最大池化(Max Pooling)和平均池化(Average Pooling)。

以下是CNN在图像分类任务中的一个简化示例,使用了两个卷积层和一个全连接层。

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(units=128, activation='relu'))

model.add(Dense(units=10, activation='softmax')) # 假设是10类分类任务

```

在这段代码中,`Conv2D`表示卷积层,`MaxPooling2D`表示池化层,`Flatten`将二维特征转换为一维,而`Dense`表示全连接层。

### 2.1.2 BiLSTM模型的特性与优势

双向长短时记忆网络(Bi-directional Long Short-Term Memory, BiLSTM)是长短期记忆网络(LSTM)的一种扩展形式,它能够同时考虑时间序列数据的前向和后向信息。LSTM是一种特殊的循环神经网络(RNN),设计用来学习长期依赖信息。

BiLSTM的独特之处在于:

- **双向结构**:允许模型在处理序列数据时,同时从两个方向学习信息。这使得BiLSTM在某些任务上,如文本分析和语音识别,比标准单向LSTM表现得更好。

- **记忆能力**:LSTM通过门控机制来控制信息的流动。这种机制可以捕捉到长期依赖性,减少梯度消失问题。

在下面的代码示例中,我们将构建一个简单的BiLSTM模型。

```python

from keras.models import Sequential

from keras.layers import LSTM, Bidirectional, Dense

model = Sequential()

model.add(Bidirectional(LSTM(units=64, return_sequences=True), input_shape=(None, input_dim)))

model.add(Bidirectional(LSTM(units=64)))

model.add(Dense(units=output_dim, activation='softmax'))

# 编译模型

***pile(optimizer='adam', loss='categorical_crossentropy', metrics=['accuracy'])

```

在这段代码中,`Bidirectional`包装器用于创建双向LSTM层。每个`LSTM`层都包含64个内存单元,`return_sequences=True`是为了保证第二层BiLSTM能够接收到所有时间步的信息。

## 2.2 CNN-BiLSTM模型的关键数学原理

### 2.2.1 卷积神经网络的数学基础

卷积神经网络的基本操作是卷积运算。卷积运算涉及一个卷积核和输入数据之间的相互滑动。卷积核是一个参数矩阵,它通过与输入数据相乘并相加的方式,提取特征。数学上,二维卷积可以用以下公式表示:

\[ (F * G)(i,j) = \sum_m \sum_n F(m,n) \cdot G(i-m, j-n) \]

其中 \( F \) 是输入数据,\( G \) 是卷积核,\( * \) 表示卷积操作,\( (i, j) \) 是卷积核中心的位置。

### 2.2.2 双向长短时记忆网络的数学模型

LSTM网络的数学模型主要由几个关键的门结构组成,包括遗忘门(forget gate)、输入门(input gate)、输出门(output gate)和单元状态更新。这些门结构使用sigmoid函数来确定信息的保留和传递。

假设 \( x_t \) 是当前的输入,\( h_{t-1} \) 是前一个状态的输出,\( C_{t-1} \) 是前一个单元状态,那么LSTM单元的状态更新可以用以下公式表示:

\[ f_t = \sigma(W_f \cdot [h_{t-1}, x_t] + b_f) \]

\[ i_t = \sigma(W_i \cdot [h_{t-1}, x_t] + b_i) \]

\[ \tilde{C}_t = \tanh(W_C \cdot [h_{t-1}, x_t] + b_C) \]

\[ C_t = f_t * C_{t-1} + i_t * \tilde{C}_t \]

\[ o_t = \sigma(W_o \cdot [h_{t-1}, x_t] + b_o) \]

\[ h_t = o_t * \tanh(C_t) \]

在这些公式中,\( W \) 代表权重矩阵,\( b \) 代表偏置项,\( \sigma \) 表示sigmoid函数,\( \tanh \) 表示双曲正切函数。这些操作确保了LSTM能够学习长距离依赖关系。

## 2.3 CNN-BiLSTM模型的数据预处理

### 2.3.1 数据收集与清洗

数据收集是机器学习项目的第一步,对于CNN-BiLSTM模型而言,数据通常为图像和序列数据。数据清洗的目的是确保训练数据的质量,包括处理缺失值、噪声和异常值。

### 2.3.2 特征提取与数据标准化

在将数据输入到CNN-BiLSTM模型之前,需要进行特征提取和数据标准化。特征提取通常涉及图像特征的提取,如边缘、角点或纹理。数据标准化是调整数据范围,使之分布在一个相对统一的尺度上,常用的标准化方法是归一化:

\[ x_{\text{norm}} = \frac{x - x_{\text{mean}}}{x_{\text{std}}} \]

归一化可以帮助模型更快地收敛。另外,对于图像数据,通常还会应用数据增强技术,如旋转、缩放和裁剪,以增加模型的泛化能力。

```python

from sklearn.preprocessing import MinMaxScaler

# 假设X为特征矩阵

scaler = MinMaxScaler()

X_scaled = scaler.fit_transform(X)

```

在这段代码中,我们使用了`MinMaxScaler`进行数据的归一化处理。这会将数据缩放到0到1的范围内。

以上内容为第二章CNN-BiLSTM模型的基础理论。接下来的章节将会探讨CNN-BiLSTM模型的优化策略和实际应用案例。

# 3. CNN-BiLSTM模型的优化策略

在前一章中我们探讨了CNN-BiLSTM模型的基础理论和关键数学原理,现在我们将聚焦于如何通过各种优化策略来提升模型的性能。在3.1节中,我们将介绍模型训练的优化技巧,包括超参数的调优方法和防止过拟合的技术。随后,3.2节将讨论模型加速与内存优化,涉及硬件加速技术与模型压缩。最后,在3.3节中,我们将探讨模型集成与泛化能力的提升。

## 3.1 模型训练的优化技巧

### 3.1.1 超参数调优方法

超参数对于模型的性能有着决定性的影响。在开始训练前,合理选择超参数是至关重要的一步。一个常

0

0