【时间序列分析】:CNN-BiLSTM的优势与挑战深度剖析

发布时间: 2024-11-17 00:32:08 阅读量: 4 订阅数: 3

# 1. 时间序列分析基础

在数据分析的世界里,时间序列分析是最具挑战性的领域之一,它不仅要求我们理解数据本身,还要求我们理解数据随时间变化的模式。本章将带您进入时间序列分析的精彩世界,从基础概念开始,逐步深入到高级技术和应用案例。

## 1.1 时间序列分析概述

时间序列分析是一系列用于分析按时间顺序排列的数据点的技术。这些技术可以用于预测未来值、识别数据中的模式、以及检测异常值等。在金融、工业、气象、健康医疗等多个领域,时间序列分析已成为关键的决策支持工具。

## 1.2 时间序列的组成要素

一个时间序列通常由四个主要成分组成:趋势(Trend)、季节性(Seasonality)、循环(Cycle)和随机性(Random)。理解这些成分对于正确地建模和预测时间序列至关重要。

## 1.3 时间序列分析的重要性

时间序列分析之所以重要,在于它提供了一种基于历史数据对未来事件进行预测的手段。无论是预测股票市场的波动,还是预防疾病的发生,抑或是优化供应链管理,时间序列分析都扮演着不可或缺的角色。

在下一章,我们将深入探讨卷积神经网络(CNN)在时间序列分析中的应用,并分析其工作原理以及在实践中如何优化数据处理和预测效果。

# 2. 卷积神经网络(CNN)在时间序列中的应用

## 2.1 CNN的基本原理与架构

### 2.1.1 卷积层的作用和机制

卷积神经网络(CNN)是一种深度学习模型,特别适合处理具有网格状拓扑结构的数据,例如图像。每个卷积层的核心操作是卷积运算,其作用在于从输入数据中提取特征。卷积层由一组可学习的滤波器(或称为卷积核)组成,这些滤波器滑动覆盖输入数据的每个位置,生成一组新的二维激活图(feature maps)。通过对输入数据的局部区域进行响应,卷积层能够有效地捕捉局部特征,这一点在处理时间序列数据时尤为有用。

具体而言,卷积操作可以通过以下公式表示:

\[ (F * K)(i,j) = \sum_m \sum_n F(m,n) \cdot K(i-m, j-n) \]

其中,\( F \) 是输入数据,\( K \) 是卷积核,\( F * K \) 表示卷积结果。这样的局部连接方式使模型在空间上具有局部感知能力,能够提取局部特征,这对于时间序列数据的处理是有益的,因为它可以识别时间上的局部模式。

### 2.1.2 特征提取与局部感知野

CNN的另一个重要特性是局部感知野(receptive field)。每个神经元不是与输入数据的所有元素连接,而是只与输入数据的一个局部区域相连,这个局部区域就称为该神经元的感知野。在时间序列分析中,这意味着CNN能够识别并聚焦于数据的关键局部特征,比如短暂的趋势、周期性或异常值。

通过堆叠多个卷积层,CNN能够逐层从原始数据中学习到更加抽象和复杂的特征表示。在时间序列分析中,深层的卷积网络能发现时间序列数据中复杂的、非线性的模式,这对于捕捉时间序列的动态特征至关重要。

## 2.2 CNN处理时间序列数据的优势

### 2.2.1 时间序列数据的空间特征

时间序列数据在某些情况下可以被视为一种一维“图像”,其中时间步长对应图像的像素列。CNN能够识别并利用这种一维数据中的空间特征。例如,通过时间序列数据的快速傅里叶变换(FFT),可以将时间序列转换为频率域,使其具备空间特征,这时使用CNN进行特征提取和模式识别就变得十分有效。

这种处理方式的优势在于,CNN不需要像循环神经网络(RNN)那样按顺序处理时间序列数据,因而可以利用现代硬件的并行计算能力,加快计算速度。此外,CNN对于时间序列数据中的不规则波动、周期性变化等特征也有较好的识别能力。

### 2.2.2 CNN参数共享特性在时间序列中的优势

CNN的参数共享机制是其另一个重要特性。在卷积操作中,同一层的卷积核参数是共享的,这意味着模型在处理不同时间点的数据时使用相同的权重,从而减少了模型的参数量和计算复杂性。对于时间序列数据,这种特性尤其有用,因为时间序列数据中的局部模式通常在时间轴上具有重复性。

参数共享降低了模型过拟合的风险,并且增加了模型对于时间序列数据泛化的能力。例如,在金融市场的时间序列预测中,诸如交易量这样的局部模式在不同的时间段内可能具有相似的形状,参数共享有助于捕捉此类通用模式。

## 2.3 CNN在时间序列分析中的实践案例

### 2.3.1 案例背景与问题定义

在具体案例中,假设我们需要分析某商品的销售额时间序列,预测未来一段时间内的销售趋势。时间序列数据通常具有时间依赖性和季节性变化等特性,CNN可以用来提取这些特征并进行预测。我们的问题定义为构建一个模型,通过分析过去几个月的销售数据来预测未来一个月的销售情况。

此案例中,CNN模型的输入是时间序列的历史数据,输出是未来一段时间内的销售预测值。整个分析流程包括数据预处理、模型构建、训练和预测。

### 2.3.2 数据预处理与模型构建

在数据预处理阶段,首先需要对原始销售数据进行清洗,去除异常值和缺失值,并进行归一化处理。对于时间序列数据,还可能需要进行差分或去趋势处理,使数据平稳,减少预测过程中的随机波动。

CNN模型构建中,我们选择适当的卷积层、池化层和全连接层来搭建网络结构。例如,可以使用带有多个卷积核的卷积层来提取时间序列的特征,并通过池化层降低特征的空间维度。最后,使用全连接层将提取的特征映射到最终的预测结果。

模型的损失函数通常选用均方误差(MSE),优化器可以选择Adam或SGD等,通过损失函数反向传播调整模型参数,直到模型在训练集上达到满意的性能。

### 2.3.3 结果分析与评估

模型训练完成后,我们使用测试集对模型进行评估。评估指标可能包括均方误差(MSE)、均方根误差(RMSE)或平均绝对误差(MAE)。通过这些指标,我们可以了解模型的预测精度和稳定性。

在结果分析阶段,还可以通过可视化预测结果和实际值,直观地评估模型性能。此外,重要的是要理解模型在某些时间段上预测失败的原因,比如节假日或促销活动可能会影响销售,而这些因素可能在模型训练中没有充分考虑。

通过这个实践案例,我们展示了CNN在时间序列分析中的应用流程,以及如何通过数据预处理、模型构建和评估来解决时间序列预测问题。

# 3. 双向长短期记忆网络(BiLSTM)基础与应用

## 3.1 BiLSTM网络结构与原理

### 3.1.1 LSTM单元的工作机制

长短期记忆网络(LSTM)是一种特殊的循环神经网络(RNN),能够学习长期依赖信息。LSTM的核心在于单元状态(cell state)和三个门控机制:遗忘门(forget gate)、输入门(input gate)和输出门(output gate)。

遗忘门决定了哪些信息应该从单元状态中丢弃,它的输出是一个介于0和1之间的数值,1表示完全保留信息,而0表示完全遗忘。输入门负责更新单元状态,决定新输入的信息中的哪些部分将被用来更新单元状态。最后,输出门控制了单元状态中哪些信息被输出。

```python

# LSTM单元简化代码块

import tensorflow as tf

# 假设已有一个输入序列

input_sequence = tf.keras.layers.Input(shape=(None, input_dim))

# 使用LSTM层

lstm_layer = tf.keras.layers.LSTM(units=hidden_units)(input_sequence)

# 构建模型

model = tf.keras.Model(inputs=input_sequence, outputs=lstm_layer)

```

这段代码展示了如何在TensorFlow/Keras中添加一个LSTM层。输入序列首先定义输入形状,然后传递给LSTM层,该层根据配置的隐藏单元数学习时间步长内的信息。

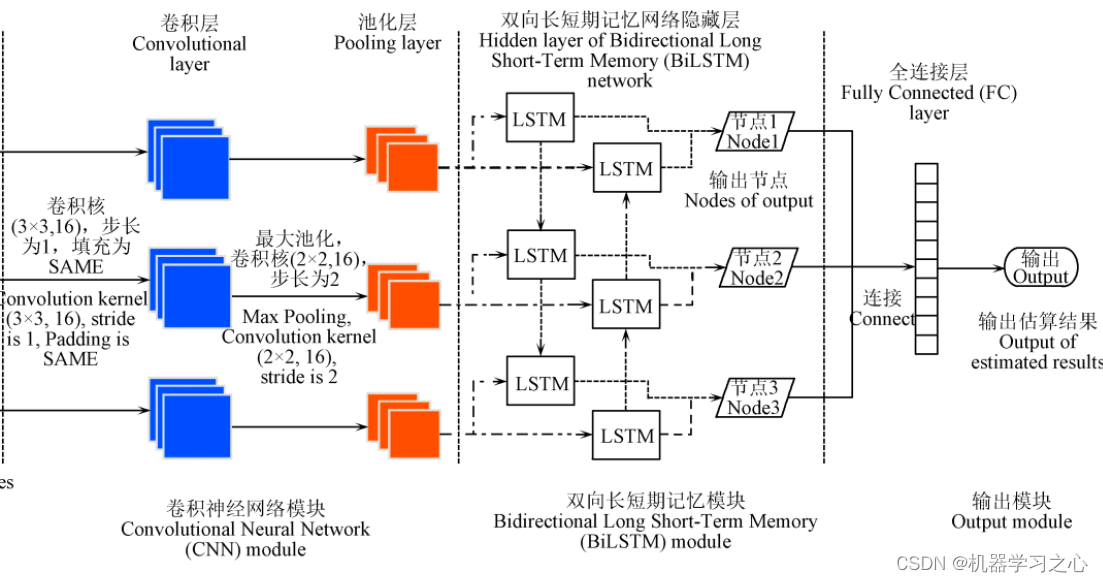

### 3.1.2 BiLSTM对LSTM的改进

双向长短期记忆网络(BiLSTM)是LSTM的扩展,它包含了两个并行的LSTM层:一个正向处理时间序列,另一个反向处理。BiLSTM通过同时考虑过去和未来的上下文信息来改进LSTM。

正向LSTM学习时间序列从开始到结束的上下文,而反向LSTM从结束到开始学习上下文。最终输出是在两者基础上综合得到的,这允许BiLSTM模型更好地捕捉到依赖于时间顺序的信息。

```python

# BiLSTM

```

0

0