Linux系统监控:揭秘实时监控工具和高效技巧

发布时间: 2024-09-26 20:18:57 阅读量: 161 订阅数: 29

# 1. Linux系统监控概述

在IT管理领域,Linux系统监控是一项至关重要的任务。它涉及对系统性能的持续跟踪,确保系统稳定运行,及时发现并解决问题。监控不仅仅是对单一组件的检查,它是一个全面的过程,需要对CPU、内存、磁盘I/O、网络流量等关键性能指标进行综合评估。

随着技术的发展,监控方法和工具也在不断更新。对于企业来说,选择合适的监控策略不仅可以提高运维效率,还能为优化系统性能提供依据。本章将简要介绍Linux系统监控的基本概念,为后续章节中具体监控工具的讨论和应用打下基础。

## 1.1 系统监控的目的与重要性

监控Linux系统的主要目的是为了保障系统的稳定性和响应速度。通过对关键指标的实时监控,管理员可以及早发现潜在问题并采取预防措施,从而减少系统故障带来的损失。此外,监控数据还可以用于系统优化和未来规划,帮助企业构建更为高效和可靠的IT环境。

## 1.2 监控的基本要求和挑战

要实现有效的系统监控,首先要确保数据的准确性和实时性。监控工具需要能够捕捉到系统运行的每一个细节,同时提供清晰的报告和分析结果。此外,监控系统需要具备可扩展性,以适应企业规模的增长和多样化的需求。但这些要求同时也带来了挑战,例如如何处理庞大的监控数据量,如何确保监控工具的高可用性和安全性等。

## 1.3 从基础到高级:监控的递进式学习路径

对于初学者来说,理解监控的基础知识,如常见的监控工具和指标分析,是第一步。随后,进阶学习如何利用监控数据进行系统优化,以及如何编写自动化脚本来简化监控流程。最终,高级监控人员需要掌握如何将监控系统与大数据、机器学习等先进技术结合,以实现更为智能化的监控解决方案。

通过本章内容,我们建立了Linux系统监控的框架,为理解后续章节中涉及的工具和技术打下了基础。随着我们深入到具体的监控工具和应用技巧的学习,你将获得更为全面和深入的系统监控知识。

# 2. Linux系统监控工具的理论与应用

在现代运维工作中,Linux系统监控工具的使用是确保系统稳定性和性能的重要手段。在本章节中,我们将深入探讨系统监控工具的理论基础,并结合实际应用场景详细分析各类工具的使用方法和效果。

## 2.1 系统性能指标分析

### 2.1.1 CPU使用率和负载

CPU是系统中最为关键的部件之一,其使用率和负载的监控对于诊断性能瓶颈至关重要。CPU使用率高不一定意味着负载大,因为后者反映了CPU请求队列的长度。高负载可能是因为单核CPU使用率100%导致的,也可能是因为多核CPU使用率不高但有很多任务等待执行。

#### 监控命令使用

`top` 和 `htop` 是常用的实时监控工具,可以显示CPU的使用率。`top` 通常提供了更为简洁的信息,而 `htop` 则更为直观,提供了颜色和交互式操作功能。

```bash

top

```

使用 `top` 命令时,按下 `1` 可以切换到多核CPU的视图,观察各个核心的负载情况。CPU负载还可以通过 `uptime` 命令查看。

```bash

uptime

```

#### 参数说明与逻辑分析

- `top` 命令会列出所有运行的进程,并周期性地更新。

- `%CPU` 列出了进程使用的CPU百分比。

- `load average` 显示了过去1分钟、5分钟和15分钟的系统平均负载。

### 2.1.2 内存使用状态

内存是计算机中非常重要的资源,它决定了系统的运行速度和多任务处理能力。通过监控内存使用状态,我们可以及时发现内存泄漏或者不足的问题。

#### 监控命令使用

`free` 命令是最基础的内存监控工具,它显示系统的总内存、已用内存、剩余内存和交换空间的信息。

```bash

free -m

```

`vmstat` 命令提供了关于系统内存、进程、CPU等的统计信息。

```bash

vmstat 1

```

#### 参数说明与逻辑分析

- `free` 的 `-m` 参数表示以MB为单位显示内存大小。

- `vmstat` 的 `1` 参数表示每隔1秒刷新一次数据。

## 2.2 网络流量监控工具

网络是连接不同设备和系统的纽带,它的性能直接影响着数据传输的效率。

### 2.2.1 常见网络监控工具介绍

`iftop`、`nethogs`、`iptraf-ng` 是常见的网络流量监控工具,它们可以提供关于进出网络流量的详细信息。

#### `iftop`

`iftop` 能够显示系统的实时带宽使用情况,并且可以按主机、端口、协议等进行过滤。

```bash

sudo apt-get install iftop

sudo iftop

```

#### `nethogs`

`nethogs` 是一个小型的"net top"工具,它用来监控每个进程的网络带宽使用情况。

```bash

sudo apt-get install nethogs

sudo nethogs

```

#### `iptraf-ng`

`iptraf-ng` 是一个交互式IP网络监控工具,提供对进出网络流量的统计和分析。

```bash

sudo apt-get install iptraf-ng

sudo iptraf-ng

```

### 2.2.2 网络流量分析实践

要对网络流量进行分析,首先需要确定分析的目标和范围,例如是要监控进出某个接口的流量,还是要监控特定进程的网络活动。

#### 实践步骤

1. 使用 `ifconfig` 或 `ip` 命令来确定要监控的网络接口名。

```bash

ifconfig

# 或者

ip link

```

2. 使用 `iftop` 监控特定接口。

```bash

sudo iftop -i eth0

```

3. 若是需要深入到进程级的监控,可以使用 `nethogs`。

```bash

sudo nethogs eth0

```

4. 通过 `iptraf-ng` 的主菜单选择监控接口,开始监控。

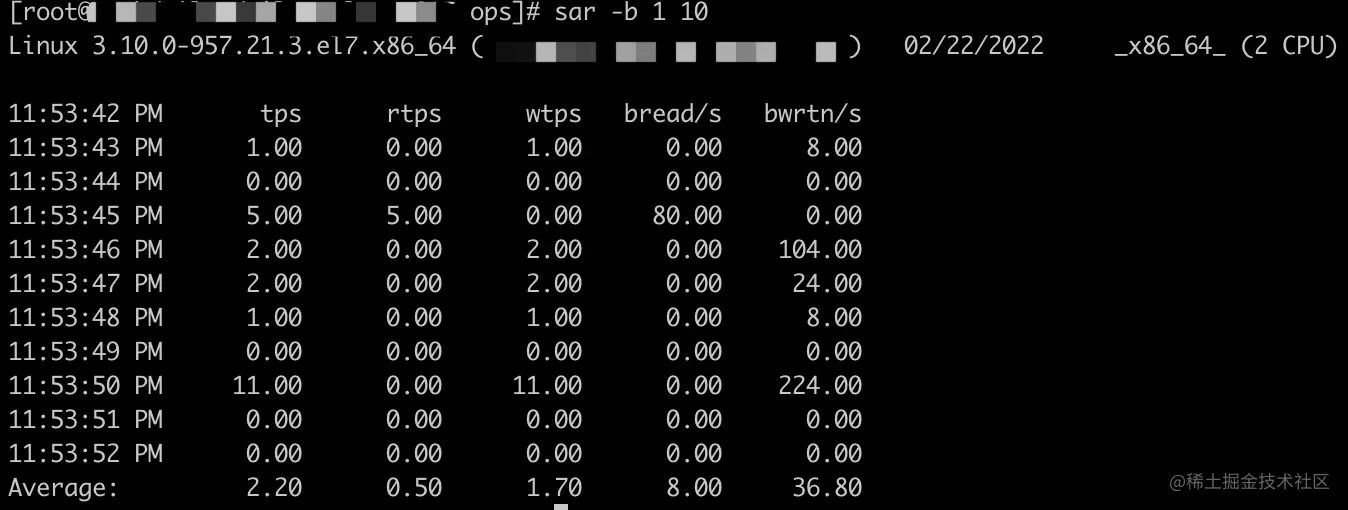

## 2.3 磁盘I/O和文件系统监控

磁盘I/O性能和文件系统的健康状态对系统来说同样重要,它们直接关联到数据的读写效率和安全性。

### 2.3.1 磁盘性能监控策略

磁盘性能的监控可以通过多种方式实施,常用的工具包括 `iostat` 和 `iotop`。

#### 使用 `iostat`

`iostat` 是一个灵活的监控工具,它可以显示CPU统计信息和设备I/O性能。

```bash

sudo iostat -x

```

`-x` 参数提供了更为详尽的统计信息,如平均服务时间和请求队列长度。

#### 使用 `iotop`

`iotop` 类似于 `top`,用于监视进程级的磁盘I/O使用情况。

```bash

sudo apt-get install iotop

sudo iotop

```

### 2.3.2 文件系统健康状态检查

确保文件系统的健康状态是预防数据丢失和系统崩溃的重要手段。`fsck` 是一个常用的文件系统检查工具。

```bash

sudo fsck -f /dev/sda1

```

`-f` 参数强制进行检查,即使文件系统显示为已干净状态。

#### 定期检查的实践

通常将 `fsck` 的使用整合到系统启动过程中的 `/etc/fstab` 文件中,确保系统引导时自动检查关键分区。

```bash

UUID=xxxxxxx-xxxx-xxxx-xxxx-xxxxxxxxxx / ext4 errors=remount-ro 0 1

```

在这里,`errors=remount-ro` 表示如果发生错误,系统将自动以只读模式挂载该分区。

# 3. Linux系统监控实践技巧

## 3.1 日志文件的监控与分析

### 3.1.1 日志文件的管理与配置

日志管理是系统监控中不可或缺的一环,它记录了系统运行过程中的各种事件和通知。为了高效地进行日志管理,首先需要了解如何配置日志文件,以适应不同系统和业务需求。

Linux系统中,`rsyslog` 和 `systemd-journald` 是常用的两个日志服务。`rsyslog` 负责处理传统的文本日志文件,而 `systemd-journald` 提供了一个基于二进制格式的日志,以优化存储和检索。

在 `/etc/rsyslog.conf` 文件中配置日志的处理规则,可以决定哪些消息被记录,以及它们记录到哪里。例如,可以设置不同优先级的消息到不同的日志文件中。以下是一个简单的配置示例:

```conf

authpriv.* /var/log/secure

kern.* -/var/log/kern.log

*.info;mail.none;authpriv.none;cron.none /var/log/messages

```

- `authpriv.*` 表示所有认证相关的消息被写入 `/var/log/secure`。

- `kern.*` 表示内核消息,带有 `-` 的表示不缓存直接写入磁盘。

- `*.info` 表示所有信息级别的消息,除了邮件、认证、计划任务之外,都被写入 `/var/log/messages`。

对于 `systemd-journald`,日志的配置和管理相对简单,它默认记录所有系统和应用程序日志。通过 `journalctl` 命令,可以查询和管理日志。

### 3.1.2 日志分析工具和技巧

日志文件是诊断问题的宝贵资料,但它们往往是杂乱无章的文本。因此,使用日志分析工具可以大大提高处理日志的效率。

常用的日志分析工具有 `grep`, `awk`, `sed` 等文本处理工具。例如,使用 `grep` 命令快速搜索包含特定文本的日志行:

```bash

grep "error" /var/log/syslog

```

除了这些基础工具,还有许多专门的日志分析工具,例如 `logwatch`, `logcheck`, `Graylog` 等。它们提供了更高级的日志分析功能,如自动报告生成、异常检测和报警。

例如,`Graylog` 是一个基于 Web 的日志分析平台,它可以收集、索引和搜索日志数据。下面是使用 `Graylog` 的一个基本配置示例:

1. 安装 Graylog 服务器:

```bash

yum install -y ***

***

```

2. 配置 Graylog 输入源以接收日志数据:

- 进入 Graylog Web 界面(默认端口为 9000)。

- 导航至 "System -> Inputs",创建一个新的输入源。

3. 分析日志数据:

- 通过 Graylog 的查询功能搜索日志消息。

- 利用仪表盘展示实时日志趋势。

使用这些工具和技巧,可以迅速定位问题发生的时间、原因和影响范围,从而提高问题解决的效率。

## 3.2 系统事件和异常告警

### 3.2.1 实时事件监控方法

实时事件监控是监控系统中最为关键的部分,它能够帮助系统管理员及时了解系统状态,以便采取预防措施或者快速响应故障。

在 Linux 系统中,`inotify` 是一个强大的文件系统事件监控机制。借助 `inotify-tools`,可以创建脚本来监控文件或目录的更改:

```bash

inotifywait -m /var/log/ -e create -e move -e delete

```

该命令会监控 `/var/log/` 目录下文件的创建、移动和删除事件。一旦检测到这些事件,`inotifywait` 将输出相关信息。

另一个有效的工具是 `systemd` 的通知机制。通过 `systemd` 服务单元文件中的 `OnFailure` 指令,可以实现服务失败时自动执行特定脚本:

```ini

[Service]

OnFailure=your_script.sh

```

`your_script.sh` 将在服务失败时执行,帮助管理员采取必要的行动。

### 3.2.2 高效异常处理流程

创建一个高效的异常处理流程是确保系统稳定运行的关键。以下是一些关键步骤:

1. **识别异常**:首先需要定义什么是异常。通常,异常是与正常行为模式相悖的行为。这可以通过设定阈值或使用机器学习模型来识别。

2. **实时监控**:使用适当的监控工具实时监控关键性能指标和系统状态。

3. **自动化报警**:一旦检测到异常,应通过邮件、短信、即时消息或其他方式自动通知相关责任人。

4. **响应和恢复**:收到报警后,迅速对事件进行诊断和处理,必要时启动预案进行系统恢复。

5. **事后分析**:事件解决后,进行彻底的事后分析,找出原因并防止未来再次发生类似事件。

通过这个流程,可以确保即使发生异常,系统也能以最快的速度恢复正常运行状态。

# 4. Linux系统监控的高级方法

随着企业对于Linux系统稳定性和性能要求的提高,仅仅使用基础的监控工具已经无法满足需求。因此,需要掌握一些高级方法来实现更为精准和全面的监控。本章将探讨如何编写自动化监控脚本、优化监控系统以及增强监控的安全性。

## 4.1 自动化监控脚本编写

自动化脚本是实现高效监控的基石,它们能够帮助管理员减少重复性劳动,确保监控工作持续且不间断地进行。

### 4.1.1 Bash脚本在监控中的应用

Bash脚本因其易于编写和执行的特性,广泛用于Linux环境下的自动化任务。通过编写脚本,可以实现对系统资源使用情况的定期检查,邮件报警,日志轮转等多种自动化任务。

#### 示例代码:

```bash

#!/bin/bash

# 监控CPU使用率,如果超过80%则发送邮件提醒

# 获取CPU使用率

cpu_usage=$(top -bn1 | grep "Cpu(s)" | sed "s/.*, *\([0-9.]*\)%* id.*/\1/" | awk '{print 100 - $1"%"}')

# 设置CPU使用率阈值

threshold=80

# 判断CPU使用率是否超过阈值

if (( $(echo "$cpu_usage > $threshold" | bc -l) )); then

# 超过阈值时发送邮件

echo "Warning: CPU usage is high at $cpu_usage" | mail -s "CPU Usage Alert" ***

else

echo "CPU usage is normal at $cpu_usage"

fi

```

#### 代码逻辑分析:

- `top -bn1` 命令获取当前CPU的使用情况。

- `grep` 和 `sed` 命令一起解析 `top` 输出,获取CPU的空闲百分比。

- `awk` 命令计算实际的CPU使用率。

- 如果计算出的CPU使用率超过了预设的阈值,使用 `mail` 命令发送邮件报警给管理员。

这个脚本能够作为基础模板,根据实际需求进一步开发,例如添加监控内存使用、磁盘空间等其他系统指标。

### 4.1.2 高级监控脚本示例分析

进一步,让我们看一个更高级的监控脚本示例,这个脚本会综合多个系统指标,并生成一个简单的HTML报告。

#### 示例代码:

```bash

#!/bin/bash

# 创建一个HTML报告,包含系统性能和状态摘要

# 定义生成报告的函数

generate_report() {

echo "<html><head><title>System Status Report</title></head><body>"

echo "<h1>System Status Report</h1>"

echo "<h2>CPU Usage</h2>"

echo "<p>CPU Usage: $(top -bn1 | grep "Cpu(s)" | sed "s/.*, *\([0-9.]*\)%* id.*/\1/")</p>"

echo "<h2>Memory Usage</h2>"

echo "<p>Memory Usage: $(free -m | awk 'NR==2{printf "%.2f%%", $3*100/$2 }')</p>"

echo "<h2>Disk Usage</h2>"

echo "<p>Disk Usage: $(df -h | awk '$NF=="/"{printf "%s", $5})</p>"

echo "</body></html>"

}

# 调用函数生成报告

report=$(generate_report)

echo "$report" > /var/www/html/status_report.html

```

#### 代码逻辑分析:

- `generate_report` 函数将系统状态数据格式化为HTML内容。

- 使用 `free -m` 和 `df -h` 命令获取内存和磁盘使用情况。

- 将生成的报告保存到Web服务器的根目录,使得管理员可以通过浏览器访问。

上述脚本可以作为基础模板进一步扩展,比如集成日志监控、网络监控数据等,以创建更为全面的系统状态报告。

## 4.2 监控系统的优化与扩展

随着系统的不断增长和复杂化,监控系统本身也需要优化和扩展以应对新的挑战。

### 4.2.1 监控系统性能优化策略

优化监控系统性能是确保监控有效性的重要步骤,包括监控频率、数据收集策略和存储方案的优化。

#### 性能优化示例:

- **监控频率调整**:依据系统负载动态调整监控频率,避免在负载较低时频繁收集数据造成资源浪费。

- **数据压缩**:实时监控数据可以先进行压缩处理,减少网络传输和存储空间的需求。

- **分布式存储**:使用分布式数据库存储监控数据,提高数据的存取速度和系统的可用性。

### 4.2.2 扩展监控系统的案例研究

扩展监控系统通常涉及引入新的监控工具或服务,以覆盖之前未监控的领域。

#### 扩展监控案例:

- **引入第三方监控服务**:例如Prometheus和Grafana,为系统提供更加丰富的监控维度和数据可视化能力。

- **定制开发**:针对特定的应用程序或服务开发专属的监控插件,增强监控的针对性。

## 4.3 安全性增强:防止监控被绕过

监控系统作为安全的第一道防线,其安全性至关重要。如果监控系统被绕过,就无法正确反映系统的安全状态。

### 4.3.1 监控机制的安全漏洞分析

监控机制可能存在的漏洞包括:

- **未授权访问**:监控系统被未经授权的用户访问。

- **数据篡改**:监控数据在传输和存储过程中被修改。

- **系统入侵**:攻击者入侵系统后关闭监控。

### 4.3.2 提高监控安全性的措施

提高监控安全性的措施包括:

- **访问控制**:对监控系统的访问进行严格控制,使用多因素认证。

- **加密通信**:使用SSL/TLS等加密协议保护监控数据的传输安全。

- **定期审计**:对监控系统的配置和操作进行定期的审计,确保没有被篡改或关闭。

通过实施这些措施,可以显著提高监控系统的安全级别,减少被攻击的风险。

## 小结

在本章节中,我们讨论了Linux系统监控的高级方法,包括编写自动化监控脚本,优化和扩展监控系统,以及如何增强监控的安全性。这些方法能够帮助管理员更高效、更安全地对系统进行监控,确保系统的稳定运行。

# 5. Linux系统监控未来发展趋势

随着技术的不断进步和企业需求的日益增长,Linux系统监控领域也在不断地发展和演变。本章将探讨Linux系统监控在未来可能的发展趋势,重点分析云环境下的系统监控、智能监控与大数据分析,以及持续集成与持续部署(CI/CD)中的监控需求。

## 5.1 云环境下的系统监控

云技术的广泛应用为Linux系统监控带来了新的挑战和机遇。云环境下的系统监控不仅需要关注传统的性能指标,还要能够适应动态变化的资源分配和多租户环境。

### 5.1.1 云监控工具的特点

云监控工具必须具备高度的可扩展性和灵活性,能够监控分布在不同数据中心甚至不同云服务商的资源。一些主流云服务提供商,如AWS、Azure和阿里云,都提供了自家的云监控工具,如AWS CloudWatch、Azure Monitor等。这些工具通常具备以下特点:

- **集成服务监控**:能够监控云平台提供的各项服务,包括虚拟机、数据库、存储等。

- **资源优化建议**:分析使用情况,给出成本和性能的优化建议。

- **自动化响应**:与自动扩展服务集成,对性能异常自动做出调整。

### 5.1.2 云环境监控实践

在云环境中,监控实践需要考虑以下方面:

- **资源使用情况分析**:利用云监控工具,实时跟踪资源使用情况,防止资源浪费。

- **性能阈值配置**:设置合理的性能阈值,一旦达到或超出,自动触发告警。

- **多云环境管理**:对于使用多个云服务提供商的组织,需要统一的多云监控策略和工具,如Dynatrace、Datadog等。

```bash

# 示例:使用AWS CloudWatch监控EC2实例的CPU使用率

aws cloudwatch put-metric-alarm \

--alarm-name "EC2-CPU-Threshold" \

--alarm-description "This alarm monitors CPU utilization for an EC2 instance" \

--metric-name CPUUtilization \

--namespace AWS/EC2 \

--statistic Average \

--period 300 \

--threshold 80 \

--comparison-operator GreaterThanThreshold \

--dimensions "Name=InstanceId,Value=your-instance-id" \

--actions-enabled true \

--alarm-actions arn:aws:sns:region:aws:your-topic

```

## 5.2 智能监控与大数据分析

在大数据时代背景下,智能监控和大数据分析技术逐渐被引入到Linux系统监控领域中。

### 5.2.1 机器学习在监控中的应用

机器学习能够帮助分析历史数据,预测潜在的性能问题和故障。例如,通过分析系统日志,机器学习模型可以学习到常见错误模式,并预测未来可能发生的故障。通过这种方式,监控系统可以提前采取措施,减少系统的停机时间。

### 5.2.2 大数据分析工具和技术在监控中的作用

大数据技术,如Hadoop和Spark,能够处理和分析海量的数据集,帮助监控系统更高效地存储、检索和分析数据。

```mermaid

graph TD;

A[收集监控数据] --> B[数据存储];

B --> C[数据处理];

C --> D[数据查询和分析];

D --> E[可视化展示];

```

上图展示了大数据技术在监控数据处理中的应用流程。

## 5.3 持续集成与持续部署(CI/CD)的监控

CI/CD流程的集成监控是确保软件交付效率和质量的关键组成部分。

### 5.3.1 CI/CD流程中的监控要求

CI/CD流程中的监控需要关注代码质量、构建状态、部署成功率等指标。监控系统应能够与CI/CD工具链集成,如Jenkins、GitLab CI、GitHub Actions等,以便实时跟踪软件开发的每个阶段。

### 5.3.2 实现CI/CD监控的策略和工具

为了满足CI/CD流程的监控需求,可以选择一些支持插件和扩展的监控工具。例如:

- **Prometheus**:作为容器环境中的监控工具,它可以与Kubernetes和Jenkins等CI/CD工具集成。

- **Selenium**:适用于Web应用的自动化测试,能够集成到CI/CD流程中,确保应用的界面和功能稳定。

```yaml

# 示例:在Jenkins Pipeline中集成Prometheus监控

pipeline {

agent any

stages {

stage('Checkout') {

steps {

checkout scm

}

}

stage('Build') {

steps {

// 构建步骤

}

}

stage('Prometheus Monitoring') {

steps {

script {

// 发送构建状态到Prometheus

def response = sh(script: 'curl -X POST ***', returnStdout: true).trim()

echo "Prometheus response: ${response}"

}

}

}

}

}

```

以上脚本展示了如何在Jenkins Pipeline中集成Prometheus监控,以便跟踪构建状态。这可以作为CI/CD流程中监控实践的一个例子。

0

0