【Anaconda安装OpenCV秘笈】:一步步攻破OpenCV安装难题

发布时间: 2024-08-06 06:28:38 阅读量: 45 订阅数: 49

# 1. Anaconda简介

Anaconda是一个开源的Python发行版,它包含了大量科学计算、数据分析和机器学习库。它为数据科学家、机器学习工程师和研究人员提供了一个完整的环境,用于开发和部署数据驱动型应用程序。

Anaconda由Continuum Analytics开发,它提供了一个预先配置的Python环境,其中包括流行的库,如NumPy、SciPy、Pandas和Matplotlib。这使得用户可以轻松地安装和管理这些库,而无需手动安装和配置它们。

# 2. OpenCV简介

### 2.1 OpenCV的历史和发展

OpenCV(Open Source Computer Vision Library)是一个开源的计算机视觉库,它由英特尔公司于1999年创立。最初,OpenCV主要用于英特尔的研究项目,但随着时间的推移,它逐渐成为计算机视觉领域最受欢迎的库之一。

OpenCV经历了几个主要版本:

- **1.x系列:**发布日期为2000-2011年,主要用于学术研究和非商业用途。

- **2.x系列:**发布日期为2011-2015年,增加了对多核处理和GPU加速的支持。

- **3.x系列:**发布日期为2015年至今,是目前最稳定的版本,引入了对Python和移动平台的支持。

### 2.2 OpenCV的应用领域

OpenCV广泛应用于各种计算机视觉领域,包括:

- **图像处理:**图像增强、降噪、分割、特征提取等。

- **视频处理:**视频稳定、运动检测、目标跟踪等。

- **机器学习:**图像分类、对象检测、人脸识别等。

- **增强现实:**场景识别、物体跟踪、交互式应用等。

- **机器人技术:**导航、避障、物体识别等。

- **医学成像:**图像分割、病变检测、图像配准等。

- **工业自动化:**质量控制、缺陷检测、视觉引导等。

### 2.3 OpenCV的优势

OpenCV之所以受到广泛欢迎,主要归功于以下优势:

- **开源和免费:**OpenCV是一个开源库,可以免费使用和修改。

- **跨平台支持:**OpenCV支持Windows、Linux、macOS等多种操作系统。

- **丰富的算法:**OpenCV提供了超过2500种计算机视觉算法,涵盖图像处理、视频分析、机器学习等领域。

- **高效性能:**OpenCV使用优化算法和多线程技术,可以高效处理大规模图像和视频数据。

- **广泛的社区支持:**OpenCV拥有一个庞大的用户社区,提供技术支持、文档和教程。

### 2.4 OpenCV的安装

OpenCV的安装方法因操作系统而异。以下是一些常见操作系统的安装步骤:

- **Windows:**

- 下载OpenCV安装程序(.exe文件)

- 运行安装程序并按照提示进行安装

- 将OpenCV的bin目录添加到系统环境变量PATH中

- **Linux:**

- 使用包管理器安装OpenCV(例如:sudo apt-get install libopencv-dev)

- 将OpenCV的lib目录添加到系统环境变量LD_LIBRARY_PATH中

- **macOS:**

- 使用Homebrew安装OpenCV(例如:brew install opencv)

- 将OpenCV的lib目录添加到系统环境变量DYLD_LIBRARY_PATH中

### 2.5 OpenCV的验证

安装完成后,可以通过运行以下命令验证OpenCV是否安装成功:

```python

import cv2

print(cv2.__version__)

```

如果输出结果为OpenCV的版本号,则表示安装成功。

# 3. Anaconda安装OpenCV实践

### 3.1 安装Anaconda

**步骤:**

1. 访问Anaconda官方网站:https://www.anaconda.com/

2. 选择适合您操作系统的Anaconda版本(Python 3.x)

3. 下载并运行安装程序

4. 按照安装向导进行操作,选择默认安装选项即可

**参数说明:**

* `--prefix=/path/to/anaconda`:指定Anaconda安装目录

* `--install-hidden`:隐藏Anaconda命令行快捷方式

* `--no-default-packages`:不安装默认的Anaconda包

### 3.2 安装OpenCV

**步骤:**

1. 打开Anaconda Navigator

2. 点击“环境”选项卡

3. 选择您要安装OpenCV的Anaconda环境(默认环境为“base”)

4. 点击“安装”按钮

5. 在搜索框中输入“opencv”

6. 选择“opencv-python”包并点击“安装”按钮

**代码块:**

```

conda install opencv-python

```

**逻辑分析:**

该命令使用Conda包管理器安装OpenCV-Python包。OpenCV-Python是OpenCV的Python绑定,它允许您在Python代码中使用OpenCV函数。

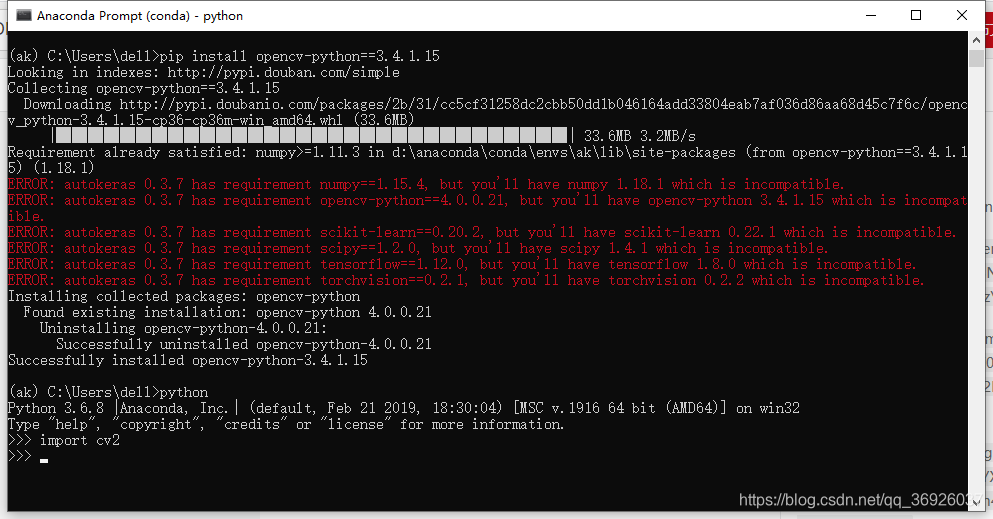

### 3.3 验证安装

**步骤:**

1. 打开Python交互式解释器(例如,Anaconda Prompt)

2. 导入OpenCV包:

```

import cv2

```

3. 打印OpenCV版本:

```

print(cv2.__version__)

```

**代码块:**

```python

import cv2

print(cv2.__version__)

```

**逻辑分析:**

此代码导入OpenCV包并打印其版本。如果安装成功,您应该看到OpenCV的版本号打印在控制台中。

# 4. OpenCV常见问题解决

在使用OpenCV的过程中,可能会遇到各种各样的问题。本章节将介绍OpenCV中常见的编译错误、运行时错误和性能优化问题,并提供相应的解决方案。

### 4.1 编译错误

#### 4.1.1 找不到头文件

**问题描述:**

编译OpenCV程序时,出现找不到头文件(例如opencv2/opencv.hpp)的错误。

**解决方案:**

* 确保OpenCV已正确安装。

* 检查头文件路径是否已添加到编译器的搜索路径中。

* 使用`pkg-config`命令检查头文件的位置:`pkg-config --cflags opencv`

#### 4.1.2 找不到库文件

**问题描述:**

编译OpenCV程序时,出现找不到库文件(例如libopencv_core.so)的错误。

**解决方案:**

* 确保OpenCV已正确安装。

* 检查库文件路径是否已添加到编译器的搜索路径中。

* 使用`pkg-config`命令检查库文件的位置:`pkg-config --libs opencv`

### 4.2 运行时错误

#### 4.2.1 段错误

**问题描述:**

运行OpenCV程序时,出现段错误(Segmentation fault)。

**解决方案:**

* 检查程序中是否存在数组越界或指针访问无效内存的情况。

* 使用调试器(例如gdb)来定位错误。

#### 4.2.2 访问违规

**问题描述:**

运行OpenCV程序时,出现访问违规(Access violation)的错误。

**解决方案:**

* 检查程序中是否存在对已释放内存的访问。

* 使用调试器(例如gdb)来定位错误。

### 4.3 性能优化

#### 4.3.1 使用多线程

**问题描述:**

OpenCV程序运行缓慢,需要提高性能。

**解决方案:**

* 将OpenCV函数中的并行部分(例如图像处理)移到多线程中。

* 使用OpenMP或pthread等多线程库。

#### 4.3.2 使用GPU加速

**问题描述:**

OpenCV程序需要处理大量数据,需要提高性能。

**解决方案:**

* 使用NVIDIA CUDA或AMD OpenCL等GPU加速库。

* 将OpenCV函数中的计算密集型部分移到GPU中。

#### 4.3.3 优化算法

**问题描述:**

OpenCV程序中的算法效率低下,需要提高性能。

**解决方案:**

* 分析算法的复杂度,并考虑使用更有效的算法。

* 优化算法中的数据结构和内存访问。

* 使用性能分析工具(例如perf或gprof)来识别性能瓶颈。

# 5.1 图像处理

OpenCV在图像处理方面拥有强大的功能,可以实现各种图像处理操作,包括:

- **图像读取和写入:**`cv2.imread()`和`cv2.imwrite()`函数可以分别读取和写入图像。

- **图像转换:**`cv2.cvtColor()`函数可以将图像从一种颜色空间转换为另一种颜色空间,例如从BGR转换为RGB。

- **图像缩放和旋转:**`cv2.resize()`和`cv2.rotate()`函数可以分别缩放和旋转图像。

- **图像裁剪:**`cv2.crop()`函数可以从图像中裁剪出一个矩形区域。

- **图像平滑:**`cv2.GaussianBlur()`和`cv2.medianBlur()`函数可以分别使用高斯滤波器和中值滤波器对图像进行平滑处理。

- **图像锐化:**`cv2.Laplacian()`和`cv2.Sobel()`函数可以分别使用拉普拉斯算子和Sobel算子对图像进行锐化处理。

- **图像边缘检测:**`cv2.Canny()`函数可以检测图像中的边缘。

- **图像分割:**`cv2.watershed()`和`cv2.grabCut()`函数可以分别使用分水岭算法和GrabCut算法对图像进行分割。

**示例代码:**

```python

import cv2

# 读取图像

image = cv2.imread('image.jpg')

# 转换为灰度图像

gray_image = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 高斯滤波

blurred_image = cv2.GaussianBlur(gray_image, (5, 5), 0)

# 边缘检测

edges_image = cv2.Canny(blurred_image, 100, 200)

# 显示图像

cv2.imshow('Original Image', image)

cv2.imshow('Gray Image', gray_image)

cv2.imshow('Blurred Image', blurred_image)

cv2.imshow('Edges Image', edges_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

0

0