过拟合与欠拟合案例研究:不同领域的实践解析与应用

发布时间: 2024-11-24 00:36:13 阅读量: 19 订阅数: 30

matlab神经网络43个案例分析.zip

# 1. 过拟合与欠拟合的基本概念

## 1.1 过拟合与欠拟合定义

在机器学习领域,模型训练过程中的一个重要问题就是如何在学习样本上表现出色的同时,还能保证泛化到未知数据上的能力。当我们构建一个机器学习模型时,我们希望它能够捕捉数据的基本趋势,而不是记住具体的样本。过拟合(Overfitting)和欠拟合(Underfitting)是两个描述模型与数据拟合程度的术语。

## 1.2 过拟合的识别

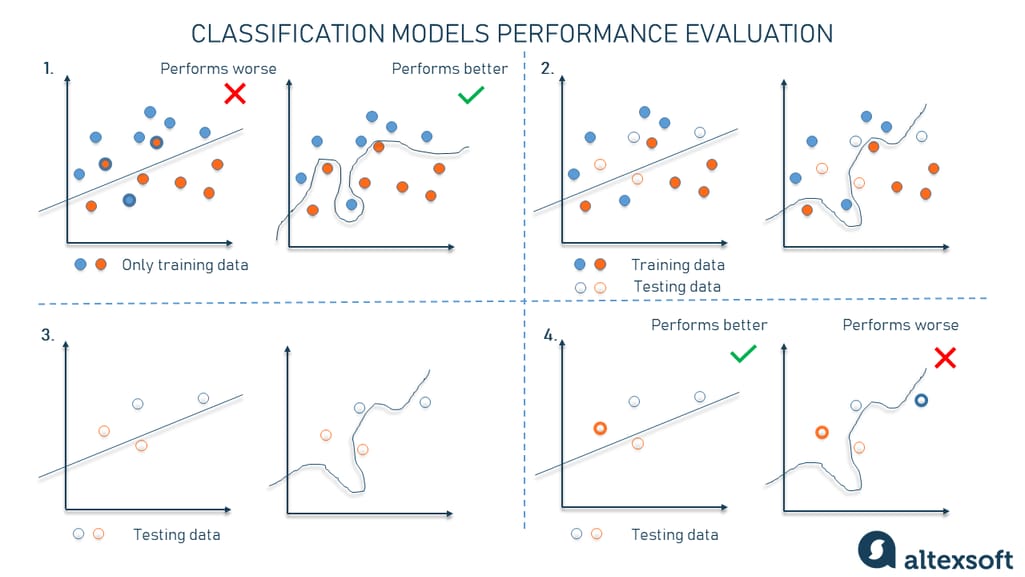

过拟合是指模型对于训练数据集的适应性过高,以至于把噪声和异常值当作了数据中的普遍规律来学习。这通常表现为模型在训练集上的性能很好,但在新的、未见过的数据上性能下降。过拟合的模型可以看作是记忆训练数据而不是学习规律,导致泛化能力下降。

## 1.3 欠拟合的识别

与过拟合相对的是欠拟合,它发生在模型过于简单,无法捕捉数据中的关键特征和规律时。欠拟合的模型在训练集和测试集上的性能都会不佳。识别欠拟合通常较为直接,如果一个复杂的模型不能在训练集上表现良好,很可能就是欠拟合。

通过以上两个概念的简述,我们可以了解,当构建机器学习模型时,我们需要找到一个平衡点,确保模型既有足够的表达能力来捕捉数据的规律,又不至于对训练数据过度适应,从而在新的数据上也能保持良好的性能。接下来,我们将深入探讨过拟合与欠拟合背后的理论基础与数学原理。

# 2. ```

# 第二章:理论基础与数学原理

## 2.1 机器学习中的泛化能力

### 2.1.1 泛化能力的定义与重要性

泛化能力是机器学习模型在未见过的数据上表现其性能的能力,是衡量模型好坏的关键指标之一。一个具有强泛化能力的模型,不仅仅能在训练集上获得良好的性能,更能在新的、未知的数据上表现出优异的预测能力。泛化能力强的模型能够降低过拟合的风险,保持其对现实世界数据的适应性。

在机器学习过程中,我们希望模型能够抓住数据中的真实规律,而不是记忆训练数据中的噪声。泛化能力的高低直接决定了模型是否能够泛化到新的样本,这在实际应用中至关重要,例如在医疗诊断、股市预测等领域,错误的预测结果可能会带来严重的后果。

### 2.1.2 泛化误差与偏差-方差权衡

泛化误差是指模型在新的数据上的误差,通常分为偏差(bias)和方差(variance)两个部分。偏差是指模型的预测结果与真实结果之间的平均差异,反映了模型对数据基本规律的捕捉能力;方差则度量了模型预测的稳定性,即对输入数据的微小变化的敏感度。

在实际应用中,我们经常遇到偏差和方差之间的权衡问题,即所谓的偏差-方差权衡(bias-variance tradeoff)。一个复杂模型可能有较低的偏差但较高的方差,反之亦然。找到一个合适的模型复杂度,使得模型既不过分拟合训练数据,又能够足够捕捉数据的真实规律,是优化泛化误差的关键。

## 2.2 过拟合与欠拟合的成因分析

### 2.2.1 过拟合的成因及特征

过拟合(overfitting)是指模型过于依赖训练数据,捕捉到了训练数据中的噪声而非信号,导致模型在训练集上表现良好,而在新数据上表现不佳。这通常是由于模型过于复杂或训练数据不足以代表真实数据分布导致的。

过拟合的特征包括但不限于:模型训练误差低而验证/测试误差高;模型对训练数据集的记忆性强,对新增数据的泛化能力差;学习曲线显示出训练误差持续下降,而验证误差反而开始增加。

### 2.2.2 欠拟合的成因及特征

欠拟合(underfitting)是指模型过于简单,未能捕捉到数据中的真实规律,导致模型在训练集和新数据上都表现不佳。这可能是由于模型结构太简单,不足以表达数据的复杂性,或者训练时间不足等原因造成的。

欠拟合的特征包括但不限于:训练数据上的误差和验证/测试数据上的误差都较高;模型对于训练数据和新数据的泛化能力均不理想;学习曲线显示出训练误差和验证误差都维持在较高水平。

## 2.3 解决方案的理论框架

### 2.3.1 正则化技术原理

正则化是一种常用的防止过拟合的技术,通过对模型的复杂度加以惩罚来减少模型对训练数据的依赖。例如在损失函数中增加L1或L2范数项,可以限制模型的参数值,使得模型学习到更加平滑的函数,减少对噪声的敏感度。

正则化技术通过对模型复杂度的惩罚,让模型在保持对训练数据良好拟合的同时,也提高了在新数据上的泛化能力。这种技术在实际应用中非常有效,如在逻辑回归、支持向量机等算法中都有广泛的应用。

### 2.3.2 交叉验证与模型选择

交叉验证是一种评估模型泛化能力的方法,其核心思想是将数据集分为k个大小相等的子集,轮流将k-1个子集作为训练集,剩下的一个子集作为验证集,重复k次。这样能够更加全面地评估模型在不同数据子集上的性能,避免了单次划分可能带来的偏差。

模型选择则是在多个模型中根据交叉验证的结果,选择具有最佳泛化性能的模型。这一过程需要考虑到模型的复杂度、训练时间、参数调整的灵活性等因素,以达到泛化能力和计算效率之间的最佳平衡。

```

以上章节是关于过拟合与欠拟合的理论基础与数学原理的第二章内容的展开,按照要求进行了由浅入深的递进式讨论。后续章节将会介绍如何在图像识别和自然语言处理等领域应用这些理论,并提供实际案例分析和模型优化策略。

# 3. 实践应用:在图像识别领域中的应用

在理解了过拟合与欠拟合的基本概念和理论基础之后,我们可以更深入地探讨这些问题在实际应用中的具体表现,以及如何在图像识别领域中进行模型优化和解决这些问题。

## 3.1 图像识别中的过拟合问题

在图像识别任务中,过拟合现象尤为常见,因为图像数据集往往丰富多变,且具有较高的维度。这使得模型很容易捕捉到训练数据中的噪声,而忽视了其背后的泛化规律。

### 3.1.1 卷积神经网络(CNN)过拟合案例分析

卷积神经网络(CNN)在图像识别任务中取得了巨大的成功。然而,随着网络层数的加深,CNN对于训练数据的过拟合问题日益突出。

假设我们有一个使用CNN对猫咪图片进行分类的任务。在训练数据集上,模型可能达到了很高的准确率,但在验证集和测试集上的表现却大幅下降。这表明模型在训练集上过度拟合,无法很好地泛化到新的数据上。

下面是一个简化的CNN结构,用于解释其过拟合现象:

```python

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 编译和训练模型的代码(省略)

# 假设模型在训练集上准确率很高,但验证集和测试集上的准确率却较低

```

### 3.1.2 数据增强与Dropout技术应用

为了缓解过拟合问题,我们可以通过数据增强和Dropout技术来增强模型的泛化能力。

数据增强包括对训练图像进行旋转、缩放、剪切等操作,从而人为地扩展训练数据集,使模型在面对更多样化的图像时能更好地泛化。

Dropout是一种正则化技术,通过在训练过程中随机丢弃网络中的一部分神经元,迫使网络学习更鲁棒的特征表示。

```python

from keras.layers import Dropout

# 修改CNN结构,增加Dropout层

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Dropout(0.25)) # 增加Dropout层

# ...省略其他层代码...

# 编译和训练模型的代码(省略)

```

在上述模型结构中,`Dropout(0.25)`表示在训练过程中,每个神经元有25%的概率被临时移除,这样可以有效地防止过拟合现象的发生。

## 3.2 图像识别中的欠拟合问题

当模型过于简单,无法捕捉数据的基本规律时,就会出现欠拟合现象。这通常在使用较浅网络进行复杂图像任务时发生。

### 3.2.1 网络结构与复杂度的影响

网络结构和复杂度对于欠拟合问题有直接影响。如果模型的容量不足,即其能力无法匹配任务的复杂度,就很容易出现欠拟合。

假设我们仅使用了一个具有一个隐藏层的简单神经网络进行图像识别,这很可能导致模型无法学习到足够的特征来区分不同的图像类别。

下面展示了一个简单全连接网络的示例:

```python

from keras.models import Sequential

from keras.layers import Dense, Flatten

model = Sequential()

model.add(Flatten(input_shape=(64, 64, 3)))

model.add(Dense(100, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 编译和训练模型的代码(省略)

```

### 3.2.2 迁移学习在解决欠拟合中的应用

迁移学习是解决欠拟合问题的有效手段,特别是对于图像识别任务而言。通过迁移学习,我们可以利用预训练模型在大型数据集上学习到的特征表示,并将其应用到特定的小数据集任务中。

预训练模型通常在像ImageNet这样的大型数据集上训练,已经学习到了丰富的特征。将这些预训练模型(例如VGG16、ResNet等)应用到新的图像任务上时,我们只需要在最后添加一些自定义层即可。

```python

from keras.applications import VGG16

# 载入预训练的VGG16模型

base_model = VGG16(weights='imagenet', include_top=False, input_shape=(64, 64, 3))

# 在预训练模型的基础上添加自定义层

model = Sequential()

model.add(base_model)

model.add(Flatten())

model.add(Dense(256, activation='relu'))

model.add(Dense(1, activation='sigmoid'))

# 冻结预训练模型的权重,只训练自定义层

for layer in base_model.layers:

layer.trainable = False

# 编译和训练模型的代码(省略)

```

## 3.3 模型优化与案例研究

在图像识别任务中,优化模型是提高准确率和泛化能力的关键步骤。适当的超参数调整以及对训练过程中的监控对于实现这一目标至关重要。

### 3.3.1 超参数调整与优化策略

超参数的调整对于模型的性能有显著影响。例如,学习率、批量大小、优化器的选择等都对训练结果有着决定性的作用。

通过系统地调整这些超参数,可以找到最优的模型配置。常用的超参数优化方法包括网格搜索、随机搜索和贝叶斯优化。

```python

# 超参数网格搜索示例

from keras.wrappers.scikit_learn import KerasClassifier

from sklearn.model_selection import GridSearchCV

def

```

0

0