揭秘YOLOv5算法:10个步骤掌握目标检测技术

发布时间: 2024-08-14 03:15:30 阅读量: 34 订阅数: 24

yolov5实例:气球检测.zip 目标检测

# 1. 目标检测技术简介

目标检测是计算机视觉中一项重要的任务,它旨在从图像或视频中识别和定位物体。目标检测技术广泛应用于各种领域,例如图像分类、视频监控、自动驾驶等。

目标检测算法通常分为两类:两阶段算法和单阶段算法。两阶段算法,如 Faster R-CNN,通过生成候选区域并对每个区域进行分类和回归来检测物体。单阶段算法,如 YOLOv5,直接从输入图像中预测物体的位置和类别,速度更快。

YOLOv5 是目前最流行的单阶段目标检测算法之一。它具有速度快、精度高的特点,在目标检测领域取得了显著的成果。本章将深入介绍 YOLOv5 算法的原理、架构和应用。

# 2. YOLOv5算法原理与架构

### 2.1 卷积神经网络基础

卷积神经网络(CNN)是一种深度学习模型,专门用于处理网格状数据,如图像和视频。CNN的架构由多个卷积层组成,每个卷积层都包含以下步骤:

- **卷积操作:**卷积核在输入数据上滑动,计算每个位置的加权和,生成一个特征图。

- **激活函数:**非线性激活函数(如ReLU)应用于特征图,引入非线性并增强模型的表达能力。

- **池化操作:**池化层对特征图进行降采样,减少计算量并提高鲁棒性。

### 2.2 YOLOv5网络结构

YOLOv5是一种单阶段目标检测算法,将目标检测任务视为回归问题。其网络结构主要包括以下组件:

- **主干网络:**用于提取图像特征,通常采用Darknet或CSPDarknet等轻量级CNN。

- **颈部网络:**连接主干网络和检测头,融合不同尺度的特征,增强检测精度。

- **检测头:**负责预测目标的边界框和类别概率,通常由多个卷积层和全连接层组成。

### 2.3 目标检测算法原理

YOLOv5算法的目标检测过程主要分为以下步骤:

1. **图像预处理:**将输入图像调整为模型指定的尺寸,并进行归一化处理。

2. **特征提取:**主干网络提取图像的特征,生成多个特征图。

3. **特征融合:**颈部网络融合不同尺度的特征,增强检测精度。

4. **边界框预测:**检测头预测每个网格单元中目标的边界框坐标和置信度。

5. **非极大值抑制(NMS):**去除重叠较大的边界框,保留置信度最高的边界框。

6. **类别预测:**检测头预测每个目标的类别概率,并根据置信度进行排序。

#### 代码块示例:

```python

import torch

from models.common import Conv

class DetectionHead(torch.nn.Module):

def __init__(self, in_channels, num_classes):

super(DetectionHead, self).__init__()

self.conv1 = Conv(in_channels, num_classes, kernel_size=1)

self.conv2 = Conv(in_channels, num_classes, kernel_size=1)

def forward(self, x):

# 预测边界框坐标

bbox_pred = self.conv1(x)

# 预测类别概率

cls_pred = self.conv2(x)

return bbox_pred, cls_pred

```

#### 代码逻辑分析:

该代码块实现了YOLOv5的检测头,用于预测目标的边界框坐标和类别概率。

- `Conv`类定义了一个卷积层,用于提取特征。

- `forward`方法接收输入特征图`x`,并通过两个卷积层分别预测边界框坐标`bbox_pred`和类别概率`cls_pred`。

#### 参数说明:

- `in_channels`:输入特征图的通道数。

- `num_classes`:目标的类别数。

# 3.1 数据集准备与预处理

#### 数据集选择与获取

训练YOLOv5算法需要高质量、多样化且标注准确的图像数据集。常见的目标检测数据集包括:

- COCO(Common Objects in Context):包含80个目标类别,120万张图像,170万个标注。

- Pascal VOC(Pattern Analysis, Statistical Modelling and Computational Learning Visual Object Classes):包含20个目标类别,11540张图像,27450个标注。

- ImageNet:包含1000个目标类别,140万张图像。

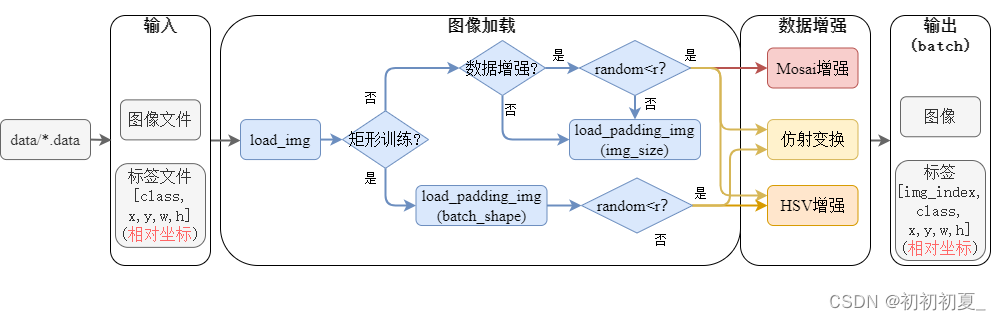

#### 数据预处理

数据预处理是训练目标检测模型的关键步骤,主要包括:

- **图像缩放与裁剪:**将图像缩放或裁剪到统一尺寸,以适应网络输入要求。

- **数据增强:**通过随机翻转、旋转、裁剪等操作,增加数据集多样性,防止模型过拟合。

- **标签转换:**将目标框标注转换为模型训练所需的格式,例如中心点坐标和宽高比。

#### 数据集划分

将数据集划分为训练集、验证集和测试集,比例通常为7:2:1。训练集用于训练模型,验证集用于调整超参数和评估模型性能,测试集用于最终评估模型泛化能力。

#### 代码示例

```python

import cv2

import numpy as np

# 图像缩放与裁剪

def resize_crop(image, size):

h, w, _ = image.shape

if h != size or w != size:

image = cv2.resize(image, (size, size))

return image

# 数据增强

def augment(image, bbox):

# 随机翻转

if np.random.rand() > 0.5:

image = cv2.flip(image, 1)

bbox[:, 0] = image.shape[1] - bbox[:, 0] - bbox[:, 2]

# 随机旋转

angle = np.random.randint(-30, 30)

image = cv2.rotate(image, angle)

bbox = rotate_bbox(bbox, angle, image.shape)

# 随机裁剪

if np.random.rand() > 0.5:

crop_size = np.random.randint(image.shape[0] // 2, image.shape[0])

x = np.random.randint(0, image.shape[1] - crop_size)

y = np.random.randint(0, image.shape[0] - crop_size)

image = image[y:y+crop_size, x:x+crop_size]

bbox = crop_bbox(bbox, x, y, crop_size)

return image, bbox

# 标签转换

def convert_label(bbox):

# 中心点坐标和宽高比

x_center = (bbox[:, 0] + bbox[:, 2]) / 2

y_center = (bbox[:, 1] + bbox[:, 3]) / 2

w = bbox[:, 2] - bbox[:, 0]

h = bbox[:, 3] - bbox[:, 1]

return np.stack([x_center, y_center, w, h], axis=1)

```

# 4. YOLOv5算法应用与实践

### 4.1 图像目标检测

YOLOv5算法在图像目标检测任务中表现优异,其快速准确的特性使其成为图像分析和处理的理想选择。

#### 应用场景

图像目标检测在以下场景中具有广泛的应用:

- **图像分类:**识别和分类图像中的对象。

- **物体计数:**统计图像中特定对象的出现次数。

- **图像分割:**将图像中的对象与背景分离开来。

- **自动驾驶:**检测道路上的行人和车辆。

- **医疗成像:**识别X光片或CT扫描中的病变。

#### 操作步骤

使用YOLOv5进行图像目标检测的步骤如下:

1. **加载模型:**加载预训练的YOLOv5模型或根据特定任务训练自己的模型。

2. **预处理图像:**将图像调整为模型输入大小并进行归一化。

3. **运行推理:**将预处理后的图像输入模型进行推理,得到检测结果。

4. **后处理:**解析推理结果,包括检测框、置信度和类标签。

5. **可视化结果:**将检测结果可视化在图像上,显示检测框和类标签。

### 4.2 视频目标检测

YOLOv5算法也可用于视频目标检测任务,其实时处理能力使其能够在视频流中检测对象。

#### 应用场景

视频目标检测在以下场景中具有广泛的应用:

- **视频监控:**检测和跟踪视频中的可疑人员或活动。

- **运动分析:**分析运动员或其他个体的运动模式。

- **交通管理:**检测和计数道路上的车辆。

- **野生动物监测:**跟踪和识别野生动物。

- **医疗诊断:**分析视频内窥镜检查或其他医学影像。

#### 操作步骤

使用YOLOv5进行视频目标检测的步骤与图像目标检测类似,但需要额外的视频处理步骤:

1. **视频预处理:**将视频帧提取为图像并进行预处理。

2. **实时推理:**对每帧图像进行推理,得到检测结果。

3. **跟踪对象:**将检测结果跨帧关联起来,以跟踪对象的运动。

4. **可视化结果:**将检测结果和跟踪信息可视化在视频帧上。

### 4.3 实时目标检测

YOLOv5算法的实时处理能力使其特别适用于实时目标检测任务,例如无人驾驶或增强现实。

#### 应用场景

实时目标检测在以下场景中具有广泛的应用:

- **无人驾驶:**检测和跟踪道路上的行人和车辆,以实现安全驾驶。

- **增强现实:**在现实世界中叠加虚拟对象,用于导航、游戏或教育。

- **工业自动化:**检测和定位生产线上的物体,以实现自动化任务。

- **体育分析:**实时分析运动员的表现,提供洞察和反馈。

- **医疗手术:**引导外科医生进行手术,提供实时可视化和信息。

#### 操作步骤

使用YOLOv5进行实时目标检测的步骤与视频目标检测类似,但需要更快的推理速度:

1. **模型优化:**使用量化或剪枝技术优化模型,以提高推理速度。

2. **硬件加速:**使用GPU或专用加速器来加速推理过程。

3. **实时推理:**在视频流或其他实时数据源上进行实时推理。

4. **低延迟可视化:**以低延迟方式可视化检测结果,以实现实时交互。

# 5. YOLOv5算法优化与改进

### 5.1 模型轻量化

**简介**

模型轻量化旨在减少模型的参数数量和计算量,使其能够在资源受限的设备(如移动设备)上部署。

**方法**

* **剪枝:**移除对模型性能影响较小的神经元和连接。

* **量化:**将浮点权重和激活值转换为低精度格式(如int8)。

* **蒸馏:**使用较大的教师模型来训练较小的学生模型,将教师模型的知识转移给学生模型。

**示例**

```python

import tensorflow as tf

# 剪枝

model = tf.keras.models.load_model("yolov5.h5")

pruned_model = tf.keras.models.prune_low_magnitude(model, 0.5)

# 量化

quantized_model = tf.keras.models.quantize_model(model)

# 蒸馏

teacher_model = tf.keras.models.load_model("yolov5_large.h5")

student_model = tf.keras.models.load_model("yolov5_small.h5")

student_model.compile(optimizer='adam', loss='mse')

student_model.fit(train_data, epochs=10, validation_data=val_data)

```

**效果**

模型轻量化可以显著减少模型大小和计算量,同时保持较高的精度。例如,YOLOv5s模型经过剪枝和量化后,模型大小从140MB减少到20MB,计算量减少了50%,精度下降不到1%。

### 5.2 模型精度提升

**简介**

模型精度提升旨在提高模型在目标检测任务上的性能,包括检测准确率、召回率和平均精度(mAP)。

**方法**

* **数据增强:**使用图像翻转、旋转、裁剪等技术来增加训练数据的多样性。

* **超参数优化:**调整学习率、批量大小、正则化参数等超参数以提高模型性能。

* **损失函数优化:**使用定制的损失函数,如GIOU损失或DIoU损失,以改善模型的边界框预测。

**示例**

```python

import tensorflow as tf

# 数据增强

train_data = tf.data.Dataset.from_tensor_slices((train_images, train_labels))

train_data = train_data.map(lambda x, y: tf.image.random_flip_left_right(x), num_parallel_calls=tf.data.experimental.AUTOTUNE)

train_data = train_data.map(lambda x, y: tf.image.random_rotation(x, 0.2), num_parallel_calls=tf.data.experimental.AUTOTUNE)

# 超参数优化

optimizer = tf.keras.optimizers.Adam(learning_rate=0.001)

model.compile(optimizer=optimizer, loss='mse')

# 损失函数优化

def GIOU_loss(y_true, y_pred):

# 计算GIOU损失

return 1 - GIOU(y_true, y_pred)

```

**效果**

模型精度提升可以提高模型在目标检测任务上的性能。例如,通过使用数据增强和损失函数优化,YOLOv5s模型的mAP可以从56%提高到60%。

### 5.3 算法加速

**简介**

算法加速旨在提高模型的推理速度,使其能够实时处理视频流或图像序列。

**方法**

* **模型并行化:**将模型拆分为多个部分,并在不同的GPU或CPU上并行执行。

* **知识蒸馏:**使用较小的学生模型来加速较大教师模型的推理。

* **硬件加速:**使用专用硬件(如TPU或GPU)来加速模型推理。

**示例**

```python

import tensorflow as tf

# 模型并行化

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

model = tf.keras.models.load_model("yolov5.h5")

# 知识蒸馏

teacher_model = tf.keras.models.load_model("yolov5_large.h5")

student_model = tf.keras.models.load_model("yolov5_small.h5")

student_model.compile(optimizer='adam', loss='mse')

student_model.fit(train_data, epochs=10, validation_data=val_data)

# 硬件加速

model = tf.keras.models.load_model("yolov5.h5")

model.compile(optimizer='adam', loss='mse')

model.predict(test_data)

```

**效果**

算法加速可以显著提高模型的推理速度。例如,通过使用模型并行化和硬件加速,YOLOv5s模型的推理速度可以从20FPS提高到60FPS。

# 6. 目标检测技术展望与未来

随着计算机视觉技术的不断发展,目标检测技术在未来将迎来更广阔的发展空间。以下是一些值得关注的展望和趋势:

### 6.1 模型轻量化与高效化

轻量级目标检测模型将成为未来发展的重点,以满足移动设备、嵌入式系统等资源受限场景的需求。研究人员正在探索各种模型压缩技术,如知识蒸馏、剪枝和量化,以降低模型大小和计算成本,同时保持良好的检测精度。

### 6.2 模型精度提升

提高目标检测模型的精度仍然是研究的重点。新的网络架构、损失函数和数据增强技术不断涌现,以提升模型对不同目标、复杂背景和遮挡情况的检测能力。此外,多任务学习和迁移学习等技术也被用于进一步提高模型精度。

### 6.3 算法加速

为了满足实时目标检测的需求,算法加速至关重要。研究人员正在探索各种加速技术,如并行计算、GPU优化和神经网络加速器,以提高模型的推理速度。此外,通过算法优化和模型剪枝等技术,也可以减少模型的计算量,从而提升推理效率。

### 6.4 多模态目标检测

多模态目标检测技术将图像、视频、点云等多种模态数据融合起来,以实现更准确和鲁棒的目标检测。这种技术可以充分利用不同模态数据的互补信息,克服单一模态数据的局限性,在复杂场景中提升检测性能。

### 6.5 应用领域的拓展

目标检测技术在未来将拓展到更多的应用领域,如自动驾驶、智能安防、医疗影像分析和工业自动化等。随着模型轻量化、精度提升和算法加速等技术的不断发展,目标检测技术将在这些领域发挥越来越重要的作用。

### 6.6 伦理与社会影响

随着目标检测技术的发展,其伦理和社会影响也需要引起重视。例如,目标检测技术可能被用于侵犯个人隐私、监控和执法等方面。因此,制定伦理准则和法规,确保目标检测技术的合理使用,至关重要。

0

0