揭秘计算机视觉背后的数学原理:图像处理与机器学习

发布时间: 2024-08-26 04:15:26 阅读量: 38 订阅数: 21

# 1. 计算机视觉概述**

计算机视觉是一个计算机科学领域,它赋予计算机“看”和“理解”图像和视频的能力。它涉及从图像和视频中提取有意义的信息,例如对象、场景和事件。计算机视觉技术广泛应用于各种领域,包括:

* **图像处理:**增强图像质量、去除噪声和提取特征。

* **图像分割:**将图像分解为不同的区域或对象。

* **目标检测:**识别和定位图像中的特定对象。

* **机器学习:**训练计算机识别和分类图像中的模式。

* **深度学习:**使用神经网络处理图像和视频数据,实现更高级别的理解。

# 2.1 图像表示和处理

### 2.1.1 像素、通道和图像格式

**像素**是图像的基本单位,它表示图像中一个特定位置的颜色值。像素通常由三个通道组成:红色(R)、绿色(G)和蓝色(B)。这些通道的值决定了像素的最终颜色。

**图像格式**定义了图像数据的存储和组织方式。常见的图像格式包括:

* **JPEG (Joint Photographic Experts Group)**:一种有损压缩格式,用于存储照片和图像。

* **PNG (Portable Network Graphics)**:一种无损压缩格式,用于存储带有透明度的图像。

* **GIF (Graphics Interchange Format)**:一种支持动画的无损压缩格式。

* **TIFF (Tagged Image File Format)**:一种无损压缩格式,用于存储高分辨率图像。

### 2.1.2 图像增强和噪声去除

**图像增强**技术用于改善图像的视觉质量。常见的图像增强技术包括:

* **对比度增强**:调整图像中明暗区域之间的差异。

* **亮度调整**:改变图像的整体亮度。

* **锐化**:增强图像中边缘的清晰度。

**噪声去除**技术用于从图像中去除不必要的噪声。常见的噪声去除技术包括:

* **中值滤波**:用图像中像素的平均值替换噪声像素。

* **高斯滤波**:使用加权平均值替换噪声像素,权重随与噪声像素的距离而减小。

* **形态学操作**:使用图像形态学操作(如膨胀和腐蚀)来去除噪声。

**代码示例:**

```python

import cv2

# 读取图像

image = cv2.imread('image.jpg')

# 对比度增强

enhanced_image = cv2.equalizeHist(image)

# 噪声去除

denoised_image = cv2.fastNlMeansDenoising(enhanced_image)

# 显示图像

cv2.imshow('Original Image', image)

cv2.imshow('Enhanced Image', enhanced_image)

cv2.imshow('Denoised Image', denoised_image)

cv2.waitKey(0)

cv2.destroyAllWindows()

```

**逻辑分析:**

* `cv2.equalizeHist()` 函数使用直方图均衡化来增强图像对比度。

* `cv2.fastNlMeansDenoising()` 函数使用非局部均值算法来去除图像噪声。

* `cv2.imshow()` 函数显示图像。

# 3. 机器学习在计算机视觉中的应用

计算机视觉与机器学习的结合为图像和视频分析带来了革命性的突破。机器学习算法赋予计算机“学习”图像和视频中模式和特征的能力,从而实现各种复杂的视觉任务。

### 3.1 监督学习与无监督学习

机器学习算法可分为两大类:监督学习和无监督学习。

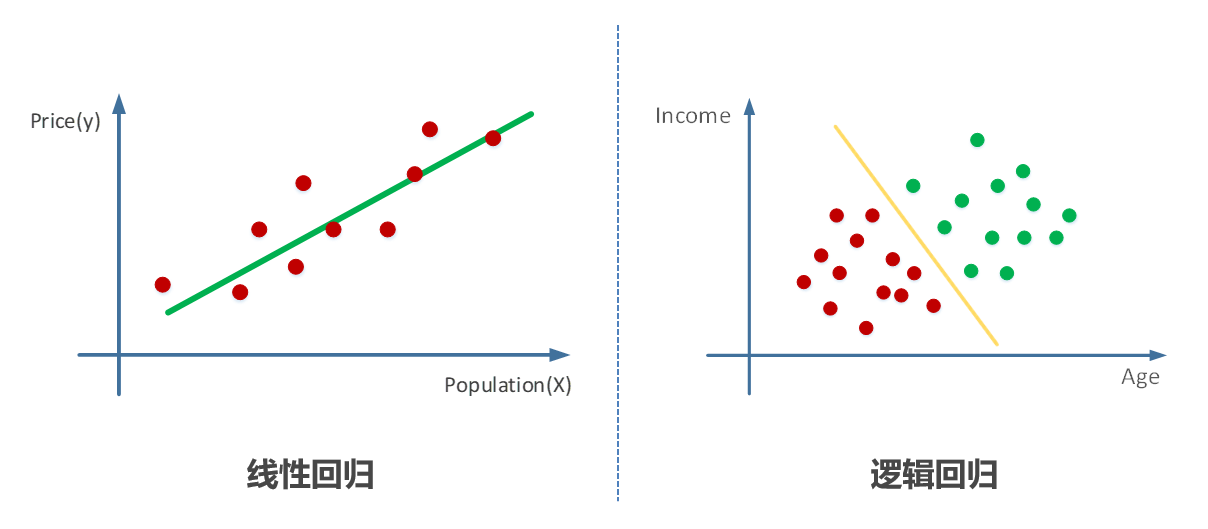

#### 3.1.1 分类和回归任务

**监督学习**涉及使用标记数据(即已知输入和输出对)来训练算法。在计算机视觉中,监督学习通常用于分类和回归任务。

* **分类任务**的目标是将图像或视频中的对象或场景分配到预定义的类别中。例如,图像分类算法可以将图像分类为“猫”、“狗”或“汽车”。

* **回归任务**的目标是预测图像或视频中的连续值。例如,回归算法可以预测图像中对象的距离或速度。

#### 3.1.2 聚类和降维

**无监督学习**涉及使用未标记数据来发现数据中的模式和结构。在计算机视觉中,无监督学习通常用于聚类和降维任务。

* **聚类**的目标是将图像或视频中的对象或场景分组到相似组中。例如,聚类算法可以将图像中的对象分组为“人”、“汽车”和“建筑物”。

* **降维**的目标是将高维数据(如图像或视频)投影到较低维度的空间中,同时保留其关键信息。例如,降维算法可以将图像从三维RGB空间投影到二维空间,从而简化处理和分析。

### 3.2 深度学习在计算机视觉中的突破

深度学习是一种机器学习技术,它使用多层神经网络来学习数据中的复杂模式。在计算机视觉中,深度学习已取得了突破性的进展,特别是在卷积神经网络(CNN)领域。

#### 3.2.1 卷积神经网络(CNN)

**卷积神经网络**(CNN)是一种专门用于处理图像和视频数据的深度神经网络。CNN 使用卷积运算来提取图像中的特征,然后通过池化层来减少特征图的尺寸。通过堆叠多个卷积层和池化层,CNN 可以学习图像中的复杂模式。

#### 3.2.2 目标检测和图像分割中的应用

CNN 已广泛应用于计算机视觉中的目标检测和图像分割任务。

* **目标检测**的目标是定位图像或视频中的对象并对其进行分类。CNN 可以使用滑动窗口或区域建议网络(RPN)来生成目标候选区域,然后使用分类器来预测每个候选区域的类别和边界框。

* **图像分割**的目标是将图像或视频中的像素分配到不同的语义区域。CNN 可以使用全卷积网络(FCN)或 U-Net 架构来生成像素级的分割掩码,从而将图像分割成不同的对象或区域。

**代码块:**

```python

import tensorflow as tf

# 创建一个卷积神经网络模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D((2, 2)),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=10)

# 评估模型

model.evaluate(x_test, y_test)

```

**逻辑分析:**

这段代码展示了一个卷积神经网络模型的创建、编译和训练过程。

* `tf.keras.models.Sequential()` 创建了一个顺序模型,其中层按顺序堆叠。

* `tf.keras.layers.Conv2D()` 创建一个卷积层,它使用卷积运算提取图像中的特征。

* `tf.keras.layers.MaxPooling2D()` 创建一个池化层,它通过最大值池化来减少特征图的尺寸。

* `tf.keras.layers.Flatten()` 将特征图展平为一维向量。

* `tf.keras.layers.Dense()` 创建一个全连接层,它用于分类。

* `model.compile()` 编译模型,指定优化器、损失函数和度量标准。

* `model.fit()` 训练模型,使用训练数据和标签。

* `model.evaluate()` 评估模型,使用测试数据和标签。

**表格:**

| 层类型 | 参数 | 功能 |

|---|---|---|

| 卷积层 | 卷积核大小、步长、激活函数 | 提取图像特征 |

| 池化层 | 池化大小、池化类型 | 减少特征图尺寸 |

| 全连接层 | 节点数、激活函数 | 分类或回归 |

# 4.1 人脸识别与生物特征识别

### 4.1.1 人脸检测和特征提取

**人脸检测**

人脸检测是计算机视觉中一项基本任务,其目的是在图像或视频中找到人脸。常用的方法包括:

- **Haar 特征:**利用 Haar 特征提取器检测人脸的边缘和纹理。

- **级联分类器:**将多个 Haar 特征级联起来,形成一个强大的分类器。

- **深度学习:**使用卷积神经网络(CNN)从图像中学习人脸特征。

**特征提取**

人脸检测后,需要提取特征以用于识别。常用的特征提取方法包括:

- **局部二值模式(LBP):**将人脸图像划分为小区域,并计算每个区域的二进制模式。

- **直方图定向梯度(HOG):**计算人脸图像中梯度的方向和幅度分布。

- **深度学习:**使用 CNN 从人脸图像中提取高级特征。

### 4.1.2 生物特征识别算法

生物特征识别是使用个体独特的生理或行为特征进行身份验证或识别的技术。常用的生物特征识别算法包括:

- **指纹识别:**分析指纹的脊线和纹路。

- **虹膜识别:**扫描虹膜的独特图案。

- **人脸识别:**利用人脸图像中的特征进行识别。

**人脸识别算法**

人脸识别算法通常分为两类:

- **基于几何特征的算法:**测量人脸的几何特征,如眼睛和嘴巴之间的距离。

- **基于统计特征的算法:**提取人脸图像中的统计特征,如像素强度分布。

**生物特征识别应用**

生物特征识别技术广泛应用于:

- 安全和身份验证

- 医疗保健和患者识别

- 执法和犯罪调查

- 边境管制和出入境管理

**代码示例:**

```python

import cv2

# 人脸检测

face_cascade = cv2.CascadeClassifier('haarcascade_frontalface_default.xml')

image = cv2.imread('image.jpg')

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

faces = face_cascade.detectMultiScale(gray, 1.1, 4)

# 特征提取

lbp = cv2.createLBPHFaceRecognizer()

lbp.train(faces, np.arange(len(faces)))

# 识别

result = lbp.predict(cv2.cvtColor(cv2.imread('new_image.jpg'), cv2.COLOR_BGR2GRAY))

print(f'识别结果:{result}')

```

**逻辑分析:**

1. 使用 Haar 级联分类器检测人脸。

2. 将检测到的人脸转换为灰度图像。

3. 使用 LBP 算法提取人脸特征。

4. 训练 LBP 分类器以识别人脸。

5. 使用训练好的分类器识别新图像中的人脸。

# 5.1 增强现实与虚拟现实

### 5.1.1 AR/VR 技术原理

**增强现实(AR)**是一种将虚拟信息叠加到真实世界中的技术。它通过摄像头或其他传感器实时捕捉现实场景,并通过显示器或眼镜将虚拟内容与现实场景融合在一起。AR 技术广泛应用于游戏、教育、旅游等领域。

**虚拟现实(VR)**是一种完全沉浸式的体验,它通过头戴式显示器将用户带入一个虚拟环境中。VR 技术利用头部追踪和立体显示技术,让用户感觉自己置身于虚拟世界中。VR 技术主要应用于游戏、娱乐、教育和培训领域。

### 5.1.2 计算机视觉在 AR/VR 中的作用

计算机视觉在 AR/VR 中扮演着至关重要的角色,它使设备能够理解和处理周围环境。具体来说,计算机视觉技术在 AR/VR 中有以下应用:

* **环境感知:**计算机视觉算法可以分析摄像头或传感器捕获的图像或视频,以理解周围环境。这包括检测物体、表面和特征点,以及估计深度和运动。

* **物体识别:**计算机视觉技术可以识别现实世界中的物体,并提供有关其位置、大小和类型的详细信息。这在 AR 应用中非常有用,例如将虚拟家具放置在真实房间中。

* **手势识别:**计算机视觉技术可以检测和识别用户的肢体动作和手势。这在 VR 应用中非常有用,例如控制虚拟角色或与虚拟环境交互。

* **空间定位:**计算机视觉技术可以估计设备在物理空间中的位置和方向。这在 AR 应用中非常有用,例如将虚拟内容与现实世界中的物体对齐。

## 5.2 无人驾驶汽车与智能机器人

### 5.2.1 感知和决策算法

无人驾驶汽车和智能机器人需要强大的感知和决策算法,以安全有效地导航环境。这些算法利用计算机视觉技术来感知周围环境,并做出相应的决策。

**感知算法:**感知算法负责从传感器(如摄像头、激光雷达、雷达)收集的数据中提取有意义的信息。这些算法包括:

* **物体检测:**检测道路上的车辆、行人、交通标志和其他物体。

* **语义分割:**将图像中的像素分类为不同的类别,例如道路、人行道、建筑物。

* **深度估计:**估计场景中物体的距离和深度。

**决策算法:**决策算法基于感知算法提供的信息,做出有关车辆或机器人的动作的决策。这些算法包括:

* **路径规划:**规划车辆或机器人的安全路径,避开障碍物和遵守交通规则。

* **运动控制:**控制车辆或机器人的运动,以执行路径规划。

* **行为预测:**预测其他车辆、行人或物体的行为,以做出安全决策。

### 5.2.2 计算机视觉在无人驾驶和机器人中的应用

计算机视觉在无人驾驶汽车和智能机器人中有着广泛的应用,包括:

* **环境感知:**计算机视觉算法可以分析传感器数据,以理解周围环境,包括检测物体、估计深度和跟踪运动。

* **物体识别:**计算机视觉技术可以识别道路上的车辆、行人、交通标志和其他物体,并提供有关其位置、大小和类型的详细信息。

* **障碍物检测:**计算机视觉算法可以检测道路上的障碍物,例如车辆、行人、交通标志和建筑物,并发出警告或采取规避措施。

* **车道线检测:**计算机视觉技术可以检测车道线,并指导车辆保持在车道内。

* **交通标志识别:**计算机视觉技术可以识别交通标志,并提醒驾驶员或机器人遵守交通规则。

# 6. 计算机视觉的伦理和社会影响

### 6.1 隐私和安全问题

计算机视觉技术在提升便利性的同时,也带来了隐私和安全方面的担忧。

**6.1.1 面部识别技术的伦理考量**

面部识别技术能够快速准确地识别个体,但也引发了隐私侵犯的担忧。未经同意收集和使用面部数据可能导致身份盗用、跟踪和监视。

**6.1.2 生物特征识别技术的潜在风险**

生物特征识别技术,如指纹和虹膜扫描,被用于安全目的。然而,这些特征是固有的,一旦泄露,无法更改,这增加了身份盗用和欺诈的风险。

### 6.2 偏见与歧视

计算机视觉算法在训练过程中依赖于数据,而数据可能包含偏见。

**6.2.1 训练数据中的偏见**

训练数据中代表性不足或不平衡会导致算法对某些群体产生偏见。例如,如果训练数据中女性较少,算法可能无法准确识别女性面孔。

**6.2.2 算法决策的公平性**

计算机视觉算法的决策可能对个人产生重大影响,例如在招聘、贷款和执法中。偏见算法可能会歧视某些群体,导致不公平的结果。

### 伦理考量和社会影响的应对措施

解决计算机视觉的伦理和社会影响需要多方面的努力:

- **法规和政策:**制定法律和政策来保护隐私、防止滥用和确保算法公平性。

- **行业自律:**计算机视觉行业应制定道德准则和最佳实践,以负责任地使用技术。

- **公众教育:**提高公众对计算机视觉技术的潜在影响的认识,并鼓励负责任的使用。

- **技术创新:**开发新的技术和方法来减轻偏见,保护隐私并确保算法公平性。

0

0