避免梯度消失:Dropout应用中隐藏的技巧和陷阱

发布时间: 2024-11-24 07:09:33 阅读量: 35 订阅数: 23

Dropout:互联网连接中的输出和_或日志丢失

# 1. 神经网络中的梯度消失问题

深度学习模型在训练过程中经常面临梯度消失问题,即当网络层足够深时,后向传播算法计算得到的梯度会逐渐衰减至接近零,导致网络参数更新极其缓慢,最终影响模型的学习效率和性能。这主要是由于深层网络中链式法则的作用,激活函数(如sigmoid或tanh)在输入值较大或较小时其导数值接近零,使得梯度在传递过程中逐步减小。为了解决这一问题,研究者们提出了多种优化策略,其中Dropout技术作为一种有效的正则化手段,在防止过拟合的同时,也帮助缓解了梯度消失问题。接下来的章节将深入探讨Dropout技术,以及它是如何改善神经网络性能的。

# 2. Dropout技术的理论基础

## 2.1 Dropout的工作原理

### 2.1.1 Dropout在神经网络中的作用机制

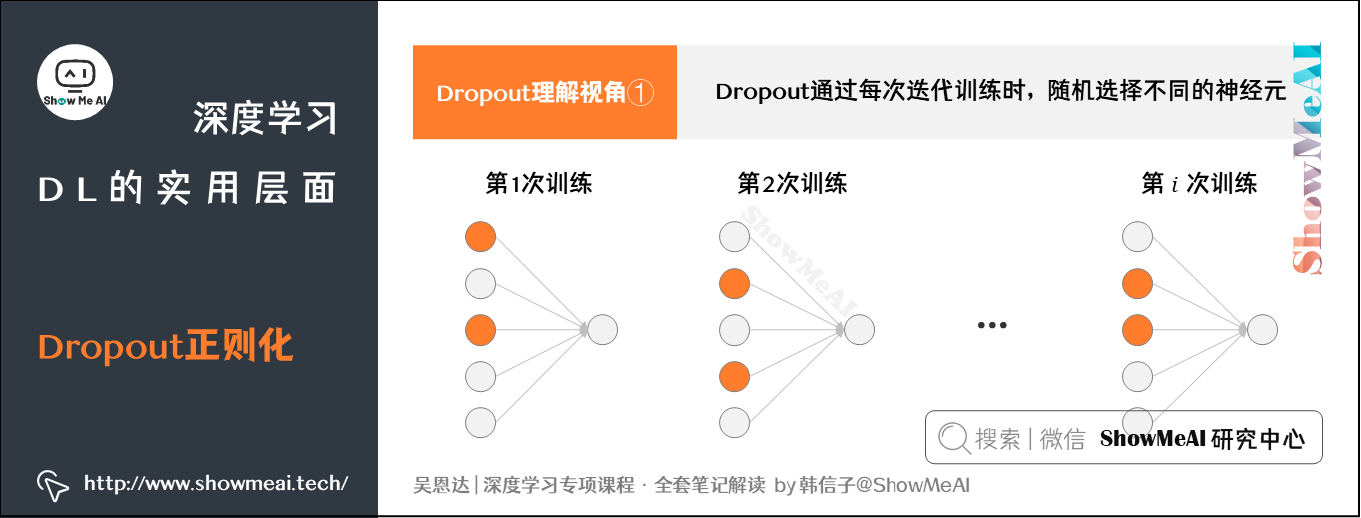

Dropout技术是神经网络中一种有效的正则化手段,其核心思想是在训练过程中随机"丢弃"神经网络中的一部分神经元,即将它们的激活值置为零,这一过程对每一个训练样本都是独立进行的。通过这种方式,网络无法依赖任何一个神经元的输出,这迫使网络学习更加鲁棒的特征表示。

从直观上理解,Dropout像是在训练多个子网络。每个子网络都包含输入层和随机选出的一部分隐藏层神经元,而每个训练批次只激活这些子网络的一部分。在测试时,所有神经元都会被激活,但它们的输出会缩放,以匹配训练时每个神经元的期望活跃程度。这样,网络在训练阶段模拟了一个大的神经网络集成,但实际测试时依然使用的是整个网络。

### 2.1.2 Dropout与正则化的关系

Dropout作为一种正则化技术,与传统的权重衰减(weight decay)等其他正则化方法有根本的不同。权重衰减通过直接惩罚模型的权重来防止过拟合,而Dropout通过在训练时随机移除神经元来工作。

具体来说,权重衰减可能会导致权重的均匀收缩,但并不直接增加模型的泛化能力。而Dropout由于其随机性,会强制模型学习更加鲁棒的特征表示。这意味着模型不会过分依赖于任何单一的神经元,从而在面对新的数据时具有更好的泛化能力。

## 2.2 Dropout的数学解释

### 2.2.1 概率图模型视角下的Dropout

概率图模型提供了一种框架来理解Dropout的数学本质。在训练过程中,通过随机地丢弃神经元,可以将Dropout看作是在神经网络上施加的一种贝叶斯推断过程。在这种观点中,每个神经元的输出都被视为一个随机变量,其值为1或0的概率取决于Dropout比率。

这允许我们把神经网络当作一个具有隐变量的贝叶斯网络,其中隐变量是神经元的输出。通过这种方式,可以使用变分推断等技术来更深入地理解Dropout对模型的影响,以及如何调整Dropout比率来优化性能。

### 2.2.2 Dropout在优化目标中的影响

在优化目标中引入Dropout,意味着每个训练样本都有一个与之相对应的子网络。这导致实际的训练损失函数是多个子网络损失函数的平均值。在优化过程中,由于子网络结构的随机性,模型被迫学习更为平滑和泛化的特征表示。

数学上,Dropout对损失函数的影响可以表示为损失函数期望的形式。对于每一个训练样本,期望损失是基于所有可能的子网络的损失函数的加权和,权重就是子网络存在的概率。这种方法对防止神经网络的过拟合非常有效,因为它减少了权重之间的协同适应,从而提高了网络的泛化能力。

Dropout在理论上的解释不仅增强了对其作用原理的理解,还为实际应用提供了重要的指导,例如如何设置合适的Dropout比率和如何在不同网络结构中应用Dropout。接下来的章节中,我们将进一步探讨Dropout在深度学习中的应用和实践技巧。

# 3. Dropout在深度学习中的应用

### 3.1 Dropout在不同网络架构中的应用

Dropout是一种在训练过程中随机丢弃神经网络中一些神经元的训练技巧,旨在减少模型对特定神经元的依赖,从而缓解过拟合。这种技术尤其在深度学习中得到了广泛应用。

#### 3.1.1 卷积神经网络(CNN)中的Dropout

CNN在图像处理中占据主导地位,Dropout作为防止过拟合的有效手段,其在CNN中的应用也得到了深入研究。在卷积层中应用Dropout时,通常是在全连接层中进行,因为卷积层具有空间层级的特性,直接在卷积层中随机丢弃神经元会破坏图像的空间结构,影响模型性能。

在实际应用中,研究者发现,将Dropout放在全连接层上(通常是在网络的末尾),而非卷积层,可以有效减少过拟合。此外,在训练阶段,Dropout会随机丢弃一些神经元,但在测试阶段,所有神经元都将参与工作,因为需要使用整个网络的推断能力。

```python

from keras.layers import Dropout

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# 定义一个简单的CNN模型

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D(pool_size=(2, 2)))

model.add(Flatten())

model.add(Dense(128, activation='relu'))

# 在全连接层上应用Dropout

model.add(Dropout(0.5))

model.add(Dense(1, activation='sigmoid'))

```

在上述代码中,Dropout层被添加到了全连接层之后,参数0.5表示在训练过程中每个神经元有50%的概率被丢弃。

#### 3.1.2 循环神经网络(RNN)中的Dropout

RNN在处理序列数据方面非常有效,如自然语言处理和时间序列分析。然而,RNN往往更容易过拟合,因此在RNN中使用Dropout也变得非常重要。

在RNN的Dropout应用中,可以对输入序列的每个时间步添加Dropout层,或对内部状态(如循环层之间的权重)应用Dropout。通常情况下,是在RNN的每个时间步的输出添加Dropout,以防止记忆单元之间产生依赖性。

```python

from keras.layers import Dropout

from keras.models import Sequential

from keras.layers import LSTM

# 定义一个带有LSTM层的简单RNN模型

model = Sequential()

model.add(LSTM(50, dropout=0.2, recurrent_dropout=0.2, input_shape=(timesteps, input_dim)))

model.add(Dense(1, activation='sigmoid'))

```

在此例中,`dropout=0.2` 表示在LSTM单元的输入和输出上应用了20%的Dropou

0

0