TensorFlow进阶:Dropout代码示例与性能调优秘籍

发布时间: 2024-11-24 06:40:29 阅读量: 5 订阅数: 7

# 1. Dropout技术简介与应用背景

在现代深度学习中,Dropout技术被广泛应用于神经网络模型中,以提高模型的泛化能力,防止过拟合。本章将介绍Dropout技术的基本概念,以及它的应用背景和在深度学习模型中的重要性。

## Dropout的定义和作用

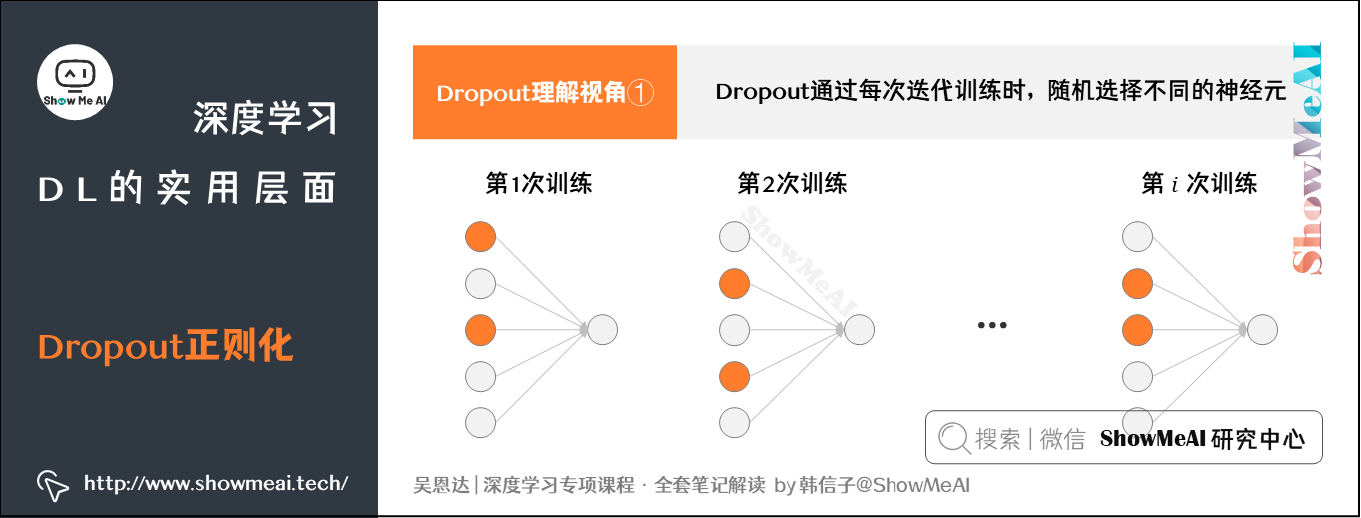

Dropout可以被理解为一种在训练过程中随机关闭神经元的正则化技术。在每个训练批次中,根据预设的保留概率(通常为0.5),随机选择部分神经元并将其暂时从网络中移除,或者将这些神经元的输出设置为零。这样,模型在每次训练时都是在使用不同的网络结构,从而鼓励网络学习更加鲁棒的特征表示。

## Dropout技术的应用背景

在构建深度神经网络时,尤其是在处理有限的数据集时,模型可能会过度地学习训练数据中的噪声和异常值,导致过拟合。过拟合是指模型在训练数据上表现良好,但在未见过的测试数据上泛化能力差。此时,引入Dropout可以有效避免过拟合,因为它强制网络不依赖于任何一个输入特征,减少模型对特定训练样本的依赖,从而提升模型的泛化能力。接下来的章节会深入讨论Dropout在不同深度学习框架中的实现以及调优技巧。

# 2. TensorFlow中的Dropout实现

## 2.1 Dropout的工作原理与数学基础

### 2.1.1 过拟合与模型泛化能力

在深度学习模型训练中,过拟合是一个普遍存在的问题,它意味着模型在训练数据上表现良好,但在未知数据上表现不佳。过拟合会导致模型在实际应用中泛化能力差,失去了模型的真正目的——在现实世界中做出准确的预测和决策。

为了解决过拟合问题,研究者们提出了多种正则化方法,其中Dropout技术是目前最流行和有效的正则化技术之一。Dropout通过对神经网络的训练过程进行修改,随机地"丢弃"(即暂时移除)一部分神经元,强迫网络在每次前向传播时都不得不依赖于一小部分随机选择的神经元,从而避免过度依赖某些特定的网络连接,有效提升了模型的泛化能力。

### 2.1.2 Dropout技术的理论支撑

Dropout的理论支撑源于对神经网络集成方法的研究。在Dropout过程中,网络的每次训练迭代都可以看作是在训练一个新的子网络,而所有这些子网络的预测结果在最终模型中被平均。从统计学的角度,这样可以模拟出一种集成学习的效果,从而提高整体模型的泛化性能。

从贝叶斯的角度来看,Dropout可以被解释为一种贝叶斯近似,其中每个子网络都可以看作是从一个更大型网络中采样得到的,而整个训练过程可以看作是在对网络的复杂度进行贝叶斯推断。这种理解为Dropout提供了一种理论基础,并启发了更多的研究者对Dropout进行深入的理论探讨。

## 2.2 Dropout的TensorFlow代码实现

### 2.2.1 基本的Dropout层添加方法

在TensorFlow中实现Dropout非常简单。通过`tf.keras.layers.Dropout`层可以轻松地向现有的神经网络模型中添加Dropout功能。下面的代码段展示了如何在一个简单的全连接神经网络中添加Dropout层。

```python

import tensorflow as tf

from tensorflow.keras.layers import Dense, Dropout

from tensorflow.keras.models import Sequential

# 假设已经定义了一个Sequential模型

model = Sequential([

# 添加Dropout层,rate参数表示丢弃的比例,即1-p,这里设置为0.5

Dropout(0.5),

# 其他层...

])

# 编译模型时,需要指定loss函数和优化器

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

```

在上面的代码中,`Dropout(0.5)`表示在训练过程中,每一层有50%的概率将单元的输出置为0。这种随机"丢弃"的行为在训练时发生,但在测试时应该关闭Dropout,以便所有单元都参与计算。

### 2.2.2 动态Dropout与训练策略

除了静态的Dropout外,TensorFlow还支持动态Dropout,允许在不同的训练阶段使用不同的丢弃率。这可以通过`tf.keras.layers.Dropout`层的`rate`参数来实现。动态调整Dropout率可以帮助模型在训练早期避免过拟合,在后期提高模型的收敛速度。

在实际应用中,动态调整Dropout率的一种策略是在训练开始时使用较高的丢弃率,随着训练进度的推移逐步降低丢弃率。这种策略利用了高丢弃率可以增强模型泛化的优点,同时避免了过度的过拟合。

```python

# 动态调整Dropout率的一个简单示例

model = Sequential([

# 在训练初期使用高丢弃率

Dropout(0.8),

# ... 其他层

# 在训练后期使用较低的丢弃率

Dropout(0.2),

# ... 其他层

])

```

## 2.3 Dropout在不同网络结构中的应用

### 2.3.1 卷积神经网络中的Dropout

在卷积神经网络(CNN)中,Dropout同样可以用来防止过拟合。在CNN中添加Dropout层通常是在全连接层之后,而不是在卷积层后。这是因为卷积层的参数通常相对较少,相比于全连接层,卷积层不太容易过拟合。

```python

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

# CNN层

Conv2D(filters=32, kernel_size=(3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D(pool_size=(2, 2)),

# ... 其他卷积层

Flatten(),

# 添加Dropout层

Dropout(0.5),

Dense(128, activation='relu'),

# ... 其他全连接层

])

```

### 2.3.2 循环神经网络中的Dropout

循环神经网络(RNN)由于其内部循环结构,更加容易出现过拟合。因此,在RNN中使用Dropout就显得尤为重要。在RNN中,常见的Dropout使用方式是在RNN层和全连接层之间添加Dropout层,以及在循环连接中添加Dropout。

```python

from tensorflow.keras.layers import LSTM, Dropout

model = Sequential([

LSTM(64, return_sequences=True, input_shape=(None, 10)),

# 在循环连接中添加Dropout

Dropout(0.5),

LSTM(64),

Dense(1, activation='sigmoid'),

# ... 其他层

])

```

在上述代码中,`Dropout(0.5)`被添加在了两个LSTM层之间,这样可以帮助模型在处理序列数据时降低过拟合的风险。需要注意的是,对于不同的RNN变体(例如LSTM、GRU等),Dropout的添加方式可能略有不同,但基本原理相同。

# 3. Dropout的性能调优技巧

## 3.1 调优参数的选择与实验方法

### 3.1.1 Dropout比率的优化

Dropout比率,即神经网络中每次迭代中被随机设置为零的节点比例,是影响模型性能的关键超参数之一。确定最优的Dropout比率通常需要通过多次实验来完成。太高的比率可能导致网络无法有效地学习到数据的重要特征,而太低的比率则可能不足以防止模型过拟合。

为了优化Dropout比率,我们可以使用交叉验证的方法,通过不断调整比率参数来观察验证集上的性能表现。例如,在一个二分类问题中,我们可能从0.2开始逐渐增加Dropout比率,直至验证集准确率开始下降为止。

```python

import tensorflow as tf

from tensorflow.keras.datasets import mnist

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Dropout

from tensorflow.keras.optimizers import Adam

# 载入MNIST数据集

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 数据预处理

x_train, x_test = x_train / 255.0, x_test / 255.0

x_train = x_train.reshape(-1, 784)

x_test = x_test.reshape(-1, 784)

# 构建模型

model = Sequential([

Dense(512, activation='relu', input_shape=(784,)),

Dropout(0.2), # 初始Dropout比率设置为0.2

Dense(10, activation='softmax')

])

# 编译模型

model.compile(optimizer=Adam(),

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# 训练模型并进行验证

history = model.fit(x_train, y_train, epochs=5, validation_split=0.2)

```

在上述代码中,我们将Dropout比率设置为0.2,并通过训练模型并观察验证集上的表现来评估该比率是否合适。如果验证集上的准确率随训练进度有所提高,且没有出现过拟合的迹象,那么这个比率可能是合适的。如果准确率开始下降或者模型过拟合,则需要适当降低或提高比率。

### 3.1.2 网络结构与Dropout的平衡

除了调整Dropout比率外,网络的深度和宽度也会对Dropout的效

0

0