【多线程应用:Beautiful Soup】:提升网络爬虫效率的秘诀

发布时间: 2024-09-30 22:31:17 阅读量: 31 订阅数: 36

# 1. 多线程在网络爬虫中的作用与优势

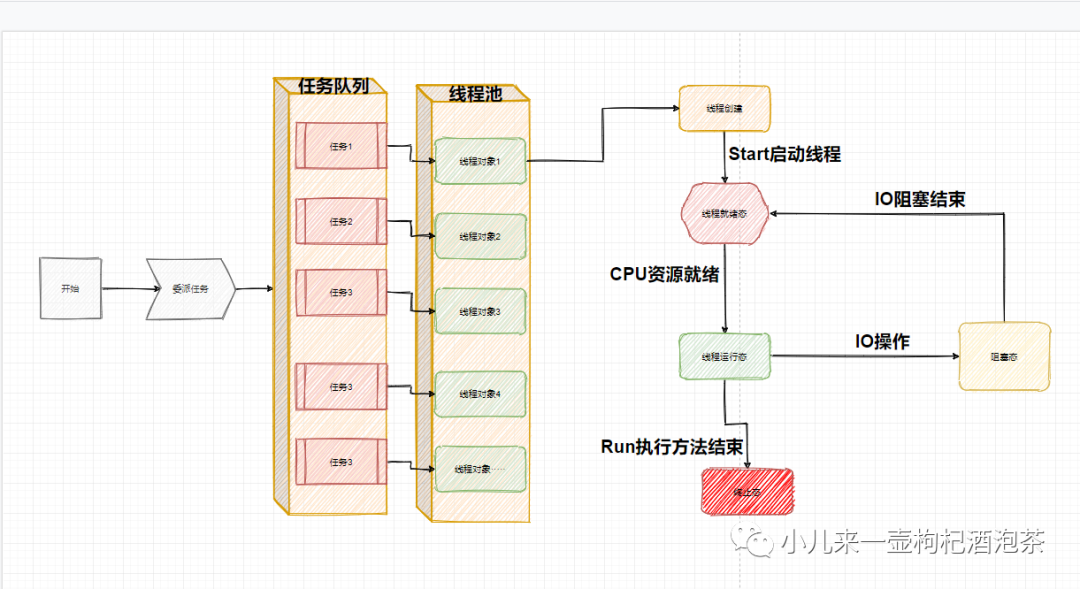

## 多线程技术简介

在网络爬虫的应用中,多线程技术可以显著提升爬取任务的执行效率。它允许多个线程同时执行,从而并行处理多个网络请求,加速数据的采集过程。线程的轻量级特性确保了资源消耗相对较低,适合于执行那些I/O密集型的任务,如频繁的网络I/O操作。

## 多线程的优势

使用多线程技术,爬虫可以在同一时间内对多个网页发起请求,大幅提高数据的采集速度。此外,多线程爬虫可以更好地利用系统的计算资源,减少因等待网络响应而造成的空闲时间。然而,需要注意的是,线程数不宜设置过多,以免造成资源竞争和管理上的困难。

## 实现多线程的挑战

在实现多线程爬虫的过程中,开发者可能会面临一些挑战,如线程同步问题、数据一致性问题等。正确地管理线程生命周期,合理同步线程间的交互,是确保爬虫稳定高效运行的关键。在后续章节中,我们将深入探讨多线程在爬虫中的具体应用,并分析如何通过各种技术手段解决这些挑战。

通过本章的介绍,我们为读者铺垫了多线程在网络爬虫中的重要性和使用优势,为后续内容的学习打下了基础。在下一章,我们将开始具体探讨如何使用Beautiful Soup库进行网页内容的解析,这是构建高效爬虫的重要步骤。

# 2. Beautiful Soup库的安装与基础使用

## 2.1 安装Beautiful Soup及其依赖库

### 2.1.1 BeautifulSoup与lxml解析器的选择

在安装Beautiful Soup之前,需要确定使用哪个解析器,Beautiful Soup支持多种解析器,包括`html.parser`, `lxml`, 和`xml`等。这里推荐使用`lxml`作为解析器,因为它是基于C语言的库,比Python自带的`html.parser`更快,也比`xml`解析器更加灵活。

在选择`lxml`时,你有两个选择:`lxml.html`和`lxml.xml`。`lxml.html`是专门用于解析HTML文档的,而`lxml.xml`则是用于解析XML。通常情况下,我们处理的是HTML文档,因此`lxml.html`是更好的选择。

安装命令如下:

```shell

pip install beautifulsoup4 lxml

```

### 2.1.2 安装过程中的常见问题及解决方法

安装过程中可能会遇到的问题包括权限不足、依赖库冲突、安装速度慢等。

- 权限不足:在Linux或Mac系统中,可以使用`sudo`提升权限来安装,例如:

```shell

sudo pip install beautifulsoup4 lxml

```

- 依赖库冲突:如果之前安装过其他版本的库,可能会导致依赖冲突。可以尝试卸载后重新安装,或者使用`--ignore-installed`参数强制安装新版本:

```shell

pip install --ignore-installed beautifulsoup4 lxml

```

- 安装速度慢:由于网络原因,可能会导致安装速度较慢。可以使用国内的镜像源进行加速,例如使用`豆瓣`镜像:

```shell

pip install beautifulsoup4 lxml -i ***

```

## 2.2 Beautiful Soup的基本操作

### 2.2.1 解析HTML/XML文档

使用Beautiful Soup解析HTML文档是构建网络爬虫的第一步。下面是一个基本的示例:

```python

from bs4 import BeautifulSoup

html_doc = """

<html><head><title>The Dormouse's story</title></head>

<p class="title"><b>The Dormouse's story</b></p>

<p class="story">Once upon a time there were three little sisters; and their names were

<a href="***" class="sister" id="link1">Elsie</a>,

<a href="***" class="sister" id="link2">Lacie</a> and

<a href="***" class="sister" id="link3">Tillie</a>;

and they lived at the bottom of a well.</p>

<p class="story">...</p>

soup = BeautifulSoup(html_doc, 'lxml')

print(soup.prettify())

```

### 2.2.2 查找、修改和删除文档节点

接下来,我们学习如何查找、修改和删除文档中的节点。

查找节点:

```python

title = soup.find('title') # 查找<title>标签

print(title.text)

```

修改节点:

```python

title.string.replace_with("The Dormouse's Tale") # 替换<title>标签内的文本

print(soup.title.text)

```

删除节点:

```python

link = soup.find('a', id='link1')

link.decompose() # 删除找到的<a>标签

print(soup.prettify())

```

### 2.2.3 解析和遍历页面元素

遍历页面元素是爬虫中非常重要的一环,Beautiful Soup提供了多种方法来帮助我们方便地遍历文档树。

遍历标签:

```python

for link in soup.find_all('a'):

print(link.get('href'))

```

遍历节点:

```python

for element in soup.recursiveChildGenerator():

if element.name == 'a':

print(element.get_text())

```

## 2.3 网络爬虫中的实际应用案例

### 2.3.1 爬取单页面的简单应用

在这个简单应用中,我们将爬取一个页面中的标题和链接。

```python

import requests

from bs4 import BeautifulSoup

url = "***"

response = requests.get(url)

soup = BeautifulSoup(response.text, 'lxml')

for link in soup.find_all('a', href=True):

print(link['href'], link.text)

```

### 2.3.2 爬取多页面的综合应用

当需要爬取多个页面时,可以结合循环和Beautiful Soup来实现。

```python

import requests

from bs4 import BeautifulSoup

base_url = "***{}"

for page_num in range(1, 11):

response = requests.get(base_url.format(page_num))

soup = BeautifulSoup(response.text, 'lxml'

```

0

0