Beautiful Soup与正则表达式:数据匹配与抽取的高效技巧

发布时间: 2024-09-30 22:41:56 阅读量: 30 订阅数: 31

# 1. 数据抽取的基本概念与需求分析

## 数据抽取简介

数据抽取是从各种数据源中提取所需信息的过程,这些数据源包括但不限于网站、数据库、API等。它在数据分析、市场研究、搜索引擎优化等领域中占有核心地位。数据抽取的关键是准确理解和实现需求分析,确保从原始数据中提取出有价值的信息。

## 需求分析的必要性

在数据抽取项目中,需求分析阶段是至关重要的。需求分析的目的是确定数据抽取的目标和范围,包括数据类型、抽取频率、数据质量要求等。一个清晰的需求分析不仅可以指导后续的数据抽取策略,还能有效避免项目返工和资源浪费。

## 数据抽取的策略

数据抽取策略的选择依赖于数据源的性质、需求的复杂度以及预期的准确性。常见的数据抽取策略包括:直接访问数据库、使用API接口、网页爬虫等。选择合适的策略对于实现高效、准确的数据抽取至关重要。

```

// 示例代码块:

// 一个简单的Python代码片段,用于说明数据抽取的基本思路

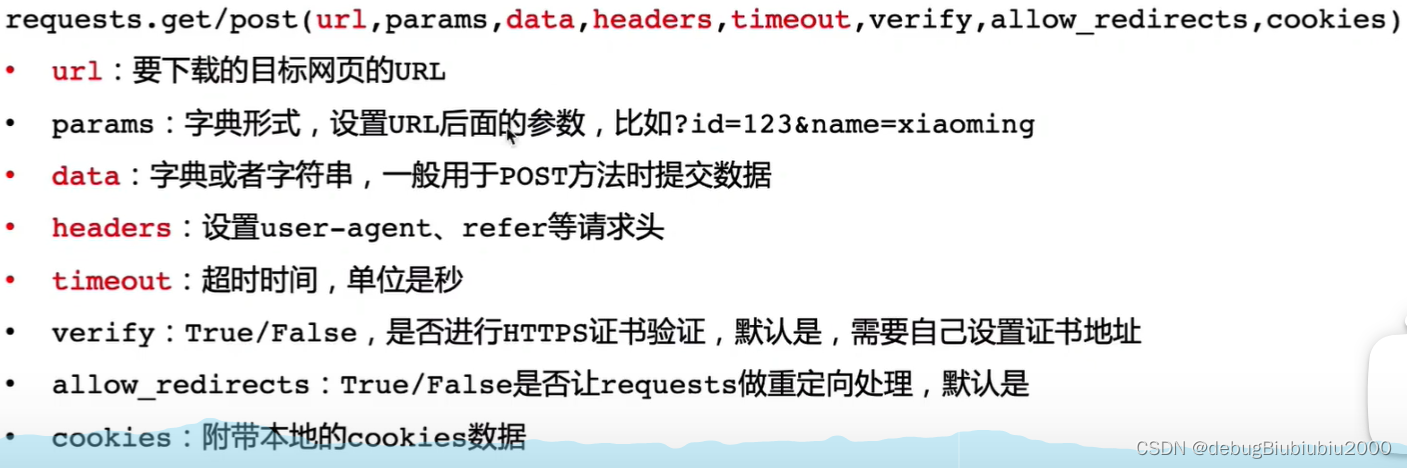

import requests

from bs4 import BeautifulSoup

# 示例网址

url = '***'

# 发送HTTP请求

response = requests.get(url)

# 使用Beautiful Soup解析HTML内容

soup = BeautifulSoup(response.text, 'html.parser')

# 假设我们要获取所有的段落文本

paragraphs = soup.find_all('p')

for p in paragraphs:

print(p.get_text())

```

在后续章节中,我们将详细介绍Beautiful Soup库在数据抽取中的应用,以及如何结合正则表达式来优化数据的提取和处理。而本章的焦点在于确保我们对数据抽取有一个全面而深入的理解。

# 2. Beautiful Soup库的应用

## 2.1 Beautiful Soup库的安装与配置

### 2.1.1 安装Beautiful Soup库

Beautiful Soup 是 Python 编程语言中用于解析 HTML 和 XML 文档的一个库,它提供了简单的 API,可以快速提取网页中的数据。安装 Beautiful Soup 非常简单,我们可以通过 pip 这个 Python 的包管理工具来安装。在命令行中输入以下指令即可完成安装:

```bash

pip install beautifulsoup4

```

安装完成后,我们可以进行一个简单的验证来确保安装成功:

```python

from bs4 import BeautifulSoup

# 创建一个BeautifulSoup对象来验证安装

soup = BeautifulSoup("<html>test</html>", 'html.parser')

print(soup)

```

上面的代码将输出一个 BeautifulSoup 对象,表明安装无误。

### 2.1.2 配置解析器与HTML文档

Beautiful Soup 支持多种解析器来解析 HTML 或 XML 文档,常用的解析器包括 'html.parser', 'lxml', 'html5lib' 等。每种解析器对文档的处理方式不尽相同,性能也不一样。在安装 Beautiful Soup 的时候,'lxml' 解析器需要额外安装:

```bash

pip install lxml

```

配置解析器非常直接,只需在创建 BeautifulSoup 对象时指定即可:

```python

from bs4 import BeautifulSoup

# 使用不同的解析器创建soup对象

soup_html_parser = BeautifulSoup("<p>测试HTML解析器</p>", 'html.parser')

soup_lxml = BeautifulSoup("<p>测试LXML解析器</p>", 'lxml')

# 打印解析结果

print(soup_html_parser)

print(soup_lxml)

```

通常情况下,'lxml' 会更快且更容易使用,不过它的安装需要额外依赖,对于简单的应用,'html.parser' 就足够了。

## 2.2 Beautiful Soup的元素搜索方法

### 2.2.1 基本选择器的使用

Beautiful Soup 提供了多种方式来搜索和选择文档树中的元素,最常用的包括:

- `find()`:找到第一个符合条件的元素。

- `find_all()`:找到所有符合条件的元素。

这些方法可以接受多个参数,包括标签名、属性、字符串等。举例来说:

```python

soup = BeautifulSoup("<p class='title'>My Title</p><p class='content'>This is the content</p>", 'html.parser')

# 找到第一个符合条件的<p>标签

first_p = soup.find("p", class_="title")

print(first_p)

# 找到所有符合条件的<p>标签

all_p = soup.find_all("p", class_="content")

print(all_p)

```

### 2.2.2 搜索树的构建与遍历

在搜索到元素后,通常需要在这些元素的基础上进一步搜索或遍历。Beautiful Soup 提供了直接的方法来遍历和搜索元素的子节点、父节点、兄弟节点等。

```python

# 获取第一个<p>标签的直接子节点

children_of_first_p = first_p.contents

print(children_of_first_p)

# 遍历元素的父节点

parents = []

current_parent = first_p.parent

while current_parent is not None:

parents.append(current_parent.name)

current_parent = current_parent.parent

print(parents)

```

### 2.2.3 CSS选择器的应用

除了 Beautiful Soup 自己的方法,我们还可以使用 CSS 选择器来选择元素,这可以让我们用非常直观的方式进行元素定位。

```python

# 使用CSS选择器选择具有特定属性的标签

content_p = soup.select_one("p.content")

print(content_p)

# 选择所有类名以"title"开头的标签

title_like_p = soup.select("p[class^='title']")

print(title_like_p)

```

## 2.3 Beautiful Soup的文本提取技巧

### 2.3.1 获取标签的文本和属性

Beautiful Soup 可以轻松提取标签的文本内容或属性,这对于数据分析、数据抽取等场景非常重要。

```python

# 获取标签的文本

title_text = first_p.get_text()

print(title_text)

# 获取标签的属性

title_class = first_p.get('class')

print(title_class)

# 获取属性的特定值

first_class = first_p['class'][0]

print(first_class)

```

### 2.3.2 处理文本的特殊情况

提取文本时,可能会遇到连续的换行或多余的空格等特殊问题,Beautiful Soup 提供了相应的功能来处理这些问题。

```python

# 移除字符串两端的空白字符

strip_text = first_p.get_text().strip()

print(strip_text)

# 分割字符串为单词列表

words = first_p.get_text().split()

print(words)

```

### 2.3.3 文本内容的清洗与重组

在提取文本后,我们可能需要对文本进行进一步的清洗或重组,以适应分析或展示的需要。

```python

# 清洗文本,例如去除特定的字符或字符串

cleaned_text = title_text.replace('My', '').strip()

print(cleaned_text)

# 重组文本,比如将多个段落合并为一个字符串

combined_text = ' '.join(p.get_text() for p in soup.find_all('p'))

print(combined_text)

```

在这一章节中,我们介绍了 Beautiful Soup 库的安装与配置,以及如何使用 Beautiful Soup 进行元素搜索、文本提取等操作。这些内容为后面章节中将数据抽取技术应用于实际

0

0