【Hive在日志分析中的终极应用】:打造高效日志数据仓库与查询优化

发布时间: 2024-10-26 02:23:34 阅读量: 49 订阅数: 50

基于微信小程序的社区门诊管理系统php.zip

# 1. Hive简介与日志分析基础

## 1.1 Hive的起源和作用

Hive是由Facebook于2008年开源的一个数据仓库工具,它将Hadoop上运行的MapReduce程序转换成SQL语句,从而使得熟悉SQL的用户可以轻松进行数据查询和分析。Hive具有海量数据存储和处理能力,特别适用于数据仓库中进行日志分析、数据挖掘等业务。

## 1.2 日志分析在Hive中的重要性

日志数据是企业中重要的数据资源,它们记录了用户的操作行为和系统运行状况。在Hive中,利用其强大的数据处理能力,可以轻松的对这些日志数据进行清洗、转换、汇总等操作,为数据分析提供支持。了解Hive和日志分析的基础,是数据处理和决策制定的重要前提。

## 1.3 如何开始使用Hive进行日志分析

想要使用Hive进行日志分析,首先需要搭建Hadoop环境,并安装Hive。然后,通过Hive提供的SQL-like语言HiveQL,创建表、执行查询等操作,对存储在HDFS中的日志数据进行分析。具体步骤为:创建Hive表、加载日志数据、编写HiveQL语句进行数据查询,最后分析查询结果。通过以上步骤,就可以利用Hive进行日志分析了。

# 2. Hive架构与日志数据仓库构建

## 2.1 Hive架构概述

### 2.1.1 Hive组件功能介绍

Hive是一个构建在Hadoop之上的数据仓库工具,它允许用户使用类SQL语言(HiveQL)进行数据查询和管理,同时保持了与Hadoop生态系统的兼容性。Hive的核心组件包括:

- **Metastore**: 存储了关于Hive表的元数据信息,比如表结构、数据位置等。它对于Hive来说至关重要,因为它帮助Hive知道数据存放在HDFS的什么位置,以及如何访问它们。

- **Driver**: 接收HiveQL语句,进行词法分析、语法分析,然后生成逻辑执行计划。

- **Compiler**: 将逻辑执行计划转化为一系列的MapReduce、Tez或Spark任务。

- **Execution Engine**: 执行编译后的任务,并将结果返回给用户。

### 2.1.2 Hive与传统数据库的对比

Hive在概念上和传统的关系数据库管理系统(RDBMS)类似,但它是为了在分布式环境中运行而设计的,因此在很多方面都有本质上的不同:

- **查询语言**: Hive使用HiveQL,是一种类SQL的查询语言,不支持传统数据库中的事务控制和行级更新。

- **数据存储**: Hive的数据存储在HDFS上,而传统数据库的数据通常存储在本地文件系统或特定的文件格式中。

- **数据处理**: Hive不支持索引、行级锁定、触发器等复杂的数据管理特性,依赖于MapReduce来处理大规模数据集。

- **性能**: 由于Hive基于MapReduce,其处理速度通常比传统数据库慢,适用于批处理,不适合实时查询。

- **扩展性**: Hive可以扩展到包含成千上万个节点的Hadoop集群,而传统数据库通常受限于单个服务器的资源。

## 2.2 构建高效日志数据仓库

### 2.2.1 数据仓库模型设计

构建高效日志数据仓库的第一步是设计一个合理的数据模型。这通常涉及到以下三个步骤:

1. **确定需求**: 根据业务需求,确定需要收集的数据类型和数据量。

2. **定义维度和度量**: 确定日志数据中的维度和度量标准,以便于后续的数据分析和查询。

3. **设计星型模式或雪花模式**: 根据业务需求,选择适合的数据仓库模型。星型模式适用于简单快速的查询,而雪花模式则提供了更丰富的维度数据结构。

### 2.2.2 日志数据的ETL过程

ETL(提取、转换、加载)是数据仓库构建中的核心步骤,尤其是在处理日志数据时:

- **提取**: 从各种数据源(如Web服务器、应用服务器等)收集日志文件。

- **转换**: 清洗和转换原始日志数据,可能包括去除无效记录、格式化日期时间、转换IP地址等。

- **加载**: 将处理后的数据存储到Hive表中,通常会根据加载的数据类型设置不同的分区和桶。

### 2.2.3 优化Hive表设计和存储

优化Hive表设计可以显著提高查询效率:

- **分区**: 通过按时间、地区或其他相关维度对数据进行分区,可以让Hive查询时只扫描相关的数据子集,减少I/O开销。

- **分桶**: 将数据分布在不同的桶(文件)中,以便Hive可以高效地进行抽样、联接等操作。

- **列式存储**: 使用列式存储格式(如ORC或Parquet),可以有效减少查询所需读取的数据量,提高性能。

## 2.3 Hive中的数据类型与分区

### 2.3.1 理解Hive数据类型

Hive提供了多种数据类型,包括基本类型和复杂类型:

- **基本类型**: 包括INT、BIGINT、FLOAT、DOUBLE、STRING、BOOLEAN等。

- **复杂类型**: 包括ARRAY、MAP、STRUCT、UNION等。

正确地选择数据类型对于存储效率和查询性能都有影响。例如,使用INT代替BIGINT可以减少存储空间和提高处理速度,前提是数据量不会超出BIGINT的范围。

### 2.3.2 分区与分桶技术的应用

分区和分桶是Hive优化数据存储和查询的关键技术:

- **分区**: 通过在Hive表创建时定义分区,可以实现数据的逻辑划分,这在查询时可以显著减少需要扫描的数据量。例如,可以根据日志数据的时间戳创建按天分区的表。

```sql

CREATE TABLE log_data (

log_id INT,

user_id STRING,

log_event STRING

)

PARTITIONED BY (log_date STRING);

```

- **分桶**: 分桶将数据分散到不同的文件中,有助于执行更高效的MapReduce操作,如采样、分组等。通过设置BUCKET数目和列进行分桶,可以实现随机分布。

```sql

CREATE TABLE bucketed_data (

id INT,

name STRING

)

CLUSTERED BY (id) INTO 10 BUCKETS;

```

以上章节内容为第二章的核心,详细介绍了Hive架构的基本知识,如何构建高效的数据仓库,以及Hive中数据类型和分区技术的应用。在实际应用中,根据具体的业务场景进行适当的调整和优化是至关重要的。在后续章节中,我们将更深入地探讨HiveQL的使用、日志数据分析实践、性能调优技巧以及Hive在大数据日志分析中的高级应用。

# 3. Hive查询语言与日志数据分析实践

## 3.1 HiveQL基础

### 3.1.1 HiveQL语句的结构和编写规则

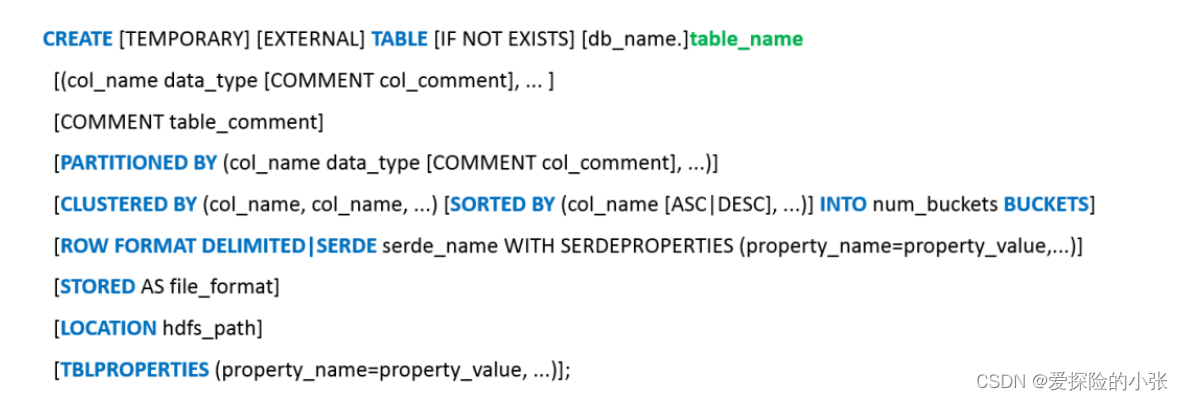

HiveQL(Hive Query Language)是Hive查询语言,它与SQL类似,用于管理和查询Hadoop中的数据。HiveQL语句支持包括数据定义语言(DDL)、数据操作语言(DML)以及数据查询语言(DQL)等。其结构可以分为以下几个部分:

1. **数据定义语言(DDL)**:用于定义数据库结构和操作,例如创建、删除、修改表结构。DDL语句通常以关键字`CREATE`, `DROP`, `ALTER`开始。

2. **数据操作语言(DML)**:用于管理数据,执行数据的增删改操作。Hive DML中的常用命令包括`INSERT`、`UPDATE`、`DELETE`等。

3. **数据查询语言(DQL)**:用于查询数据并从数据库中检索信息。Hive中主要使用`SELECT`语句进行数据查询,与传统SQL查询语句类似。

编写HiveQL时,需要遵守一定的规则:

- **关键字大小写不敏感**:HiveQL中的关键字不区分大小写。

- **分号结尾**:每条HiveQL语句以分号(`;`)结束。

- **注释**:可以通过`--`对单行进行注释,或使用`/* ... */`对多行进行注释。

- **表和列名**:表名和列名在Hive中区分大小写,并且如果标识符包含特殊字符或者关键字,则需要用反引号(`)进行标识。

```sql

-- 创建表语句示例

CREATE TABLE IF NOT EXISTS logs (

id INT,

log_date S

```

0

0