【HiveQL语法速成课】:掌握高效数据查询与操作的秘诀

发布时间: 2024-10-26 01:58:40 阅读量: 36 订阅数: 50

关系型数据库SQL基础教程:语法解析与应用指南

# 1. HiveQL简介与安装配置

HiveQL是Hadoop生态系统中不可或缺的一部分,它是一种类SQL查询语言,用于简化对Hadoop存储数据的查询和分析。在本章节中,我们将概述HiveQL的基本概念,并引导读者完成安装与配置的步骤。

## 1.1 HiveQL概述

HiveQL使得Hadoop上的数据处理更加简便,尤其是对那些熟悉传统SQL的用户。它将SQL语句转换成MapReduce作业运行在Hadoop集群上。通过HiveQL,用户无需掌握复杂的Java编程,就可以进行数据的查询、汇总和分析等操作。

## 1.2 Hive安装与配置步骤

要使用HiveQL,首先需要安装Hive并进行配置。以下是简化的安装步骤:

1. **安装Java环境**:因为Hive运行在Java上,所以首先确保已安装Java开发环境(JDK)。

2. **下载并解压Hive**:从Apache官网下载Hive压缩包并解压到指定目录。

3. **配置环境变量**:设置`HADOOP_HOME`环境变量,并将Hive的bin目录添加到系统的`PATH`环境变量中。

4. **初始化Metastore**:Metastore用于存储Hive的元数据,需要初始化后才能使用。

5. **验证安装**:通过执行`hive`命令进入Hive命令行界面,执行一些基本查询命令来验证安装是否成功。

执行这些步骤后,就可以开始使用HiveQL进行数据探索和分析了。在后续章节中,我们将深入探讨如何利用HiveQL高效地管理和查询数据。

# 2. HiveQL基础语法

## 2.1 数据类型与表定义

### 2.1.1 内置数据类型介绍

Hive支持多种数据类型,这些数据类型可以大致分为两类:原始数据类型和复杂数据类型。原始数据类型主要包含数值类型、日期和时间类型以及字符串类型。复杂数据类型包括数组、映射、结构体和联合体。

HiveQL的数值类型主要有TINYINT、SMALLINT、INT、BIGINT、FLOAT、DOUBLE、DECIMAL、DOUBLE PRECISION、FLOAT、REAL等。日期和时间类型则有TIMESTAMP、DATE、INTERVAL等。字符串类型则有STRING、VARCHAR、CHAR等。

对于非数值类型,Hive也提供了丰富的内置函数进行操作。例如,对于时间类型TIMESTAMP,我们可以使用`unix_timestamp`函数来将其转换成Unix时间戳。

```sql

SELECT unix_timestamp('2022-01-01 12:00:00') FROM table;

```

上述SQL语句用于获取指定日期时间字符串的时间戳值。这条查询语句展示了如何使用HiveQL函数处理日期和时间类型的数据。

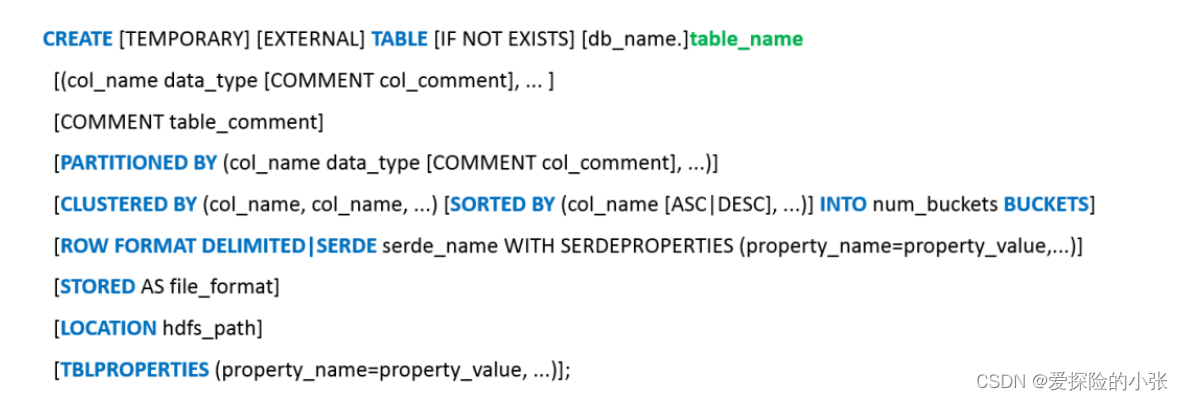

### 2.1.2 创建表与分区表的语法

在Hive中创建表是进行数据存储和查询操作的基础,创建分区表则是Hive优化查询性能的重要手段。分区表能够将数据按照分区键值分隔存储,当查询条件包含分区键时,Hive能够减少需要扫描的数据量,从而提高查询效率。

创建分区表时,需要在创建表的语句中使用PARTITIONED BY语句指定分区键。以下是一个简单的示例:

```sql

CREATE TABLE sales (

year INT,

month INT,

day INT

)

PARTITIONED BY (region STRING)

ROW FORMAT DELIMITED

FIELDS TERMINATED BY ','

STORED AS TEXTFILE;

```

这段代码创建了一个名为sales的表,包含年、月、日三个字段,并以region作为分区字段。分区字段用于后续的查询优化。

### 2.1.3 管理表结构与元数据

管理表结构主要涉及对表进行添加、删除列,更改表属性等操作。Hive提供了ALTER TABLE语句来实现对表结构的管理。例如,添加新列到已有表的操作如下:

```sql

ALTER TABLE sales ADD COLUMNS (amount BIGINT);

```

此代码在sales表中添加了一个新列amount。Hive表的元数据信息存储在Hive Metastore中,可以通过元数据API查询和管理这些信息,比如查看表结构、获取分区信息等。

## 2.2 HiveQL数据查询操作

### 2.2.1 SELECT语句基础

SELECT语句是HiveQL中最基本也是最重要的数据查询语句。基本的SELECT语句包含SELECT和FROM子句,用来从一个或多个表中选择列,并对结果进行展示。

一个简单的查询示例如下:

```sql

SELECT year, month, day, amount

FROM sales

WHERE region = '东部';

```

在这个例子中,我们从sales表中选择了年、月、日和金额四个字段,且过滤了region为'东部'的数据。注意,HiveQL在语法上与传统SQL类似,但是HiveQL在处理大数据时的性能和特性是其主要优势。

### 2.2.2 JOIN、UNION和子查询

HiveQL提供了多种数据查询的方式,包括JOIN、UNION和子查询等。JOIN用于表之间的联合查询,UNION用于合并两个或多个SELECT语句的结果集,并去除重复行。子查询则允许在SELECT、FROM或WHERE子句中嵌套其他查询语句。

一个使用JOIN的例子:

```sql

SELECT s.year, s.month, s.day, p.product_name, s.amount

FROM sales s

JOIN products p ON s.product_id = p.id;

```

在这个JOIN语句中,我们通过product_id将sales表和products表联合在一起,以便能够展示出每个销售记录对应的产品名称和销售金额。这里展示了如何在HiveQL中进行多表查询操作。

### 2.2.3 分组与排序操作

在处理数据分析任务时,经常需要进行数据聚合和排序。HiveQL提供了GROUP BY和ORDER BY子句,用于进行分组聚合和结果排序。

分组聚合的操作示例如下:

```sql

SELECT region, SUM(amount) AS total_sales

FROM sales

GROUP BY region

ORDER BY total_sales DESC;

```

这里,我们计算了每个区域的销售总额,并按总额降序排序。注意,使用聚合函数(如SUM)时通常需要配合GROUP BY语句使用,这样才能对数据进行有效的聚合分析。

## 2.3 HiveQL的复杂查询与函数

### 2.3.1 分布式计算与聚合函数

Hive通过在底层使用Hadoop MapReduce框架提供对大规模数据的分布式计算能力。聚合函数是HiveQL中非常重要的一类函数,用于对一组值执行计算并返回单个值。Hive支持的聚合函数包括COUNT、SUM、AVG、MIN、MAX等。

使用聚合函数进行数据分析的示例如下:

```sql

SELECT region, COUNT(*) AS total_count, AVG(amount) AS avg_amount

FROM sales

GROUP BY region;

```

在这段代码中,我们计算了每个区域的销售记录总数和平均销售额。聚合函数是处理大数据时,进行数据统计和分析的利器,能够快速得到全局或者分组的统计信息。

### 2.3.2 正则表达式与函数应用

正则表达式在处理文本数据时非常有用,HiveQL通过内置的正则表达式函数支持在查询中使用正则表达式,进行模式匹配和文本提取等操作。常用的正则表达式函数包括RLIKE、REGEXP_EXTRACT和REGEXP_REPLACE等。

一个使用正则表达式函数的示例如下:

```sql

SELECT product_name,

REGEXP_EXTRACT(product_name, '^(.*) - [0-9]+') AS base_name

FROM products

WHERE product_name RLIKE '.* - [0-9]+';

```

在这个例子中,我们使用了REGEXP_EXTRACT函数从产品名称中提取基础名称,其中使用了正则表达式匹配产品名称中"-"之前的字符串。这个操作展示了如何在HiveQL中利用正则表达式对数据进行灵活的处理。

### 2.3.3 用户定义函数(UDF)的创建与使用

HiveQL允许用户通过Java编程定义自己的函数,这些函数被称为用户定义函数(UDF)。UDF为Hive查询提供了强大的扩展性,能够执行复杂的数据转换和处理。

创建一个简单的UDF示例需要遵循以下步骤:

1. 编写Java代码实现UDF的逻辑。

2. 编译Java代码为jar包。

3. 在Hive中添加jar包路径,并注册UDF。

以下是一个简单的UDF示例,该UDF的功能是将字符串转换为大写:

```java

import org.apache.hadoop.hive.ql.exec.UDF;

import java.text.SimpleDateFormat;

public class UpperCaseUDF extends UDF {

public String evaluate(final String s) {

return s.toUpperCase();

}

}

```

在Hive中使用UDF的代码如下:

```sql

ADD JAR /path/to/udf.jar;

CREATE TEMPORARY FUNCTION upperudf AS 'your.package.UpperCaseUDF';

SELECT upperudf(column_name) F

```

0

0