【C++并发编程秘籍】:解锁std::mutex互斥锁的9大最佳实践

发布时间: 2024-10-20 11:42:45 阅读量: 80 订阅数: 34

C++11 并发指南之std::mutex详解

# 1. C++并发编程基础与std::mutex简介

在计算机科学中,随着多核处理器的普及,软件并发编程变得愈发重要。C++作为系统编程领域的主要语言,其标准库提供了强大的并发支持,而`std::mutex`是其中最基本的同步原语之一。本章节将带领读者了解C++并发编程的基础知识,以及如何使用`std::mutex`来管理并发执行的线程间共享资源的访问。

## 1.1 C++并发编程概述

C++的并发编程涉及到线程(thread)的创建、管理以及线程间同步(synchronization)和通信(communication)。同步机制防止了多个线程同时访问共享资源导致的数据竞争(race condition)和不一致问题。`std::mutex`就是最常用的一种同步工具,用来保证数据在多线程环境下的安全访问。

## 1.2 std::mutex简介

`std::mutex`是C++标准库中提供的互斥锁类,提供了一种机制来防止多个线程同时访问同一段代码或数据。当一个线程获取了互斥锁后,其他试图获取该锁的线程将被阻塞,直到锁被释放。使用`std::mutex`能够有效地防止竞态条件,保证数据一致性和程序的正确性。

```cpp

#include <mutex>

std::mutex mtx; // 定义一个mutex对象

void sharedResource() {

mtx.lock(); // 上锁

// 临界区代码

mtx.unlock(); // 解锁

}

```

代码块中,`mtx.lock()`与`mtx.unlock()`之间的代码段,被称之为临界区。只有当某一线程进入并执行完临界区代码后,其他线程才能进入临界区。这就保证了任何时候,共享资源的访问都是安全的。这是使用`std::mutex`保护共享资源的最基本模式。

# 2. 深入理解互斥锁std::mutex

## 2.1 互斥锁的工作原理

### 2.1.1 临界区和同步机制

在多线程环境中,为了保护共享资源不被多个线程同时操作而导致数据不一致或竞争条件,临界区的概念应运而生。临界区指的是那些一次只能由一个线程访问的代码区域。为了实现对这些临界区的控制,需要使用同步机制,而互斥锁(mutex)就是其中一种最基本的同步机制。

互斥锁的工作原理基于一个简单的原则:当一个线程访问临界区时,它会尝试"锁定"这个临界区。如果锁已经被其他线程持有,那么当前线程将阻塞,直到锁被释放。当线程完成对临界区的访问后,它会"解锁"这个临界区,使得其他线程有机会访问。通过这种方式,互斥锁确保了任何时候只有一个线程可以操作临界区内的资源。

### 2.1.2 互斥锁在并发中的角色

互斥锁在并发编程中扮演着关键角色。它不仅仅是同步访问共享资源的工具,而且是维护数据完整性和一致性的保障。在复杂的数据结构和业务逻辑中,使用互斥锁可以有效避免诸如数据竞争、死锁和资源饥饿等问题。

互斥锁的引入增加了线程间的协调开销,但相比于没有同步机制而造成的数据错乱,这种开销是必要的。在设计并发程序时,如何平衡性能和正确性是程序员必须考虑的问题。

## 2.2 std::mutex的使用方法

### 2.2.1 std::mutex的基本用法

`std::mutex`是C++标准库提供的互斥锁类。它是不可复制的,只能通过移动语义进行转移。要使用`std::mutex`,程序员可以创建一个`std::mutex`类型的对象,并在访问临界区前后调用`lock()`和`unlock()`方法。然而,直接使用这两个方法并不安全,容易引起忘记解锁导致的死锁或重复解锁的问题。

为了避免这些问题,C++提供了几种RAII风格的互斥锁包装器,如`std::lock_guard`和`std::unique_lock`。通过这些包装器,可以在对象生命周期结束时自动释放锁,从而提高代码的健壮性和安全性。

```cpp

#include <mutex>

#include <iostream>

std::mutex mtx; // 定义一个互斥锁对象

void print_thread_safe(int id) {

mtx.lock(); // 尝试锁定互斥锁

std::cout << "Thread " << id << " is accessing the critical section" << std::endl;

std::cout << "Thread " << id << " is leaving the critical section" << std::endl;

mtx.unlock(); // 解锁

}

int main() {

std::thread t1(print_thread_safe, 1);

std::thread t2(print_thread_safe, 2);

t1.join();

t2.join();

return 0;

}

```

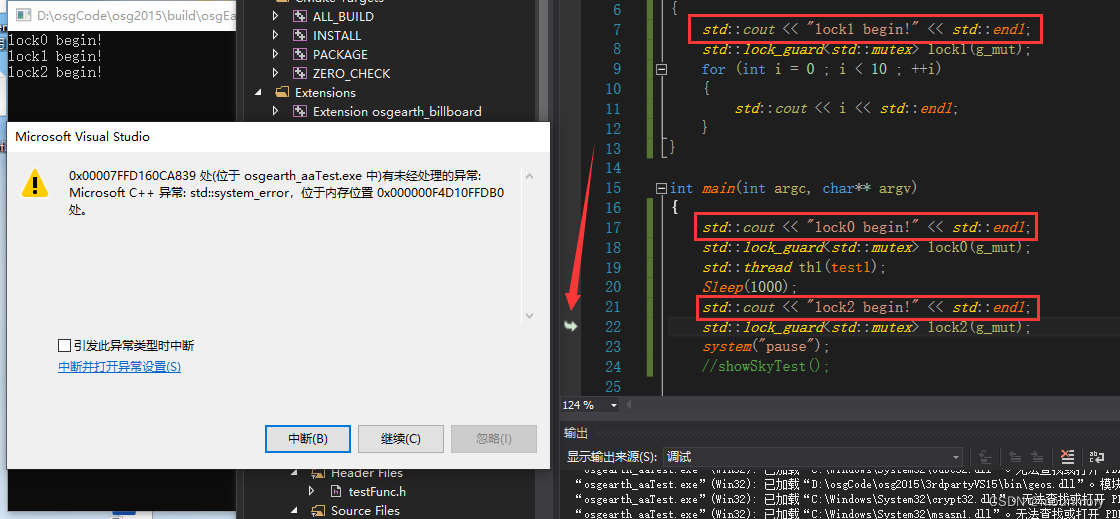

### 2.2.2 死锁及其预防

死锁是指两个或多个线程在执行过程中,因争夺资源而造成的一种僵局。当线程处于相互等待状态,导致永远无法继续执行,这种情况下的程序会停止响应。

预防死锁的一种常见方法是实施锁定顺序。这意味着所有线程必须以相同的顺序获取一组锁。除此之外,避免嵌套锁定、尝试短暂锁定、使用死锁检测工具或允许线程在获取锁时放弃其他资源也是避免死锁的策略。

### 2.2.3 与std::lock_guard的配合使用

`std::lock_guard`是`std::mutex`的RAII包装器,其构造函数会自动调用`lock()`方法锁定互斥锁,并在析构函数中自动调用`unlock()`方法释放互斥锁,从而确保锁定和解锁总是成对出现。此外,`std::lock_guard`对象不可复制,但可移动,这意味着它只在作用域有效期间锁定互斥锁。

```cpp

#include <mutex>

#include <iostream>

std::mutex mtx;

void print_thread_safe(int id) {

std::lock_guard<std::mutex> lock(mtx); // 创建lock_guard对象时锁定互斥锁

std::cout << "Thread " << id << " is accessing the critical section" << std::endl;

std::cout << "Thread " << id << " is leaving the critical section" << std::endl;

// 当lock_guard对象离开作用域时自动释放锁

}

int main() {

std::thread t1(print_thread_safe, 1);

std::thread t2(print_thread_safe, 2);

t1.join();

t2.join();

return 0;

}

```

## 2.3 高级互斥锁技术

### 2.3.1 递归锁std::recursive_mutex

在某些复杂的并发场景中,同一个线程可能需要多次获取同一个锁。标准的`std::mutex`不支持这种情况,多次锁定会导致未定义行为。为了解决这个问题,C++提供了`std::recursive_mutex`,它允许同一个线程多次获取同一个锁。

使用`std::recursive_mutex`时,每次成功锁定都会增加内部的锁定计数,每次解锁则会减少计数,直到计数归零时锁才会被释放供其他线程使用。

### 2.3.2 定时锁std::timed_mutex

标准互斥锁`std::mutex`是无条件的,一旦线程尝试获取锁,它将阻塞直到锁被释放。然而,在某些情况下,如果锁长时间无法获得,程序可能需要执行其他操作。针对这种情况,`std::timed_mutex`提供了两个额外的方法:`try_lock_for`和`try_lock_until`,它们允许线程在超时时间内尝试获取锁,如果未能获取锁则线程可以继续执行其他任务。

```cpp

#include <mutex>

#include <chrono>

#include <iostream>

std::timed_mutex mtx;

void print_thread_safe(int id) {

if (mtx.try_lock_for(std::chrono::milliseconds(100))) {

std::cout << "Thread " << id << " got the lock and is accessing the critical section" << std::endl;

std::cout << "Thread " << id << " is leaving the critical section" << std::endl;

mtx.unlock();

} else {

std::cout << "Thread " << id << " couldn't get the lock in time" << std::endl;

}

}

int main() {

std::thread t1(print_thread_safe, 1);

std::thread t2(print_thread_safe, 2);

t1.join();

t2.join();

return 0;

}

```

在这段代码中,如果线程尝试在100毫秒内获取`std::timed_mutex`锁失败,则输出未获得锁的信息,并继续执行。

通过使用高级互斥锁技术,C++并发编程可以更加灵活,同时也更加强大。理解这些技术对于开发高性能且安全的多线程应用程序至关重要。

# 3. std::mutex的最佳实践案例分析

## 3.1 简单线程同步案例

### 3.1.1 单一资源的线程安全访问

在多线程环境中,保证单一资源的线程安全访问是并发编程中最基础也最关键的任务。std::mutex 作为最常用的同步机制之一,在这里起到了至关重要的作用。它的主要功能是确保在某一时刻只有一个线程能够访问特定的资源,从而避免了竞态条件(race condition)。

```cpp

#include <iostream>

#include <mutex>

#include <thread>

std::mutex mtx; // 定义一个互斥锁对象

int sharedResource = 0; // 定义共享资源

void incrementResource() {

for (int i = 0; i < 1000; ++i) {

mtx.lock(); // 上锁

++sharedResource; // 修改共享资源

mtx.unlock(); // 解锁

}

}

int main() {

std::thread t1(incrementResource);

std::thread t2(incrementResource);

t1.join();

t2.join();

std::cout << "Final value of sharedResource: " << sharedResource << std::endl;

return 0;

}

```

在上面的代码示例中,`incrementResource` 函数试图对共享资源 `sharedResource` 进行1000次增加操作。通过在修改资源前后使用 `lock()` 和 `unlock()` 方法,确保了即使在多线程环境下,每次只有一个线程能够修改 `sharedResource`。这保证了线程安全。

### 3.1.2 多个线程访问多个资源的同步

在多线程编程中,我们经常遇到需要同时访问多个资源的情况。这种情况下,为了避免死锁,必须遵循一定的访问顺序,或者使用更高级的同步机制,比如 std::lock 或者 std::unique_lock。

```cpp

#include <iostream>

#include <mutex>

#include <thread>

#include <vector>

std::mutex mtxA, mtxB;

void accessResources(int threadID) {

int resourceA = threadID * 10;

int resourceB = threadID + 10;

// 确保先锁定resourceA的锁

if (threadID % 2 == 0) {

std::lock(mtxA, mtxB);

std::lock_guard<std::mutex> gA(mtxA, std::adopt_lock);

std::lock_guard<std::mutex> gB(mtxB, std::adopt_lock);

// 模拟对资源的操作

std::cout << "Thread " << threadID << " locked both mutexes\n";

} else {

std::lock(mtxB, mtxA);

std::lock_guard<std::mutex> gB(mtxB, std::adopt_lock);

std::lock_guard<std::mutex> gA(mtxA, std::adopt_lock);

// 模拟对资源的操作

std::cout << "Thread " << threadID << " locked both mutexes\n";

}

// ... 代码执行完毕后,锁会自动释放 ...

}

int main() {

std::vector<std::thread> threads;

for (int i = 0; i < 5; ++i) {

threads.emplace_back(accessResources, i);

}

for (auto& t : threads) {

t.join();

}

return 0;

}

```

在这个例子中,我们定义了两个全局变量 `mtxA` 和 `mtxB` 来表示需要同步访问的两个资源。为了防止死锁,我们使用了 `std::lock` 来同时锁定两个互斥锁,然后使用 `std::lock_guard` 来自动管理锁的生命周期。确保每个线程都能以一种安全的方式访问两个资源,避免了可能的死锁情况。

## 3.2 复杂业务场景下的互斥锁应用

### 3.2.1 分布式系统的互斥锁应用

在分布式系统中,多个进程可能需要访问共享资源,比如数据库、缓存等。在这样的环境中,实现互斥锁可能会变得复杂,因为它需要一种机制来确保跨进程或跨机器的同步。这种情况下,通常需要使用如 Redis 或者 ZooKeeper 这样的分布式协调服务来实现分布式锁。

下面是一个使用 Redis 实现的分布式锁的简单示例:

```cpp

#include <iostream>

#include <redis++/redis++.h>

#include <thread>

redis::client redisClient("***.*.*.*", 6379); // 连接到本地 Redis 服务器

bool acquire_lock(const std::string& lockName, int expiryTime) {

int64_t expires_at = redis::time() + expiryTime;

std::string result = redisClient.set(lockName, "true", "NX", "PX", expiryTime);

if (result == "OK") {

return true;

} else if (result == "QUEUED") {

// 可以重试,获取锁

}

return false;

}

void release_lock(const std::string& lockName) {

redisClient.del(lockName);

}

void critical_section() {

// 执行临界区代码...

std::cout << "Critical section acquired by thread!" << std::endl;

}

int main() {

const std::string lockName = "my_lock";

int expiryTime = 10000; // 锁的过期时间,单位为毫秒

if (acquire_lock(lockName, expiryTime)) {

critical_section(); // 执行需要互斥访问的代码

release_lock(lockName); // 访问完毕,释放锁

} else {

std::cout << "Failed to acquire lock..." << std::endl;

}

return 0;

}

```

这个例子使用 Redis 的 SETNX 和 PX 命令来实现锁的获取和过期。`acquire_lock` 函数尝试设置一个带有过期时间的键,如果成功,则获得锁。`release_lock` 函数则删除该键释放锁。这样的机制可以在不同的进程或机器之间实现互斥。

### 3.2.2 多线程数据库操作的加锁策略

在多线程环境下对数据库进行操作时,正确的加锁策略至关重要。这通常涉及到数据库层面的锁,如行级锁、表级锁、乐观锁和悲观锁等。而 C++ 程序通常使用连接池管理数据库连接,因此加锁策略也必须与连接池的线程安全行为相兼容。

下面是一个简化的例子,展示了如何在 C++ 中使用互斥锁来保证数据库操作的线程安全:

```cpp

#include <iostream>

#include <mutex>

#include <thread>

#include <string>

#include <sqlite3.h>

std::mutex mtx; // 用于同步数据库操作的互斥锁

void databaseOperation(sqlite3* db) {

std::lock_guard<std::mutex> guard(mtx); // 确保每次只有一个线程可以操作数据库

char* errMsg = 0;

const char* sql = "UPDATE my_table SET value = 1 WHERE id = 1";

int rc = sqlite3_exec(db, sql, 0, 0, &errMsg);

if (rc != SQLITE_OK) {

std::cerr << "SQL error: " << errMsg << std::endl;

sqlite3_free(errMsg);

} else {

std::cout << "Operation succeeded" << std::endl;

}

}

int main() {

sqlite3* db;

int rc = sqlite3_open("my_database.db", &db);

if (rc) {

std::cerr << "Can't open database: " << sqlite3_errmsg(db) << std::endl;

return 1;

}

std::thread t1(databaseOperation, db);

std::thread t2(databaseOperation, db);

t1.join();

t2.join();

sqlite3_close(db);

return 0;

}

```

在上述代码中,所有数据库操作都通过一个互斥锁来同步,保证了即使在多线程环境下,对数据库的操作也不会因为并发而产生问题。`std::lock_guard` 被用来自动地管理锁的获取和释放,避免了忘记释放锁的可能。

## 3.3 性能优化策略

### 3.3.1 减少锁的粒度

为了提高并发性能,减少锁的粒度是常用的一种优化策略。通常,我们会尽量减少需要保护的共享资源的大小,或者将资源划分成更小的部分,这样就只有较少的代码和数据需要同步。

```cpp

#include <iostream>

#include <thread>

#include <vector>

#include <mutex>

#include <atomic>

std::vector<std::atomic<int>> counters(1000); // 使用 std::atomic 而非 std::mutex

std::vector<std::thread> threads;

void incrementCounter(int index) {

for (int i = 0; i < 1000; ++i) {

counters[index].fetch_add(1, std::memory_order_relaxed);

}

}

int main() {

for (int i = 0; i < 10; ++i) {

threads.emplace_back(incrementCounter, i);

}

for (auto& t : threads) {

t.join();

}

for (int i = 0; i < 10; ++i) {

std::cout << "Counter " << i << ": " << counters[i].load() << std::endl;

}

return 0;

}

```

在这个例子中,我们没有使用互斥锁而是使用了 `std::atomic` 来保证对共享资源的线程安全。由于 `std::atomic` 的操作通常比 `std::mutex` 的加锁和解锁操作要轻量级,因此当需要保护的数据量不大时,可以考虑使用原子操作替代互斥锁。不过需要注意的是,`std::atomic` 适用于简单的操作,对于更复杂的操作可能还是需要互斥锁。

### 3.3.2 读写锁std::shared_mutex的使用

对于读多写少的场景,使用 std::shared_mutex 可以进一步提升性能。std::shared_mutex 允许多个线程同时读取数据,但写入数据时需要独占访问权。与 std::mutex 相比,它可以提高读取操作的并发性。

```cpp

#include <iostream>

#include <shared_mutex>

#include <thread>

std::shared_mutex rw_mutex;

std::string sharedResource = "Initial value";

void readData() {

std::shared_lock<std::shared_mutex> read_lock(rw_mutex);

std::cout << "Reader thread: " << sharedResource << std::endl;

}

void writeData() {

std::unique_lock<std::shared_mutex> write_lock(rw_mutex);

sharedResource = "Updated value";

std::cout << "Writer thread: " << sharedResource << std::endl;

}

int main() {

std::thread t1(readData);

std::thread t2(readData);

std::thread t3(writeData);

t1.join();

t2.join();

t3.join();

return 0;

}

```

在这个例子中,`readData` 函数用于读取共享资源,它使用 `std::shared_lock` 来允许多个读操作同时进行。`writeData` 函数则使用 `std::unique_lock` 来保证对共享资源的独占访问。std::shared_mutex 允许我们在读操作频繁的场景下获得更好的并发性能。

以上章节内容展示了 std::mutex 在不同场景下的应用和最佳实践。接下来的章节将会继续深入探讨 std::mutex 的高级特性和实践技巧。

# 4. std::mutex的高级特性和实践技巧

在现代C++并发编程中,std::mutex提供的基本互斥机制是不够的。程序员需要在实践中掌握一些高级特性和技巧,以实现高效且安全的同步机制。本章将深入探讨std::mutex的高级特性以及如何在实际编程中应用这些特性。

## 4.1 扩展互斥锁功能

### 4.1.1 自定义锁的实现

在C++中,有时候标准库提供的互斥锁不足以应对复杂的并发场景,这时就需要我们自定义锁来满足特定需求。

自定义锁的实现需要继承自`std::mutex`,并在此基础上提供更高级的锁定机制。例如,我们可能会实现一个可以重入的互斥锁(recursive mutex),或者一个具有更细粒度控制的读写锁(read-write lock)。下面是一个简单的自定义锁的实现示例:

```cpp

#include <mutex>

class CustomMutex : public std::mutex {

public:

void lock_shared() {

std::lock_guard<std::mutex> guard(*this);

while (write_locked) {

// 如果已经有线程在写入,当前线程将在这里等待

condition.wait(guard);

}

read_locked++;

}

void unlock_shared() {

std::lock_guard<std::mutex> guard(*this);

read_locked--;

condition.notify_one();

}

void lock() {

std::lock_guard<std::mutex> guard(*this);

while (read_locked > 0 || write_locked) {

// 如果有其他线程正在读取或写入,当前线程将在这里等待

condition.wait(guard);

}

write_locked = true;

}

void unlock() {

std::lock_guard<std::mutex> guard(*this);

write_locked = false;

condition.notify_all();

}

private:

bool write_locked = false;

bool read_locked = 0;

std::condition_variable condition;

};

```

在这个示例中,我们扩展了`std::mutex`的行为,让它具备基本的读写锁功能。`lock_shared`和`unlock_shared`方法提供给读操作使用,而`lock`和`unlock`方法提供给写操作使用。

### 4.1.2 使用std::unique_lock的灵活性

`std::unique_lock`是一个灵活的互斥锁管理器,它提供了比`std::lock_guard`更加灵活的锁定和解锁策略。

它不仅可以用于管理`std::mutex`,还可以用于管理其他类型的锁,如`std::timed_mutex`和`std::recursive_mutex`。`std::unique_lock`允许延迟锁定,提前解锁,并可以转移所有权。

```cpp

#include <mutex>

#include <thread>

std::mutex mutex;

void task() {

std::unique_lock<std::mutex> lock(mutex, std::defer_lock); // 不立即锁定

// 做一些准备工作...

lock.lock(); // 延迟锁定,在需要时锁定

// 执行需要同步的操作...

lock.unlock(); // 明确地解锁

// 再次做些准备工作...

lock.lock(); // 再次锁定

// 执行需要同步的操作...

lock.unlock(); // 解锁

}

int main() {

std::thread t(task);

t.join();

return 0;

}

```

在这个例子中,`std::unique_lock`的灵活性使得我们可以根据实际需要在代码中控制锁定和解锁的时机。

## 4.2 避免常见并发错误

### 4.2.1 防止优先级反转

优先级反转是一个并发编程中非常棘手的问题。当一个高优先级的线程等待一个低优先级线程持有的资源时,高优先级线程可能会被无限期地阻塞。这种情况通常通过优先级继承协议来解决,在C++中可以使用互斥锁的优先级保护机制。

```cpp

#include <mutex>

#include <thread>

std::mutex mutex;

void task() {

std::lock_guard<std::mutex> lock(mutex);

// 任务执行中...

}

int main() {

std::thread t1([]() {

// 更高优先级线程

task();

});

std::thread t2([]() {

// 更低优先级线程

std::this_thread::sleep_for(std::chrono::milliseconds(100)); // 延迟获得资源

task();

});

t1.join();

t2.join();

return 0;

}

```

在上述代码中,如果低优先级线程获得互斥锁后被高优先级线程抢占,那么操作系统可能会提升低优先级线程的优先级,以减少高优先级线程的等待时间。

### 4.2.2 锁的顺序化使用

在多锁情况下,不一致的锁顺序可能会导致死锁。解决这个问题的一个方法是按照全局一致的顺序来获取锁。

```cpp

#include <mutex>

#include <thread>

std::mutex m1, m2;

void task() {

std::lock(m1, m2); // 使用std::lock同时获取两个锁

std::lock_guard<std::mutex> lock1(m1, std::adopt_lock);

std::lock_guard<std::mutex> lock2(m2, std::adopt_lock);

// 执行需要同步的操作...

}

int main() {

std::thread t1(task);

std::thread t2(task);

t1.join();

t2.join();

return 0;

}

```

这里使用`std::lock`确保两个锁按照固定的顺序被同时获取,从而避免死锁。

## 4.3 高级编程技巧和工具

### 4.3.1 使用C++11/C++17的新特性

C++11以及之后的版本引入了很多并发编程的新特性,例如`std::async`、`std::future`、`std::promise`等。C++17中引入了并行算法,它们可以用来提高代码的并发性能。

```cpp

#include <future>

int calculate(int value) {

// 执行一些耗时的计算...

return value * value;

}

int main() {

std::future<int> result = std::async(std::launch::async, calculate, 10);

// 在这里可以执行其他任务...

std::cout << "Result is " << result.get() << std::endl; // 获取异步操作的结果

return 0;

}

```

### 4.3.2 利用工具检测并发问题

检测并发问题通常比修复它们要容易。现代开发环境提供了很多工具可以帮助检测死锁、数据竞争等问题。

例如,使用Valgrind的Helgrind工具可以检测多线程程序中的数据竞争和死锁。

```bash

# 使用Valgrind检测程序的并发问题

valgrind --tool=helgrind ./my_program

```

在本章中,我们详细介绍了std::mutex的高级特性和实践技巧,包括自定义锁的实现、std::unique_lock的灵活性、避免常见并发错误的策略以及使用C++11/C++17新特性和工具来提升并发编程的效率和安全性。在下一章中,我们将放眼未来,探讨C++并发编程的最新发展及其对跨平台并发编程的影响。

# 5. C++并发编程的未来展望

## 5.1 C++20中的并发更新

### 5.1.1 新的同步原语std::barrier和std::latch

C++20引入了新的同步原语,如`std::barrier`和`std::latch`,它们在多线程程序中用于同步线程的执行。`std::latch`是一次性的同步辅助工具,允许多个线程等待直到指定的计数下降到零。而`std::barrier`更复杂,它允许多个阶段的同步,每个阶段所有线程到达后才能继续执行。

#### 代码示例

```cpp

#include <iostream>

#include <thread>

#include <latch>

std::latch latch(3); // 初始化latch计数为3

void work() {

// 模拟工作

std::this_thread::sleep_for(std::chrono::milliseconds(100));

std::cout << "Thread completed work.\n";

latch.count_down(); // 通知latch计数减一

}

int main() {

std::thread t1(work);

std::thread t2(work);

std::thread t3(work);

latch.wait(); // 等待latch计数到0

std::cout << "All threads have completed their work.\n";

t1.join();

t2.join();

t3.join();

return 0;

}

```

这段代码创建了三个线程,每个线程都有一个`work`函数,该函数执行一些工作并调用`latch.count_down()`。主线程等待所有线程完成工作,然后继续执行。

#### 逻辑分析

`std::latch`用于确保多个线程到达某一执行点后才继续执行主线程。这在并行计算中非常有用,比如,在所有的线程完成初始化数据操作后,主线程才开始处理数据。

### 5.1.2 std::atomic的增强

`std::atomic`提供了对原子操作的支持,它保证了即使在并发环境下,操作也是原子性的。C++20对`std::atomic`进行了增强,引入了更多的原子操作类型和扩展了对用户自定义类型的原子操作支持。

#### 代码示例

```cpp

#include <atomic>

#include <iostream>

std::atomic<int> counter(0);

void increment_counter() {

++counter;

}

int main() {

std::thread t1(increment_counter);

std::thread t2(increment_counter);

t1.join();

t2.join();

std::cout << "Counter value is " << counter << std::endl;

return 0;

}

```

在这个例子中,`counter`是一个原子整型,`++counter`操作确保了即使两个线程同时对其进行加一操作,计数器的最终值也是正确的。

#### 参数说明

`std::atomic`的使用可以有效防止数据竞争,因为它提供了不可分割的读-改-写序列。C++20扩展了对非标准布局类型的原子操作支持,使得更多的类型可以被原子化处理。

## 5.2 跨平台并发编程的挑战与机遇

### 5.2.1 平台间的并发模型差异

不同平台(例如Linux、Windows、macOS)可能会有不同的并发模型和线程库。这些差异带来了挑战,但也为学习不同并发编程方法提供了机遇。

#### 表格

| 平台 | 并发模型 | 线程库 |

| --- | --- | --- |

| Linux | POSIX线程(Pthreads) | N/A |

| Windows | Windows API线程 | Win32线程 |

| macOS | Mach线程 | C++11线程库 |

每个平台使用不同的并发模型和线程库,程序员需要熟悉各个平台上的并发编程。但这种多样性也让开发者可以从不同的并发模型中学习不同的设计理念。

### 5.2.2 C++并发编程在不同平台的实现策略

C++标准库中的并发库提供了一套平台无关的并发编程接口。但为了让这些接口能在不同平台上更好地工作,开发者需要采取不同的实现策略。

#### 流程图

```mermaid

flowchart LR

A[C++ Concurrency Library] -->|Platform Independent| B[Standard Implementation]

A -->|Adaptation| C[Platform Specific Implementation]

B -->|Direct Use| D[Portability]

C -->|Hybrid Use| D

D --> E[Cross-Platform Concurrency]

```

根据上述流程图,开发者可以通过直接使用标准实现来获得可移植性,或者根据特定平台进行适配来实现交叉平台的并发编程。

#### 实践策略

1. **直接使用标准实现**:只要编译器遵循C++标准,并且操作系统提供了足够的支持,直接使用标准实现是非常直接且容易的。

2. **平台特定适配**:在某些情况下,可能需要访问平台特定的API来优化性能或者实现一些标准库中未提供的功能。

3. **混合使用**:为了兼顾可移植性和平台特定的性能优势,可以考虑混合使用标准库和平台特定的实现。

通过选择合适的实现策略,开发者可以在保持代码的可移植性的同时,利用不同平台提供的特定并发机制的优势。这使得C++并发编程不仅限于单一平台,而是能够适应并充分利用各种操作系统资源的潜力。

# 6. 实战演练:构建一个并发安全的C++应用程序

## 6.1 应用程序架构设计

在构建一个并发安全的C++应用程序之前,我们必须首先对应用程序的架构进行细致的设计。这包括确定并发需求和策略,以及设计线程安全的数据结构。

### 6.1.1 确定并发需求和策略

首先,我们需要分析应用程序将执行哪些任务,并确定这些任务在并发环境下是否可以独立运行。并发需求通常涉及对CPU和内存资源的评估,以及对应用程序响应时间和吞吐量的要求。确定并发策略需要考虑以下方面:

- 任务划分:确定哪些任务可以并行执行,哪些任务需要顺序执行。

- 资源管理:识别并管理共享资源,决定对共享资源的访问是通过互斥锁保护还是使用无锁编程技术。

- 线程创建和管理:选择是使用线程池来管理线程还是动态创建和销毁线程。

### 6.1.2 设计线程安全的数据结构

设计线程安全的数据结构是构建并发应用程序的核心部分。我们需要定义数据结构,并确保它们能够安全地在多个线程之间共享。这通常意味着需要同步对这些数据结构的访问。设计线程安全数据结构时应考虑以下几点:

- 锁粒度:合理选择锁的粒度以减少锁竞争,提高并发效率。

- 内存模型:确保内存可见性和操作的顺序性,遵守C++的内存模型规定。

- 数据结构的不变性:维护数据结构的状态,确保不变性条件在并发访问中得到保护。

## 6.2 从理论到实践:编码实践

在理论设计之后,编码实践环节是对并发安全应用程序实现的关键步骤。这包括实现任务的并发执行以及分析和优化程序性能。

### 6.2.1 实现任务的并发执行

为了实现任务的并发执行,我们可以使用C++标准库中的线程和互斥锁。以下是一个简单的示例代码,演示如何使用`std::thread`来并发执行任务:

```cpp

#include <iostream>

#include <thread>

#include <mutex>

#include <vector>

std::mutex mtx; // 全局互斥锁,用于保护共享资源

int sharedResource = 0; // 共享资源

void task(int id) {

for (int i = 0; i < 5; ++i) {

std::lock_guard<std::mutex> lock(mtx); // 自动解锁,简化代码

sharedResource += id; // 修改共享资源

// 其他需要同步的操作...

std::this_thread::sleep_for(std::chrono::milliseconds(100)); // 模拟耗时操作

}

}

int main() {

std::vector<std::thread> threads;

for (int i = 0; i < 10; ++i) {

threads.emplace_back(task, i);

}

for (auto& t : threads) {

t.join(); // 等待所有线程完成

}

std::cout << "Final value of sharedResource: " << sharedResource << std::endl;

return 0;

}

```

### 6.2.2 分析和优化程序性能

在编码实践的最后,我们应该对程序性能进行分析和优化。可以通过以下方法来分析和提升性能:

- 使用性能分析工具(如Valgrind、GDB、Intel VTune等)来识别瓶颈。

- 考虑无锁编程技术或读写锁来减少锁的开销。

- 优化算法和数据结构,减少不必要的数据共享和锁竞争。

- 实现高效的线程调度,避免线程的过度创建和销毁。

通过上述策略和方法,我们可以逐步提高并发程序的效率和稳定性,最终构建出一个既安全又高效的C++应用程序。

0

0