C++并发编程实战:用std::thread打造极致性能多线程应用

发布时间: 2024-10-20 10:13:16 阅读量: 38 订阅数: 28

# 1. C++并发编程基础与std::thread概述

## 1.1 并发编程的重要性与挑战

在现代软件开发中,随着多核处理器的普及,利用并发编程来提升程序性能变得至关重要。并发能够使程序同时执行多个任务,提高CPU利用率,缩短响应时间。但同时,它也引入了复杂性,开发者需要考虑线程管理、同步机制、死锁预防等一系列挑战。

## 1.2 C++并发编程简介

C++11标准引入了对并发编程的全面支持,为开发者提供了丰富的库和工具。其中,`std::thread`是C++并发编程中最为基础的组件之一,它允许程序员创建和管理线程,是实现并发的关键工具。

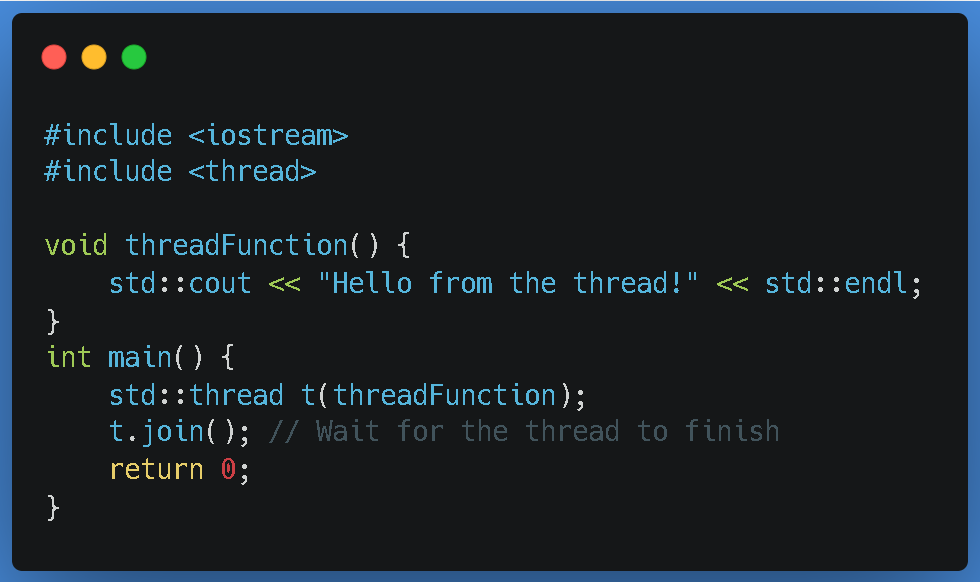

## 1.3 std::thread的基础使用

`std::thread`提供了创建和管理线程的接口。要使用`std::thread`,开发者需要包含头文件`<thread>`,然后创建一个`std::thread`对象,并将线程要执行的函数作为参数传递。例如:

```cpp

#include <thread>

void print_number(int n) {

for (int i = 0; i < n; ++i) {

// 执行线程任务

}

}

int main() {

std::thread t(print_number, 10); // 创建线程并传递参数

t.join(); // 等待线程结束

return 0;

}

```

上述代码创建了一个线程`t`,它执行`print_number`函数,打印10次数字。通过调用`t.join()`,主线程等待`t`结束,保证程序的正确退出。

## 1.4 并发与并行的区别

并发编程并不总是等同于并行处理。并发是关于程序的设计结构,它允许多个任务共享时间片在单核处理器上交错执行,或者在多核处理器上同时执行。并行是并发的一种实现方式,它要求多核处理器同时处理多个任务。理解这一区别对于设计高效的多线程程序至关重要。

通过本章的介绍,我们将建立起对C++并发编程及`std::thread`的初步认识,为后续深入学习奠定基础。

# 2. 深入理解线程管理

## 2.1 线程的创建和销毁

### 2.1.1 构建std::thread实例

创建线程是并发编程中的基本操作之一,C++通过`std::thread`类在标准库中提供了线程支持。要构建一个`std::thread`实例,可以将其与一个可调用对象(如函数指针、lambda表达式或者函数对象)以及一系列参数进行绑定。一旦创建,线程将进入可运行状态,等待操作系统调度执行。

```cpp

#include <thread>

#include <iostream>

void printHello(int count) {

for (int i = 0; i < count; ++i) {

std::cout << "Hello, World!" << std::endl;

}

}

int main() {

std::thread t(printHello, 5); // 创建一个线程实例,将执行printHello函数

t.join(); // 等待线程执行完毕

return 0;

}

```

在上述代码中,我们定义了一个`printHello`函数,它接收一个整数参数`count`,并打印指定次数的"Hello, World!"。在`main`函数中,我们创建了一个`std::thread`实例`t`,并传入`printHello`函数和参数`5`。`t.join()`确保主线程等待子线程`t`完成其工作后再继续执行。

### 2.1.2 线程的启动和结束

线程的启动是指线程开始执行其任务的时刻。在C++中,当`std::thread`对象被构造时,线程启动。线程的结束是当其关联的任务执行完毕时发生的。有两种方式来确保线程的结束:`join()`和`detach()`。

- `join()`:会阻塞当前线程(调用`join()`的线程),直到线程完成其执行。使用`join()`后,`std::thread`对象不再表示一个可加入的线程,它的资源可以被系统回收。

- `detach()`:使`std::thread`对象与线程分离,线程在后台独立于`detach()`调用继续运行。`detach()`后,`std::thread`对象不能再被`join()`。

```cpp

#include <thread>

#include <iostream>

void printNumbers(int count) {

for (int i = 0; i < count; ++i) {

std::cout << i << " ";

}

std::cout << std::endl;

}

int main() {

std::thread t(printNumbers, 10); // 创建并启动线程

t.join(); // 等待线程结束

// 如果使用t.detach(),线程将独立运行,主线程继续执行,没有同步点

return 0;

}

```

在使用`std::thread`时,正确管理线程的生命周期非常重要,因为资源泄露或意外的线程行为都可能导致程序错误。

## 2.2 线程的同步与通信

### 2.2.1 使用互斥量保护共享资源

当多个线程访问共享资源时,需要确保资源访问的互斥性,防止数据竞争和其他并发问题。C++标准库提供了`std::mutex`以及其衍生的几种锁,其中`std::mutex`是最基本的互斥量类型。

```cpp

#include <mutex>

#include <thread>

#include <iostream>

std::mutex mtx;

int sharedResource = 0;

void incrementResource() {

mtx.lock(); // 锁定互斥量

sharedResource++;

mtx.unlock(); // 解锁互斥量

}

int main() {

std::thread t1(incrementResource);

std::thread t2(incrementResource);

t1.join();

t2.join();

std::cout << "Shared Resource Value: " << sharedResource << std::endl;

return 0;

}

```

在上述代码中,我们定义了一个全局的`std::mutex`实例`mtx`和一个全局的共享资源`sharedResource`。创建了两个线程`t1`和`t2`,它们都试图增加`sharedResource`的值。为了保证`sharedResource`的更新是互斥的,我们在`incrementResource`函数中使用`mtx.lock()`和`mtx.unlock()`来确保一次只有一个线程能够进入临界区。

### 2.2.2 条件变量的使用场景和原理

条件变量`std::condition_variable`是用于线程间同步的另一种机制,它允许线程等待直到某个条件为真。条件变量通常与互斥量结合使用,以保证条件检查和线程等待的原子性。

```cpp

#include <iostream>

#include <thread>

#include <mutex>

#include <condition_variable>

std::mutex mtx;

std::condition_variable cond;

bool ready = false;

void printNumbers() {

std::unique_lock<std::mutex> lock(mtx);

while (!ready) {

cond.wait(lock); // 在条件变量上等待

}

for (int i = 0; i < 10; ++i) {

std::cout << i << " ";

}

std::cout << std::endl;

}

int main() {

std::thread producer([&]() {

std::unique_lock<std::mutex> lock(mtx);

ready = true;

cond.notify_one(); // 通知一个等待的线程

});

std::thread consumer(printNumbers);

producer.join();

consumer.join();

return 0;

}

```

在这个例子中,`printNumbers`函数中的线程等待条件变量`cond`,直到`ready`被设置为`true`。`producer`线程通过`cond.notify_one()`通知`printNumbers`线程。条件变量的`wait`方法在调用时会自动释放`lock`,然后再次获取`lock`并返回,这保证了等待期间其他代码可以操作`ready`变量。

### 2.2.3 使用原子操作保持操作的原子性

原子操作是一系列不可分割的操作,即在执行过程中不会被线程调度机制中断的操作。在C++中,`std::atomic`模板类提供了原子操作的工具,其操作保证了线程安全。

```cpp

#include <atomic>

#include <thread>

std::atomic<int> atomicCounter(0);

void incrementCounter(int iterations) {

for (int i = 0; i < iterations; ++i) {

atomicCounter.fetch_add(1, std::memory_order_relaxed);

}

}

int main() {

std::thread t1(incrementCounter, 1000);

std::thread t2(incrementCounter, 1000);

t1.join();

t2.join();

std::cout << "Counter: " << atomicCounter << std::endl;

return 0;

}

```

在这个例子中,我们使用`std::atomic<int>`来定义一个原子计数器`atomicCounter`,并创建了两个线程来增加计数器。使用`fetch_add`方法来原子性地增加计数器的值。通过使用原子操作,我们可以避免在并发环境中对共享资源进行同步,从而避免竞争条件。

## 2.3 线程的异常处理

### 2.3.1 异常传播与捕获机制

线程函数可能抛出异常,这些异常需要在线程的其他部分被适当地捕获和处理。在C++中,线程的异常处理可以通过线程的`join()`方法抛出的异常来实现。如果线程函数抛出异常,异常会被存储在线程对象中,直到被调用`join()`方法的线程捕获。

```cpp

#include <thread>

#include <iostream>

#include <exception>

void throwingFunction() {

throw std::runtime_error("Example exception");

}

int main() {

std::thread t(throwingFunction);

try {

t.join();

} catch (const std::exception& e) {

std::cout << "Exception in thread: " << e.what() << std::endl;

}

return 0;

}

```

在上述代码中,`throwingFunction`抛出了一个异常,然后在线程`t`中运行。当主线程执行`join()`操作时,这个异常被重新抛出,并在`catch`块中被捕获和处理。

### 2.3.2 异常安全的线程函数设计

异常安全意味着即使在发生异常的情况下,程序也能保持一致的状态,资源得到合理释放,不泄露资源。在线程函数中,编写异常安全的代码尤其重要。

```cpp

#include <thread>

#include <mutex>

#include <iostream>

#include <exception>

#include <vector>

std::mutex mtx;

std::vector<int> vec;

void safeFunction() {

std::lock_guard<std::mutex> lock(mtx); // RAII方式自动管理资源

vec.push_back(42);

// 即使这里抛出异常,互斥锁也会在lock_guard的析构函数中释放

}

int main() {

try {

std::thread t(safeFunction);

t.join();

} catch (...) {

std::cerr << "Exception occurred, resource is still safe." << std::endl;

}

return 0;

}

```

在这个例子中,我们使用`std::lock_guard`来确保异常安全。`std::lock_guard`是一个RAII风格的互斥锁,当`lock_guard`对象超出作用域时,它会自动释放已持有的锁。即使`safeFunction`中的`vec.push_back(42)`操作抛出异常,由于`lock_guard`的特性,互斥锁也会在`lock_guard`对象销毁时被释放,从而保持线程安全。

# 3. std::thread的高级特性与应用

## 3.1 线程局部存储

### 3.1.1 使用线程局部存储优化数据隔离

在多线程程序中,线程局部存储(Thread Local Storage, TLS)是一种允许我们为每个线程提供独立存储空间的技术。这对于优化数据隔离非常有用,可以避免不必要的同步操作,因为每个线程都将拥有其专用的变量副本。

让我们看看如何在C++中使用TLS。我们通过`thread_local`关键字来声明一个线程局部存储变量:

```cpp

#include <iostream>

#include <thread>

thread_local int tlsVar = 0;

void threadFunction() {

++tlsVar;

std::cout << "Value of tlsVar in thread: " << tlsVar << std::endl;

}

int main() {

std::thread t1(threadFunction);

std::thread t2(threadFunction);

t1.join();

t2.join();

return 0;

}

```

在上述代码中,我们为每个线程定义了一个`tlsVar`变量。当我们在两个不同的线程中递增这个变量时,每个线程的`tlsVar`值都是独立的。TLS确保了线程间的变量不会互相干扰,这是线程安全的一个重要方面。

### 3.1.2 线程局部存储的内存管理

TLS的内存管理是自动的。在程序开始时为每个线程的TLS变量分配空间,在线程结束时释放这个空间。这个过程是透明的,开发者通常不需要担心内存的分配和释放问题。但是,为了确保资源的正确释放,我们需要确保TLS变量生命周期的管理。

在C++中,TLS变量的生命周期通常等同于线程的生命周期。当线程结束时,任何线程局部存储的变量都会被销毁。但如果TLS对象需要进行特殊资源管理,例如动态分配的内存,则必须确保适当的析构函数调用,可能需要手动管理这些资源的释放。

## 3.2 线程组和并发算法

### 3.2.1 std::thread_group的使用和限制

虽然C++11标准库没有提供`std::thread_group`这一类,但在一些第三方实现(比如Boost库)中可以找到它的身影。`std::thread_group`允许你创建和管理一组线程,这对于简化线程的管理非常有用,尤其是当你需要大量线程时。

虽然`std::thread_group`并不是官方C++标准的一部分,我们还是可以尝试理解它的基本使用方法。这里是一个使用Boost库的`boost::thread_group`的例子:

```cpp

#include <boost/thread.hpp>

#include <boost/thread/thread_group.hpp>

int main() {

boost::thread_group tg;

for (int i = 0; i < 10; ++i) {

tg.create_thread([]() {

std::cout << "Thread from thread group" << std::endl;

});

}

tg.join_all(); // 等待所有线程完成

return 0;

}

```

需要注意的是,`std::thread_group`并不是C++标准的一部分,而且由于C++11引入了`std::async`,在很多情况下,我们可以使用更加现代的并行工具来替代传统的线程组。

### 3.2.2 C++17中的并行算法概述

C++17引入了一系列并行算法,它们在`<algorithm>`和`<numeric>`中,并通过命名空间`std::execution`进行访问。这些算法利用了执行策略(例如`std::execution::par`或`std::execution::par_unseq`),以便在支持并行处理的环境中执行。

这些算法不仅提高了代码的可读性,而且还能提高程序的性能。下面是一个使用并行算法的简单例子:

```cpp

#include <iostream>

#include <vector>

#include <numeric>

#include <execution>

int main() {

std::vector<int> numbers(1000000);

std::iota(numbers.begin(), numbers.end(), 1); // 填充数据

int sum = std::reduce(std::execution::par, numbers.begin(), numbers.end());

std::cout << "Sum of numbers is: " << sum << std::endl;

return 0;

}

```

在上述代码中,`std::reduce`算法在并行模式下对一个整数向量求和。使用`std::execution::par`执行策略指定了并行处理。

## 3.3 线程的优先级和亲和性

### 3.3.1 设置线程优先级和CPU亲和性

在多线程应用中,有时需要对线程进行优先级调整或者指定线程运行的CPU核心。这有助于满足对性能和资源使用要求严格的场景。

在C++中,可以使用操作系统提供的API来设置线程优先级和亲和性。比如,在POSIX兼容的操作系统(例如Linux或macOS)中,可以使用`pthread_setschedparam`函数来设置线程优先级:

```cpp

#include <pthread.h>

#include <iostream>

void* threadFunction(void*) {

// 线程执行的内容

return nullptr;

}

int main() {

pthread_t thread;

sched_param param;

// 创建线程

pthread_create(&thread, nullptr, threadFunction, nullptr);

// 设置优先级

param.sched_priority = 1;

pthread_setschedparam(thread, SCHED_FIFO, ¶m);

// ...线程操作

pthread_join(thread, nullptr);

return 0;

}

```

在Windows平台上,可以使用`SetThreadPriority`函数来设置线程优先级。

### 3.3.2 线程调度的影响因素

线程调度是由操作系统的调度器来管理的。调度器会考虑多个因素来决定哪个线程应该运行在哪个CPU核心上,这包括线程优先级、亲和性设置、运行时间以及线程的状态等。

线程优先级和CPU亲和性的设置,会直接影响到线程调度的决策。较高的优先级可以使得线程更容易抢占CPU资源,而CPU亲和性则允许系统将线程保持在一个或一组特定的CPU核心上运行,减少上下文切换,提高性能。

要注意的是,过度使用高优先级和固定的CPU亲和性设置可能会导致其他线程饿死,进而影响整个系统的稳定性。因此,这些高级特性应当谨慎使用,最好是在性能测试后根据实际需要进行调整。

# 4. C++并发编程模式与实践

## 4.1 生产者-消费者模式

生产者-消费者模式是一种广泛应用于多线程编程中的同步模式,用于管理由一个或多个生产者线程产生的数据,并由一个或多个消费者线程消费这些数据。该模式的核心目的是解决生产者和消费者之间的速度不匹配问题,使得生产者不会因为消费者跟不上而阻塞,消费者也不会因为没有数据可消费而空转。

### 4.1.1 使用队列和条件变量实现模式

在C++中,可以利用`std::queue`作为存储数据的容器,结合`std::mutex`和`std::condition_variable`来实现生产者-消费者模式。以下是一个简化的示例代码:

```cpp

#include <iostream>

#include <queue>

#include <mutex>

#include <condition_variable>

std::queue<int> queue;

std::mutex queue_mutex;

std::condition_variable queue_cond;

void producer(int value) {

std::unique_lock<std::mutex> lock(queue_mutex);

queue.push(value);

lock.unlock();

queue_cond.notify_one();

}

int consumer() {

std::unique_lock<std::mutex> lock(queue_mutex);

queue_cond.wait(lock, []{ return !queue.empty(); });

int value = queue.front();

queue.pop();

return value;

}

int main() {

int product;

std::thread producer_thread(producer, 1);

std::thread consumer_thread(consumer);

consumer_thread.join();

producer_thread.join();

}

```

在这个例子中,`producer`函数将一个值推入队列,并通知一个等待的消费者。`consumer`函数等待一个非空队列的条件,取得并消费队列中的值。队列的访问是通过`std::mutex`同步的,确保了线程安全。

### 4.1.2 模式在异步处理中的应用

生产者-消费者模式在异步处理中非常有用,特别是在I/O密集型任务和数据处理任务中。通过使用`std::async`和`std::future`,可以实现非阻塞的异步处理。生产者只需创建一个异步任务并将数据传递给消费者,消费者通过`std::future`获得异步任务的结果。

```cpp

#include <future>

#include <iostream>

std::future<int> producer() {

return std::async(std::launch::async, [](){

return calculate_value(); // calculate_value() 是计算任务的函数

});

}

void consumer(std::future<int>& fut) {

int value = fut.get(); // 获取结果

process(value); // 处理结果

}

int main() {

std::future<int> prod_fut = producer();

consumer(prod_fut);

}

```

在这个例子中,`producer`函数通过异步调用`calculate_value()`函数生成一个异步任务,并返回一个`std::future`对象给消费者。消费者通过`get`函数等待并获取异步任务的结果。这样,生产者不会因为消费者处理速度慢而阻塞,消费者也不会因为没有数据而空转,实现了高效的异步处理。

## 4.2 读写锁模式

### 4.2.1 std::shared_mutex的使用与原理

`std::shared_mutex`是C++17中引入的读写锁,允许多个线程同时读取共享数据,但写入时需要独占访问。这是通过允许多个读取者共享访问,而写入者则需要等待所有读取者完成才能获取锁,从而避免了写饥饿的情况。

使用`std::shared_mutex`的示例代码如下:

```cpp

#include <shared_mutex>

#include <vector>

#include <thread>

#include <iostream>

std::vector<int> shared_data;

std::shared_mutex data_mutex;

void read_data() {

while(true) {

std::shared_lock<std::shared_mutex> read_lock(data_mutex);

// 对shared_data进行读取操作

std::cout << "Reading..." << std::endl;

std::this_thread::sleep_for(std::chrono::milliseconds(10));

}

}

void write_data() {

while(true) {

std::unique_lock<std::shared_mutex> write_lock(data_mutex);

// 对shared_data进行写入操作

std::cout << "Writing..." << std::endl;

std::this_thread::sleep_for(std::chrono::milliseconds(10));

}

}

int main() {

std::thread reader(read_data);

std::thread writer(write_data);

reader.join();

writer.join();

}

```

在这个例子中,多个`read_data`线程可以同时读取`shared_data`,而`write_data`线程在写入时需要等待所有读取者完成。这样可以提高多线程对共享数据的并发访问效率。

### 4.2.2 高性能读写锁的实现

高性能读写锁的关键在于减少锁的争用和等待时间,以及支持读取者和写入者之间的优先级。实现高性能读写锁的一种方式是引入更多的状态和更复杂的控制逻辑来平衡读者和写者的访问。例如,可以实现一个自定义的读写锁类,采用两级锁机制(reader/writer lock):

```cpp

class CustomRWLock {

public:

void lock_shared() {

std::unique_lock<std::mutex> lock(mtx);

while (write_active || write_pending)

read_cond.wait(lock);

++num_readers;

}

void unlock_shared() {

std::unique_lock<std::mutex> lock(mtx);

--num_readers;

if (num_readers == 0)

write_cond.notify_one();

}

void lock() {

std::unique_lock<std::mutex> lock(mtx);

write_pending = true;

while (num_readers != 0)

write_cond.wait(lock);

write_active = true;

}

void unlock() {

std::unique_lock<std::mutex> lock(mtx);

write_active = false;

write_pending = false;

read_cond.notify_all();

write_cond.notify_one();

}

private:

std::mutex mtx;

std::condition_variable read_cond;

std::condition_variable write_cond;

bool write_pending = false;

bool write_active = false;

int num_readers = 0;

};

```

上述`CustomRWLock`类通过`std::mutex`和`std::condition_variable`实现了自定义的读写锁。该实现通过维护活跃写入者标志`write_active`、等待写入者标志`write_pending`以及读取者数量`num_readers`来控制锁的获取和释放。这种方式可以减少不必要的等待,提高读写操作的性能。

## 4.3 工作窃取模式

### 4.3.1 工作窃取算法介绍

工作窃取模式是一种在多线程任务调度中常见的模式,它允许线程在处理完自己的任务后,从其他线程的任务队列中窃取未完成的任务。这种方式提高了资源的利用率,特别是在任务执行时间不确定或者线程执行速度不一的情况下。

工作窃取算法的核心思想是,当一个线程(窃取者)的队列为空时,它随机选择另一个线程的队列,尝试从队尾窃取一个任务。如果这个队列也是空的,窃取者会继续寻找其他线程的队列进行窃取。以下是一个简单的模拟工作窃取的示例代码:

```cpp

#include <iostream>

#include <thread>

#include <vector>

#include <atomic>

std::vector<std::atomic<bool>> task_lists;

std::atomic<bool> tasks_exist(true);

void worker(int id) {

while (tasks_exist) {

int idx = (id + rand() % task_lists.size()) % task_lists.size();

if (task_lists[idx].exchange(false)) {

// 执行任务

std::cout << "Worker " << id << " is executing a task." << std::endl;

} else if (std::all_of(task_lists.begin(), task_lists.end(), [](std::atomic<bool> &flag) { return !flag; })) {

tasks_exist = false;

} else {

// 空闲时,尝试窃取其他线程的任务

// ...

}

}

}

int main() {

const int num_tasks = 20;

const int num_workers = 4;

task_lists = std::vector<std::atomic<bool>>(num_workers, true);

std::vector<std::thread> workers;

for (int i = 0; i < num_workers; ++i) {

workers.emplace_back(worker, i);

}

// 随机产生任务并分配到工作线程的任务队列中

for (int i = 0; i < num_tasks; ++i) {

task_lists[rand() % num_workers].store(true);

}

// 等待所有线程完成

for (auto& worker_thread : workers) {

worker_thread.join();

}

}

```

在这个例子中,每个线程维护了一个任务队列,并在队列为空时尝试从其他线程窃取任务。随机选择和窃取机制使得工作负载在各个线程之间动态平衡。

### 4.3.2 使用std::thread实现工作窃取模式

为了使用`std::thread`实现更规范的工作窃取模式,可以创建一个任务队列类,为每个线程绑定一个任务队列。然后,线程在工作完成后,会尝试从其他线程的任务队列中窃取任务。这里展示一个简化的示例:

```cpp

#include <thread>

#include <mutex>

#include <condition_variable>

#include <queue>

#include <functional>

template<typename T>

class ThreadTaskQueue {

public:

void push(T task) {

std::unique_lock<std::mutex> lock(queue_mutex);

tasks.push(task);

condition.notify_one();

}

std::function<void()> steal_task() {

std::unique_lock<std::mutex> lock(queue_mutex);

if (!tasks.empty()) {

auto task = tasks.front();

tasks.pop();

return task;

}

return nullptr;

}

private:

std::queue<std::function<void()>> tasks;

std::mutex queue_mutex;

std::condition_variable condition;

};

void worker(ThreadTaskQueue<std::function<void()>>& queue, int id) {

while (true) {

auto task = queue.steal_task();

if (task) {

task();

} else {

// 没有任务可做,可以窃取或者结束线程

break;

}

}

}

int main() {

ThreadTaskQueue<std::function<void()>> queue;

std::vector<std::thread> threads;

// 添加一些任务到队列中

for (int i = 0; i < 10; ++i) {

queue.push([i] { std::cout << "Task " << i << " executed by main thread." << std::endl; });

}

// 创建多个工作线程

for (int i = 0; i < 4; ++i) {

threads.emplace_back(worker, std::ref(queue), i);

}

// 等待所有线程完成任务

for (auto& thread : threads) {

thread.join();

}

}

```

在这个例子中,`ThreadTaskQueue`类管理任务队列,允许工作线程窃取任务。每个工作线程尝试从队列中取出一个任务并执行,如果队列为空,则尝试窃取其他队列的任务,否则线程结束。这实现了工作窃取模式的基本逻辑。

以上就是本章节的内容,包含了生产者-消费者模式、读写锁模式和工作窃取模式在C++中的实现和应用,通过具体的代码示例和解释,展示了如何将这些并发编程模式运用到实际的多线程程序中。

# 5. 多线程程序的性能调优

在多线程程序的开发过程中,性能调优是一个非常关键的环节。有效的性能调优可以显著提高程序的运行效率,降低资源消耗,提升用户体验。本章将详细介绍性能分析工具与方法,并探讨针对多线程程序的优化策略与最佳实践。

## 5.1 性能分析工具与方法

为了有效地优化多线程程序的性能,首先需要了解和掌握性能分析的工具与方法。这些工具可以帮助开发者发现程序的性能瓶颈,从而有针对性地进行优化。

### 5.1.1 使用gdb和Valgrind诊断多线程问题

`gdb`(GNU Debugger)和`Valgrind`是常用的调试和性能分析工具。`gdb`提供了丰富的调试功能,可以用来跟踪程序的执行流程,设置断点以及查看线程状态等。`Valgrind`则是一个强大的内存调试工具,它不仅能检测内存泄漏,还能帮助开发者找出多线程程序中的数据竞争等问题。

#### 示例代码

```c++

#include <iostream>

#include <thread>

#include <vector>

#include <mutex>

std::vector<int> shared_data;

std::mutex data_mutex;

void add_data(int value) {

for (int i = 0; i < 100000; ++i) {

std::lock_guard<std::mutex> lock(data_mutex);

shared_data.push_back(value);

}

}

int main() {

std::vector<std::thread> threads;

for (int i = 0; i < 10; ++i) {

threads.emplace_back(add_data, i);

}

for (auto& t : threads) {

t.join();

}

return 0;

}

```

#### 使用gdb调试

gdb调试多线程程序时,可以使用以下命令:

- `info threads`:列出所有线程。

- `thread <id>`:切换到指定ID的线程。

- `bt`:查看当前线程的调用栈。

使用gdb调试上述程序时,可以检查共享数据是否被多个线程正确地添加数据,没有出现数据竞争现象。

#### 使用Valgrind检测

使用Valgrind检测程序的命令如下:

```bash

valgrind --tool=helgrind ./your_program

```

`helgrind`是Valgrind中的一个工具,它可以检测程序中的多线程竞争条件和死锁问题。

### 5.1.2 性能瓶颈的识别与分析

在多线程程序中,性能瓶颈的识别与分析是性能调优的基础。常见的性能瓶颈可能来自以下几个方面:

- I/O操作:网络I/O或磁盘I/O往往是性能瓶颈的源头之一。

- 数据竞争:当多个线程访问同一资源且至少有一个是写操作时,就可能发生数据竞争。

- 死锁:多个线程相互等待对方持有的资源,导致程序僵死。

- 不合理的线程同步机制:例如过度使用互斥量可能导致线程频繁阻塞,降低程序效率。

#### 性能分析工具应用示例

在确认程序存在性能瓶颈后,可以使用下面的工具进一步分析:

- `perf`:Linux下用于性能分析的工具,可以用来分析程序的CPU使用情况、函数调用频率等。

- `pstack`:查看进程的调用栈信息。

- `htop`:一个比`top`更加友好的进程查看工具,可以更直观地看到线程信息。

通过上述工具,我们可以收集到程序运行时的详细信息,帮助我们找到性能瓶颈的具体位置。

## 5.2 优化策略与最佳实践

在识别出性能瓶颈后,可以采取一系列优化策略来提升多线程程序的性能。

### 5.2.1 优化数据竞争和死锁问题

针对数据竞争问题,最直接的解决方案是使用互斥量或其他同步机制来保护共享资源。然而,过度使用互斥量会导致线程频繁阻塞和唤醒,影响程序性能。这时可以考虑使用无锁编程技术,如原子操作,来替代互斥量。

#### 代码示例

```c++

#include <atomic>

std::atomic<int> shared_counter = {0};

void increment_counter() {

for (int i = 0; i < 100000; ++i) {

shared_counter.fetch_add(1, std::memory_order_relaxed);

}

}

int main() {

std::thread t1(increment_counter);

std::thread t2(increment_counter);

t1.join();

t2.join();

std::cout << "Counter: " << shared_counter << std::endl;

return 0;

}

```

在上面的代码中,我们使用了`std::atomic`来保护一个全局的计数器变量,以避免数据竞争。原子操作保证了操作的原子性,并且由于`fetch_add`操作是无锁的,因此可以减少线程间的竞争。

### 5.2.2 缓存优化与内存访问模式调整

缓存优化是性能提升的关键,尤其是在多核CPU上。当多个线程频繁访问同一块内存区域时,可以考虑使用缓存行填充(padding)技术来减少缓存行争用。此外,内存访问模式的调整,比如保证数据的局部性,可以显著提高缓存的命中率。

#### 缓存行填充示例

```c++

struct alignas(64) CacheLinePad {

char padding_[64];

int data;

};

CacheLinePad cache_lines[1024];

```

在上面的代码中,我们定义了一个结构体`CacheLinePad`,并使用`alignas`关键字保证了内存对齐。通过将数据填充到64字节的缓存行大小,我们可以保证不同的`CacheLinePad`实例不会共享同一个缓存行,从而减少缓存行争用的可能性。

通过优化策略的实施,我们可以显著提高多线程程序的性能。然而,需要注意的是,优化工作需要针对具体的程序和性能瓶颈进行,没有通用的“银弹”解决方案。开发者应结合实际情况,通过测试和分析,找到最合适的优化策略。

# 6. 案例分析:构建高性能多线程应用

## 6.1 实际项目中的并发需求分析

### 6.1.1 确定并发执行的粒度

在设计高性能多线程应用时,合理确定并发执行的粒度是至关重要的。粒度太粗,可能会导致资源利用不足,影响性能;粒度太细,则可能导致线程调度开销过大,同样影响性能。

- **任务级别**:是将整个任务作为一个独立的线程执行,还是将任务进一步细分为多个子任务,每个子任务由一个线程处理。

- **数据级别**:是将数据集作为一个整体处理,还是将数据集分割为小块,每个线程处理一部分数据。

- **函数级别**:是将函数调用作为并发的单位,还是将函数内部的某些计算密集型代码段作为并发的单位。

在具体实践中,可能需要根据应用的特点和需求,进行测试和调整,以确定最佳的并发粒度。

```cpp

// 一个简单的示例:定义一个函数,用于计算数据集的平方和,使用并发进行优化

#include <thread>

#include <vector>

#include <algorithm>

#include <numeric>

// 函数:计算平方和

void calculate_square_sum(std::vector<int>& data, size_t start, size_t end, long long& result) {

long long local_sum = std::accumulate(data.begin() + start, data.begin() + end, 0LL, [](long long a, int b) {

return a + b * b;

});

result += local_sum;

}

// 使用多线程计算整个数据集的平方和

long long calculate_parallel_square_sum(std::vector<int>& data) {

const size_t num_threads = std::thread::hardware_concurrency();

std::vector<std::thread> threads;

long long result = 0LL;

size_t chunk_size = data.size() / num_threads;

for (size_t i = 0; i < num_threads; ++i) {

size_t start = i * chunk_size;

size_t end = (i == num_threads - 1) ? data.size() : (i + 1) * chunk_size;

threads.emplace_back(calculate_square_sum, std::ref(data), start, end, std::ref(result));

}

// 等待所有线程完成

for (auto& t : threads) {

t.join();

}

return result;

}

```

### 6.1.2 选择合适的并发模型

并发模型是多线程应用的骨架,选择合适的并发模型对程序的性能和可维护性有决定性影响。常用的并发模型有:

- **基于线程的模型**:直接使用 `std::thread` 等线程库提供的接口创建和管理线程。

- **任务并行库(TPL)**:如 `std::async` 和 `std::future`,允许以更高级别的抽象来编写并行代码。

- **协程模型**:例如C++20中引入的协程,提供了更轻量级的并发执行单元。

下面是一个使用 `std::async` 实现的并发模型示例:

```cpp

#include <future>

#include <vector>

#include <numeric>

// 使用std::async并发计算平方和

long long calculate_async_square_sum(std::vector<int>& data) {

std::vector<std::future<long long>> futures;

const size_t num_threads = std::thread::hardware_concurrency();

size_t chunk_size = data.size() / num_threads;

for (size_t i = 0; i < num_threads; ++i) {

size_t start = i * chunk_size;

size_t end = (i == num_threads - 1) ? data.size() : (i + 1) * chunk_size;

futures.emplace_back(std::async(std::launch::async, calculate_square_sum, std::ref(data), start, end));

}

long long result = 0LL;

for (auto& future : futures) {

result += future.get();

}

return result;

}

```

## 6.2 构建示例项目:多线程搜索引擎

### 6.2.1 设计多线程爬虫架构

多线程爬虫架构应考虑到网络请求的并发执行,以及网页内容的异步下载和解析。下面是一个简单的多线程爬虫设计思路:

- **任务调度器**:负责分配和管理抓取任务,每个任务由一个独立的线程执行。

- **下载器**:并发执行多个网络请求,下载网页内容。

- **解析器**:对下载的网页内容进行解析,提取出新的URL添加到任务队列中。

### 6.2.2 实现多线程索引与搜索功能

为了实现高效的多线程索引和搜索,可以采用以下策略:

- **分词与索引**:使用多个线程对文档进行分词,然后并行构建索引数据结构。

- **搜索优化**:利用多线程并行处理搜索请求,提高响应速度。

下面是一个简单的索引功能实现示例:

```cpp

#include <thread>

#include <mutex>

#include <unordered_map>

#include <vector>

#include <string>

#include <sstream>

// 假设文档是一个字符串

struct Document {

int id;

std::string content;

};

// 假设索引是一个文档ID到关键词的映射

std::unordered_map<std::string, std::vector<int>> index;

// 分词函数,用于提取关键词

std::vector<std::string> tokenize(const std::string& text) {

// 假设这是分词实现,返回分词结果

return {/*...*/};

}

// 线程安全的索引更新函数

void update_index_for_document(const Document& doc) {

std::vector<std::string> tokens = tokenize(doc.content);

std::lock_guard<std::mutex> lock(index_mutex); // 使用互斥量保护共享资源

for (const auto& token : tokens) {

index[token].push_back(doc.id);

}

}

// 构建索引的函数

void build_index(const std::vector<Document>& documents) {

std::vector<std::thread> threads;

for (const auto& doc : documents) {

threads.emplace_back(update_index_for_document, doc);

}

// 等待所有线程完成

for (auto& t : threads) {

t.join();

}

}

```

在这个示例中,我们创建了一个线程安全的索引更新函数,并发地为每个文档创建线程,最后等待所有线程完成索引构建。实际应用中,搜索算法和索引的数据结构可能会更加复杂,但基本思路是类似的。

0

0