【边缘计算深度探索】:NVIDIA Orin与边缘AI的完美融合

发布时间: 2024-12-15 07:10:23 阅读量: 41 订阅数: 28

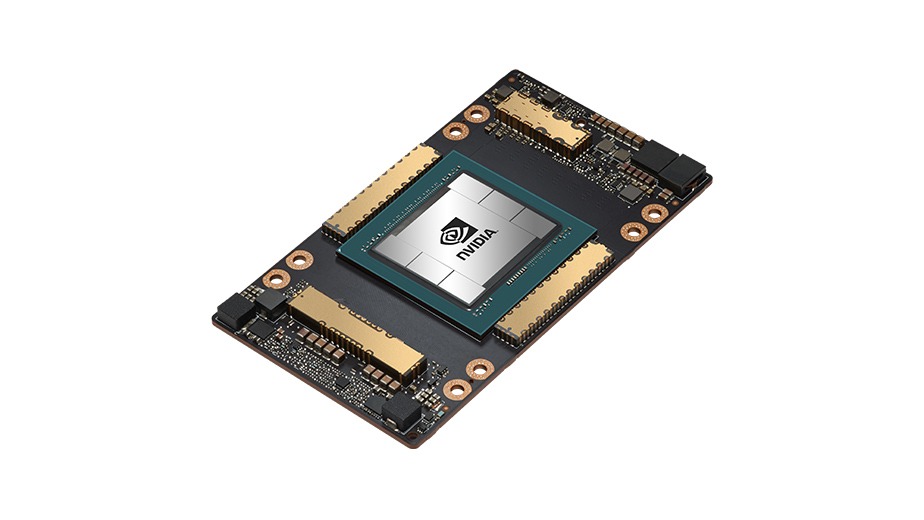

NVIDIA-英伟达-jetson orin 模块设计指南

参考资源链接:[英伟达Jetson AGX Orin系列手册与性能详解](https://wenku.csdn.net/doc/2sn46a60ug?spm=1055.2635.3001.10343)

# 1. 边缘计算的基础理论与技术背景

边缘计算是一种分布式计算架构,它将数据的处理、分析和存储更靠近数据生成的源头,即网络的边缘。这种架构的关键优势在于减少延迟、节省带宽并提高整体网络效率。本章将概述边缘计算的基础理论,包括其定义、起源、以及核心技术,如数据流管理、实时分析等。我们将讨论边缘计算如何从云计算中分离出来,并分析其与物联网(IoT)和5G网络的紧密联系。通过深入理解这些基础知识,我们将为探索NVIDIA Orin平台和边缘AI应用案例奠定坚实基础。

# 2. NVIDIA Orin平台解析

## 2.1 NVIDIA Orin的硬件架构

### 2.1.1 CPU与GPU协同工作原理

NVIDIA Orin作为一款面向边缘计算和自动驾驶领域的高性能计算平台,其硬件架构是多核异构计算的集大成者。它将ARM CPU与NVIDIA GPU协同工作,形成了一个强大的AI超级计算引擎。CPU负责逻辑运算和控制任务,而GPU则专长于并行数据处理,这在图形渲染、科学计算以及深度学习模型的推理和训练中尤为重要。

在这样的架构下,Orin平台可以将复杂的工作负载智能分配给不同的处理器。例如,在自动驾驶场景中,CPU可以处理传统的控制逻辑和车载信息娱乐系统,而GPU则用于处理视频流的实时分析,包括行人检测、车道识别等复杂的视觉处理任务。Tensor Cores作为GPU中的特殊单元,可以加速矩阵运算,这对于执行深度学习中的卷积神经网络(CNN)等算法至关重要。

此外,Orin平台支持CUDA、OpenCL等编程模型,开发者可以使用这些模型将算法并行化,充分发挥GPU的并行处理能力。在硬件层面,Orin还支持多级缓存架构和高速互连技术,保证了数据在不同处理单元间高效流转。

### 2.1.2 特色技术—Tensor Cores与AI性能

NVIDIA的Tensor Cores是其GPU架构中的创新技术,专门针对AI计算进行了优化。Tensor Cores能够高效执行混合精度运算,也就是同时使用16位和32位浮点数进行计算。这为加速深度学习模型的推理和训练提供了显著的性能提升。

在Orin平台上,Tensor Cores是实现高AI吞吐量的关键。相较于标准的CUDA核心,Tensor Cores可以在相同的时间内处理更多的数据,这就意味着更高的计算效率和更快的模型执行速度。这也使Orin平台能够在边缘AI应用中实现实时的、高精度的AI处理能力。

对于开发者而言,Tensor Cores的优化意味着可以使用NVIDIA提供的AI加速库(如cuDNN、TensorRT)来编写程序,这些库充分利用了Tensor Cores的性能。在实际应用中,这可以减少模型的推理时间,提高响应速度,对于延迟敏感型应用尤为重要,例如自动驾驶中的紧急避障和智能交通信号控制。

## 2.2 NVIDIA Orin的软件生态系统

### 2.2.1 操作系统与软件堆栈

Orin平台支持多种操作系统,其中NVIDIA JetPack SDK为其主要的软件开发包。JetPack SDK基于Ubuntu Linux,提供了包括CUDA、cuDNN、TensorRT等在内的丰富开发工具和运行时库,为开发者打造了一套完整的软件堆栈。

在操作系统的选择上,开发者可以根据具体的应用需求选择合适版本的Linux,比如Ubuntu或Red Hat,或者选择专为实时性能优化的操作系统,例如NVIDIA的RTOS。操作系统的选择将直接影响到系统集成和后续的开发工作。

软件堆栈的构建是基于这样的理念:简化开发者的任务,使他们能够更快地实现想法并部署到Orin平台上。JetPack SDK不仅包括了底层的驱动和中间件,还提供了高级的API和库,例如用于计算机视觉的VisionWorks,用于深度学习的TensorRT以及用于机器人开发的Isaac SDK。这样的层次化结构旨在满足从系统集成到应用开发的全面需求。

### 2.2.2 NVIDIA JetPack SDK详解

NVIDIA JetPack SDK是开发者利用Orin平台进行边缘AI应用开发的重要工具。它集合了NVIDIA的最新技术,包括CUDA、cuDNN和TensorRT等,为开发者提供了一套完整的AI开发环境。

JetPack SDK中的CUDA是NVIDIA自家的并行计算平台和编程模型,它允许开发者使用C、C++等语言编写能够在GPU上加速执行的代码。CUDA对于大规模并行数据处理至关重要,这在深度学习和科学计算领域非常实用。

cuDNN是NVIDIA提供的深度神经网络库,它经过优化,能够提升深度学习框架的性能。TensorRT则是一个高性能的推理引擎,它通过优化深度学习模型来提高推理速度和效率。

除了这些核心组件,JetPack SDK还包括了开发工具和实用程序,如NVIDIA Nsight开发人员工具、OpenCV、OpenVX等。这些都大大简化了边缘AI应用的开发流程,提高了开发效率。

JetPack SDK的另一个亮点是它提供了丰富的示例和教程,这对于开发者来说是无价之宝。它们不仅能够帮助新手快速上手,同时也让经验丰富的开发者能够迅速构建起自己的应用原型。

## 2.3 NVIDIA Orin在边缘AI中的应用案例

### 2.3.1 智慧城市与自动驾驶

NVIDIA Orin平台在智慧城市和自动驾驶领域展现了强大的应用潜力。智慧城市利用Orin处理大量来自摄像头和传感器的实时数据,执行复杂的分析任务,比如交通流量监测、安全监控、以及公共安全事件的实时响应。

自动驾驶汽车是边缘AI应用中的集大成者,Orin平台提供了必要的计算能力来处理自动驾驶系统中的所有AI工作负载。Orin的高性能GPU和Tensor Cores能够快速处理来自车辆传感器的大量数据,包括摄像头、雷达和激光雷达,实现高级别的自动驾驶功能,如环境感知、决策制定和车辆控制。

### 2.3.2 工业物联网与智能制造

在工业物联网(IIoT)和智能制造领域,Orin平台能够执行实时的数据分析和处理任务,提升自动化生产线的效率和质量控制。Orin可以在制造设备上直接进行数据分析和预测维护,减少意外停机时间,提高生产率。

通过集成Orin平台,制造商能够实现对生产线的实时监控和优化。平台的高性能计算能力使得复杂的机器视觉和机器人控制应用成为可能,使得工厂更加智能和灵活。例如,在质量检测环节,Orin可以处理高分辨率图像和视频数据,快速准确地识别产品缺陷。

综上所述,NVIDIA Orin平台以其强大的计算能力和丰富的软件支持,为边缘AI应用提供了广泛的可能性。无论是在智慧城市、自动驾驶还是工业物联网领域,Orin都展现了其作为边缘AI核心计算平台的领导地位。随着技术的不断进步和应用场景的不断拓展,Orin无疑将在边缘AI的未来发展中扮演更为关键的角色。

# 3. 边缘AI的实战应用与挑战

## 3.1 边缘AI的数据处理能力

### 3.1.1 数据采集与预处理技术

在边缘计算中,数据采集和预处理是至关重要的第一步。与集中式云数据中心不同,边缘计算更加强调数据的实时性和本地性。这意味着数据处理和分析通常发生在数据产生源附近,以减少延迟和带宽使用。

边缘设备通常配备各种传感器,如摄像头、麦克风和其他I/O设备,这些传感器负责收集数据。在某些情况下,这些数据需要即时处理,以支持实时决策。例如,自动驾驶汽车依赖于边缘设备(如车辆上的传感器)进行实时数据采集,以避免交通事故。

数据预处理通常包括以下步骤:

1. **数据清洗** - 移除噪声和不完整或错误的数据。

2. **数据集成** - 从多个数据源合并数据,以获得更全面的视图。

3. **数据转换** - 将数据转换为适合机器学习模型的格式。

4. **数据归一化/标准化** - 使数据特征在相似的规模上,有助于加快学习过程。

预处理的代码片段可以是使用Python的Pandas库进行数据清洗的示例:

```python

import pandas as pd

# 加载数据集

data = pd.read_csv('sensor_data.csv')

# 数据清洗:去除缺失值

data_cleaned = data.dropna()

# 数据转换:将数据从非数值类型转换为数值类型

data_transformed = pd.get_dummies(data_cleaned)

# 数据归一化

data_normalized = (data_transformed - data_transformed.mean()) / data_transformed.std()

```

### 3.1.2 数据流管理和实时分析

在边缘AI中,数据流的管理是一项挑战

0

0