【深度学习框架整合实战】:在Orin平台上打造TensorFlow & PyTorch应用

发布时间: 2024-12-15 07:15:19 阅读量: 11 订阅数: 36

深度学习界的双子星:TensorFlow与PyTorch的较量

参考资源链接:[英伟达Jetson AGX Orin系列手册与性能详解](https://wenku.csdn.net/doc/2sn46a60ug?spm=1055.2635.3001.10343)

# 1. 深度学习框架整合概览

在当今的科技发展浪潮中,深度学习已成为推动创新的核心力量。为了实现更高效、更智能的计算,各种深度学习框架应运而生,TensorFlow、PyTorch等成为了行业内的佼佼者。然而,由于不同框架的特性和应用场景的差异,开发者常常需要将这些框架进行整合以满足特定的需求。

本章将为读者提供一个关于深度学习框架整合的全景视图。首先,我们将对深度学习框架的发展趋势和技术背景进行简要概述,接着探讨不同框架之间的互操作性和兼容性问题。我们将重点强调框架整合的实际意义和优势,以及可能遇到的技术挑战。

随后,在后续章节中,我们将深入探讨具体的深度学习平台和框架,如Orin平台、TensorFlow和PyTorch,并介绍它们各自的特点和优势。此外,我们还将探讨如何在Orin平台上实现不同深度学习框架的整合应用,以及如何优化这些应用以满足日益增长的计算需求。

## 1.1 深度学习框架的演进与整合必要性

深度学习框架是构建和训练神经网络模型的软件工具,它们提供了各种工具、API和算法库,极大地降低了研究者和开发者的入门门槛和实现复杂模型的难度。随着技术的不断进步,框架的多样性也带来了各自的特色和优势,但也为模型的迁移和整合带来了挑战。

整合不同深度学习框架,可以让开发者利用各自框架的优势,实现高效的模型开发与部署。例如,可以使用TensorFlow的成熟生态系统和优化工具,同时借助PyTorch灵活的动态计算图优势,达成更优的模型表现和更快速的实验迭代。

## 1.2 框架整合的挑战与策略

在进行框架整合时,开发者需要考虑到不同框架在数据格式、API设计、模型存储和加载方式上的差异。这种不一致性会导致额外的适配和开发工作,从而影响开发效率和模型的稳定性。

为了应对这些挑战,行业内部逐步发展出一系列策略和工具。这些包括模型转换工具如ONNX(Open Neural Network Exchange),它们支持将一种框架中的模型转换为另一种框架能够识别和加载的格式。此外,为了减轻开发者的负担,许多框架开始实现跨框架的API和抽象层,使得开发者可以在统一的接口下使用不同框架的特性和性能。

通过这些方法,深度学习框架的整合能够有效地进行,并逐步实现不同框架间的无缝协作,为AI应用的广泛部署和实施提供支持。

# 2. Orin平台基础知识

### 2.1 Orin平台硬件架构解读

#### 2.1.1 硬件规格和技术参数

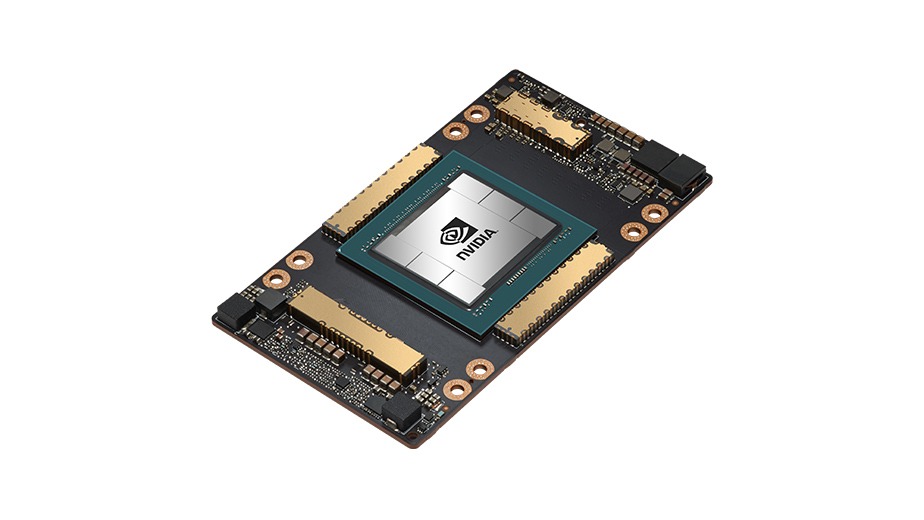

Orin平台以其高性能的硬件规格而在市场上脱颖而出,其关键组件包括GPU、CPU、以及专门的AI加速器。平台采用最新一代的GPU架构,拥有数百个流处理器,这为并行计算提供了强大的支持。同时,集成的多核CPU提供高效的通用计算能力,能够处理操作系统级别的任务以及运行复杂的软件应用。此外,Orin平台还配备有专门为深度学习任务优化的硬件加速器,这些加速器可以提供特定于算法的加速,如卷积神经网络(CNN)和循环神经网络(RNN)。

技术参数方面,Orin平台可以达到数Teraflops的计算性能,支持高达数十GB/s的内存带宽,确保了在执行大规模深度学习模型时的高效数据吞吐。这样的硬件规格使得Orin平台在处理实时数据和复杂模型方面具有显著优势。

#### 2.1.2 平台软件支持和生态系统

Orin平台不仅在硬件上具有竞争力,在软件支持和生态系统构建方面同样值得关注。其官方提供了全面的软件开发套件(SDK),包含优化后的深度学习库、工具链以及预编译的加速器驱动程序。这样的软件支持大大减少了开发者配置环境的时间和复杂性,同时也使得开发者能够快速启动和运行。

此外,Orin平台还拥有一个活跃的开发者社区和合作伙伴网络。这不仅确保了各种工具和库的持续更新和维护,也促成了大量的开源项目和应用案例的积累。这些资源为开发者提供了宝贵的参考和学习资料,从而加速了深度学习应用的开发和部署流程。

### 2.2 Orin平台操作系统和环境配置

#### 2.2.1 官方提供的操作系统选项

Orin平台支持多种操作系统,包括但不限于Ubuntu, Debian, Yocto等主流Linux发行版。官方推荐使用定制的Linux发行版以获得最佳性能,这些发行版对Orin平台的硬件进行了针对性的优化。安装操作系统是使用Orin平台进行深度学习开发的第一步,通常需要考虑平台的硬件特性和开发者的个人喜好。

在选择操作系统时,开发者还需要考虑到系统的稳定性和安全性。例如,为了确保操作系统的稳定性,Orin平台可能推荐使用实时Linux发行版,这可以保证深度学习任务在严格的时间限制内得到响应。

#### 2.2.2 环境搭建和依赖库安装

在操作系统安装完成后,接下来就是环境的搭建,这包括安装必要的软件依赖库和深度学习框架。Orin平台官方推荐使用如Anaconda或Miniconda这样的Python环境管理器来创建隔离的开发环境,这样可以方便地管理和切换不同项目所需的库版本。

对于深度学习开发者来说,安装CUDA、cuDNN、TensorRT等NVIDIA专有软件包是常见的需求。这些软件包提供对GPU进行编程和优化的能力,从而实现高效的深度学习训练和推理。安装这些依赖库不仅需要遵循特定的步骤,还需要确保它们的版本与Orin平台的硬件架构兼容。

```bash

# 示例:在Ubuntu系统中安装CUDA

wget https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/cuda-ubuntu2004.pin

sudo mv cuda-ubuntu2004.pin /etc/apt/preferences.d/cuda-repository-pin-600

sudo apt-key adv --fetch-keys https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/3bf863cc.pub

sudo add-apt-repository "deb https://developer.download.nvidia.com/compute/cuda/repos/ubuntu2004/x86_64/ /"

sudo apt-get update

sudo apt-get -y install cuda

```

在上述代码块中,我们展示了如何在Ubuntu系统上安装CUDA,这包括添加NVIDIA的官方软件源、导入GPG密钥以及安装CUDA。这只是一个简单的例子,但在实际情况中,安装过程可能更加复杂,需要处理版本兼容性、硬件抽象层(HAL)配置等问题。

对于依赖库的安装,通常推荐使用Conda环境进行管理:

```bash

# 创建一个新的Conda环境

conda create -n myenv python=3.8

# 激活新的环境

conda activate myenv

# 在环境中安装深度学习相关的库

conda install pytorch torchvision torchaudio cudatoolkit=11.1 -c pytorch -c nvidia

```

以上代码块演示了如何使用Conda创建一个新的环境并安装PyTorch及其依赖。这样的操作确保了开发环境的整洁,避免了不同项目之间的库版本冲突。

# 3. TensorFlow基础应用与实践

## 3.1 TensorFlow核心概念和模型构建

### 3.1.1 TensorFlow的基本数据结构和操作

TensorFlow的核心数据结构是张量(Tensor),它是多维数组,用于表示数据和操作之间的关系。在TensorFlow中,张量可以存储各种数据类型和形状。为了理解张量和基本操作,我们首先需要了解TensorFlow的编程范式。

#### 张量的基本操作

```python

import tensorflow as tf

# 创建常量张量

constant_tensor = tf.constant([[1, 2], [3, 4]])

# 创建变量张量

variable_tensor = tf.Variable([[1, 2], [3, 4]])

# 运行一个计算图中的节点

with tf.compat.v1.Session() as sess:

result = sess.run(constant_tensor)

print(result)

# 张量的数学操作示例

addition = tf.add(constant_tensor, variable_tensor)

substraction = tf.subtract(constant_tensor, variable_tensor)

multiplication = tf.multiply(constant_tensor, variable_tensor)

with tf.compat.v1.Session() as sess:

print("Addition:\n", sess.run(addition))

print("Substraction:\n", sess.run(substracting))

print("Multiplication:\n", sess.run(multiplication))

```

- **创建张量**:可以通过`tf.constant`创建不可变的常量张量,通过`tf.Variable`创建可变的变量张量。

- **会话操作**:在TensorFlow 1.x版本中,使用`tf.Session`来运行计算图。需要注意的是,TensorFlow 2.x推荐使用`tf.compat.v1.Session()`的方式进行兼容。

- **张量操作**:张量间的数学操作如加法、减法和乘法通过`tf.add`、`tf.subtract`和`tf.multiply`等函数完成。

### 3.1.2 构建和训练基础神经网络模型

为了演示如何使用TensorFlow构建和训练一个基础的神经网络模型,我们以手写数字识别任务(MNIST数据集)为例。

#### 神经网络模型构建

```python

import tensorflow as tf

# 数据集加载

mnist = tf.keras.datasets.mnist

(x_train, y_train), (x_test, y_test) = mnist.load_data()

# 数据预处理

x_train, x_test = x_train / 255.0, x_test / 255.0

x_train = x_train[..., tf.newaxis]

x_test = x_test[..., tf.newaxis]

# 模型构建

model = tf.keras.Sequential([

tf.keras.layers.Flatten(input_shape=(28, 28)),

tf.keras.layers.Dense(128, activation='relu'),

tf.keras.layers.Dropout(0.2),

tf.keras.layers.Dense(10, activation='softmax')

])

# 编

```

0

0