【Python爬虫】:urllib与多线程结合,数据下载效率革命

发布时间: 2024-10-04 14:35:06 阅读量: 29 订阅数: 34

# 1. Python爬虫概述与初识urllib

## 1.1 Python爬虫的基本概念

Python爬虫是一种自动化网络数据抓取工具,它模拟浏览器行为,访问网页并提取所需数据。Python语言因其简洁性及强大的库支持,在爬虫领域应用广泛。使用Python爬虫可以帮助我们快速高效地从互联网上收集整理信息。

## 1.2 选择Python进行爬虫开发的原因

Python具有丰富的第三方库,其中最著名的包括`requests`和`urllib`。`urllib`库作为Python标准库的一部分,无需额外安装,且功能全面,能够支持复杂的网络请求。而`requests`库以其简洁的API设计和强大的功能被广泛使用于更高级的HTTP请求处理中。

## 1.3 urllib库简介

`urllib`库是一个用于处理URL的模块集合,包括`request`、`error`、`parser`以及`robotparser`等多个子模块。它能够帮助开发者进行HTTP请求发送、异常处理、内容解析等操作。在初识`urllib`时,我们可以先从了解`request`模块入手,逐步掌握如何创建请求、发送请求以及获取响应。这是搭建Python爬虫的基本技能,也是后续章节深入学习的基础。

# 2. 掌握urllib的核心模块和使用方法

### urllib的request模块深入解析

#### 创建请求对象

urllib的request模块是Python进行网络请求的核心工具之一,它允许你打开和读取URL。使用urllib.request模块的第一步是创建一个请求对象。下面是一个创建请求对象的示例代码:

```python

from urllib import request

# 创建请求对象

url = "***"

req = request.Request(url)

```

`urllib.request.Request`类用于创建请求对象。你可以传递一个URL和可选的数据、headers和方法来创建请求。如果你不提供数据和headers,则默认使用GET请求。

#### 发送请求及获取响应

创建了请求对象之后,你将需要发送请求并获取服务器的响应。通过调用`urlopen`方法可以实现这一点:

```python

# 发送请求并获取响应

response = request.urlopen(req)

```

`urlopen`方法返回一个HTTPResponse对象,该对象类似于一个文件对象。你可以使用`read`、`readinto`或`geturl`等方法来访问响应内容。

```python

# 读取响应内容

html = response.read()

```

#### 示例分析

下面是一个完整的示例,将请求的URL的内容读取并打印出来:

```python

from urllib import request

# 创建请求对象

url = "***"

req = request.Request(url)

# 发送请求并获取响应

response = request.urlopen(req)

# 读取响应内容并打印

html = response.read()

print(html.decode('utf-8'))

```

这段代码演示了如何使用urllib的request模块创建HTTP请求,并从服务器获取响应。

### urllib的error模块异常处理

#### 常见异常类型

在使用urllib进行网络请求时,可能会遇到多种异常类型。`urllib.error`模块包含了一些与urllib请求相关的异常类,常见的异常类型有`URLError`和`HTTPError`。

- `URLError`是网络错误的基类,当无法访问网络时,会引发这个异常。

- `HTTPError`是当服务器返回错误状态码时会引发的异常。

#### 异常处理策略

当这些异常发生时,你可以通过try/except语句来捕获并处理它们。下面是一个处理异常的示例代码:

```python

from urllib import request, error

try:

# 创建请求对象

url = "***"

req = request.Request(url)

# 发送请求并获取响应

response = request.urlopen(req)

# 读取响应内容

html = response.read()

except error.URLError as e:

print("网络错误:", e.reason)

except error.HTTPError as e:

print("HTTP错误:", e.code)

```

这段代码尝试获取一个不存在的URL的内容,当捕获到`URLError`或`HTTPError`时,会打印出相应的错误信息。

### urllib的parser模块解析数据

#### 解析HTML/XML文档

urllib的parser模块可以用于解析HTML和XML文档。通常我们使用第三方库如`BeautifulSoup`或`lxml`来进行更复杂的解析,但`urllib`自带的解析器足以应对一些简单的解析任务。

#### 提取所需数据的技巧

为了从网页中提取特定信息,我们通常会寻找HTML文档中的特定标签或属性。下面是一个使用`HTMLParser`进行简单解析的示例:

```python

from urllib import parse, error, request

from html.parser import HTMLParser

class MyHTMLParser(HTMLParser):

def handle_starttag(self, tag, attrs):

print(f"Start tag: {tag}")

for attr in attrs:

print(f"Attribute: {attr[0]}={attr[1]}")

def handle_data(self, data):

print(f"Data: {data}")

try:

# 创建请求对象

url = "***"

req = request.Request(url)

# 发送请求并获取响应

response = request.urlopen(req)

# 解析响应内容

content = response.read().decode('utf-8')

parser = MyHTMLParser()

parser.feed(content)

except error.URLError as e:

print("网络错误:", e.reason)

```

在这个示例中,`MyHTMLParser`类继承自`HTMLParser`,并重写了`handle_starttag`和`handle_data`方法来打印标签名、属性和标签之间的文本。

### urllib的robotparser模块使用

#### 识别robots.txt

`robotparser`模块用于解析网站的robots.txt文件。robots.txt是一个放置于网站根目录下的文件,它指示了搜索引擎的爬虫哪些页面可以抓取,哪些不可以。

#### 遵守网站爬取规则

`robotparser.RobotFileParser`类用于分析robots.txt文件。在发起请求之前,使用该模块判断是否允许爬取指定URL是爬虫遵守网络礼仪的表现。

```python

from urllib import robotparser

rp = robotparser.RobotFileParser()

rp.set_url("***")

rp.read()

# 创建请求对象

url = "***"

req = request.Request(url)

# 判断是否可以爬取该页面

can_fetch = rp.can_fetch("*", req.full_url)

print("是否可以爬取该页面:", can_fetch)

```

这个示例演示了如何读取一个网站的robots.txt文件,并检查是否允许爬取一个特定的URL。

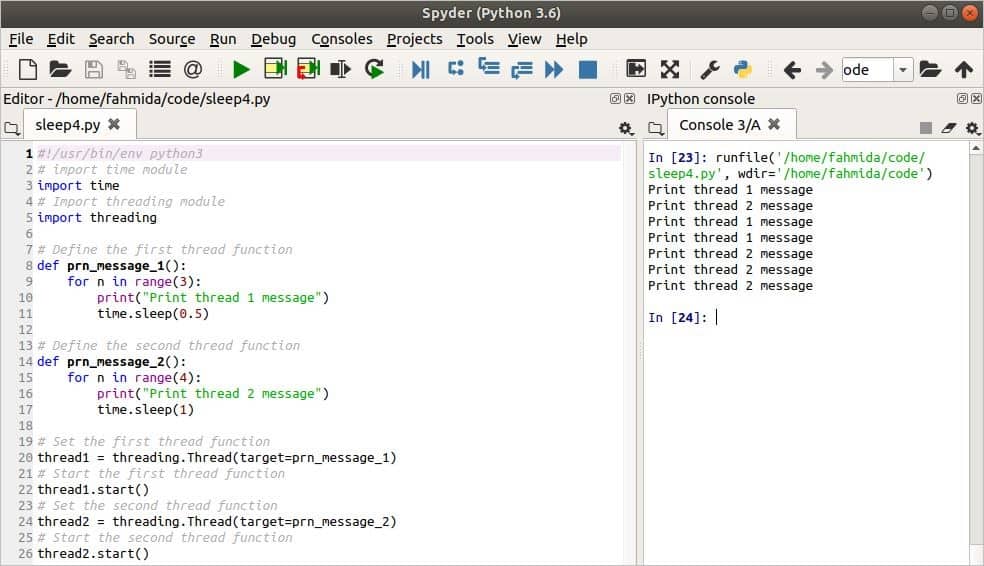

# 3. 多线程编程基础与线程安全

随着爬虫任务的复杂度增加,单线程操作已难以满足性能需求。多线程编程让爬虫能够并行处理多个网络请求,显著提高数据抓取效率。但线程的并发执行也带来了线程安全问题,如何平衡效率与线程安全是本章讨论的重点。

## 3.1 理解多线程编程的优势

### 3.1.1 并发与并行的区别

在深入多线程编程之前,我们需要明确并发与并行的概念。并发(Concurrency)指的是同时处理多件事情的能力,而并行(Parallelism)是指同时执行多件事情的能力。在现代操作系统中,并行是通过多个CPU核心或多个线程来实现的。

**并发**是一种编程方式,它允许多个任务能够在相同的

0

0