【深度学习中的注意力机制】:理解并应用Transformer模型,掌握AI新趋势

发布时间: 2025-01-05 04:34:54 阅读量: 27 订阅数: 12

人工智能里程碑论文: 基于注意力机制的序列转换模型Transformer介绍与应用研究

# 摘要

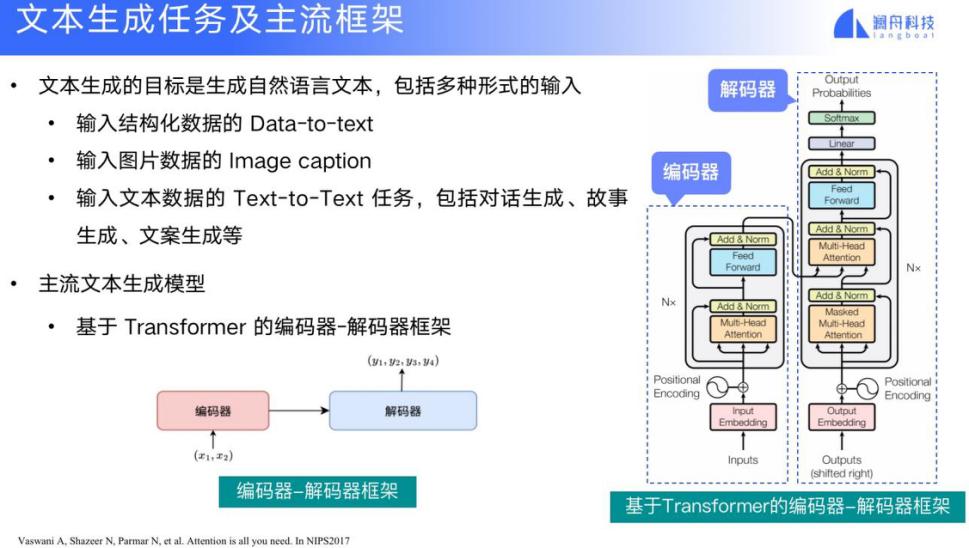

本文首先介绍了注意力机制的重要性及其在深度学习中的作用。接着,深入探讨了Transformer模型的架构和关键技术细节,包括自注意力与多头注意力机制,以及位置编码的作用。文章还讨论了Transformer模型在实际任务中的应用情况,特别是在机器翻译和自然语言处理(NLP)领域。第四章着重于模型的优化与扩展,分析了训练技巧、模型调优以及BERT等进阶模型的特点和优势。最后,文章探讨了Transformer模型面临的挑战和局限性,并提出了未来研究方向,如无监督与自监督学习的发展和模型压缩技术。本文旨在为研究人员和实践者提供对Transformer模型全面深入的理论认识和实践指导。

# 关键字

注意力机制;深度学习;Transformer模型;自注意力;序列模型;模型优化

参考资源链接:[《深度学习技术》全面介绍PPT共41页](https://wenku.csdn.net/doc/6459dc48fcc539136824a4d1?spm=1055.2635.3001.10343)

# 1. 注意力机制简介与重要性

在当今的深度学习领域中,注意力机制已成为一种不可或缺的技术,它模仿了人类视觉注意力的工作方式,允许模型在处理数据时具有一定的选择性。这种机制在自然语言处理(NLP)和计算机视觉(CV)等多个领域取得了显著的效果。理解注意力机制不仅有助于推动这些领域的发展,还能够促进我们对深度学习模型工作原理的深入认识。本章节将首先回顾注意力机制的提出背景,然后详细介绍其工作原理,并探讨它为什么在现代AI架构中变得如此重要。

# 2. 深度学习中的基础概念

### 2.1 神经网络基础回顾

神经网络作为深度学习的基石,其基本组成和运作机制是理解后续高级技术的前提。在这一部分中,我们将重新审视神经网络的核心概念,并深入探讨其类型与结构、前向传播与反向传播算法。

#### 2.1.1 神经网络的类型与结构

在深度学习的世界里,神经网络的类型繁多,每一种都针对特定问题和数据集进行了优化。从结构上来看,神经网络可以是全连接的(Fully Connected),也可以是卷积的(Convolutional),甚至是循环的(Recurrent)。在全连接神经网络中,每个神经元都与其他层中的每个神经元相连;卷积神经网络(CNNs)专注于处理具有网格结构的数据,如图像;循环神经网络(RNNs)则被设计用来处理序列数据,如时间序列和文本。

**表格 1** 概述了不同类型的神经网络及其应用领域:

| 类型 | 应用领域 | 结构特点 |

| --- | --- | --- |

| 全连接网络(Fully Connected) | 分类、回归、特征学习 | 相邻层之间全连接 |

| 卷积神经网络(CNNs) | 图像识别、视频分析 | 局部连接、权值共享 |

| 循环神经网络(RNNs) | 自然语言处理、语音识别 | 时间步共享权重 |

### 2.2 深度学习与序列模型

序列模型是处理序列数据的一种深度学习架构。它们在处理文本、时间序列数据和音频信号时特别有效。本小节将探讨RNN与LSTM的工作原理及其区别,并介绍序列到序列的学习框架。

#### 2.2.1 RNN与LSTM的理解与区别

RNN是一种循环神经网络,它通过隐藏层的循环连接,使其能够捕捉序列数据中的时间动态性。然而,RNN因其梯度消失和梯度爆炸的问题而受限,尤其是在处理长序列时。

长短期记忆网络(LSTM)是为了解决传统RNN的这些问题而设计的。LSTM引入了门控机制来调节信息的流动,有效防止了梯度问题,并且可以学习长期依赖关系。

**Mermaid 流程图** 展示LSTM单元的结构,如下所示:

```mermaid

graph LR

A[输入门] -->|控制新信息流入| C[记忆细胞]

B[遗忘门] -->|控制旧信息流出| C[记忆细胞]

C[记忆细胞] -->|决定输出信息| D[输出门]

```

### 2.3 从序列模型到注意力机制

注意力机制是深度学习中的一个突破性概念,它允许模型在处理数据时“关注”序列中的特定部分,从而提高了对复杂数据的处理能力。本小节将介绍注意力机制的提出背景和工作原理。

#### 2.3.1 注意力机制的提出背景

注意力机制最初由研究者在机器翻译任务中提出,以应对传统序列到序列模型难以处理长句子的问题。注意力机制使模型能够在生成当前词时,动态地“聚焦”于输入序列中的相关信息,从而缓解了长距离依赖问题,并提高了模型的翻译质量和效率。

#### 2.3.2 注意力机制的工作原理

在注意力机制中,模型会计算输入序列中每个元素与当前处理元素之间的注意力分数。这些分数决定了输入序列中每个元素对于当前任务的“重要性”。然后,模型基于这些分数,产生加权的上下文向量,该向量随后被用于任务的相关决策。

**代码块** 示例:

```python

# 注意力分数计算示例

def calculate_attention_scores(input_sequence, query_vector):

# input_sequence: 输入序列, query_vector: 查询向量

scores = []

for item in input_sequence:

# 计算当前输入项与查询向量之间的相似度

score = dot_product(item, query_vector) # dot_product为自定义函数

scores.append(score)

return scores

# 注意力分数的softmax处理,得到归一化权重

attention_weights = softmax(calculate_attention_scores(input_sequence, query_vector))

# 使用加权的上下文向量生成最终输出

context_vector = weighted_sum(input_sequence, attention_weights)

```

在上述代码中,`dot_product`和`softmax`是自定义的函数,用于计算点积和应用softmax函数。`weighted_sum`函数用于根据权重对序列元素进行加权求和,生成加权的上下文向量。

注意力机制的提出,不仅促进了深度

0

0