【大数据分析揭秘】:MapReduce任务启动时机对性能的决定性影响

发布时间: 2024-10-31 17:57:51 阅读量: 40 订阅数: 25

# 1. MapReduce的性能基准和影响因素

MapReduce作为一种广泛应用于大数据处理的编程模型,其性能基准和影响因素一直是IT专业人士关注的焦点。为了深入理解如何在实际应用中最大化MapReduce的潜力,我们必须首先对影响其性能的关键因素有一个清晰的认识。这些因素包括但不限于任务的并行度、数据的输入输出模式、网络带宽以及CPU和内存的资源利用情况。这些因素在不同程度上影响着MapReduce作业的总体性能,特别是它们对任务执行时间、资源消耗和作业吞吐量的影响。理解这些因素是如何相互作用的,不仅有助于开发者优化单个作业的执行,而且对于整个大数据处理系统的性能调优也至关重要。后续章节将进一步深入探讨MapReduce的工作原理和性能优化的策略。

# 2. 深入理解MapReduce任务执行模型

MapReduce是一个分布式计算框架,允许开发者通过简单的接口处理大规模数据集。本章节将深入探讨MapReduce任务执行模型,包括其工作原理、性能分析基础以及启动时机对资源分配的影响。

## 2.1 MapReduce的工作原理

### 2.1.1 MapReduce的核心组件和执行流程

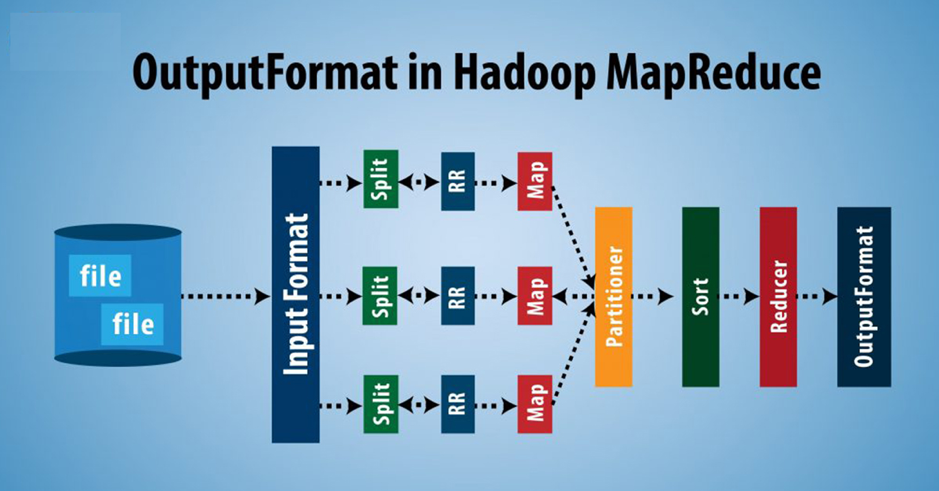

MapReduce程序主要由Map和Reduce两个阶段组成,其核心组件包括输入数据、Map函数、Shuffle过程、Reduce函数和输出数据。Map阶段处理输入数据并输出键值对,Shuffle过程负责将所有Map输出的键值对进行排序和分组,然后传递给Reduce阶段。Reduce阶段对分组后的键值对进行合并处理,最后输出最终结果。

MapReduce工作流程如下:

1. 输入数据被分割成多个小的数据块,每个数据块由Map任务处理。

2. Map任务读取输入数据块,执行Map函数,输出中间键值对。

3. 所有Map任务完成后,Shuffle过程开始。它收集所有Map任务的输出,按照键值对中的键进行排序和分组。

4. 分组后的键值对传递给Reduce任务。

5. Reduce任务对每个键的所有值进行合并操作,生成最终的输出结果。

### 2.1.2 MapReduce任务的调度机制

MapReduce任务的调度是由JobTracker(对于Hadoop 1.x版本)或ResourceManager(对于YARN框架,即Hadoop 2.x及之后版本)负责。任务调度流程包括资源分配、任务监控和容错处理。

资源分配涉及确定哪些节点可以执行任务。ResourceManager根据资源请求和节点上可用资源来调度任务。任务监控包括跟踪任务的执行状态和处理失败的任务。如果MapReduce任务失败,ResourceManager会重新调度任务至其他节点。

## 2.2 MapReduce性能分析基础

### 2.2.1 性能评估的关键指标

评估MapReduce性能的关键指标包括:

- 吞吐量:单位时间内处理的数据量。

- 响应时间:从提交任务到获取结果的时间。

- 资源利用率:系统资源的使用效率。

- 可伸缩性:系统处理数据规模增加时,性能提升的效率。

### 2.2.2 性能瓶颈的识别方法

识别MapReduce性能瓶颈通常采用以下方法:

- 监控各个阶段的执行时间和资源使用情况。

- 使用性能分析工具(如Ganglia、Ambari等)进行实时监控。

- 分析Map和Reduce任务的日志文件。

- 检查任务失败和数据倾斜问题。

## 2.3 启动时机对资源分配的影响

### 2.3.1 资源分配策略和任务启动时刻的关系

资源分配策略直接影响任务的启动时机。在YARN框架中,ResourceManager根据集群的资源使用情况和任务需求来分配资源。资源分配策略可以分为静态和动态两种:

- 静态策略:任务在提交时就预分配资源,不随集群负载的变化而调整。

- 动态策略:ResourceManager根据集群当前资源使用情况动态分配资源。

选择合适的资源分配策略和确定任务的启动时刻对于优化资源利用率和系统性能至关重要。

### 2.3.2 启动时机对资源利用率的影响分析

任务启动时机的优化能够提高资源利用率,减少任务等待时间,降低延迟。启动时机过早或过晚都会影响到系统的整体性能。

- 提早启动可能导致资源抢占,增加任务等待时间。

- 过晚启动可能造成资源空闲,降低系统吞吐量。

因此,通过分析历史性能数据和任务特性,可以确定最优的启动时机,平衡资源利用率和任务响应时间。

以下章节的内容将在后续回答中继续输出,按照指定的章节结构和内容要求逐一提供。

# 3. MapReduce启动时机优化理论

## 3.1 任务启动时机的理论模型

### 3.1.1 理论模型的建立和参数

在优化MapReduce启动时机的过程中,理论模型的建立至关重要。它能帮助我们理解和预测任务执行的性能,并制定出合理的启动策略。模型的建立通常包括几个关键参数:任务的输入数据大小、集群的资源容量、节点的处理能力和网络带宽等。

假设我们有一个简化的模型,其中包含的参数如下:

- **D**: 输入数据的大小(单位:GB)

- **C**: 集群中可用的CPU核心数

- **M**: 每个Map任务所占用的内存大小(单位:MB)

- **R**: 网络带宽(单位:Mbps)

- **T**: 任务的处理时间

该模型的目标是确定启动时机,以最小化整个MapReduce作业的总完成时间。这涉及到对上述参数的计算和优化。

### 3.1.2 理论模型对实际操作的指导意义

理论模型的价值在于它能够预测在特定条件下,MapReduce任务的性能表现。通过模型,我们可以推断出最优的启动时机,确保集群资源得到充分利用,同时避免资源的浪费。

例如,在资源受限的环境中,提前启动过多的任务会因资源竞争导致效率下降。通过理论模型,我们可以计算出最优的任务启动数量,避免这种资源浪费。同时,通过模型中的参数调整,我们还可以针对不同的应用场景进行性能优化。

### 代码块示例

```python

import numpy as np

def calculate_optimal_start_time(data_size, cpu_cores, memory_per_map, bandwidth, processing_time):

# 这是一个简化的函数,用于计算理论上的最佳启动时间

# 实际应用中可能需要复杂的算法和优化技术

optimal_time = (data_size / bandwidth) * processing_time / cpu_cores / memory_per_map

return optimal_time

# 示例参数

data_size = 500 # GB

cpu_cores = 100

memory_per_map = 1024 # MB

bandwidth = 1000 # Mbps

processing_time = 10 # minutes

optimal_time = calculate_optimal_start_time(data_size, cpu_cores, memory_per_map, bandwidth, processing_time)

print(f"理论上的最佳启动时间为: {optimal_tim

```

0

0