Hadoop文件传输协议揭秘:掌握pull与get通信协议的精髓

发布时间: 2024-10-28 04:06:17 阅读量: 39 订阅数: 25

# 1. Hadoop文件传输协议概述

在大数据技术的浪潮中,Hadoop作为开源框架的核心,支持数据密集型分布式应用的高效运行。本章节将简要介绍Hadoop文件传输协议的基础知识,为读者进一步深入学习pull与get通信协议的理论与实践打下坚实基础。

## 1.1 Hadoop文件传输协议简介

Hadoop文件传输协议主要用于在Hadoop集群内部以及外部的节点间高效安全地移动大量数据。Hadoop通过结合pull与get两种通信协议,优化了数据的读写操作,确保了数据的一致性和系统的可靠性。理解这两种协议的工作机制对于优化Hadoop集群的性能和稳定性至关重要。

## 1.2 Hadoop中的数据传输需求

### 1.2.1 Hadoop集群的数据流

Hadoop集群的数据流涉及大量的数据输入和输出操作,数据的存储通常基于HDFS,而数据处理则依赖于MapReduce等计算框架。了解数据流的流向和特点有助于理解Hadoop在数据传输中所面临的挑战。

### 1.2.2 数据传输的挑战与需求

为了保证高吞吐量和低延迟的数据传输,Hadoop需要解决网络带宽限制、数据冗余存储、故障恢复等核心问题。本章节将探讨Hadoop如何通过内建的文件传输协议来应对这些挑战,并满足大数据处理中的严格需求。

# 2. pull与get通信协议理论基础

## 2.1 Hadoop中的数据传输需求

### 2.1.1 Hadoop集群的数据流

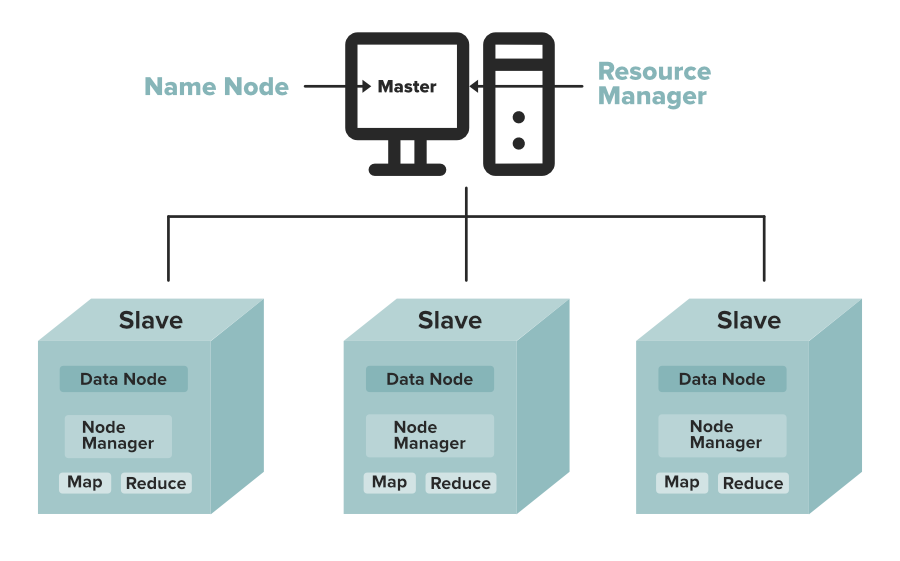

在Hadoop集群中,数据流主要涉及到数据的存储、复制、计算和最终的输出。数据首先通过HDFS(Hadoop Distributed File System)存储在多个节点上。当需要进行数据处理时,MapReduce或其他计算框架会从HDFS中读取数据,进行并行处理。处理结果可以是中间数据或者最终结果,这些数据又要写回到HDFS中,或者输出到外部系统。除此之外,数据复制保证了系统的高可用性和容错性,通过数据块(block)的自动备份在不同节点间传输。

### 2.1.2 数据传输的挑战与需求

Hadoop集群的数据传输面临很多挑战。由于集群可能包含成百上千的节点,且数据规模可能达到PB级别,因此,网络传输的效率直接影响整个集群的性能。Hadoop需要保证数据传输的可靠性、效率和安全性。面对如此大规模的数据移动,对网络带宽和延迟提出了更高的要求。同时,数据传输协议需要能够处理节点故障和数据不一致的情况。

## 2.2 pull与get通信协议的工作原理

### 2.2.1 pull协议机制详解

pull协议机制允许客户端主动从源节点拉取数据。这种方式下,数据传输的主动权掌握在请求方手中,可以较好地控制数据传输的时机和速度。例如,在数据备份和恢复过程中,目标节点会通过pull协议向源节点请求所需的数据块。Hadoop中,DataNode节点之间数据的复制就是通过pull机制进行的。当一个数据块需要复制时,目标DataNode节点会向拥有该数据块的DataNode节点发起请求,获取数据块。

pull机制的优点在于它能够有效地减轻数据源节点的压力,尤其是在数据源节点需要同时服务多个请求时,因为数据源节点不需要主动去推送数据给所有目标节点,而是等待目标节点来请求数据。此外,pull协议也支持更灵活的数据传输调度,可以根据网络状况和目标节点的需求来动态调整数据传输计划。

```mermaid

sequenceDiagram

participant DN1

participant DN2

DN1->>DN2: Data block required

DN2-->>DN1: Send data block

```

### 2.2.2 get协议机制详解

与pull协议相对的是get协议,get协议机制中,数据传输是由源节点控制的。源节点会主动将数据推送到目标节点。在Hadoop中,客户端读取HDFS数据时,就是通过get协议从NameNode获取数据块的地址列表,然后直接从对应的DataNode节点上获取数据块。get协议适合于那些需要从单一源快速并行传输数据到多个目标节点的场景,比如数据加载和恢复。

get协议能够有效利用源节点的处理能力,因为它不需要目标节点频繁地请求数据,从而减少通信开销。不过,这也可能导致源节点在高负载情况下过载,因为它必须主动管理所有目标节点的数据传输。因此,在使用get协议时,往往需要考虑源节点的负载均衡和传输速率控制。

```mermaid

sequenceDiagram

participant Client

participant NameNode

participant DataNode

Client->>NameNode: Request data block list

NameNode-->>Client: Data block addresses

Client->>DataNode: Get data block

DataNode-->>Client: Send data block

```

### 2.2.3 两种协议的对比分析

pull和get两种协议各有利弊,选择哪一种取决于具体的数据传输需求。pull协议提供了更大的灵活性和目标节点控制权,它允许目标节点根据自己的能力和条件去请求数据。这在节点数量众多且网络状况复杂的大规模集群中特别有优势。然而,这种模式可能会造成网络中的通信量增加,因为每个节点都可能需要发送多个请求来满足自己的数据需求。

相比之下,get协议通过源节点控制数据传输,可以在源节点和目标节点间建立高效的传输通道,尤其适用于数据流是从单一源到多个目标的场景。它减少了网络中的通信量,并且由于是源节点主动推送数据,因此可以更好地控制数据传输过程。不过,如果目标节点众多或目标节点分布广泛,get协议可能会造成源节点负载过重。

## 2.3 Hadoop网络编程基础

### 2.3.1 Hadoop网络通信架构

Hadoop网络通信架构是基于Java的网络编程实现的,它利用了Java的网络和IO库。核心通信模型是基于RPC(Remote Procedure Call)机制,它允许程序在远程机器上执行操作就像本地操作一样简单。Hadoop通过RPC实现了节点间的通信,比如NameNode和DataNode之间的通信、客户端与NameNode之间的通信等。此外,为了支持大规模数据传输,Hadoop也利用了基于HTTP的通信机制。通过HTTP,Hadoop可以处理大块数据的传输,因为HTTP协议自身具备了良好的压缩和缓存处理机制。

### 2.3.2 RPC与HTTP在Hadoop中的应用

RPC在Hadoop中的应用非常广泛,它是Hadoop分布式计算框架中各个组件进行通信的基石。例如,客户端通过RPC向NameNode发送文件读写请求,Nam

0

0