Hadoop文件系统监控:pull与get操作的实时监控与日志分析策略

发布时间: 2024-10-28 03:55:15 阅读量: 30 订阅数: 36

基于Hadoop网站流量日志数据分析系统.zip

# 1. Hadoop文件系统基础与监控需求

Hadoop作为一个分布式存储与计算框架,在大数据存储和处理方面发挥着重要作用。对于Hadoop文件系统(通常指HDFS,Hadoop Distributed File System),监控是确保数据可靠性和系统稳定性的关键环节。本章首先介绍Hadoop文件系统的基础知识,为后续的监控策略和实践案例打下理论基础。

## 1.1 Hadoop文件系统简介

Hadoop文件系统,特指HDFS,是一个高度容错性的系统,设计用来部署在廉价的硬件上。它能提供高吞吐量的数据访问,非常适合大规模数据集的存储。HDFS通过将数据分块(block)并跨多台机器存储,实现了数据的分布式存储。

## 1.2 监控需求分析

监控HDFS的目的是为了实时了解集群的工作状态,预测潜在问题,以及分析历史数据。对于Hadoop集群来说,监控需求包括但不限于:数据读写流量、节点健康状态、资源利用率(CPU、内存、磁盘、网络)以及文件系统的完整性等。

## 1.3 Hadoop集群监控的重要性

Hadoop集群的监控不仅能够帮助管理员及时发现硬件故障和软件错误,而且能够评估系统性能,合理调配资源,以及预防可能的数据丢失。监控Hadoop集群的运行状况对于保障业务的连续性和数据的安全至关重要。

# 2. Hadoop文件系统监控理论

## 2.1 Hadoop文件系统架构概述

### 2.1.1 Hadoop核心组件介绍

Hadoop作为一个开源框架,它允许使用简单的编程模型跨服务器群集分布式处理大量数据。Hadoop的核心组件包括Hadoop分布式文件系统(HDFS)、Hadoop MapReduce和YARN(Yet Another Resource Negotiator)。

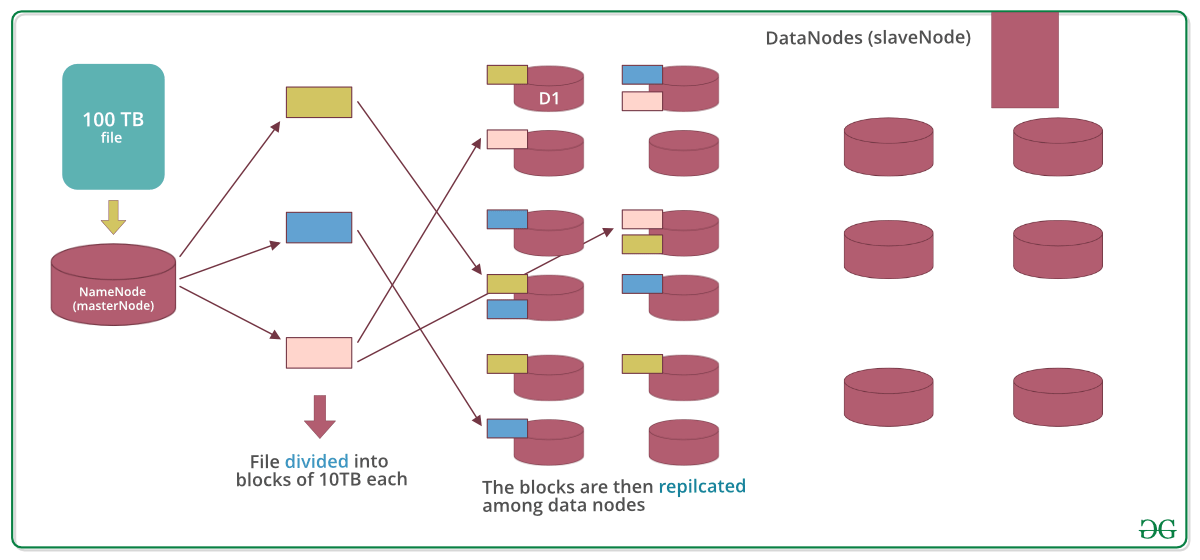

- **HDFS**:Hadoop分布式文件系统,负责存储数据,它使用主从结构模型,由一个NameNode(主节点)和多个DataNodes(数据节点)组成。NameNode管理文件系统命名空间和客户端对文件的访问,DataNode则在本地文件系统上存储实际数据。

- **MapReduce**:一种编程模型和处理大规模数据集的计算框架。它将应用分解为许多小块进行处理,然后合并这些小块的结果以得到最终答案。

- **YARN**:负责资源管理和作业调度。YARN的引入将资源管理和作业调度/监控分离开来,使得Hadoop能够支持更多种类的处理任务,不仅仅局限于MapReduce。

### 2.1.2 文件系统在Hadoop中的作用

文件系统在Hadoop生态系统中扮演着基础存储的角色,对于大数据分析的性能和可靠性至关重要。

- **数据存储**:HDFS提供了高吞吐量的数据访问,非常适合大规模数据集的应用。通过数据的分布式存储,Hadoop能够处理PB级别的数据。

- **容错机制**:HDFS通过在不同的DataNode上存储数据的多个副本,提供高容错性。当某个节点失败时,系统依然能够访问数据,保证了系统的高可靠性。

- **扩展性**:HDFS被设计为易于扩展的文件系统,可以横向增加更多的DataNode来提高存储容量和计算性能。

## 2.2 监控系统的设计原则

### 2.2.1 实时性与准确性的平衡

在设计Hadoop监控系统时,需要平衡监控数据的实时性和准确性。监控系统必须能够及时地提供数据,以便于快速反应并采取措施。

- **实时监控**:实时监控通过持续地收集和分析系统运行数据,可以迅速地发现异常情况。这对于确保服务的高可用性和性能至关重要。

- **数据准确性**:监控数据必须准确,以便于工程师能够依赖这些数据进行决策。准确性低的监控数据可能导致错误的判断和处理。

### 2.2.2 监控系统的可扩展性

随着Hadoop集群规模的不断扩大,监控系统的设计需要具有良好的扩展性,能够适应集群规模的增加。

- **水平扩展**:监控系统应当支持水平扩展,即通过增加监控节点来增强监控系统的处理能力。

- **模块化设计**:采用模块化设计,可以使得监控系统在不同层级上都能够增加新的功能而不需要对整个系统进行重大的改造。

## 2.3 日志分析的重要性

### 2.3.1 日志数据的采集

在Hadoop集群中,日志数据是系统健康状态的直接反映,是进行故障诊断和性能优化的重要依据。

- **日志级别**:设置合适的日志级别对日志的采集至关重要。错误和警告级别的日志可以帮助快速定位问题,而信息级别的日志则有助于深入理解系统行为。

- **日志聚合**:日志数据往往分散在集群的各个节点上,因此需要使用如Flume或Kafka等工具进行日志的收集和聚合。

### 2.3.2 日志数据的预处理

采集后的日志数据往往需要经过清洗和转换才能用于进一步的分析。

- **清洗**:去除无用的日志信息,例如已知的正常日志模式,这样可以减少数据量,提高分析效率。

- **格式转换**:将原始日志转换成统一的格式,例如JSON或CSV,以便于后续的处理和分析。

### 2.3.3 日志数据的存储与管理

- **存储方案**:选择适合大数据环境的日志存储方案,例如HDFS或分布式NoSQL数据库。

- **数据索引**:建立日志数据的索引机制,加快查询速度。

### 2.3.4 日志分析方法与工具

- **分析方法**:介绍常见的日志分析方法,如统计分析、模式匹配、时间序列分析等。

- **分析工具**:介绍一些流行的日志分析工具,比如ELK Stack(Elasticsearch、Logstash和Kibana)和Fluentd等。

在下一章节,我们将深入探讨实时监控技术的实现,包括监控工具的选择、配置,以及如何实现对Hadoop文件系统操作的实时监控。

# 3. 实时监控技术的实现

在大数据生态中,实时监控技术的实现是确保系统稳定性与高可用性的关键。随着数据量的增加,对监控系统的性能和准确性要求也越来越高。在这一章节中,我们将深入探讨实时监控技术的实现途径,包括选择和配置监控工具、实现数据的pull与get操作监控以及设计和实现异常处理与告警机制。

## 3.1 实时监控工具选择与配置

### 3.1.1 监控工具对比分析

监控工具的选择对于实时监控系统至关重要。市场上存在多种监控解决方案,包括开源与商业产品。一些知名的开源监控工具有Prometheus、Ganglia、Nagios等,而商业解决方案如New Relic、Datadog等提供了更完善的支持与服务。

对比分析这些工具时,需考虑它们的实时性、扩展性、稳定性和易用性。例如,Prometheus具有强大的数据查询语言和内置的告警机制,但对数据存储的扩展性有限。另一方面,商业产品通常提供了更好的UI和客户支持,但可能需要较高的成本。

### 3.1.2 配置监控工具实例

以Prometheus为例,该工具通过配置文件或自动发现机制来收集监控数据。以下是一个简单的Prometheus配置文件实例:

```yaml

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'hadoop-cluster'

static_configs:

- targets: ['hdfs-namenode:9100', 'hdfs-datanode:9100']

```

在此配置中,Promet

0

0