Hadoop文件传输安全性:深入pull与get过程的加密与认证机制

发布时间: 2024-10-28 03:51:49 阅读量: 37 订阅数: 36

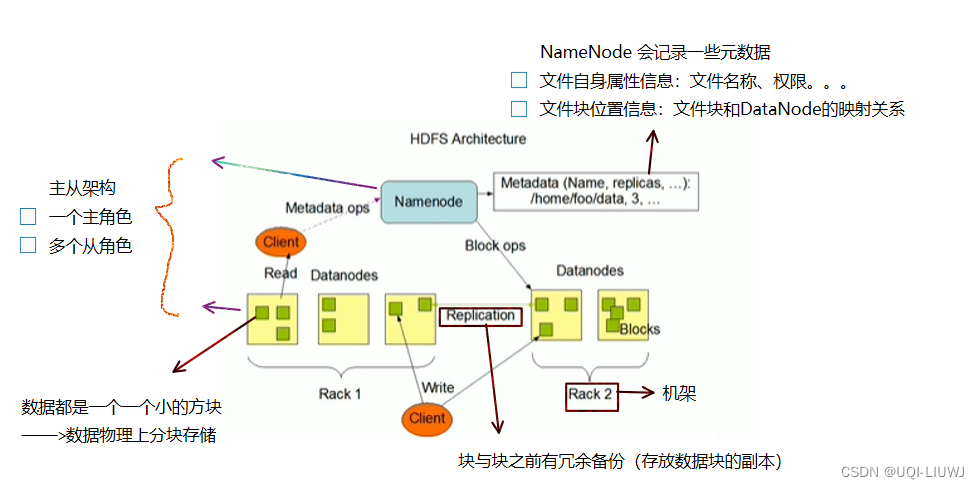

深入 Hadoop 的心脏:HDFS 架构解析与工作机制

# 1. Hadoop文件传输安全性的基本概念

在现代大数据处理框架中,Hadoop已成为存储和处理大量数据的重要工具。然而随着数据安全和隐私问题的日益突出,Hadoop文件传输安全性已经成为系统管理员和开发人员必须面对的问题。本章将对Hadoop文件传输安全性的基本概念进行简单阐述,为读者建立起后续章节深入了解的技术基础。

## 1.1 Hadoop文件传输安全性的意义

Hadoop文件传输安全性是指在Hadoop生态系统中,对数据在各个节点间传输时采取的安全措施,以防止数据被未授权访问或篡改。在大数据分析和存储解决方案中,数据的安全传输是保障企业数据安全的关键环节。理解并优化这个环节对于确保数据的完整性和隐私保护至关重要。

## 1.2 Hadoop文件传输面临的威胁

在Hadoop的文件传输过程中,面临着多种潜在的安全威胁。其中包括中间人攻击、数据泄露风险、以及恶意用户或软件的非法访问等。要有效防护这些风险,必须采取包括但不限于数据加密、安全认证、权限控制等多种安全措施。

## 1.3 安全传输的重要性

在分析了Hadoop文件传输的安全性问题后,我们可以清楚地看到,为Hadoop环境中的文件传输提供坚固的安全保障,对于保护企业敏感信息、遵守法律法规、以及维护企业声誉具有重大意义。这一点对于处理大量数据的现代企业尤其重要,也是我们深入探讨Hadoop文件传输安全性的初衷。在接下来的章节中,我们将详细介绍Hadoop安全传输的基础组件与原理,以及各种实用的安全策略。

# 2. Hadoop安全传输的基础组件与原理

## 2.1 Hadoop安全传输的组件

### 2.1.1 Hadoop RPC和传输层安全

Hadoop的远程过程调用(RPC)协议是Hadoop各组件间通信的基础。它允许Hadoop集群中的节点之间进行高效的通信。然而,这种通信是透明的,也可能容易受到攻击,因此,Hadoop通过传输层安全(TLS)来保护其RPC通信。

TLS是建立在TCP/IP协议之上的加密协议,用于确保在两个或多个网络应用间交换的数据安全和完整性。Hadoop通过集成TLS,确保了所有通过RPC发送和接收的数据都是加密的,并且数据传输双方的身份都得到了验证,防止了中间人攻击。

在Hadoop中配置TLS涉及到一系列步骤,包括生成密钥和证书、配置Hadoop集群中的各个守护进程来使用这些证书、以及可能的情况下修改网络防火墙设置以允许加密通信。代码示例如下:

```shell

# 生成密钥对和自签名证书

keytool -genkeypair -keystore keystore.jks -alias <alias> -keyalg RSA -keysize 2048 -storepass <password> -dname "CN=<common_name>, OU=<organization_unit>, O=<organization>, L=<location>, S=<state>, C=<country>"

# 配置Hadoop守护进程使用密钥和证书

# 在hadoop-env.sh中设置JAVA_HOME

export JAVA_HOME=<path_to_java_home>

# 在core-site.xml中配置TLS

<configuration>

<property>

<name>hadoop.ssl.enabled</name>

<value>true</value>

</property>

<property>

<name>hadoop.ssl.server.keystore.type</name>

<value>jks</value>

</property>

<property>

<name>hadoop.ssl.server.keystore.location</name>

<value>***${hadoop.home.dir}/ssl/server.jks</value>

</property>

</configuration>

```

请注意,实际操作中,需要将`<alias>`, `<password>`, `<common_name>`, 和其他相关属性替换为合适的值。

### 2.1.2 安全认证机制简介

认证是Hadoop安全传输的基础,用于验证Hadoop集群中组件之间的身份。Hadoop利用Kerberos认证协议来进行安全认证。Kerberos是一种广泛使用的网络认证协议,它依赖于密钥分布中心(KDC)来验证用户的身份数字证书。每一个Hadoop集群的用户和服务都有一个唯一的Kerberos主体,它由一个服务名称和一个主体名称组成。

在Hadoop集群中,当用户想要访问某个资源或服务时,需要先向Kerberos获取一个票据授予票据(TGT),再使用该TGT获取服务票据,以此来访问特定的服务。在Hadoop的配置中,这涉及到修改`krb5.conf`文件,确保Kerberos能够正确地与Hadoop集群进行通信。

```ini

# /etc/krb5.conf 示例配置

[libdefaults]

default_realm = ***

dns_lookup_realm = false

dns_lookup_kdc = true

[realms]

*** = {

kdc = ***

admin_server = ***

}

[domain_realm]

.*** = ***

*** = ***

```

通过上述配置,当用户提交作业或访问HDFS时,Kerberos可以确保用户的请求是在身份验证后进行的。

## 2.2 Hadoop安全传输的工作原理

### 2.2.1 Kerberos认证过程

Kerberos认证过程是一个涉及用户、KDC和Hadoop集群组件之间的三个主要步骤的过程。用户首先向KDC发送认证请求,KDC验证用户的身份,并返回一个会话密钥和TGT。用户随后使用这个TGT来请求访问特定服务的票据,服务票据在服务端被验证,从而完成认证过程。

在这个过程中,Hadoop集群的每一个节点和服务都需要有自己的Kerberos主体,而且集群需要能够与KDC通信。这要求在每个节点上正确配置Kerberos客户端,并且需要有一个运行中的KDC。Kerberos认证过程不仅保证了用户身份的认证,还保证了通信过程中消息的完整性和保密性。

### 2.2.2 数据加密和解密流程

在Hadoop中,数据在传输过程中是加密的,这涉及到在数据发送端加密数据,并在数据接收端解密数据。Hadoop的加密技术是可插拔的,支持多种加密算法,如AES(高级加密标准)和3DES(三重数据加密算法)等。

数据加密通常发生在数据传输之前,而数据解密则发生在数据接收之后。这个过程是透明的,用户不需要手动干预。在集群中,数据加密由Hadoop的安全组件管理,如HDFS的DataNode组件,它们在存储数据时自动加密数据,在读取数据时自动解密数据。这个过程通过配置不同的加密策略来实现,例如文件系统级别的加密、加密区域或者使用特定的加密算法进行加密。

数据加密的配置示例如下:

```xml

<!-- 在core-site.xml中配置数据加密 -->

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://namenode:8020</value>

</property>

<property>

<name>hadoop.security.cipher.suite</name>

<value>AES/CTR/NoPadding</value>

</property>

</configuration>

```

在配置加密时,确保选择的加密算法满足安全和性能要求。而且,数据解密的过程是自动的,对用户来说是透明的。

## 2.3 Hadoop安全传输的挑战和解决策略

### 2.3.1 兼容性问题的应对

随着Hadoop版本的更新和安全功能的增强,可能会出现向后兼容性问题。这在升级Hadoop集群时尤其明显,因为旧的客户端可能无法与新版本的守护进程通信,或者旧的安全协议不再被支持。为应对这类挑战,Hadoop提供了版本兼容性配置选项,允许集群在一定时期内同时支持新旧协议和安全模型。

为了保持兼容性,管理员可能需要在集群中部署多个版本的Hadoop守护进程,并确保它们都能满足不同客户端的需求。除此之外,确保所有的安全升级都是渐进的,为每个步骤提供充分的测试和回滚计划,也是保持集群稳定运行的重要策略。

### 2.3.2 性能优化的方法

虽然安全传输为Hadoop集群增加了保护,但同时也可能带来性能开销,如CPU处理加密和解密的负载,

0

0