Hadoop文件操作进阶:掌握高级pull与get使用技巧

发布时间: 2024-10-28 03:48:35 阅读量: 18 订阅数: 25

# 1. Hadoop文件操作基础

## 简介

Hadoop作为一个成熟的分布式存储和计算平台,广泛用于大数据处理领域。学习Hadoop文件操作是理解其生态系统和高效利用资源的基础。本章将从最基础的文件操作开始,为读者打开Hadoop世界的大门。

## Hadoop文件操作概述

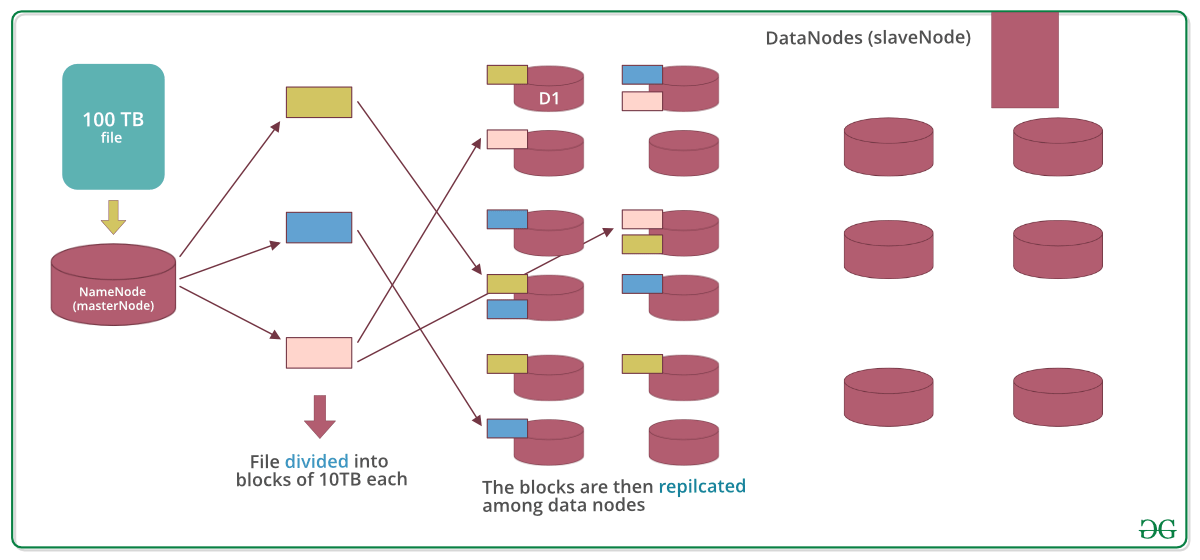

Hadoop文件系统(HDFS)是分布式环境下处理大规模数据集的基础设施。它允许在普通硬件上存储大量数据,并通过提供高吞吐量访问这些数据,以实现容错。HDFS通过"写一次,读多次"的方式减少写操作,增强数据的可靠性。

## 基本命令

Hadoop提供了简单易用的命令行工具来进行文件操作。以下是一些基本的命令操作示例:

```bash

# 列出目录下的文件和子目录

hadoop fs -ls /path/to/directory

# 查看文件内容

hadoop fs -cat /path/to/file

# 创建目录

hadoop fs -mkdir /new/directory

# 删除文件或目录

hadoop fs -rm /path/to/file_or_directory

# 上传本地文件到HDFS

hadoop fs -put localfile /path/to/hdfs_directory

# 下载HDFS中的文件到本地

hadoop fs -get /path/to/hdfs_file localfile

```

执行这些基本命令是掌握Hadoop文件操作的第一步。通过这些操作,我们可以了解HDFS的目录结构和文件存储方式,为进一步的学习和实践打下基础。

# 2. 深入理解Hadoop的高级pull操作

## 2.1 Hadoop pull操作的基本原理

### 2.1.1 数据拉取流程概述

Hadoop作为一个大规模数据存储与处理系统,其数据拉取操作(通常称为“pull操作”)是指从Hadoop分布式文件系统(HDFS)中读取数据的过程。pull操作主要涉及到几个关键步骤,包括客户端发起读请求、NameNode处理请求、DataNode响应读取以及数据传输给客户端。

pull操作开始时,客户端向NameNode发送一个读请求,这个请求包含了要读取的文件的名称和起始位置。NameNode负责找到数据所在的DataNode,并返回这些信息给客户端。客户端随后直接与DataNode进行通信,拉取所需的数据块。

### 2.1.2 权限和认证机制

在数据拉取的过程中,Hadoop通过权限和认证机制保证了数据的安全性。每一个文件和目录在HDFS上都有相应的权限控制,这些权限定义了哪些用户或组可以读取或修改数据。同时,Hadoop使用Kerberos协议进行用户认证,确保只有授权用户能够访问系统资源。

pull操作中的权限检查通常发生在客户端与NameNode通信阶段。当NameNode接收到读取请求时,它会验证发起请求的用户是否具有相应的权限。如果权限验证失败,则操作被拒绝。而认证则是在用户首次登录系统时完成,之后的操作都是基于已经认证的身份进行的。

## 2.2 高级pull操作技巧

### 2.2.1 并行拉取与性能优化

在处理大规模数据集时,单一的数据拉取操作可能会成为瓶颈。为了提高数据的传输速度和效率,Hadoop支持并行拉取策略。这意味着客户端可以同时从多个DataNode获取数据,从而充分利用网络带宽和提高数据检索速度。

并行拉取通过多线程技术实现,客户端会启动多个线程,每个线程负责从不同的DataNode拉取数据。在实现时,需要注意合理设置线程数量,避免因线程过多造成资源竞争和额外的网络开销。

### 2.2.2 处理大规模数据集的策略

处理大规模数据集时,一个重要的优化策略是将数据本地化。数据本地化指的是将计算任务调度到存储数据的节点上执行,这样可以减少网络传输的数据量,显著提高整体性能。Hadoop通过调度策略优化,将计算任务和数据尽可能放在同一个物理节点上。

另一个策略是使用压缩技术。通过压缩数据,在存储和传输过程中可以减少IO开销。但要注意,压缩也会增加CPU的计算负担,因此需要在压缩带来的IO节省和CPU消耗之间找到平衡点。

### 2.2.3 安全性增强的方法

随着对数据隐私和安全的要求越来越高,Hadoop也提供了更多的安全性增强方法。其中,启用心跳加密和数据传输加密是提高安全性的重要手段。心跳加密保证了NameNode与DataNode之间的通信安全,而数据传输加密确保数据在传输过程中不被窃听或篡改。

在实现安全性增强方法时,可能会引入额外的性能开销。因此,在配置安全相关参数时,需要仔细权衡安全性和性能之间的关系,以确保系统既有良好的安全性,又能保持高效运行。

## 2.3 实际案例分析

### 2.3.1 日志文件的高效拉取

日志文件是大数据分析中常见的数据类型之一。为了高效地从HDFS中拉取和分析日志文件,Hadoop社区提供了一些优化手段和工具。例如,使用Apache Flume可以实现实时日志收集,而Apache Sqoop则能高效地将日志数据导入Hadoop集群中。

在实际操作中,可以通过配置合理的文件块大小来优化日志数据的读取效率。小文件块意味着更多的NameNode元数据操作,可能降低性能,而过大的文件块则可能影响并行拉取的效果。

### 2.3.2 非结构化数据处理

非结构化数据,如图片、视频、音频等,通常比结构化数据更难管理和分析。在Hadoop中处理非结构化数据,可以通过使用支持非结构化数据处理的框架来提高效率。例如,Hadoop生态系统中的HBase就是一个支持非结构化数据处理的分布式数据库。

为了有效地从HDFS中拉取非结构化数据,重要的是要实现良好的数据流管理和存储策略。这包括合理地分布数据,以及对数据进行预处理以优化访问速度。Hadoop的高级pull操作可以结合这些技术,实现对非结构化数据的快速有效访问。

# 3. 掌握Hadoop的高级get操作

Hadoop的高级get操作是处理大数据

0

0