数据预处理最佳实践:掌握这些跨领域数据整合策略,让数据更强大

发布时间: 2024-09-07 05:25:46 阅读量: 120 订阅数: 39

# 1. 数据预处理的必要性与挑战

在当今数据驱动的业务环境中,数据预处理是数据科学工作流程中的第一个重要步骤。它涉及到识别原始数据集中存在的问题和不一致性,并采取措施纠正这些问题,以提高数据质量。高质量的数据对于数据建模和分析至关重要,因为如果数据集包含噪声、异常值或者不一致的数据,这将直接影响最终分析结果的准确性。

数据预处理的必要性主要体现在以下几个方面:

- **确保数据质量**:数据质量的好坏直接决定了数据挖掘和分析的质量。数据清洗可以减少数据集中的噪声,提高数据的一致性。

- **提高分析效率**:预处理后,数据集更加规范、整洁,能够提升后续数据分析的效率。

- **减少分析误差**:通过纠正数据中的偏差和错误,可以有效减少模型训练过程中的误差。

然而,数据预处理面临着诸多挑战,例如:

- **数据规模庞大**:随着数据量级的增长,对计算资源的要求也相应提高。

- **数据来源复杂**:多样化的数据来源增加了预处理过程中的复杂度。

- **数据隐私问题**:在处理敏感数据时需要格外注意隐私保护和合规性问题。

在接下来的章节中,我们将探讨数据清洗的方法论、数据集成的关键技术、数据转换与数据规约等更深入的主题,以及跨领域数据整合的实践案例,以确保读者能够全面地理解数据预处理的重要性并掌握相应的技术。

# 2. 数据清洗的基本方法论

## 2.1 数据清洗的概念与目标

### 2.1.1 数据质量的重要性

数据质量是数据科学和数据分析领域的基石。高质量的数据能够提升分析的准确性,增强机器学习模型的预测能力,并能有效地支持决策过程。在企业环境中,不准确或不完整数据可能导致错误的业务决策,造成资源浪费和收益损失。例如,一个零售企业若使用了错误的库存数据进行补货,可能会导致库存不足或过剩,进而影响到现金流和客户满意度。此外,数据质量差还会增加数据分析和维护的成本,从而影响企业整体的运营效率。

### 2.1.2 数据清洗的常见问题

数据清洗过程中常见的问题包括但不限于:缺失值、重复数据、异常值、格式不统一和不一致性等。缺失值可能会导致分析时数据集不完整,进而影响分析结果;重复数据会造成数据冗余,降低数据处理效率;异常值和格式不一致问题可能会让数据处理变得复杂,并影响数据的质量和准确性。为了应对这些问题,数据清洗工作就显得尤为重要。

## 2.2 数据清洗技术的应用

### 2.2.1 缺失值处理技术

缺失值是在数据集中经常遇到的问题,有多种技术可以处理缺失数据:

- **删除法**:简单地删除含有缺失值的记录。这种方法简单但可能会造成大量数据丢失,尤其是当缺失数据比较集中时。

- **填充法**:用统计量(如均值、中位数、众数)填充缺失值。这种方法适用于数值型数据,并假设数据缺失是随机发生的。

- **预测模型法**:使用其他变量建立预测模型来预测缺失值。适用于复杂的数据情况,可以更好地考虑变量之间的关系。

```python

import pandas as pd

from sklearn.impute import SimpleImputer

# 假设df是包含缺失值的DataFrame

imputer = SimpleImputer(strategy='mean') # 使用均值填充

df_filled = pd.DataFrame(imputer.fit_transform(df), columns=df.columns)

```

上述代码使用`SimpleImputer`类来填充缺失值。参数`strategy='mean'`指定了使用均值填充缺失值,适用于数值型数据列。

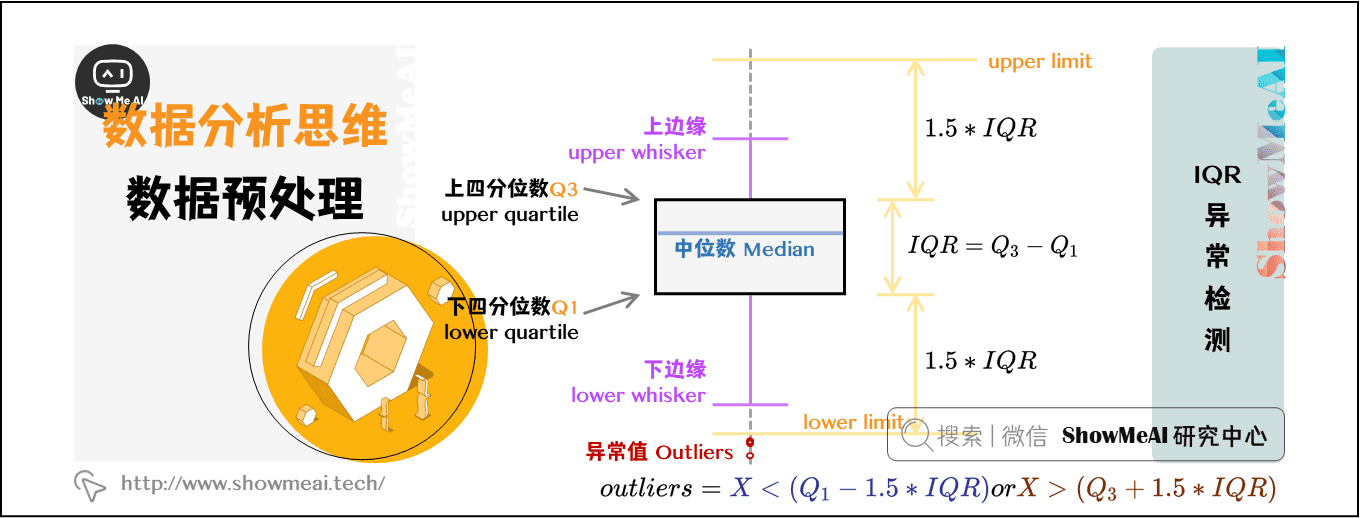

### 2.2.2 异常值检测与处理

异常值指的是那些不符合正常分布或预期范围的数据点。检测和处理异常值的策略包括:

- **统计方法**:例如,使用箱型图来识别异常值,因为异常值通常位于箱型图之外。

- **Z分数法**:计算Z分数,Z分数远离0的点可能就是异常值。

- **基于模型的方法**:如孤立森林(Isolation Forest)或局部异常因子(Local Outlier Factor, LOF),这些方法可以用于检测复杂的模式中的异常值。

```python

from sklearn.ensemble import IsolationForest

# 使用孤立森林检测异常值

iso_forest = IsolationForest(n_estimators=100, contamination=0.01)

predictions = iso_forest.fit_predict(df)

# 标记异常值为-1,正常值为1

df['anomaly'] = predictions

```

### 2.2.3 数据一致性与规范性

数据一致性保证数据在各个系统和应用中保持一致。数据规范性是指数据格式和内容符合预定义的规则。为了实现数据一致性与规范性,可以使用以下技术:

- **数据标准化**:例如,统一日期格式、电话号码格式等。

- **数据编码**:将非数值型数据转换为数值型,以便于分析。

- **参考数据管理**:使用统一的数据源来定义和管理数据实体。

```python

# 示例:使用pandas进行数据标准化

df['phone'] = df['phone'].str.replace(r'\D', '') # 移除非数字字符

```

## 2.3 数据清洗工具的选择与使用

### 2.3.1 传统数据清洗工具

传统数据清洗工具主要基于GUI操作,适合没有编程背景的用户,常见的有Trifacta的Data Wrangler、Microsoft Excel等。

### 2.3.2 现代数据清洗框架

现代数据清洗框架多数基于编程实现,比如Apache NiFi、Talend等,支持大数据量处理,并且可集成至复杂的数据处理流程中。

### 2.3.3 自动化数据清洗流程

自动化数据清洗流程通过编写脚本或使用特定软件工具,能够自动执行多个数据清洗步骤,减少手动操作。例如,Python脚本结合pandas库可以自动化执行数据清洗任务。

```python

# 使用pandas进行自动化的数据清洗流程

def clean_data(df):

# 连续执行多个清洗步骤...

df_clean = df.dropna() # 删除缺失值

df_clean = df_clean[df_clean['feature'] > 0] # 删除特定条件的异常值

return df_clean

# 调用清洗函数

df_clean = clean_data

```

0

0