【序列到序列模型】:TensorFlow构建端到端机器翻译系统

发布时间: 2024-11-22 00:49:45 阅读量: 20 订阅数: 31

# 1. 序列到序列模型概述

## 序列到序列模型简介

序列到序列(Seq2Seq)模型是一种广泛应用于自然语言处理(NLP)领域的神经网络架构,主要用于解决序列转换问题,例如机器翻译、文本摘要生成、语音识别等。这些任务的核心是将一个长度可能不等的输入序列转换成另一个长度不等的输出序列。Seq2Seq模型通常由两部分组成:编码器(Encoder)和解码器(Decoder),通过这种结构,模型能够捕捉输入数据的深层次语义并生成正确的输出序列。

## 编码器与解码器

在Seq2Seq模型中,编码器负责接收输入序列并将其编码成一个内部表示(即上下文向量),这个向量浓缩了输入序列的关键信息。之后,解码器接收这个内部表示,并开始生成输出序列。在翻译任务中,编码器通常是一个循环神经网络(RNN)或其变体,如长短期记忆网络(LSTM)或门控循环单元(GRU),它们能够处理序列数据并记住重要信息。

## 注意力机制的引入

传统的Seq2Seq模型在处理长序列时容易丢失信息,注意力机制(Attention Mechanism)的引入解决了这个问题。注意力机制允许解码器在生成每个输出时,动态地聚焦于输入序列中与当前生成步骤最相关的部分。这提高了模型处理长句子的能力,并且在很大程度上提升了翻译的质量。

```python

# 示例代码块展示如何构建一个简单的Seq2Seq模型结构(不包含具体的实现细节)

class Encoder(tf.keras.Model):

def __init__(self):

super(Encoder, self).__init__()

# 编码器模型内部结构定义(如LSTM层)

def call(self, input_seq, hidden_state):

# 编码过程

return output, hidden_state

class Decoder(tf.keras.Model):

def __init__(self):

super(Decoder, self).__init__()

# 解码器模型内部结构定义(如带有注意力机制的LSTM层)

def call(self, input_step, hidden_state, encoder_output):

# 解码过程

return output, hidden_state

# Seq2Seq模型类

class Seq2SeqModel(tf.keras.Model):

def __init__(self):

super(Seq2SeqModel, self).__init__()

self.encoder = Encoder()

self.decoder = Decoder()

def call(self, input_seq, output_seq):

# 整个Seq2Seq模型的调用流程

pass

```

在上述代码中,我们定义了编码器和解码器的基本结构,以及如何通过这些组件构建一个完整的Seq2Seq模型。尽管实际实现细节较为复杂,但上述代码提供了一个高层次的概览。

# 2. TensorFlow基础

TensorFlow是一个由Google开发的开源软件库,用于进行高性能数值计算,非常适合深度学习和神经网络模型的研究和应用。在本章节中,我们将深入探讨TensorFlow的基础知识,包括其安装与配置、核心概念以及如何构建数据流图。

### 2.1 TensorFlow的安装与配置

#### 2.1.1 TensorFlow环境的搭建

搭建TensorFlow环境涉及一系列步骤,包括安装合适的依赖、选择适合的TensorFlow版本以及配置开发环境。以下是一个基本的安装流程:

1. 确保Python环境已安装,建议使用Python 3.x版本。

2. 安装TensorFlow,可以使用pip进行安装:

```bash

pip install tensorflow

```

这个命令会安装TensorFlow的CPU版本,适用于没有GPU支持的环境。如果你有NVIDIA GPU并安装了CUDA和cuDNN,那么可以安装GPU支持的版本:

```bash

pip install tensorflow-gpu

```

安装完成后,验证TensorFlow是否正确安装:

```python

import tensorflow as tf

print(tf.__version__)

```

执行上述代码应无任何错误,并输出TensorFlow的版本号。

#### 2.1.2 理解TensorFlow的计算图

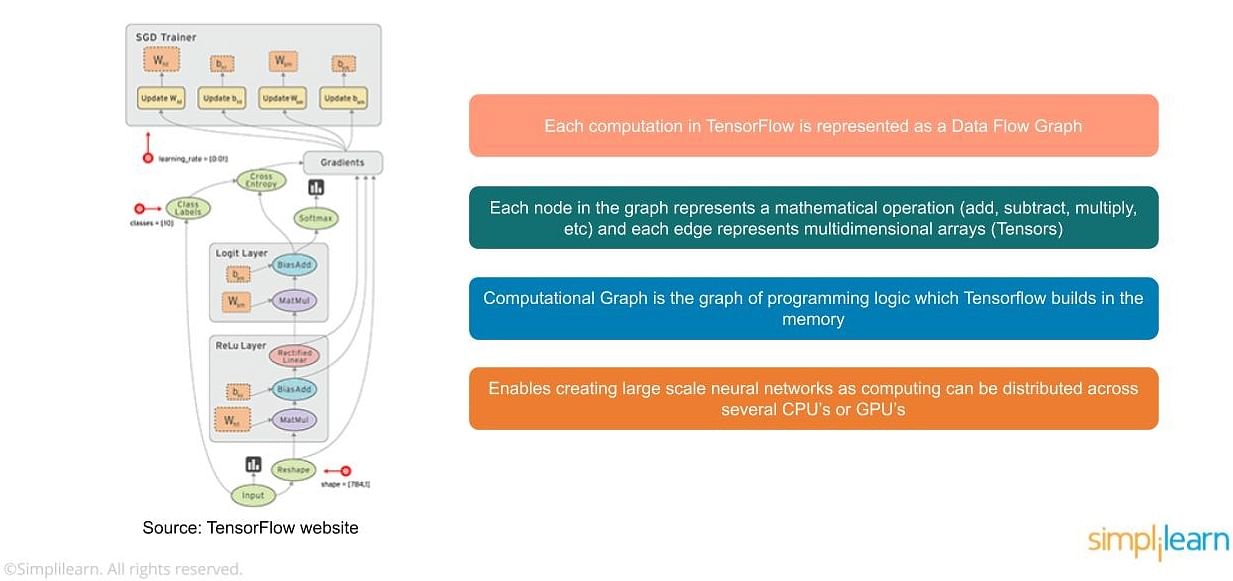

TensorFlow计算图是一种定义计算任务的方式,它由节点(操作)和边(张量)组成,能够实现复杂的数值计算。在TensorFlow中,计算图负责定义如何将计算任务映射到可用的计算资源上。

下面是一个简单的例子来展示TensorFlow计算图的构建:

```python

# 导入TensorFlow库

import tensorflow as tf

# 创建一个常量操作,结果赋值给a

a = tf.constant(2)

# 创建另一个常量操作,结果赋值给b

b = tf.constant(3)

# 创建一个加法操作,将a和b作为输入,结果赋值给c

c = tf.add(a, b)

# 创建一个会话,并在会话中运行计算图

with tf.compat.v1.Session() as sess:

result = sess.run(c)

print(result)

```

运行上述代码将输出:

```

5

```

这说明了计算图中的操作已经被正确地执行了。

### 2.2 TensorFlow核心概念

TensorFlow的核心概念包括张量、操作、变量、占位符和常量。下面将逐一进行介绍。

#### 2.2.1 张量和操作

在TensorFlow中,张量是一个多维数组,可以看作是n维向量。操作是作用于张量上的函数,它定义了如何通过输入张量得到输出张量。例如,加法、乘法等算术运算都是操作。

以下是创建和操作张量的代码示例:

```python

# 创建一个常量操作,是一个2x3的张量

tensor = tf.constant([[1, 2, 3], [4, 5, 6]])

# 创建一个加法操作,将tensor与另一个常量张量相加

sum_tensor = tensor + 10

# 在会话中运行计算图

with tf.compat.v1.Session() as sess:

result = sess.run(sum_tensor)

print(result)

```

该代码将输出:

```

[[11 12 13]

[14 15 16]]

```

#### 2.2.2 变量、占位符和常量

- **变量**:表示可以被训练的参数,用`tf.Variable()`创建,可以在会话中被修改。

- **占位符**:用于在运行时接收外部输入数据,用`tf.compat.v1.placeholder()`创建。

- **常量**:表示常数值,其值在创建后不可更改。

下面是一个涉及变量和占位符的代码示例:

```python

# 创建变量,初始值为0.0

W = tf.Variable(0.0, name="weight")

# 创建占位符,用于输入数据

X = tf.compat.v1.placeholder(tf.float32)

Y = tf.compat.v1.placeholder(tf.float32)

# 定义操作,W乘以X加上Y

output = W * X + Y

# 初始化变量

init = tf.compat.v1.global_variables_initializer()

# 在会话中运行计算图

with tf.compat.v1.Session() as sess:

sess.run(init)

result = sess.run(output, {X: [1, 2, 3], Y: [0.5, 0.5, 0.5]})

print(result)

```

执行该代码将输出:

```

[0.5 1.5 2.5]

```

### 2.3 TensorFlow数据流图的实践

在实践环节,我们将学习如何使用TensorFlow创建一个简单的数据流图,并构建一个基础模型的训练与评估流程。

#### 2.3.1 创建简单的数据流图

接下来的步骤是通过实际代码创建一个简单的线性模型数据流图,并展示如何进行求值。

```python

import tensorflow as tf

# 创建一个占位符用于输入数据,形状为[None, 1],None表示可以接受任意数量的样本,1表示特征数量

X = tf.compat.v1.placeholder(tf.float32, [None, 1])

# 创建一个变量W,初始值为0.0,用于表示模型参数

W = tf.Variable(0.0, name="weight")

# 创建一个变量b,初始值为0.0,用于表示模型偏置

b = tf.Variable(0.0, name="bias")

# 定义模型,y = XW + b

y = tf.add(tf.matmul(X, W), b)

# 定义损失函数,这里使用均方误差

loss = tf.reduce_sum(tf.pow(y - X, 2))

# 定义优化器,这里使用梯度下降优化器,并设置学习率为0.01

optimizer = tf.compat.v1.train.GradientDescentOptimizer(learning_rate=0.01).minimize(loss)

# 初始化所有全局变量

init = tf.compat.v1.global_variables_initializer()

# 创建会话并运行计算图

with tf.compat.v1.Session() as sess:

sess.run(init)

# 假设有一个简单的输入数据和真实值

X_train = [[1], [2], [3]]

Y_train = [[2], [4], [6]]

# 进行3000次迭代训练模型

for epoch in range(3000):

for (x, y) in zip(X_train, Y_train):

sess.run(optimizer, feed_dict={X: x, Y: y})

# 计算训练完毕后的参数值

trained_W, trained_b = sess.run([W, b])

print('训练完毕,W值为:', trained_W, ', b值为:', trained_b)

```

上述代码实现了一个简单的线性回归模型,并使用梯度下降优化器训练了参数。通过迭代,模型参数逐渐接近真实值。

#### 2.3.2 模型的构建与训练流程

TensorFlow通过构建数据流图来定义模型,并通过会话(Session)来执行图中的操作。构建模型的流程通常包含以下几个步骤:

1. 定义输入数据的占位符。

2. 构建模型的前向传播。

3. 定义损失函数。

4. 选择并配置优化器。

5. 初始化模型参数。

6. 使用会话(Session)运行图来训练模型。

下面是一个完整的模型训练流程示例,利用前面创建的

0

0