【反向传播算法】:TensorFlow中的理论与实现深入解析

发布时间: 2024-11-22 00:14:19 阅读量: 22 订阅数: 21

TensorFlow_-_神经网络中前向传播和反向传播解析.zip

# 1. 反向传播算法基础

深度学习的迅猛发展离不开反向传播算法(Backpropagation),这是一种高效计算神经网络参数梯度的方法。在本章,我们将探索反向传播的基础知识,以及它如何在神经网络训练中发挥作用。

## 1.1 理解神经网络中的权重与偏差

在神经网络中,权重(weights)和偏差(biases)是调整模型输出以匹配预期结果的关键因素。权重决定了输入对每个神经元的影响程度,而偏差决定了神经元激活的阈值。反向传播算法通过优化这些参数,使得模型能够更好地适应数据。

## 1.2 误差函数与梯度下降

误差函数(Loss Function),也称成本函数,衡量模型预测与真实值之间的差异。梯度下降(Gradient Descent)是一种优化算法,通过迭代更新权重和偏差,最小化误差函数的值。反向传播负责计算梯度,即误差函数相对于权重的导数,指示着如何调整参数以减少误差。

## 1.3 反向传播的过程与链式法则

反向传播算法利用链式法则来计算复合函数的导数。在神经网络的上下文中,这意味着从输出层开始,逐层向前传播误差的梯度。每个节点的梯度依赖于它的后续节点的梯度和它本身的激活函数。这个过程反复进行,直至网络的输入层。

```mermaid

flowchart LR

A[输入层] -->|前向传播| B[隐藏层1]

B -->|前向传播| C[隐藏层2]

C -->|前向传播| D[输出层]

D -->|计算误差| C'

C' -->|反向传播| B'

B' -->|反向传播| A'

```

通过理解并应用这些基础知识,我们为深入研究反向传播在TensorFlow中的应用奠定了坚实的基础。

# 2. TensorFlow核心概念与架构

### 2.1 TensorFlow的基本组成

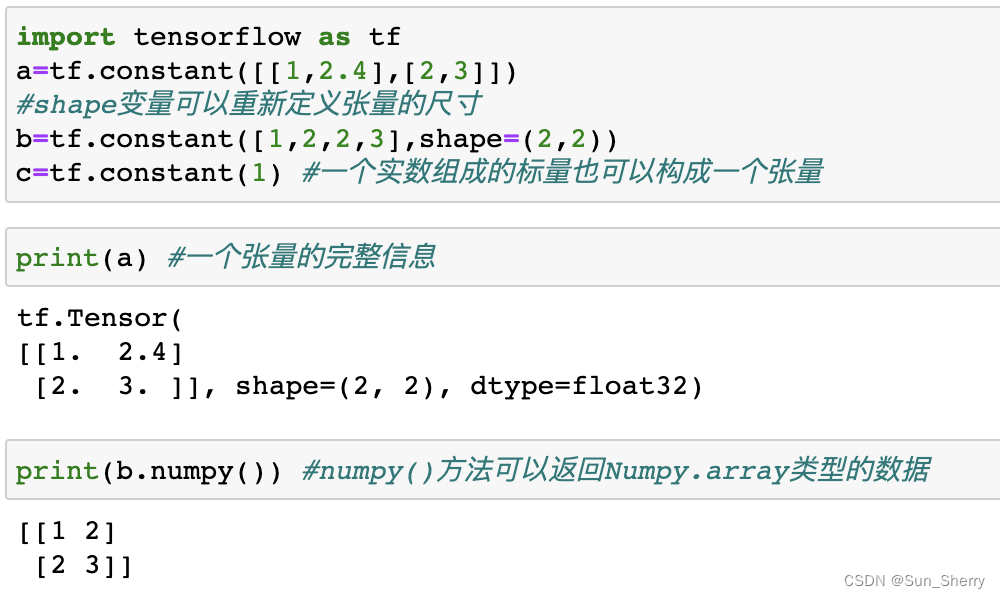

#### 2.1.1 张量(Tensor)与计算图(Graph)

张量(Tensor)在 TensorFlow 中是一个多维数组,可以看作是数据在 n 维空间中的一个点或一个向量。计算图(Graph)则是由张量和操作(Operations,简称Ops)构成的网络,用于表示一系列可被 TensorFlow 执行的计算任务。

```python

import tensorflow as tf

# 创建常量张量

a = tf.constant(2.0)

b = tf.constant(3.0)

c = a * b

# 创建计算图

graph = tf.Graph()

with graph.as_default():

# 在这个子图中定义操作和张量

d = tf.constant(10.0)

e = tf.constant(15.0)

f = d + e

# 获取当前默认图

default_graph = tf.get_default_graph()

print("默认计算图中的节点:", default_graph.get_operations())

```

代码解析:

- 我们首先导入 TensorFlow 库,并创建了两个常量张量 `a` 和 `b`。

- 接着定义了 `c` 为 `a` 和 `b` 的乘积,这也是一个张量,但不是在默认图中创建。

- 为了演示计算图,我们创建了一个新的计算图 `graph` 并进入该图的上下文,创建了额外的常量张量 `d` 和 `e`,以及它们的和 `f`。

- 最后,我们获取了当前默认图并打印了其节点信息。

#### 2.1.2 会话(Session)与执行图

会话(Session)用于执行计算图,它将计算图中的操作映射到实际的计算设备(CPU或GPU)上。我们可以使用会话来运行整个图或者特定的局部图(子图),并获取操作的结果。

```python

# 创建并启动一个会话

with tf.Session(graph=graph) as sess:

print("计算结果:", sess.run(c))

print("计算图中的节点:", graph.get_operations())

print("运行会话中的节点:", sess.graph.get_operations())

```

代码解析:

- 我们使用 `tf.Session` 创建了一个会话,并指定我们想要在其中运行的图 `graph`。

- 然后我们使用 `sess.run` 来执行操作 `c` 并打印结果。

- 最后,我们打印了在创建会话时指定的图的节点、会话当前图的节点,以及执行操作 `c` 后图中的节点。

### 2.2 TensorFlow的数据流图执行机制

#### 2.2.1 静态图与动态图

在 TensorFlow 中,计算图可以分为静态图和动态图两种。静态图(也称为定义时图)在构建阶段就定义了所有操作,它在会话中运行时只能按照定义的结构执行。动态图(也称为即时执行图)则允许在执行时动态构建图结构。

```python

# 静态图示例

a = tf.constant(1)

b = tf.constant(2)

c = tf.add(a, b)

print("静态图的加法结果:", c)

# 动态图示例

def dynamic_graph(x):

y = tf.multiply(x, 2)

return y

# 使用 TensorFlow 1.x API 进行动态构建

with tf.Session() as sess:

x = tf.placeholder(dtype=tf.float32)

result = dynamic_graph(x)

feed_dict = {x: [1, 2, 3]}

print("动态图的计算结果:", sess.run(result, feed_dict))

```

代码解析:

- 静态图示例展示了如何定义和打印一个静态图中的加法操作。

- 动态图示例使用了一个函数 `dynamic_graph`,这个函数会根据输入动态生成乘法操作。

- 在 TensorFlow 1.x 中,我们使用 `placeholder` 来接收外部输入,并在会话中使用 `feed_dict` 传递数据来执行动态图。

#### 2.2.2 TensorFlow中的自动微分

自动微分是机器学习库中的核心功能,TensorFlow 提供了自动微分机制来计算损失函数关于模型参数的梯度,它通过构建的计算图自动完成这一过程。

```python

# 自动微分的简单示例

x = tf.Variable(3.0, name="x")

y = tf.Variable(2.0, name="y")

f = x * x * y + y + 1

# 求 f 关于 x 和 y 的梯度

with tf.Session() as sess:

# 初始化所有全局变量

init = tf.global_variables_initializer()

sess.run(init)

# 计算梯度

grad_x, grad_y = tf.gradients(ys=f, xs=[x, y])

print("f 关于 x 的梯度:", grad_x)

print("f 关于 y 的梯度:", grad_y)

```

代码解析:

- 我们首先创建了两个变量 `x` 和 `y`,然后定义了一个函数 `f`。

- 使用 `tf.gradients` 函数计算了 `f` 关于 `x` 和 `y` 的梯度,它利用了 TensorFlow 内置的自动微分机制。

### 2.3 TensorFlow中的变量管理

#### 2.3.1 变量的初始化与赋值

在 TensorFlow 中,变量需要先初始化才能被赋值和使用。初始化操作通常在会话中执行一次,而变量的赋值和更新则在模型训练过程中持续进行。

```python

# 变量初始化和赋值示例

W = tf.Variable(tf.random_normal([2, 2]), name="weight")

b = tf.Variable(tf.zeros([2]), name="bias")

# 创建一个初始化所有变量的操作

init = tf.global_variables_initializer()

# 创建一个赋值操作,更新变量 W 的值

assign_op = W.assign(tf.ones([2, 2]) * 5)

# 启动会话,并初始化所有变量

with tf.Session() as sess:

sess.run(init)

# 执行赋值操作,W 被更新为 5

sess.run(assign_op)

print("赋值后的 W:", sess.run(W))

```

代码解析:

- 我们首先创建了两个变量 `W` 和 `b`,并为 `W` 指定了一个初始值。

- 使用 `tf.global_variables_initializer` 创建一个初始化所有全局变量的操作。

- 我们还创建了一个赋值操作 `assign_op`,用于更新变量 `W` 的值。

- 在会话中,我们初始化了所有变量,并执行了赋值操作,最后打印出更新后的 `W` 的值。

#### 2.3.2 变量的作用域和生命周期

在 TensorFlow 的计算图中,变量的作用域可以使用 `tf.variable_scope` 来控制。在相同的变量作用域内,变量的名称必须唯一。变量的生命周期从创建时刻开始,到会话结束时结束。

```python

# 变量作用域示例

with tf.variable_scope("scope"):

W1 = tf.get_variable("W", shape=[1, 2], initializer=tf.constant_initializer(1))

W2 = tf.get_variable("W", shape=[1, 3], initializer=tf.constant_initializer(2))

# 尝试创建同名变量会导致错误

# W3 = tf.get_variable("W", shape=[1, 4], initializer=tf.constant_initializer(3))

# 会话中使用变量

with tf.Session() as sess:

sess.run(tf.global_variables_initializer())

# 在相同的变量作用域内,变量 W1 和 W2 可以正常工作

print("W1: ", sess.run(W1))

print("W2: ", sess.run(W2))

# 如果在一个不同的变量作用域内尝试访问 W1 或 W2,则会失败

# print("W1: ", sess.run(tf.get_variable("W", shape=[1, 2])))

```

代码解析:

- 我们在 `with tf.variable_scope("scope"):` 块中创建了两个名为 "W" 的变量,它们具有不同的形状和初始化值。

- 我们还尝试在同一作用域内创建同名的第三个变量,但因为存在冲突而被注释掉。

- 在会话中,我们初始化了所有变量,并尝试访问 `W1` 和 `W2`,并且展示了如何在不同的作用域中正确地访问变量。

总结而言,TensorFlow 的核心概念和架构提供了构建和执行深度学习模型的基础。本章节的内容为理解后续章节,如反向传播算法的实现和性能优化等高级主题奠定了基础。接下来的章节将深入探讨如何在 TensorFlow 中实现反向传播算法,包括构建计算图、损失函数的定义、以及优化器的配置和使用。

# 3. 反向传播算法在TensorFlow中的实现

## 3.1 构建计算图

### 3.1.1 定义操作节点和变量

在TensorFlow中,构建计算图是实现反向传播算法的第一步。计算图由操作节点(Operations)和张量(Tensors)组成。张量可以视为多维数组,而操作节点定义了如何使用输入张量来生成输出张量。在编写计算图时,我们通常定义一系列操作节点来表示复杂的数学运算,例如矩阵加法、乘法和激活函数等。

要构建计算图,我们首先需要初始化一个TensorFlow环境,并创建必要的变量和操作节点。下面是一个简单的计算图构建过程的示例代码:

```python

import tensorflow as tf

# 创建一个常量张量

a = tf.constant(2, name='a')

b = tf.constant(3, name='b')

# 定义一个操作节点,计算两个张量的和

sum = tf.add(a,

```

0

0