深度学习框架中的张量分解:打造无缝工作流的终极指南

发布时间: 2024-12-25 10:23:59 阅读量: 6 订阅数: 11

# 摘要

本文深入探讨了深度学习框架中张量分解的基础知识、理论详解、应用实例以及实践技巧。文章首先介绍了张量分解的数学原理和重要性,随后详细阐述了不同分解方法和算法流程,并讨论了优化技术,包括迭代优化和并行计算。在应用方面,本文着重分析了模型压缩、特征提取和数据预处理三个深度学习关键环节中张量分解的作用。实践中,以TensorFlow、PyTorch和Keras为例,展示了张量分解的具体应用,并提出了高级技巧和避免常见错误的策略。最后,通过案例研究,文章评估了张量分解在深度学习项目中的实际效果,并对未来趋势及工作流发展提出了建议。整篇论文旨在为深度学习领域提供关于张量分解的全面参考和深入见解。

# 关键字

张量分解;深度学习;模型压缩;特征提取;数据预处理;算法优化

参考资源链接:[张量分解入门:CP与Tucker分解解析](https://wenku.csdn.net/doc/7qvu9i9ibd?spm=1055.2635.3001.10343)

# 1. 深度学习框架中的张量分解基础

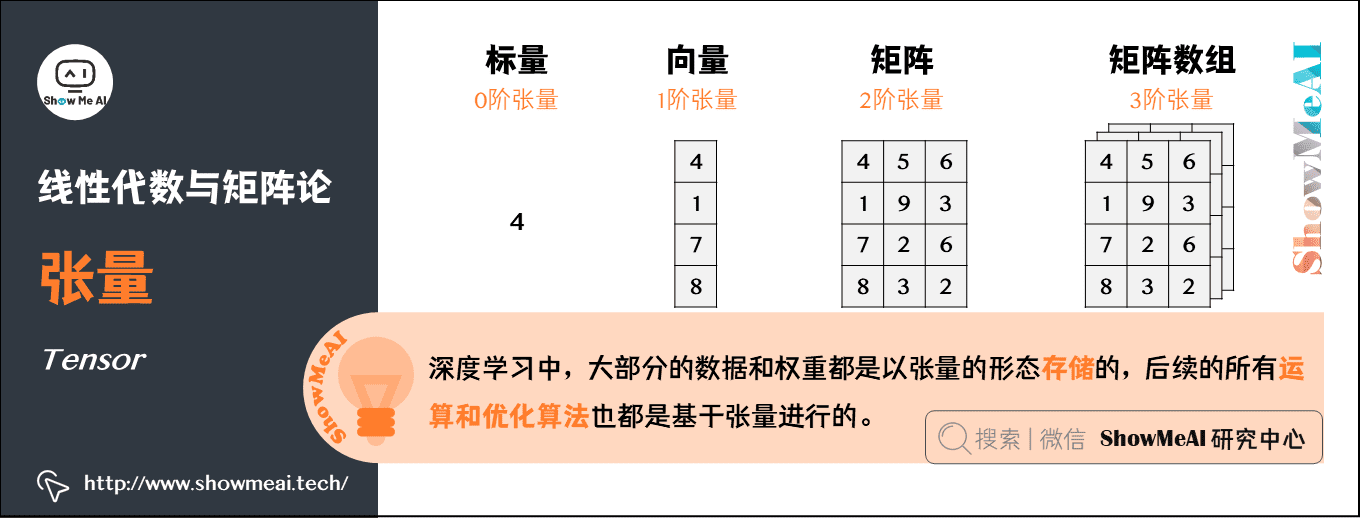

## 1.1 张量分解的基本概念

在深度学习领域,张量分解是处理和压缩高维数据的关键技术之一。简单来说,张量是多维数组,分解则是将高维张量简化为若干低维张量乘积的过程。这在模型训练和推理中尤为重要,因为低维张量能够减少计算成本和内存消耗,提高深度学习模型的运行效率。

## 1.2 张量分解的必要性

随着深度学习模型复杂度的不断增加,数据的维度也随之增长。传统的处理方法会遭遇计算资源的限制。张量分解的必要性在于它允许数据以更精简、高效的形式存储和处理,进而提升算法的性能,尤其是在大规模数据集上的应用。

## 1.3 张量分解的初步应用

在实际应用中,张量分解可以应用于各种深度学习任务,如图像和视频处理、自然语言处理、推荐系统等。它有助于降低模型的复杂性,提高泛化能力,并通过减少模型大小加快部署速度。具体如何操作张量分解,将随着后续章节的深入进行详细探讨。

# 2. 张量分解理论详解

## 2.1 张量分解的数学原理

### 2.1.1 张量分解的概念和重要性

张量分解是多维数组分解的推广,其核心思想是将高维张量分解为低维张量的乘积形式,这种技术广泛应用于信号处理、数据压缩、机器学习等领域。分解后的张量拥有更低的秩,可以减少数据的存储空间和计算成本,同时保留了主要的数据特征和结构信息。

具体而言,对于一个N维张量\( \mathcal{X} \in \mathbb{R}^{I_1 \times I_2 \times \ldots \times I_N} \),张量分解的目标是找到一组核心张量\( \mathcal{G} \)以及一组变换矩阵\( U^{(n)} \),使得\( \mathcal{X} \)近似为以下形式:

\[ \mathcal{X} \approx \mathcal{G} \times_1 U^{(1)} \times_2 U^{(2)} \times \ldots \times_N U^{(N)} \]

核心张量\( \mathcal{G} \)具有较小的阶数,而变换矩阵\( U^{(n)} \)是可逆的。这种分解使得我们可以用更小的张量来表示原始的高维数据。

### 2.1.2 主要的张量分解方法介绍

在张量分解的众多方法中,最重要的有以下几种:

- **CANDECOMP/PARAFAC (CP) 分解**:这种分解方式将张量分解为一系列外积的形式,适用于对称结构的张量。

- **Tucker 分解**:该方法将张量分解为一个核心张量和一组正交矩阵,特别适合于捕捉张量内部的模式和结构。

- **Tensor Train (TT) 分解**:这种分解方式把张量表示为一系列矩阵的乘积,适用于近似对角占优的高维数据。

每一种方法在不同的应用场景下有着不同的优劣,合理选择合适的张量分解方法,对于优化计算效率和保持数据完整性至关重要。

## 2.2 张量分解的算法流程

### 2.2.1 算法选择的考量因素

张量分解算法的选择受到数据性质、计算资源以及分解目标的影响。在选取分解算法时,需考虑以下因素:

- **计算效率**:在有限的计算资源下,算法的运行时间和内存消耗是主要考量。

- **分解精度**:在保留数据特征的同时减少误差,找到合适的误差范围至关重要。

- **可扩展性**:算法能够处理多大尺寸的数据,是否适用于大规模问题。

- **稳定性**:算法在面对不同数据时的鲁棒性和收敛性。

针对不同的应用需求,需要对上述因素进行权衡,选择最适合的张量分解方法。

### 2.2.2 算法的实现步骤和伪代码

以CP分解为例,其算法实现步骤如下:

1. 初始化分解矩阵\( U^{(n)} \)。

2. 通过交替最小二乘法(Alternating Least Squares, ALS)迭代以下步骤,直至收敛:

- 保持\( n \)之外的分解矩阵固定,优化第\( n \)个分解矩阵\( U^{(n)} \)。

- 将张量\( \mathcal{X} \)投影到由\( n \)之外的分解矩阵定义的子空间中。

- 在投影空间中,通过最小化重构误差求解第\( n \)个分解矩阵\( U^{(n)} \)。

3. 重复步骤2,直至满足收敛条件(例如,误差不再显著减少)。

伪代码示例:

```python

def CP-Decomposition(X, rank):

# 初始化分解矩阵U

U = [initialize_matrix(I) for I in X.sizes]

for iteration in range(max_iterations):

for n in range(N): # N是张量维度

# 固定其他分解矩阵,仅优化第n个分解矩阵

U[n] = solve_for_nth_factor(X, U[:n], U[n+1:], rank)

if convergence_check(U, prev_U, threshold):

break

G = reconstruct_tensor(X, U)

return U, G

def solve_for_nth_factor(X, Us, fixed_factors, rank):

# 在这里实现通过求解一个优化问题来找到第n个分解矩阵

# 此处省略优化过程的细节

pass

def reconstruct_tensor(X, U):

# 使用分解矩阵和核心张量重构张量

# 此处省略重构过程的细节

pass

def convergence_check(U, prev_U, threshold):

# 检查分解矩阵是否收敛

# 此处省略收敛判断的细节

pass

```

## 2.3 张量分解的优化技术

### 2.3.1 迭代优化方法

迭代优化方法是实现张量分解的常见技术,包括ALS算法、梯度下降等。ALS算法通过交替优化分解矩阵来逐步减小重构误差,而梯度下降则通过计算损失函数相对于分解矩阵的梯度来直接更新矩阵。

### 2.3.2 并行计算与硬件加速

在处理大规模张量分解时,计算效率至关重要。利用多核处理器和分布式计算资源进行并行化处理,可以在保持精度的前提下显著提高运算速度。

硬件加速技术,如使用GPU进行张量运算,可以进一步提高并行计算的效率。通过专门的库,例如TensorFlow或PyTorch,可以有效地利用GPU进行大规模数据处理。

### 2.3.3 张量分解的参数优化

参数优化是提升张量分解效果的重要手段。通过调整分解算法中的超参数,比如秩的选择、学习率、迭代次数等,可以使得分解结果更符合实际应用需求。在实践中,利用交叉验证、网格搜索等方法来确定最佳的超参数组合。

### 2.3.4 张量分解的软件工具和库

在软件工具和库的支持下,张量分解变得更加方便和高效。常用的库有:

- **NumPy**:提供基础的多维数组操作。

- **TensorFlow** 和 **PyTorch**:不仅支持张量操作,也实现了多种张量分解算法。

- **TensorLy**:一个高级的、用户友好的张量分解库,支持多种分解技术。

代码示例,使用TensorFlow实现CP分解:

```python

import tensorflow as tf

import numpy as np

def cp_decomposition(tensor, rank):

# 随机初始化分解矩阵

U = [tf.Variable(tf.random.normal([tensor.shape[i], rank])) for i in range(len(tensor.shape))]

# 使用TensorFlow的优化器和损失函数进行迭代优化

optimizer = tf.optimizers.Adam(learning_rate=0.01)

```

0

0