时间序列预测模型评估:权威指标与测试方法详解

发布时间: 2024-09-02 22:43:04 阅读量: 100 订阅数: 63

果壳处理器研究小组(Topic基于RISCV64果核处理器的卷积神经网络加速器研究)详细文档+全部资料+优秀项目+源码.zip

# 1. 时间序列预测模型基础

时间序列预测在金融、气象、销售等多个领域有着广泛的应用。理解其基础模型对于预测准确性至关重要。在本章中,我们将介绍时间序列预测的基本概念、主要模型以及它们如何被应用于预测分析中。

首先,时间序列预测模型依赖于历史数据来预测未来值。数据随时间的顺序排列,因此捕捉数据中的趋势和季节性变化至关重要。基本的预测方法包括平滑技术(如简单移动平均SMMA、指数平滑等),以及基于自回归移动平均(ARMA)和自回归积分滑动平均(ARIMA)的统计模型。

接下来,我们将深入探讨模型如何通过识别数据中的规律性变化,包括趋势、周期性和随机性成分,来预测未来的值。这涉及到对时间序列的分解,将数据分为可解释和可预测的部分。在下一章,我们将通过评估指标来分析这些模型的有效性。

时间序列预测模型的搭建需要关注如下几个方面:

- 数据采集:收集与业务或研究目标相关的时间序列数据。

- 数据预处理:包括数据清洗、缺失值处理、异常值检测等步骤。

- 模型选择:根据时间序列的特性(如是否平稳)选择合适的预测模型。

- 参数估计:估计模型中的参数,以使得模型与历史数据拟合得最好。

- 预测与验证:使用模型对未来的数据进行预测,并通过评估指标来验证预测的准确性。

在下一章,我们将详细讨论这些评估指标,并学习如何使用它们来选择和优化时间序列预测模型。

# 2. 评估指标的理论与应用

在时间序列预测中,正确评估模型的性能是至关重要的。评估指标不仅帮助我们了解模型的预测能力,也指导我们如何优化模型以提高准确性。本章节将详细介绍常用的评估指标及其应用,为时间序列预测模型的深入分析打下坚实的基础。

## 2.1 绝对误差度量

绝对误差度量关注的是预测值与真实值之间的绝对差异。这类指标直观且易于理解,广泛应用于各种预测模型的评估。

### 2.1.1 MAE(平均绝对误差)

MAE是预测误差绝对值的平均,其计算公式如下:

```

MAE = (1/n) * Σ|yi - ŷi|

```

其中,`yi` 是真实值,`ŷi` 是预测值,`n` 是样本数量。

MAE对所有单个预测误差的大小具有相同权重,因此它不会放大个别大误差的影响。这使得MAE成为一个稳健的性能指标。

**代码示例:**

```python

from sklearn.metrics import mean_absolute_error

# 假设y_true和y_pred是真实的和预测的值

y_true = [3, -0.5, 2, 7]

y_pred = [2.5, 0.0, 2, 8]

mae = mean_absolute_error(y_true, y_pred)

print(f"MAE: {mae}")

```

### 2.1.2 RMSE(均方根误差)

RMSE是预测误差平方的平均数的平方根,公式如下:

```

RMSE = sqrt((1/n) * Σ(yi - ŷi)^2)

```

与MAE相比,RMSE对较大误差的惩罚更重,这使得它对异常值更加敏感。

**代码示例:**

```python

from sklearn.metrics import mean_squared_error

# 计算RMSE

rmse = mean_squared_error(y_true, y_pred, squared=False)

print(f"RMSE: {rmse}")

```

## 2.2 方向性度量

方向性度量专注于预测值与真实值方向的一致性,即预测值是否正确指出了时间序列的趋势方向。

### 2.2.1 方向准确率(Direction Accuracy)

方向准确率衡量预测值与真实值方向一致的比例,计算公式如下:

```

Direction Accuracy = (正确预测方向的次数 / 总预测次数) * 100%

```

方向准确率是一个非常直观的指标,它直接反映了模型对趋势方向的预测能力。

### 2.2.2 符号测试(Sign Test)

符号测试是一种非参数统计检验方法,用于判断预测值和真实值符号的一致性是否具有统计显著性。该测试通过比较实际观察到的正负符号差异与期望的正负符号差异,来计算P值,以确定是否存在统计显著性差异。

## 2.3 相对误差度量

相对误差度量关注的是预测值相对于真实值的比例误差,有助于评估模型在不同尺度上的预测准确性。

### 2.3.1 MAPE(平均绝对百分比误差)

MAPE是预测误差百分比的绝对值的平均,公式如下:

```

MAPE = (1/n) * Σ(|(yi - ŷi) / yi|) * 100%

```

MAPE的一个显著优点是它将误差标准化为百分比形式,使得不同规模的数据集之间的预测性能可以直接比较。但是,它也有局限性,例如,当真实值接近零时,MAPE会无限大,导致结果不稳定。

### 2.3.2 MPE(平均百分比误差)

MPE与MAPE类似,但不取绝对值,因此它能够显示预测误差的方向。计算公式为:

```

MPE = (1/n) * Σ((yi - ŷi) / yi) * 100%

```

MPE有助于区分模型预测是系统性偏高还是偏低,这对于调整模型具有重要意义。

## 评估指标的选择

选择合适的评估指标对于时间序列预测模型至关重要。MAE和RMSE适合用于连续值的误差测量;方向准确率和符号测试对于评估趋势方向的准确性十分有效;而MAPE和MPE则对于比较不同模型在不同尺度数据集上的性能非常有用。根据具体问题的需求和数据的特点,选择合适的评估指标将为模型优化提供明确的指导。

在实际操作中,一个常见的错误是仅依赖单一评估指标进行模型的评估。由于每个指标都有其固有的局限性,因此综合使用多个指标将能提供更全面的性能评估视角。例如,我们可能首先使用MAE来确定模型预测的基本准确性,然后使用MAPE来评估模型在不同数据集上的一致性,最后使用方向准确率来评价模型对趋势的把握能力。

## 结合使用评估指标

在模型评估和比较中,我们应该结合使用不同的评估指标,以便从多个维度对模型性能进行综合评价。例如,一个模型可能在MAE上表现较好,但在方向准确率上表现不佳。这种情况下,单独使用MAE可能会忽略模型在预测趋势方面的不足。因此,通过结合多种指标来评估模型性能,将有助于我们全面了解模型的优势和不足。

在实践中,模型的选择和优化往往是一个迭代的过程。通过对各种评估指标的综合分析,我们可以调整模型参数,尝试不同的算法,以达到更优的预测结果。最终,选择一个整体性能最佳的模型,并对其进行进一步的测试和部署。

这一系列的评估指标为我们提供了一个全面的分析框架,帮助我们深入理解模型的预测能力,并通过不断优化来提高预测准确性。在接下来的章节中,我们将继续深入探讨模型性能测试方法和高级评估技术。

# 3. 模型性能测试方法

在时间序列预测中,模型性能测试是至关重要的环节。通过选择合适的测试方法,可以全面评估模型的预测能力,确保模型在未来的预测任务中能够达到预期的准确性。本章节将详细介绍三种常见的模型性能测试方法,并探讨它们在不同场景下的应用。

## 3.1 留出法(Holdout Method)

留出法是一种简单直观的模型性能测试方法,它将数据集分为两部分:训练集和测试集。训练集用于模型训练,而测试集则用于评估模型性能。

### 3.1.1 单一留出法

单一留出法是最基本的留出法。在这种方法中,数据集被分为两个部分:大部分用于训练模型,剩余的部分用作测试。测试集的大小通常根据数据集的总量来决定,例如可以是数据集的20%。

```python

from sklearn.model_selection import train_test_split

# 假设df是包含特征和标签的DataFrame

X = df.drop('target', axis=1) # 特征集

y = df['target'] # 标签

# 将数据集分为训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

```

在上述代码中,`train_test_split`函数将数据集分割为训练集和测试集。`test_size=0.2`参数设置测试集大小为20%,`random_state=42`确保每次分割的结果一致。

### 3.1.2 时间序列分割技术

在时间序列数据中,由于数据点具有时间依赖性,简单的随机分割可能不适用。时间序列分割技术考虑了时间的顺序性,按照时间先后进行分割。

```python

import numpy as np

# 假设time_series是一个按时间顺序排列的序列

time_series = np.random.randn(1000)

# 划分训练集和测试集

train_size = int(len(time_series) * 0.8)

train, test = time_series[:train_size], time_series[train_size:]

```

在这个例子中,时间序列被分成训练集和测试集,其中80%的数据点用于训练,剩下的20%用于测试。这种分割保证了模型训练和评估的顺序性和时间依赖性。

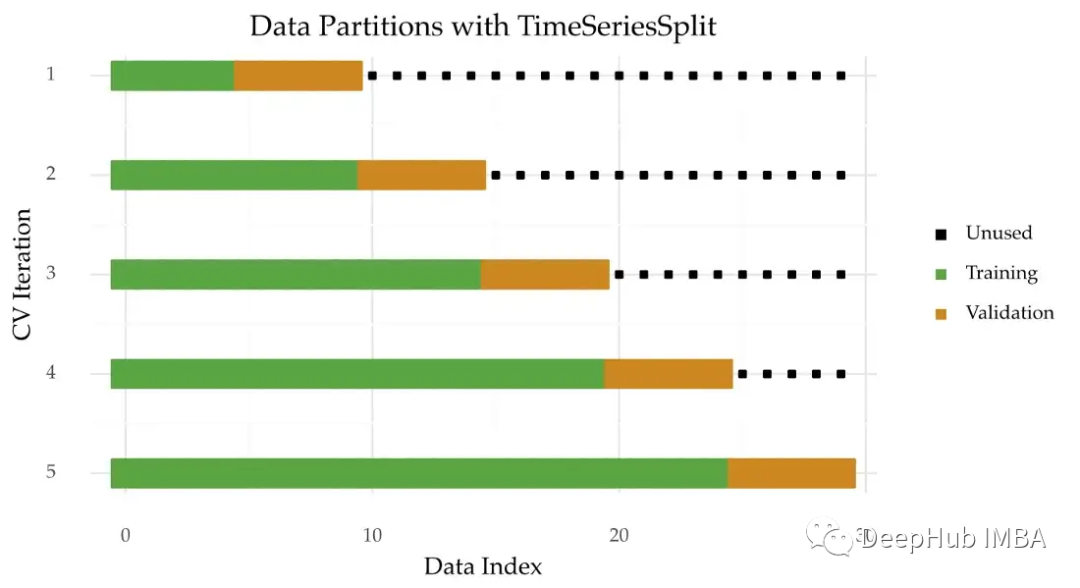

## 3.2 交叉验证法(Cross-validation)

交叉验证法通过多次分割数据集,并且每次使用不同的训练集和验证集来进行模型训练和评估,从而更全面地考察模型性能。

### 3.2.1 简单交叉验证

简单交叉验证也称为K折交叉验证,数据集被分为K个大小相似的子集。每次选择一个子集作为测试集,其余的作为训练集。重复K次,每次都使用不同的子集作为测试集,然后计算K次评估结果的平均值作为模型性能的指标。

```python

from sklearn.model_selection import cross_val_score

# 使用随机森林模型进行交叉验证评估

from sklearn.ensemble import RandomForestRegressor

model = RandomForestRegressor(n_estimators=100, random_state=42)

# 进行10折交叉验证

scores

```

0

0