【深度学习时间序列预测精要】:RNN使用技巧与高级应用

发布时间: 2024-09-02 22:21:14 阅读量: 105 订阅数: 56

# 1. 深度学习与时间序列预测概述

## 1.1 深度学习技术简介

深度学习作为机器学习领域的一个分支,已经成为处理复杂数据和模式识别的核心技术。通过模拟人脑神经网络的工作原理,深度学习算法可以自动学习数据的表示和特征,无需人工设计特征。这种自适应的特征提取能力,让深度学习在图像识别、语音处理和自然语言处理等方面取得了突破性进展。

## 1.2 时间序列预测的重要性

时间序列预测指的是根据历史数据预测未来的数据点或趋势。这项技术在金融、气象、经济、能源等众多领域有着广泛的应用。时间序列预测的目的是从过去和现在的数据中学习规律,从而对未来一段时间内的数据进行合理的预测。准确的时间序列预测对于资源优化配置、风险管理和决策制定等方面至关重要。

## 1.3 深度学习与时间序列预测的结合

深度学习在时间序列预测领域的应用,特别是通过循环神经网络(RNN)及其变体(如LSTM和GRU),使得模型能够处理序列数据的依赖性,捕捉长期的时间动态。与传统的统计学方法相比,深度学习方法在非线性模式识别方面具有独特优势,因此在处理复杂的、高维的时间序列数据时,能够提供更为精准的预测结果。

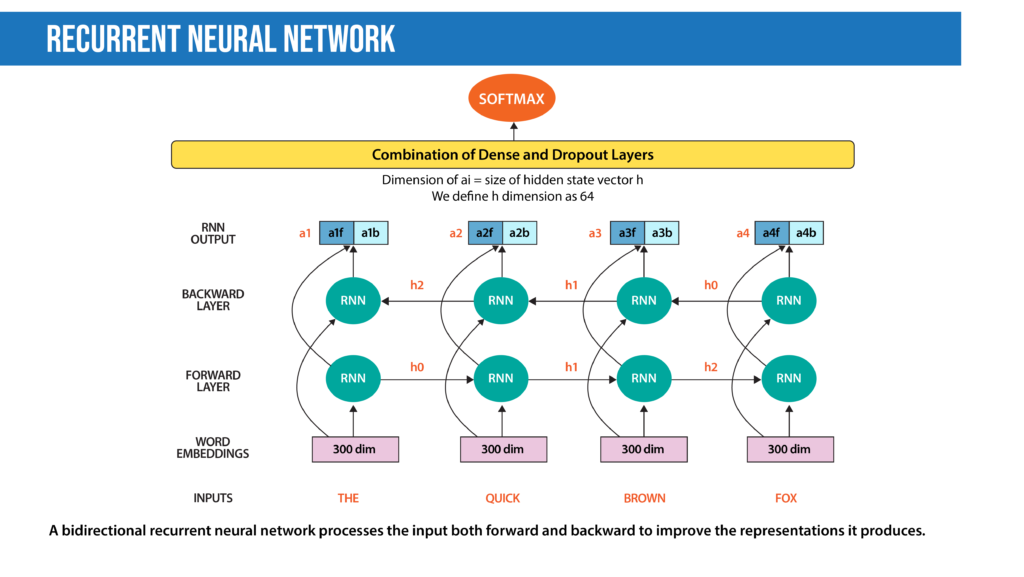

# 2. RNN网络的基本原理与结构

## 2.1 循环神经网络(RNN)基础

### 2.1.1 RNN的工作原理

循环神经网络(Recurrent Neural Networks,RNN)是一种用于处理序列数据的神经网络。在传统的前馈神经网络中,信息是单向流动的,从输入层到隐藏层再到输出层。而RNN的核心特点在于它能够利用自身的记忆来处理序列数据,使得网络在时间上具有了动态特性。

RNN通过引入隐藏状态(hidden state),使得网络可以保存先前信息,并利用这一信息来影响后续的输出。这使得RNN特别适合处理如时间序列数据、自然语言、语音等序列相关的任务。

在每个时间步,RNN接收输入数据和前一时间步的隐藏状态,然后计算出当前时间步的隐藏状态和输出。输出可以是时间步的分类结果,也可以是整个序列的综合表示。数学表达式如下:

$$ h_t = f(h_{t-1}, x_t) $$

这里 $h_t$ 是当前时间步的隐藏状态,$h_{t-1}$ 是前一时间步的隐藏状态,$x_t$ 是当前时间步的输入,$f$ 是一个非线性激活函数。

RNN的隐藏状态维持了一种“状态”,可以理解为一种对序列历史信息的编码。这种状态的更新,即隐藏层的计算,通过循环连接实现,因此得名循环神经网络。

### 2.1.2 RNN与其他神经网络的比较

RNN与传统的前馈神经网络相比,最大的不同在于其能够处理序列数据,而前馈网络无法捕捉到序列间的时间依赖性。

与卷积神经网络(CNN)相比,虽然CNN也可以处理序列数据,但其重点在于通过局部感受野捕捉局部模式,而RNN强调的是时间上的信息传递。

除了标准的RNN,还有几种特殊的循环网络结构,如长短时记忆网络(LSTM)和门控循环单元(GRU),它们被设计用来解决RNN固有的梯度消失和爆炸问题,以及提高对长期依赖关系的建模能力。这些改进的RNN变体在实际应用中更为常见,因其能更有效地训练长时间序列数据。

## 2.2 RNN的数学模型与计算图

### 2.2.1 时间步展开和梯度消失问题

在RNN中,由于隐藏层之间的循环连接,可以将RNN看作是多个相同的神经网络层在时间上串联起来。这种结构上的特点导致了RNN在训练时可以展开成一个非常深的网络,使得梯度在反向传播时需要通过许多时间步传递。当时间步过长时,就会导致梯度消失或梯度爆炸的问题。

梯度消失是指梯度在反向传播过程中,会随着传递距离的增加而指数级减小,导致学习过程变得非常缓慢。梯度爆炸则相反,梯度会指数级增大,导致权重更新不稳定,甚至出现数值溢出的情况。

为了解决这些问题,研究人员提出了多种方法,例如使用梯度剪切技术来限制梯度大小,或者使用更加复杂、专门设计的RNN变体如LSTM和GRU。

### 2.2.2 前向传播与反向传播

前向传播(Forward Propagation)是指RNN在每个时间步接收输入数据,并更新隐藏状态的过程。此过程会一直持续到序列结束。在这个过程中,网络生成输出,并将隐藏状态传递到下一个时间步。

反向传播(Backpropagation)则是通过时间(Backpropagation Through Time,BPTT)的过程。在传统的反向传播中,错误梯度是通过网络的各个层向下传播。但在RNN中,由于网络结构的特殊性,梯度不仅要通过各层,还需要在时间维度上传播。在计算每个时间步的梯度时,会累积前一个时间步的梯度,这一步骤需要递归地重复,直到整个序列结束。

这一过程涉及到链式法则,需要计算每个时间步的局部梯度,并结合前一个时间步的梯度来更新权重。这是通过求解偏导数并应用链式法则来完成的,最终得到在每个时间步需要更新的梯度。

### 2.2.3 RNN变体:LSTM和GRU

由于标准的RNN存在梯度消失和梯度爆炸的问题,研究者们设计了LSTM和GRU这两种特殊的RNN结构,用来更有效地处理长期依赖性。

- **LSTM(Long Short-Term Memory)**:LSTM的设计思想是在每个时间步引入一个门控机制,这些门可以决定信息的保留或遗忘。LSTM有三个门:遗忘门(决定哪些信息要丢弃),输入门(决定哪些新信息被保存到状态中),输出门(决定下一个隐藏状态的输出)。通过这种设计,LSTM能够在序列中保存长期依赖信息,同时避免了梯度消失的问题。

- **GRU(Gated Recurrent Unit)**:GRU可以看作是LSTM的一种简化版本。GRU只使用了两个门:重置门(决定新输入与旧记忆的结合程度),更新门(决定保留多少旧记忆)。GRU的结构比LSTM更简单,但仍然能有效处理长期依赖问题。

这两种变体通过门控机制有效地解决了梯度问题,并且在各种序列预测任务中展现出了卓越的性能。

### 代码块示例:RNN模型的前向传播

假设我们使用Python中的Keras库来定义一个简单的RNN模型,以下是一个简化的代码示例:

```python

from keras.models import Sequential

from keras.layers import SimpleRNN, Activation

# 创建模型

model = Sequential()

# 添加RNN层,假设输入序列长度为10,特征维度为50

model.add(SimpleRNN(64, input_shape=(10, 50), return_sequences=False))

# 添加激活层

model.add(Activation('relu'))

# 编译模型

***pile(loss='mean_squared_error', optimizer='adam')

# 打印模型概况

model.summary()

```

#### 参数说明:

- `Sequential()`:创建一个序列模型。

- `SimpleRNN(64, input_shape=(10, 50), return_sequences=False)`:添加一个RNN层。这里使用了64个神经元,`input_shape`定义了输入数据的形状(时间步长度为10,特征维度为50)。`return_sequences=False`表示只返回每个时间步的最后一个输出。

- `Activation('relu')`:添加一个激活层,使用ReLU作为激活函数。

- `***pile(loss='mean_squared_error', optimizer='adam')`:编译模型,使用均方误差作为损失函数,优化器使用Adam。

#### 逻辑分析:

在这个简单的RNN模型中,我们定义了一个输入序列长度为10,特征维度为50的数据。该RNN层将根据这些数据生成输出,因为`return_sequences=False`,我们得到的是每个时间步的最后一个输出。激活层随后应用ReLU函数,以增加模型的非线性能力。最后,我们通过编译模型指定了损失函数和优化器。

在实际应用中,通常会使用LSTM或GRU层来构建模型,因为它们在许多任务中表现更优,尤其是在序列数据较复杂时。同时,对于多输出任务,我们会设置`return_sequences=True`以保留每个时间步的输出。

# 3. RNN的时间序列预测实践

## 3.1 数据预处理和特征工程

### 3.1.1 数据清洗和标准化

在开始时间序列预测之前,对数据进行彻底的清洗和标准化是至关重要的一步。数据清洗涉及识别和处理异常值、缺失数据、重复记

0

0