【实时语音识别系统】:设计与优化,10大策略助你成功

发布时间: 2024-09-01 23:54:53 阅读量: 170 订阅数: 79

# 1. 实时语音识别系统概述

在数字化浪潮推动下,实时语音识别系统成为人类与计算机沟通的重要桥梁。它能够将人类的语音转换为机器可识别的文本,实现信息的即时处理和交换。实时语音识别不仅仅局限于简单的语音到文本的转换,它还涉及语音信号的处理、语音识别模型的构建、语言模型和解码过程等多个复杂的技术环节。

本章将简要介绍实时语音识别系统的工作原理,包括它是如何捕捉和分析声音,以及如何将声音信号转换为可理解的文本。通过概述这一领域的核心概念和技术,我们将为后续章节更深入的技术讨论和实践应用打下基础。读者将了解到实时语音识别系统在日常生活中常见的应用场景,如智能家居控制、自动翻译服务、客服支持系统等,以及它在提高工作效率、改善用户体验方面所扮演的关键角色。

# 2. 语音识别技术的理论基础

## 2.1 语音信号的处理

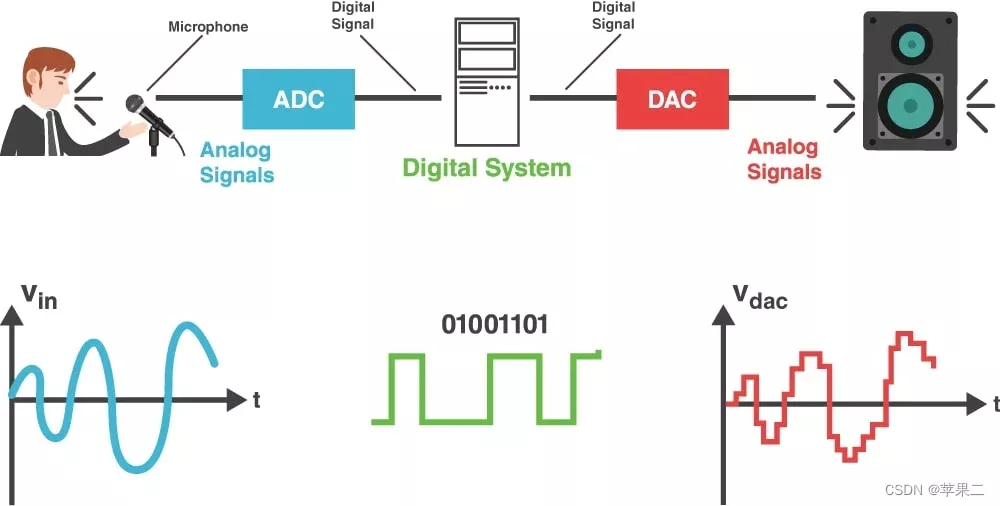

语音信号的处理是语音识别系统中最基础也是至关重要的一步。它涉及到从模拟信号到数字信号的转换,以及如何有效地从信号中提取出可以用于识别的特征。

### 2.1.1 语音信号的采样和量化

首先,声音是一种模拟信号,要想在数字设备上处理,必须通过采样和量化过程转换成数字信号。

- **采样**:根据奈奎斯特定理,采样频率必须是信号最高频率的两倍以上,才能确保信号在采样后不产生混叠失真。在实际应用中,通常会选择一个更高的采样频率来确保信号的质量,例如常见的44.1kHz。

- **量化**:在采样后得到的是模拟值,需要将其转换为数字信号。量化过程是将采样得到的连续幅值转换为离散幅值的过程。量化的精度通常由位数表示,比如8位、16位或24位。位数越高,可以表示的幅值范围越大,量化噪声越小,信号质量也越高。

#### 示例代码块:

```python

import numpy as np

import sounddevice as sd

# 采样函数,获取44.1kHz的16位单声道录音

def capture_audio(duration=5):

recording = sd.rec(int(duration * 44100), samplerate=44100, channels=1, dtype='int16')

sd.wait()

return recording

# 使用示例

audio_data = capture_audio()

```

### 2.1.2 频谱分析与特征提取技术

采样和量化之后,接下来要进行的是频谱分析,主要是通过快速傅里叶变换(FFT)将信号从时域转换到频域。

- **频谱分析**:通过FFT,我们可以得到信号的频谱信息,了解哪些频率成分是主要的,哪些是次要的。

- **特征提取**:基于频谱信息,可以提取出一系列对语音识别有帮助的特征,如梅尔频率倒谱系数(MFCCs)、线性预测编码系数(LPCs)等。这些特征被用于表示语音信号的独特属性。

#### 特征提取代码块与分析:

```python

import librosa

def extract_features(audio_data):

# 提取MFCC特征

mfccs = librosa.feature.mfcc(y=audio_data, sr=44100, n_mfcc=40)

return mfccs

features = extract_features(audio_data)

```

在上述代码中,`librosa`是一个广泛使用的音频处理库,`extract_features`函数使用`librosa.feature.mfcc`方法从音频数据中提取MFCC特征。这些特征随后可用于训练语音识别模型。

## 2.2 语音识别模型的构建

### 2.2.1 统计模型与机器学习方法

在传统的语音识别系统中,主要采用的是基于统计的方法,如隐马尔可夫模型(HMM)。HMM能够对音频序列建模,并通过观察到的音频信号来估计隐藏的状态序列(即语音中隐含的音素序列)。

#### HMM的基本构成:

- 状态:音素或者音素序列。

- 观察序列:音频信号的特征向量。

- 转移概率:从一个状态转移到另一个状态的概率。

- 观察概率:在给定状态下生成某个观察值的概率。

- 初始概率:初始状态的概率分布。

### 2.2.2 深度学习在语音识别中的应用

深度学习技术的引入极大地推动了语音识别技术的发展,特别是卷积神经网络(CNN)和循环神经网络(RNN),包括长短时记忆网络(LSTM)和门控循环单元(GRU)在语音识别中的应用。

#### 深度学习模型的选择与应用:

- **卷积神经网络(CNN)**:擅长捕捉局部特征,常用于特征提取阶段,以减少维度并突出关键信息。

- **循环神经网络(RNN)**:能够处理序列数据,记忆先前的信息,适用于序列建模。

- **长短时记忆网络(LSTM)**:RNN的一种,能够有效避免传统RNN中出现的长期依赖问题。

- **门控循环单元(GRU)**:一种简化版的LSTM,在某些情况下可以提供与LSTM类似的性能,计算成本更低。

## 2.3 语言模型与解码过程

### 2.3.1 语言模型的构建与优化

语言模型在语音识别系统中扮演着重要角色。它根据给定的词序列来计算该词序列出现的概率,从而帮助系统决定最有可能的输出词序列。

- **构建方法**:传统的n-gram模型是构建语言模型的一种常见方法。而随着深度学习的发展,神经网络语言模型逐渐成为主流。

- **优化策略**:平滑技术如拉普拉斯平滑或Kneser-Ney平滑技术被用来处理n-gram模型中的稀疏性问题。

### 2.3.2 解码策略和搜索算法

解码过程涉及搜索算法,目的是在由识别模型和语言模型构成的搜索空间中找到最佳的词序列。

- **搜索算法**:常见的搜索算法包括维特比算法、束搜索(Beam Search)等。

- **优化方法**:动态规划、束调整等技术用于减少搜索空间,提高搜索效率。

### 2.3.3 实例分析:束搜索算法

束搜索算法是一种启发式搜索算法,它可以有效地在语音识别中找到最可能的词序列。在束搜索中,我们维护了一个“束”(或“束宽”),它是一个有限的候选词序列集合,代表了当前阶段最有可能的词序列。

#### 束搜索算法步骤:

1. 初始化:创建一个包含空序列和初始概率的束。

2. 扩展:对于束中的每一个候选序列,计算所有可能的后续音素,并为每个后续音素生成新的候选序列。

3. 排序和剪枝:根据联合概率(语言模型概率和声学模型概率的乘积)对所有候选序列进行排序,并只保留概率最高的若干个。

4. 终止:如果候选序列达到了句子结束标记或束宽限制,则停止搜索,否则返回步骤2。

束搜索算法的优化包括调整束宽、减少搜索深度、实施剪枝策略等,以降低计算复杂度和提高搜索效率。

通过结合上述章节内容,我们可以看到,在构建实时语音识别系统时,从语音信号处理到构建有效的语音识别模型,再到最终解码与语言模型的应用,每一步都至关重要。这些理论基础为我们提供了实现高质量语音识别系统的坚实基础,而在下一章节中,我们将着重介绍如何在实践中构建这样的系统。

# 3. 实时语音识别系统的构建实践

在现代IT领域,实时语音识别系统已经成为很多应用的核心组件,例如智能助理、实时翻译服务和语音控制系统等。构建一个实时语音识别系统不仅需要深入理解语音识别的基础理论,更需要实践中的具体实现。这一章将深入探讨如何实际构建一个实时语音识别系统,涵盖从选择合适的语音识别引擎,处

0

0