urllib.parse解析秘籍:URL解析不求人,5分钟快速入门

发布时间: 2024-10-11 18:49:59 阅读量: 15 订阅数: 16

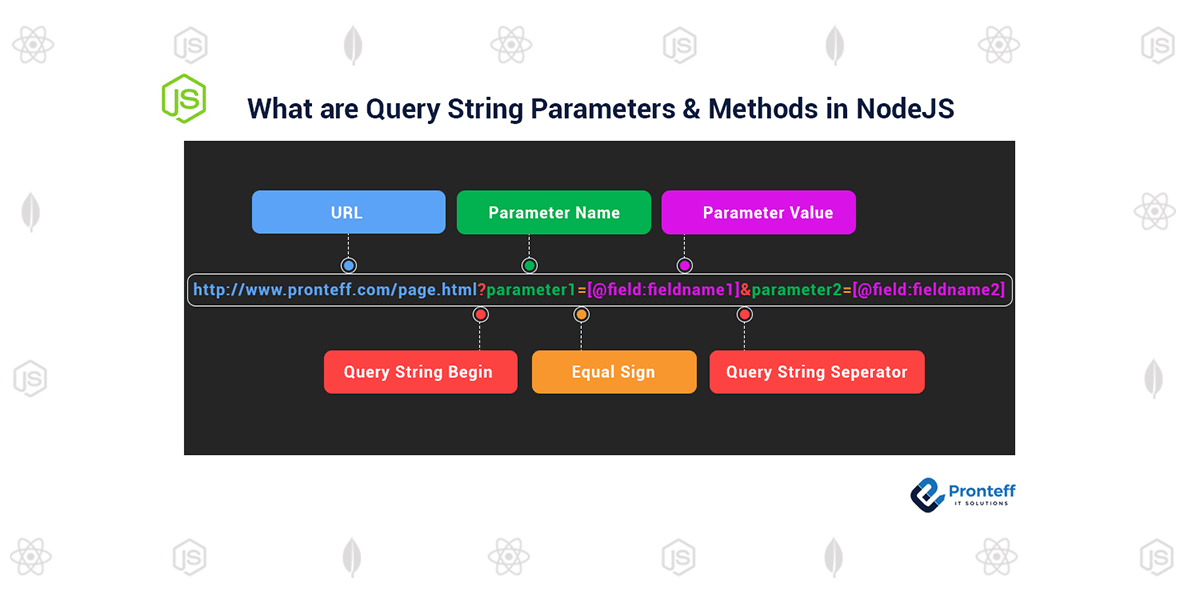

# 1. URL解析的基本概念

在互联网的世界里,统一资源定位符(Uniform Resource Locator, URL)是用于在Web上定位资源的唯一地址。理解URL的结构和组成部分对于开发者来说至关重要,因为它涉及到网络请求、资源获取、安全验证等多个方面。

URL通常由以下几个主要部分组成:

- 协议(Scheme):如`http`, `https`, `ftp`等,指定访问资源所使用的协议类型。

- 主机(Host):通常是一个域名(如`***`)或IP地址,指示资源所在的服务器。

- 端口(Port):(可选)指定服务器上资源的端口号,默认值依赖于协议。

- 路径(Path):指定服务器上资源的具体位置。

- 查询(Query):(可选)以`key=value`的形式附加查询参数,多个参数通过`&`连接。

- 锚点(Fragment):(可选)指定资源内部的一个位置,以`#`开头。

例如,在URL `***` 中,`https` 是协议,`***` 是主机,`443` 是端口,`/path/to/resource` 是路径,`query=value` 是查询字符串,而`section` 则是锚点。

理解URL的这些组成部分有助于正确解析和使用URL,为进行有效的网络通信打下基础。

# 2. urllib.parse模块的结构和功能

urllib.parse模块是Python标准库的一部分,专门用于解析URLs。本章节我们将深入探讨urllib.parse模块的结构和功能,帮助读者理解如何使用该模块来分解和重组URL。

## 2.1 urllib.parse模块的组成部分

urllib.parse模块主要由以下几个部分组成:

### 2.1.1 parse函数

parse函数是urllib.parse模块的核心,它可以将URL分解为其组成部分。例如,它会将一个URL分解为scheme(协议)、netloc(网络位置)、path(路径)、params(参数)、query(查询字符串)和fragment(片段标识符)。

```python

from urllib.parse import parse_qs, urlparse

url = "***"

parsed_url = urlparse(url)

query = parse_qs(parsed_url.query)

```

在上面的代码中,`urlparse`函数将URL分解为组成部分,`parse_qs`将查询字符串解析为字典。

### 2.1.2 unquote函数

unquote函数用于将URL中的百分号编码转换为普通字符。例如,将"%20"转换为空格。

```python

from urllib.parse import unquote

encoded_url = "***"

decoded_url = unquote(encoded_url)

```

在上述代码中,`unquote`函数将编码的URL转换为原始URL。

## 2.2 urllib.parse的功能详解

### 2.2.1 分解URL的各个组成部分

urllib.parse模块可以将URL分解为其基本组成部分。这有助于分析和理解URL的结构。

```python

from urllib.parse import urlparse

url = "***"

parsed_url = urlparse(url)

scheme, netloc, path, params, query, fragment = parsed_url

```

在上述代码中,`urlparse`函数将URL分解为各个组成部分。

### 2.2.2 合成URL的不同部分

urllib.parse模块还可以将分解后的URL各部分重新组合成完整的URL。

```python

from urllib.parse import urlencode, urlunparse

query = {'name': 'ferret', 'color': 'purple'}

query_string = urlencode(query)

url = urlunparse(('http', '***', '/path/to/file.txt', '', query_string, ''))

```

在上述代码中,`urlencode`函数将字典转换为查询字符串,`urlunparse`函数将URL的各部分重新组合。

### 2.2.3 URL编码与解码

URL编码与解码是处理URL的重要环节,尤其是在处理查询参数时。

```python

from urllib.parse import quote, quote_plus

original_url = "***测试"

encoded_url = quote(original_url)

encoded_plus_url = quote_plus(original_url)

```

在上述代码中,`quote`函数对URL进行百分号编码,而`quote_plus`函数除了进行百分号编码外,还将空格转换为加号。

通过本章节的介绍,我们了解了urllib.parse模块的基本结构和功能。下一章节我们将深入探讨urllib.parse模块在实际应用中的案例,包括解析网站URL参数、构建和重构URL以及处理网络请求中的URL。

# 3. urllib.parse的实际应用案例

## 3.1 解析网站URL参数

### 3.1.1 从URL中提取查询参数

在处理Web请求时,我们经常需要从URL中提取查询参数。例如,当我们访问一个网页时,浏览器地址栏中的URL可能会包含一个查询字符串,如`***`。我们可以使用`urllib.parse`模块中的`parse_qs`和`parse_qsl`函数来解析这些参数。

```python

from urllib.parse import parse_qs, parse_qsl

url = '***'

parsed_params = parse_qs(urlparse(url).query)

print(parsed_params)

# 输出:{'param1': ['value1'], 'param2': ['value2']}

parsed_params_list = parse_qsl(urlparse(url).query)

print(parsed_params_list)

# 输出:[('param1', 'value1'), ('param2', 'value2')]

```

在这段代码中,`parse_qs`函数返回一个字典,其键是查询参数的名称,值是参数值的列表。这适用于单值参数和多值参数。另一方面,`parse_qsl`函数返回一个参数值的列表,每个元素是一个(键,值)对,这在需要顺序信息时非常有用。

### 3.1.2 修改和创建查询参数

解析参数后,我们可能需要根据应用程序的逻辑修改或创建新的查询参数。修改参数可以通过字典操作简单完成,而创建新的参数则需要将修改后的参数重新编码为查询字符串。

```python

# 修改已存在的参数

params = {'param1': ['value1'], 'param2': ['value2']}

params['param2'][0] = 'newvalue'

# 添加新的参数

params['param3'] = 'value3'

# 使用urlencode重新编码查询字符串

from urllib.parse import urlencode

new_query_string = urlencode(params)

print(new_query_string)

# 输出:param1=value1¶m2=newvalue¶m3=value3

```

通过以上步骤,我们可以从原始URL中提取查询参数,根据需要修改它们,并创建一个新的查询字符串。这对于动态地处理Web请求非常有用。

## 3.2 构建和重构URL

### 3.2.1 使用 urllib.parse重构URL

重构URL意味着在保持URL组件关系的基础上修改某些部分。我们可以利用`urlparse`和`urlunparse`函数来实现这一点,它们分别用于解析和重构URL组件。

```python

from urllib.parse import urlparse, urlunparse

# 假设有一个基础URL和新的参数

base_url = '***'

new_params = {'newparam': 'newvalue'}

# 解析基础URL

parsed_base = urlparse(base_url)

# 构建新的路径和参数

new_path = parsed_base.path

new_query = urlencode(new_params).encode('utf-8') # 必须编码

# 重构URL

components = list(parsed_base)

components[2] = new_path

components[4] = new_query

new_url = urlunparse(components)

print(new_url)

# 输出:***

```

重构URL的过程涉及到对URL组件的理解和操作,`urlparse`函数将URL分解为多个组件,然后通过更改这些组件中的一个或多个来构建新的URL。之后,`urlunparse`函数将这些组件重新组合成一个完整的URL。

### 3.2.2 防止URL的注入和安全问题

在处理用户输入以构建URL时,我们需要考虑防止注入攻击和维护URL安全。注入攻击是指恶意用户通过URL输入传递额外的参数或命令,可能导致数据泄漏、服务器拒绝服务等安全问题。

```python

# 安全地添加用户输入的查询参数

user_input = 'user;drop+table'

safe_input = urllib.parse.quote(user_input)

params = {'user_input': safe_input}

query_string = urlencode(params).encode('utf-8')

components = list(urlparse(base_url))

components[4] = query_string

safe_url = urlunparse(components)

print(safe_url)

# 输出:***

```

在这里,使用`urllib.parse.quote`函数对用户输入进行URL编码,防止注入攻击。编码后,任何特殊字符都会被转换为安全的URL格式,从而确保URL不会被恶意修改。

## 3.3 处理网络请求中的URL

### 3.3.1 在HTTP请求中处理URL

在网络请求中处理URL需要考虑如何构建请求的URL,并处理响应中的重定向。我们通常使用`urllib.request`模块中的`Request`类来发送HTTP请求。

```python

from urllib.parse import urlparse

from urllib.request import Request, urlopen

url = '***'

req = Request(url)

# 发送请求并获取响应

response = urlopen(req)

data = response.read()

# 处理响应中的URL

parsed_response_url = urlparse(response.geturl())

print(parsed_response_url)

```

在上述代码中,我们创建了一个HTTP请求,并使用`urlopen`发送它。响应对象包含了一个`geturl`方法,该方法返回最终访问的URL。这在处理重定向时非常有用。

### 3.3.2 理解与使用URL重定向

网络请求中常常遇到URL重定向的情况,服务器将请求从一个URL转发到另一个URL。了解和正确处理重定向对于确保应用程序的行为符合预期至关重要。

```python

from urllib.parse import urlparse

from urllib.request import Request, urlopen

# 创建请求对象

url = '***'

req = Request(url)

# 发送请求

response = urlopen(req)

final_url = response.geturl()

# 分析重定向的URL

print(urlparse(final_url).path)

# 输出重定向目标的路径部分

```

在这个例子中,尽管初始请求的URL是`***/redirect`,但服务器可能会将请求重定向到另一个URL,例如`***/resource`。使用`response.geturl()`可以获取重定向后的最终URL,确保应用程序处理的是正确的资源地址。

以上例子展示了如何在使用`urllib.parse`模块处理URL时,针对不同的应用场景采取不同的策略和方法。通过合理的应用,我们可以确保在解析、修改和重构URL时能够有效地管理和维护网络请求。

# 4. 高级URL解析技巧与误区

在处理URL时,开发者经常会遇到需要进行复杂查询参数处理的情况,同时也需要规避一些常见的误区。本章节将深入探讨这些高级技巧和常见的错误思维。

## 4.1 高级查询参数处理

### 4.1.1 复杂查询字符串的解析

在实际开发中,我们经常需要处理具有复杂结构的查询字符串。例如,嵌套的查询参数、数组格式的参数,以及带有特殊字符的参数。这类查询字符串的解析通常涉及到递归或者迭代的算法。

```python

from urllib.parse import parse_qs, urlencode

# 示例URL字符串

query_string = "name=John&age=30&friend=Bob&friend=Alan&cars=Mercedes&cars=BWM"

# 解析查询字符串

parsed_query = parse_qs(query_string)

# 输出解析结果

print(parsed_query)

# 重新编码查询字符串(保持原有的空格和特殊字符编码)

encoded_query = urlencode(parsed_query, doseq=True)

# 输出编码后的查询字符串

print(encoded_query)

```

解析后的字典 `parsed_query` 将允许我们访问每个参数的不同值,例如 `parsed_query['friend']` 将会返回列表 `['Bob', 'Alan']`。注意到这里使用了 `doseq=True` 参数,在重新编码时保留了列表结构,这对于处理数组格式的查询参数非常有用。

### 4.1.2 查询参数的编码与验证

当处理从外部来源接收到的数据时,验证和编码查询参数是十分关键的步骤,因为这直接关联到数据的安全性和准确性。验证参数确保它们符合预期的格式,而编码是为了防止注入攻击和保证URL的结构正确。

```python

from urllib.parse import quote, unquote

# 从用户输入中获取参数值(潜在危险)

user_input = "\"--alert\""

# 避免注入攻击,使用quote对特殊字符进行编码

safe_input = quote(user_input)

# 输出编码后的安全字符串

print(safe_input)

# 确保在发送请求前,对字符串进行解码和验证

unquoted_input = unquote(safe_input)

# 输出解码后的字符串

print(unquoted_input)

```

在这个例子中,我们展示了如何对用户输入进行编码来避免潜在的注入攻击。在实际应用中,你应该使用额外的逻辑对输入进行验证,确保它们符合预定的格式或类型。

## 4.2 解析URL的常见误区

### 4.2.1 忽略的编码问题

解析URL时,可能会忽视编码问题,尤其是对于国际化的字符或特殊字符。这可能导致数据丢失或者解析错误。

```python

from urllib.parse import unquote

# 带有国际化字符的URL

url_with_special_chars = '***名字'

# 错误地解析URL(忽略编码)

incorrect_parse = unquote(url_with_special_chars).split('/')

# 输出结果可能会包含乱码

print(incorrect_parse)

# 正确地解析URL(保留编码)

correct_parse = unquote(url_with_special_chars).split('/')

correct_parse_decoded = [unquote(part) for part in correct_parse]

# 输出结果将正确显示

print(correct_parse_decoded)

```

当处理包含国际化字符的URL时,正确地进行编码和解码至关重要,以确保数据的准确性和一致性。

### 4.2.2 盲目信任解析结果的风险

另一个常见的错误是开发者可能会盲目地信任解析结果,而没有做进一步的验证。在实际应用中,需要考虑到URL可能被篡改,或者解析库存在缺陷。

```python

import re

# 解析得到的参数

params = {"name": "John", "age": "30"}

# 检查参数是否有效

if re.match("^[A-Za-z0-9]+$", params.get('name', '')) and int(params.get('age', 0)) > 0:

print("参数验证通过")

else:

print("参数验证失败")

```

在这个例子中,我们使用正则表达式来验证名称是否只包含字母和数字,以及年龄是否为有效的正整数。这样的验证步骤能够降低因信任解析结果而导致的安全风险。

# 5. urllib.parse的错误处理与调试

在处理URL解析时,错误处理和调试是不可或缺的两个环节。无论多么完善的代码,总会遇到一些异常情况或者需要进一步优化的环节。本章将会探讨在使用urllib.parse模块进行URL解析过程中,如何有效地处理异常情况,并分享一些实用的调试技巧,以便于开发者能够更加自信地编写和维护代码。

## 5.1 异常处理机制

### 5.1.1 理解异常类型和触发条件

在使用urllib.parse进行URL操作时,可能会遇到各种各样的异常。这通常发生在以下几个场景:

- 输入的URL不符合URL规范;

- URL组件被错误地编码或解码;

- 网络请求中遇到网络问题或服务器错误。

为了更好地理解和处理这些异常,我们先来看看urllib.parse可能抛出的一些常见异常:

```python

from urllib.parse import urlparse, urlunparse, parse_qs

# 假设这是需要解析的URL

url = '***'

try:

result = urlparse(url)

# 在这里可能会抛出异常,比如ValueError

except ValueError as e:

print(f'ValueError: {e}')

```

上述代码尝试解析一个URL,由于查询参数中的`age`被重复赋值,可能会引发异常。因此,我们需要明确知道哪些操作会引发异常,并准备相应的处理逻辑。

### 5.1.2 有效的错误处理策略

对于可能出现的异常,我们需要采取一系列有效的策略来应对。通常,我们可以采取以下步骤:

1. 使用try-except语句捕捉异常;

2. 针对不同类型的异常,编写不同的处理逻辑;

3. 尽可能提供有用的错误信息和建议的修复方法。

下面是一个更具体的例子,展示了如何在解析URL时进行异常处理:

```python

from urllib.parse import urlparse

url = '***'

try:

result = urlparse(url)

print(result)

except Exception as e:

# 记录错误日志

print(f'Error while parsing URL "{url}": {e}')

```

在这个例子中,如果`urlparse`因为某种原因失败了,我们捕捉到了异常,并向用户打印出了一条错误信息。

## 5.2 调试技巧和日志记录

### 5.2.1 设置日志记录解析过程

在开发中,日志记录是一个非常有用的调试工具。它可以帮助我们跟踪程序的运行情况,了解代码在什么情况下被执行,以及程序执行时的状态。在urllib.parse模块的使用中,我们可以使用Python标准库中的`logging`模块来记录日志。

下面是如何在使用urllib.parse模块时记录日志的示例:

```python

import logging

from urllib.parse import urlparse

# 设置日志记录器

logging.basicConfig(level=***, format='%(asctime)s - %(levelname)s - %(message)s')

url = '***'

try:

result = urlparse(url)

***(f'URL parsed: {result}')

except Exception as e:

logging.error(f'Error parsing URL "{url}": {e}')

```

在这个例子中,我们将日志级别设置为INFO,意味着所有INFO级别及以上(例如WARNING或ERROR)的日志信息都会被记录下来。在日志中,我们记录了解析URL的操作结果或错误信息。

### 5.2.2 使用调试工具和技巧

除了日志记录,有时候我们还需要进一步地调试程序。这时可以使用Python的调试器pdb,或者集成开发环境(IDE)提供的调试工具。这些工具允许我们逐步执行代码,观察变量的值,以及判断程序的执行流程。

以pdb为例,我们可以通过以下方式使用它来调试urllib.parse模块的使用:

```python

import pdb

from urllib.parse import urlparse

url = '***'

pdb.set_trace()

result = urlparse(url)

print(result)

```

在这个例子中,我们通过`pdb.set_trace()`设置了断点,程序会在执行到这一行时暂停。随后我们可以使用pdb提供的命令(如`n`(next),`c`(continue)等)来逐步执行代码,并检查变量和程序状态。

**表格:常见urllib.parse模块异常类型及处理建议**

| 异常类型 | 触发条件 | 处理建议 |

|----------------|----------------------------------------------|----------------------------------------------------------|

| ValueError | 输入的URL不符合标准规范或格式错误 | 检查输入URL的格式,确保其符合标准规范。 |

| UnicodeEncodeError | 编码字符串时遇到无法编码的字符 | 确保使用正确编码,或在编码前对字符串进行清洗和预处理。 |

| UnicodeDecodeError | 解码字节序列时遇到无法解码的字节序列 | 检查输入数据源,确保数据是正确的编码格式。 |

| HTTPError | 网络请求失败时触发 | 使用异常处理来捕获错误并根据错误代码提供相应的处理逻辑。 |

| URLError | URL无法解析或存在网络问题时触发 | 检查网络连接状态,并在必要时提供重试逻辑。 |

在本章中,我们介绍了如何使用urllib.parse模块进行URL解析时进行有效的错误处理与调试。通过理解和掌握异常处理机制,以及利用日志记录和调试工具,开发者可以更加有效地解决编码中的问题,并优化代码的稳定性和健壮性。这不仅能够提高开发效率,还能在出现问题时快速定位问题原因,减少维护成本。

# 6. 未来展望和最佳实践

## 6.1 新兴标准和库的介绍

### 6.1.1 了解最新URL解析规范

随着互联网的迅速发展,URL解析标准也在不断进化,以适应新的技术要求和用户需求。开发者需要关注最新的RFC文档,了解URL结构中可能出现的新组件以及对现有组件的修改。例如,RFC 3986是当前广泛使用的URL解析标准,它定义了URL的通用结构并为组件定义了语法规则。

除了官方标准,社区中也有新的库和工具不断涌现,它们提供了更丰富的功能以及更灵活的使用方式。一些新兴的JavaScript库如`url`和`query-string`,就提供了一些额外的工具函数来处理查询字符串的序列化和反序列化,以及URL的解析和格式化功能。

```javascript

// 示例:使用query-string库解析查询字符串

const queryString = require('query-string');

const queryParams = queryString.parse(window.location.search);

// 输出查询参数

console.log(queryParams);

```

### 6.1.2 探索其他解析库的可能性

在某些情况下,标准库可能无法完全满足你的需求,这时探索其他的第三方库就显得尤为重要。例如,对于更复杂的应用场景,如爬虫开发,你可能会考虑使用专门的库如`Scrapy`,它提供了内置的URL解析器,可以方便地处理各种复杂的链接。

```python

# 示例:使用Scrapy的LinkExtractor提取链接

from scrapy.linkextractors import LinkExtractor

link_extractor = LinkExtractor(allow=r'/page\d+')

links = link_extractor.extract_links(some_response)

for link in links:

print(link.url)

```

## 6.2 将urllib.parse纳入开发最佳实践

### 6.2.1 编写可读性强的URL解析代码

编写可读性强的代码是提高开发效率和减少错误的关键。在使用`urllib.parse`时,应该遵循一些编码规范和最佳实践,比如合理使用括号、确保缩进正确,并且适当添加注释说明代码功能。此外,命名变量时尽量使用有意义的名称,这样在代码阅读和维护时,其他开发者能够快速理解代码意图。

```python

from urllib.parse import urlparse, parse_qs

def extract_query_params(url):

"""解析URL中的查询参数"""

parsed_url = urlparse(url)

query_params = parse_qs(parsed_url.query)

return query_params

# 示例使用

params = extract_query_params('***')

print(params)

```

### 6.2.2 遵循行业内的URL处理标准

在开发过程中,除了遵循Python官方文档中的规范,还应该遵循行业内最佳实践。这包括对URL的处理标准,比如在构建URL时应考虑到SEO最佳实践,以及如何处理各种异常情况。例如,当设计Web API时,按照RESTful标准来设计URL可以让API更加清晰易用。

此外,还应该考虑URL的安全性,比如对用户输入的URL进行适当的验证,防止恶意用户利用解析过程中的漏洞来执行不安全的操作。在处理URL时,应该对其进行严格的验证,以防止注入攻击和跨站脚本攻击(XSS)。

```python

# 示例:使用正则表达式验证URL格式

import re

def validate_url(url):

"""验证URL是否符合标准格式"""

regex = ***pile(

r'^(?:http|ftp)s?://' # ***

*'(?:(?:[A-Z0-9](?:[A-Z0-9-]{0,61}[A-Z0-9])?\.)+(?:[A-Z]{2,6}\.?|[A-Z0-9-]{2,}\.?)|' # domain...

r'localhost|' # localhost...

r'\d{1,3}\.\d{1,3}\.\d{1,3}\.\d{1,3}|' # ...or ipv4

r'\[?[A-F0-9]*:[A-F0-9:]+\]?)' # ...or ipv6

r'(?::\d+)?' # optional port

r'(?:/?|[/?]\S+)$', re.IGNORECASE)

return re.match(regex, url) is not None

# 使用示例

print(validate_url("***")) # 输出:True

print(validate_url("***")) # 输出:False

```

以上示例展示了如何对URL进行格式验证,确保其遵循了互联网上的标准实践,并对不符合标准的URL进行适当的处理。

0

0