Python网络爬虫高级篇:urllib.parse模块的应用技巧

发布时间: 2024-10-11 19:20:09 阅读量: 20 订阅数: 21

利用python爬虫(part2)–urllib.parse模块

# 1. Python网络爬虫基础回顾

在这一章,我们将对Python网络爬虫的概念和基础进行简要回顾,为后续章节的深入探讨提供一个稳固的起点。

## 1.1 网络爬虫的定义和用途

网络爬虫(Web Crawler)是一种自动提取网页内容的程序,它按照一定的规则,自动地访问互联网,并收集所需信息。爬虫广泛应用于搜索引擎、数据挖掘、市场分析等领域,是获取网络数据的重要手段。

## 1.2 爬虫的工作流程

一个基本的爬虫工作流程包括:发送请求(Request)、获取响应(Response)、解析内容(Parsing)、提取数据(Extraction)和数据存储(Storage)。理解这一流程对于设计和开发高效的爬虫至关重要。

```python

import requests

from bs4 import BeautifulSoup

# 发送请求

response = requests.get('***')

# 解析内容

soup = BeautifulSoup(response.text, 'html.parser')

# 提取数据

title = soup.find('title').get_text()

# 数据存储(示例)

with open('title.txt', 'w') as ***

***

```

上述Python代码演示了一个简单的爬虫工作流程。通过请求网页、解析HTML内容、提取标题信息并存储到文件的过程,我们可以看到爬虫如何实现自动化的数据抓取。

在下一章中,我们将深入探讨urllib.parse模块,它在爬虫的请求构造与解析中扮演着核心角色。

# 2. 深入解析urllib.parse模块

## 2.1 urllib.parse模块的组成部分

在深入了解urllib.parse模块之前,我们需要掌握它的各个组成部分。urllib.parse模块是Python标准库中用于处理URL的模块,它主要包含了以下几个部分:

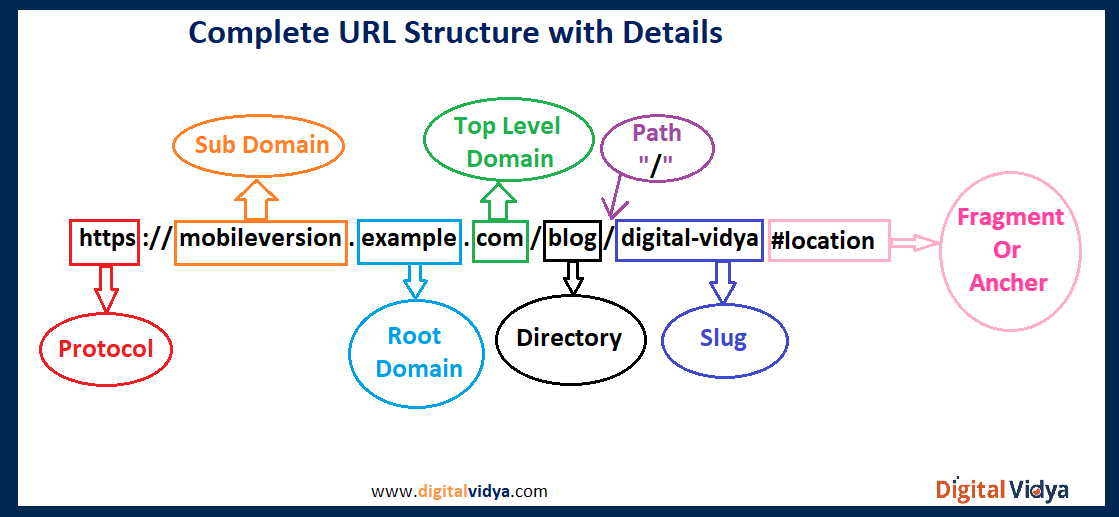

### 2.1.1 url的构成要素

一个标准的URL由以下几个部分组成:scheme(协议)、netloc(网络位置)、path(路径)、params(参数)、query(查询)和fragment(片段)。例如,在URL '***' 中,可以分别识别出各个部分:

- **scheme**: 'http'

- **netloc**: '***:80'

- **path**: '/path/to/page'

- **params**: 无

- **query**: 'name=ferret&color=purple'

- **fragment**: 'section2'

使用urllib.parse模块可以将这些部分解析为单独的组件,并将它们重新组合。

### 2.1.2 解析URL的关键函数和方法

urllib.parse模块提供了以下关键的函数和方法来进行URL的解析和构建:

- **urlparse()**: 解析URL字符串为六部分组成的命名元组。

- **urlunparse()**: 将六部分组成的命名元组重新组装为URL字符串。

- **urlsplit()**: 类似于urlparse(),但它将netloc分成hostname和port。

- **urlunsplit()**: 类似于urlunparse(),用于处理urlsplit()的输出。

- **urlencode()**: 将字典或参数序列编码为URL查询字符串。

通过这些方法,我们可以灵活地对URL进行操作。

## 2.2 高级URL解析技巧

当处理复杂的URL时,我们可能需要进行查询字符串的编码与解码,或者构建和修改URL。

### 2.2.1 查询字符串的编码与解码

查询字符串通常包含特殊字符,需要进行适当的编码才能在URL中正确传输。urllib.parse提供了urlencode()函数来处理编码工作。

```python

from urllib.parse import urlencode

query = {'name': '张三', 'age': 28}

encoded_query = urlencode(query)

print(encoded_query) # 输出: name=%E5%BC%A0%E4%B8%89&age=28

```

### 2.2.2 构建和修改URL

我们可以用urlparse()和urlunparse()来构建和修改URL。

```python

from urllib.parse import urlparse, urlunparse

url_parts = list(urlparse('***'))

url_parts[2] = '/newpath' # 修改path部分

url = urlunparse(url_parts)

print(url) # 输出: ***

```

## 2.3 urllib.parse模块的实用案例

在实际使用中,urllib.parse模块可以帮助我们构造复杂的查询和处理URL编码问题。

### 2.3.1 构造复杂查询的示例

如果需要在查询中添加多个参数或带有特殊字符的参数,我们可以使用urlencode()。

```python

from urllib.parse import urlencode, quote_plus

params = {'name': '张三', 'query': 'Python & urllib'}

encoded_query = urlencode(params, doseq=True)

print(encoded_query) # 输出: name=%E5%BC%A0%E4%B8%89&query=Python+%26+urllib

# 特殊字符编码

special_char = '测试&编码'

encoded_char = quote_plus(special_char)

print(encoded_char) # 输出: %E6%B5%8B%E8%AF%95%26%E7%BC%96%E7%A0%81

```

### 2.3.2 处理重定向和编码问题的策略

处理重定向时,我们可以使用urlparse()分析重定向后的URL,而编码问题可以通过urlencode()进行处理。

```python

from urllib.parse import urlparse, urlencode

# 假设重定向URL存储在redirect_url变量中

redirect_url = '***'

url_parts = urlparse(redirect_url)

query = dict(urlparse.parse_qsl(url_parts.query))

print(query) # 输出: {'name': '张三', 'age': '28'}

```

在这一章中,我们详细介绍了urllib.parse模块的基本组成部分和其高级使用技巧,同时提供了一些实用案例帮助你更好地理解和运用。下章我们将探讨urllib.parse模块在爬虫中的应用。

# 3. urllib.parse在爬虫中的应用

## 3.1 爬虫请求构造与解析

### 3.1.1 创建和修改请求头

在使用Python进行网络爬虫开发时,模拟浏览器发送请求是常见的操作。创建和修改请求头是这一过程中的关键步骤,urllib.parse模块可以提供有效的帮助。通过解析和构建合适的HTTP头部信息,可以提高爬虫请求的逼真度,降低被目标网站屏蔽的风险。

```python

from urllib.parse import urlencode

from urllib.request import Request, urlopen

# 设置编码后的请求参数

params = {'name': 'example', 'age': '25'}

encoded_params = urlencode(params)

url = '***' + encoded_params

# 构造请求头,模拟浏览器访问

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, l

```

0

0