LSTM在图像识别中的潜力探索:开启新应用领域的大门

发布时间: 2024-11-20 19:35:07 阅读量: 16 订阅数: 49

AVR单片机项目-ADC键盘(源码+仿真+效果图).zip

# 1. LSTM和图像识别的基础知识

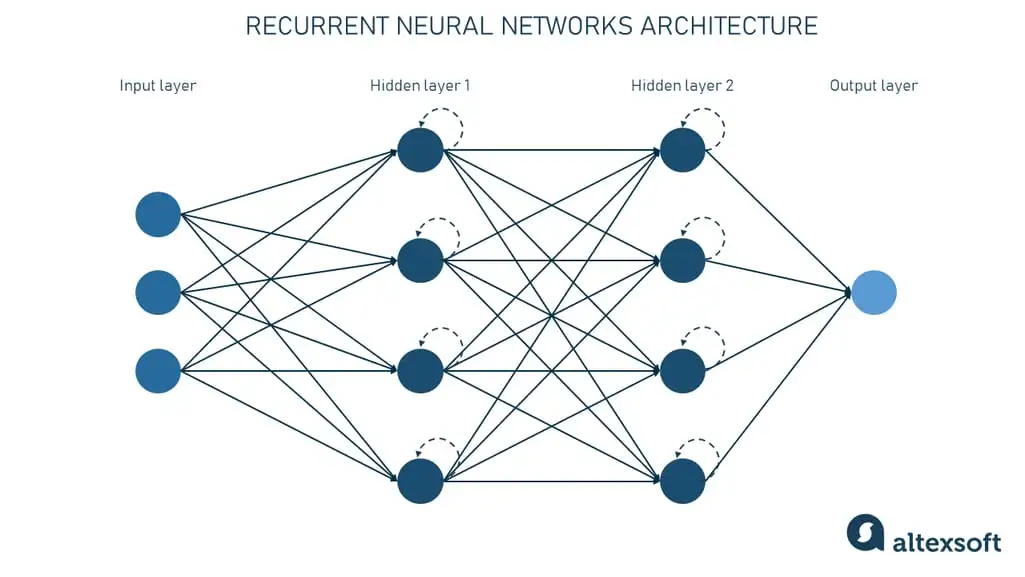

在这一章,我们将探讨LSTM(长短期记忆网络)和图像识别的基本概念和它们之间的关系。LSTM是一种特殊的循环神经网络(RNN),它解决了传统RNN在处理长序列数据时的梯度消失或梯度爆炸问题。它在自然语言处理、语音识别、图像识别等多个领域有着广泛的应用。

图像识别,则是使用计算机来识别和处理图像数据的一门技术。它包括了目标检测、图像分类、图像分割等任务,是计算机视觉领域的核心内容之一。近年来,LSTM被应用到图像识别中,尤其在处理图像序列和视频识别任务中表现出了独特的优势。

接下来的章节,我们将深入探讨LSTM的内部工作机制,它如何在图像识别任务中发挥作用,以及如何优化和应用这种技术。我们将从基础概念出发,逐步深入到实现细节和实际应用中。在这一章结束时,读者将对LSTM和图像识别有基本的了解,并为后续章节的学习打下坚实的基础。

# 2. LSTM网络的工作原理及实现

## 2.1 LSTM网络结构详解

### 2.1.1 LSTM单元的工作机制

LSTM(Long Short-Term Memory)是一种特殊的RNN(Recurrent Neural Network),能够学习长期依赖信息。LSTM的核心思想是在传统的RNN中引入了“门”结构,用以控制信息的流动。LSTM单元主要由三个门构成:遗忘门、输入门和输出门。这些门由一个或多个神经网络层组成,其中包含了Sigmoid激活函数,Sigmoid函数的输出范围在0到1之间,用于决定信息的保留程度。

- **遗忘门(Forget Gate)**:决定了上一个状态中哪些信息应该被忘记。它通过当前输入和上一个隐藏状态来计算,输出一个0到1之间的数字,对应每个状态变量应该保留的信息比例。

- **输入门(Input Gate)**:决定了当前输入的哪些信息需要被存储,并更新到当前的单元状态。它通常包含两个部分:一个Sigmoid层决定哪些值需要更新,另一个tanh层创建一个新的候选值向量,然后将这个向量与Sigmoid层的输出相乘,得到最终的更新值。

- **输出门(Output Gate)**:决定在下一个时间步长中输出什么值。首先,它通过当前输入和上一个隐藏状态计算当前的单元状态,然后使用另一个Sigmoid层来决定哪些信息将被输出。

代码块示例:

```python

# 伪代码展示LSTM单元的计算过程

class LSTMCell:

def __init__(self, ...):

# 初始化权重、偏置等参数

...

def forward(self, x, prev_state):

# 计算遗忘门、输入门、输出门和候选隐藏状态

forget_gate = ...

input_gate = ...

output_gate = ...

candidate_state = ...

# 更新单元状态和隐藏状态

cell_state = ...

hidden_state = ...

return hidden_state, cell_state

```

### 2.1.2 LSTM与传统RNN的比较

相较于传统RNN,LSTM在理论上解决了长期依赖问题,即传统RNN难以学习和记忆长距离的时序依赖关系。LSTM通过其复杂的“门”结构能够有效地选择性地记忆信息和忘记信息,使得长序列的依赖关系能被有效地捕获和使用。

- **长序列的处理能力**:LSTM通过门控机制能够保留较长时间跨度内的信息,而传统RNN会逐渐丢失早期信息,即出现梯度消失问题。

- **模型复杂度**:LSTM较传统RNN有更高的计算复杂度,因为其单元内部有多个门控结构,需要更多的参数和计算资源。

- **训练效率**:在实践中,LSTM通常需要更多的数据和时间进行训练,才能达到较好的性能。

- **适用场景**:LSTM适用于那些需要学习长期时间依赖的序列任务,如自然语言处理、语音识别、时间序列分析等。

## 2.2 LSTM的训练过程

### 2.2.1 序列数据的预处理方法

在训练LSTM模型之前,对输入数据进行适当的预处理是非常重要的一步。序列数据预处理通常包括以下几个步骤:

- **归一化**:将数据缩放到一个小的范围内,如[0,1]或[-1,1],以便模型更快收敛。

- **填充(Padding)**:确保所有序列输入到LSTM时有相同的长度,对于较短的序列,可以在末尾添加特殊值或零进行填充。

- **数据批处理**:将数据分成大小相等的批次,可以减少内存消耗,并加速训练过程。

- **序列切分**:将长序列切分为更小的片段,这有助于避免梯度消失或梯度爆炸的问题。

### 2.2.2 损失函数和优化器的选择

在训练神经网络时,损失函数和优化器的选择对模型的训练效果至关重要。

- **损失函数**:对于回归任务,常用的损失函数是均方误差(MSE),对于分类问题,交叉熵损失(Cross-Entropy)是更常见的选择。在LSTM模型中,可以使用以下公式来表达均方误差损失函数:

\[ L(y, \hat{y}) = \frac{1}{N} \sum_{i=1}^{N} (y_i - \hat{y_i})^2 \]

其中,\( y \)是真实值,\(\hat{y}\)是预测值,\( N \)是样本数量。

- **优化器**:优化器用于调整网络权重,以最小化损失函数。常见的优化器包括SGD、Adam、RMSprop等。Adam优化器结合了RMSprop和梯度下降动量法的优点,通常能够有效地训练深度神经网络,包括LSTM。

### 2.2.3 超参数调整和模型评估

超参数的调整对模型的性能有着决定性的影响。LSTM模型的超参数包括但不限于:

- **学习率**:决定权重更新的速度。

- **隐藏层单元数**:LSTM单元的数量。

- **批次大小(Batch size)**:一个批次中的样本数量。

- **迭代次数(Epochs)**:整个训练数据集被用来训练的次数。

模型评估主要通过交叉验证、混淆矩阵、精确度、召回率、F1分数、ROC曲线、AUC值等指标来衡量。

## 2.3 LSTM的实现技术

### 2.3.1 使用深度学习框架搭建LSTM

深度学习框架如TensorFlow和PyTorch提供了快速搭建LSTM网络的API。以PyTorch为例,通过定义LSTMCell或使用nn.LSTM模块,可以轻松实现LSTM网络。

```python

import torch

import torch.nn as nn

# 定义LSTM网络

class LSTM_Network(nn.Module):

def __init__(self, ...):

super(LSTM_Network, self).__init__()

self.lstm = nn.LSTM(input_size=..., hidden_size=..., num_layers=..., batch_first=True)

def forward(self, x):

# x的形状为(batch_size, seq_len, input_size)

output, (hn, cn) = self.lstm(x)

return output, (hn, cn)

# 实例化模型并进行训练...

```

### 2.3.2 高级优化技术的应用

除了传统的优化器外,还有一些高级技术能够提升LSTM模型的训练效果:

- **学习率衰减**:随着训练的进行逐渐减小学习率,帮助模型在收敛点附近进行更细致的调整。

- **早停法(Early Stopping)**:监控模型在验证集上的性能,一旦性能不再提升或开始下降,提前终止训练过程。

- **梯度裁剪(Gradient Clipping)**:防止梯度爆炸问题,通过将梯度限制在某个阈值范围内。

### 2.3.3 实际问题的调试和解决

在实际开发LSTM模型时,可能会遇到各种问题,如梯度消失、过拟合、收敛速度慢等。以下是一些常见的调试策略:

- **梯度消失**:使用ReLU或Leaky ReLU激活函数,初始化权重使用合适的策略,如He初始化或Xavier初始化。

- **过拟合**:采用dropout、权重衰减等正则化技术,增加数据集大小或使用数据增强。

- **收敛速度慢**:考虑调整学习率,使用更复杂的模型结构,或者加入预训练模型的权重作为起点。

在调试过程中,可视化损失函数和准确率的变化趋势,可以帮助我们更好地理解模型的训练状态,并做出相应的调整。

# 3. LSTM在图像识别中的应用实践

## 3.1 图像识别的挑战和方法

图像识别作为计算机视觉的核心

0

0