LSTM并行计算优化:提升训练速度的五大策略

发布时间: 2024-11-20 19:31:26 阅读量: 3 订阅数: 7

# 1. LSTM并行计算优化概述

长短期记忆网络(LSTM)是序列数据处理领域中的重要模型,尤其在自然语言处理和语音识别等应用中发挥着关键作用。随着数据量和计算需求的增大,LSTM模型的训练时间也变得越来越长,因此并行计算成为了优化LSTM模型训练速度的重要手段。

本章将简要介绍LSTM并行计算优化的背景及其必要性,并概述本章内容。我们将探讨为什么需要对LSTM进行并行计算优化,以及优化后能带来哪些具体的性能提升。同时,本章将为接下来的章节打下基础,为读者展现并行计算优化的全局视角。

我们将了解到并行计算技术是如何在GPU和分布式计算资源上实现,以及这些技术如何帮助我们缩短LSTM模型的训练周期,从而实现更快的模型部署和应用落地。通过本章的阅读,读者将对LSTM并行计算优化形成初步的认识,并对后续章节中更具体的技术细节和操作步骤产生期待。

# 2. 理解LSTM模型与并行计算

## LSTM模型基础

### LSTM单元结构解析

长短期记忆网络(LSTM)是由Hochreiter与Schmidhuber于1997年提出的一种特殊的循环神经网络(RNN),被设计用于避免传统RNN在学习长序列数据时遇到的梯度消失或梯度爆炸的问题。LSTM的核心是“单元状态”(Cell State)和“门控机制”(Gating Mechanism)。

- **单元状态**:在LSTM中,单元状态类似于一条信息高速公路,信息能够在不经过太多修改的情况下流动。然而,与传统的RNN不同的是,LSTM可以有选择地添加或删除信息到单元状态中,这由门控机制负责。

- **门控机制**:这是LSTM最核心的部分,包含三个主要的门:遗忘门(Forget Gate)、输入门(Input Gate)、输出门(Output Gate)。这些门控制信息的流动,它们都是使用sigmoid神经网络层来输出介于0和1之间的数值,0表示完全排除信息,1表示完全通过信息。

- **遗忘门**:决定了应该从单元状态中丢弃什么信息。它查看前一个隐藏状态和当前输入,并输出一个介于0到1之间的数值。

- **输入门**:决定了什么新信息需要存储在单元状态中。它包括一个sigmoid层,决定哪些信息将被更新,并由一个tanh层创建新的候选值向量。

- **输出门**:决定下一个隐藏状态的输出。首先计算单元状态的值,然后输出门决定该值的哪些部分将用于下一个隐藏状态。

通过这些门的组合,LSTM能够保持长期的状态,这使得它非常擅长处理和预测时间序列数据中的重要事件。

### LSTM在序列数据中的作用

LSTM的特性使得它在处理序列数据时具有独特的优势。序列数据通常包含长期依赖问题,即在数据序列中,某些早期发生的信息对后续的输出或决策有着决定性的影响。LSTM能够记住和传递长期的信息,从而在序列的每个时间步上提供更加准确的输出。

序列数据存在于多种应用中,包括语音识别、自然语言处理(NLP)、时间序列预测、股票市场分析等。例如,在NLP任务中,LSTM能够利用上下文信息来提高翻译质量或情感分析的准确性。

## 并行计算理论基础

### 并行计算的概念与重要性

并行计算是指同时使用多个计算资源解决计算问题的过程,可以有效缩短程序运行时间,提高数据处理能力。在深度学习中,并行计算尤为重要,因为训练深度神经网络通常需要大量的计算资源和时间。通过将数据集分割并分配到多个处理单元,可以并行化处理多个数据子集,这样可以显著提高训练速度。

并行计算的关键在于算法的分解和任务的同步。算法分解指的是将一个问题拆分成可以并行处理的部分,而任务同步则确保这些部分能够在适当的时候整合结果,保持一致性。

### GPU与CPU在深度学习中的应用比较

在深度学习中,GPU(图形处理单元)和CPU(中央处理单元)是两种主要的计算资源。它们在架构上有着本质的不同。

- **CPU**:设计上强调单核运算能力,拥有较少的核心但每个核心的运算速度较快。适合处理逻辑复杂的任务以及需要快速执行单线程程序的场景。

- **GPU**:拥有成百上千的核心,适合处理具有高度并行性的计算任务,如矩阵和向量运算。由于其能够同时处理大量的数据,因此特别适合于深度学习中的数据并行操作。

由于深度学习中的很多操作可以被并行化,GPU成为深度学习实践中的首选硬件。它能够在同样的时间内处理比CPU多得多的数据,从而加速模型的训练和推断过程。

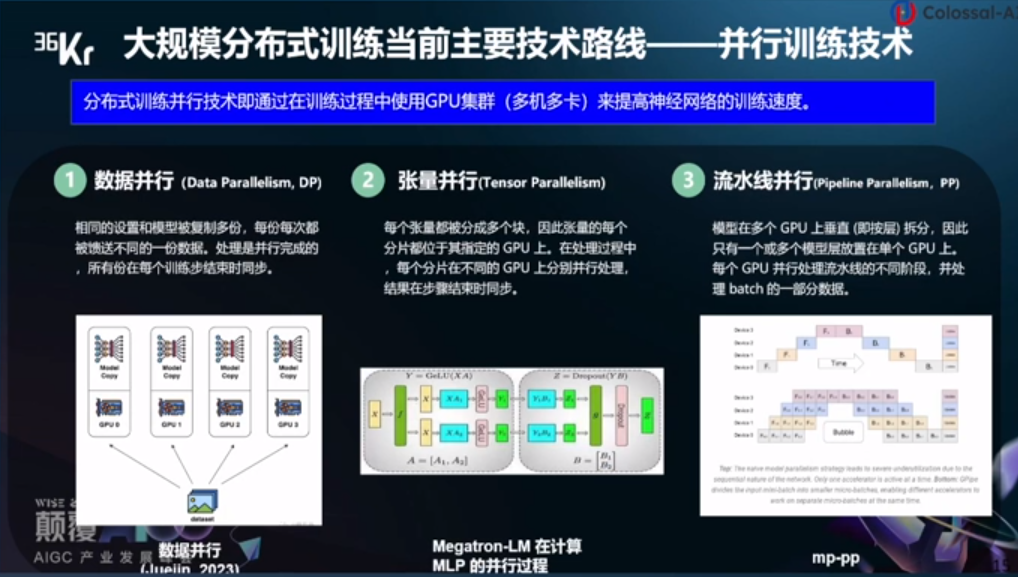

### 数据并行与模型并行的原理与区别

并行计算在深度学习中有两种主要的并行策略:数据并行和模型并行。

- **数据并行**:是最常见的一种并行策略,核心思想是将数据集分成多个部分,并将每个部分发送到不同的处理单元。每个处理单元使用相同的模型结构对各自的数据进行训练,并最终将这些处理单元的结果汇总。数据并行特别适用于那些能够被分割的数据集,而且训练过程中不需要过多的通信。

- **模型并行**:当模型过大无法在单个处理单元中完全加载时,就需要使用模型并行。在这种策略下,模型的不同部分被分配到不同的处理单元上。由于需要在不同的处理单元之间进行大量通信,模型并行通常比数据并行复杂,并且可能成为性能的瓶颈。

选择数据并行还是模型并行,需要根据具体的应用场景、数据集大小、模型复杂度以及可用的计算资源来决定。在实际操作中,这两种策略经常结合使用以达到最佳效果。

# 3. 优化策略一:数据预处理与批量加载

## 3.1 数据预处理技巧

### 3.1.1 数据标准化与归一化

在深度学习任务中,数据预处理是至关重要的一步,它直接关系到模型的训练效果和收敛速度。数据标准化(Standardization)和归一化(Normalization)是两种常见的预处理方法,用于调整数据分布,以获得更好的学习效果。

数据标准化的目标是将数据特征的均值变为0,标准差变为1。这样处理后,数据的分布会被限制在较小的范围内,即符合标准正态分布。标准化的公式如下:

\[ x_{std} = \frac{(x - \mu)}{\sigma} \]

其中,\( x \)是原始数据点,\( \mu \)是数据集的均值,\( \sigma \)是数据集的标准差。

数据归一化则是将数据特征缩放到一个特定的范围,通常是0到1之间。归一化的公式如下:

\[ x_{norm} = \frac{(x - x_{min})}{(x_{max} - x_{min})} \]

在这里,\( x_{min} \)和\( x_{max} \)分别是特征值中的最小值和最大值。

以下是标准化和归一化在Python中使用pandas和scikit-learn库进行操作的代码示例:

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler, MinMaxScaler

# 假设df是pandas DataFrame对象,包含了一些待处理的数据

# 数据标准化

scaler = StandardScaler()

df_scaled = pd.DataFrame(scaler.fit_transform(df), columns=df.columns)

# 数据归一化

scaler = MinMaxScaler()

df_normalized = pd.DataFrame(scaler.fit_transform(df), columns=df.columns)

```

通过标准化和归一化处理,数据的尺度得到了统一,这有助于减少不同特征对模型训练的影响,从而可以提高算法的收敛速度并提升模型的预测性能。

### 3.1.2 异常值处理与数据增强

在数据

0

0