【数据集划分的陷阱】:识别并避免数据集划分的10大常见错误

发布时间: 2024-11-20 03:26:57 阅读量: 6 订阅数: 13

# 1. 数据集划分的基本原则和重要性

在机器学习和数据分析项目中,数据集划分是至关重要的一步,它是建立有效模型的基础。正确划分数据集能够确保模型在未知数据上的泛化能力,防止过拟合和欠拟合。本章我们将介绍数据集划分的基本原则,包括理解数据集划分的意义、划分过程中需要遵循的标准以及划分对模型性能的影响。

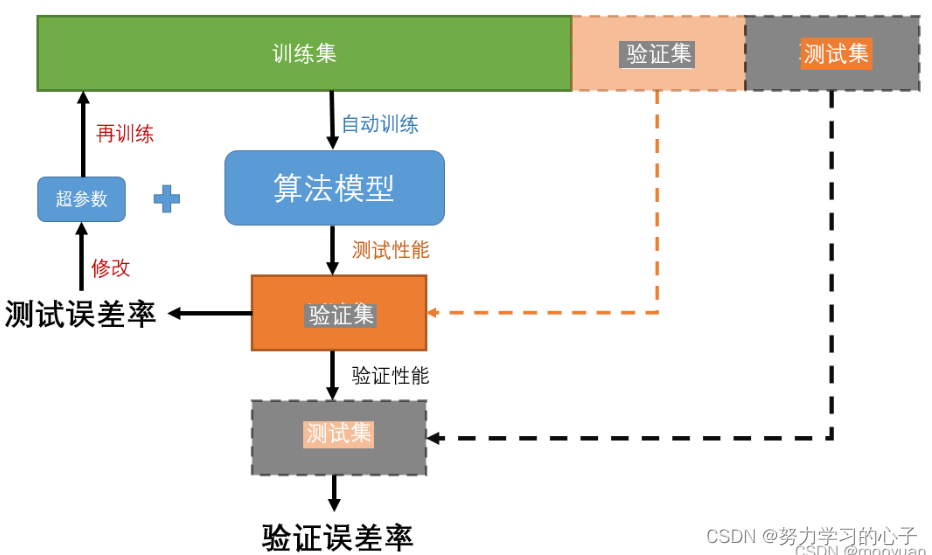

数据集通常分为训练集、验证集和测试集三个部分。训练集用于模型的训练,验证集用于模型参数的调整和选择,测试集则用于评估模型的最终性能。划分数据集时,我们需要考虑数据的代表性和多样性,确保每个部分都能够反映总体数据的特性。

理解并应用正确的数据集划分原则,可以帮助我们更好地控制模型的复杂度,避免对特定数据样本的过度拟合,提高模型在现实世界中的准确性和稳定性。在后续章节中,我们将深入探讨数据集划分的常见错误、高级技术和实际应用案例。

# 2. 数据集划分的常见错误解析

## 2.1 数据划分的比例设置错误

### 2.1.1 错误比例设置的原因和后果

在机器学习和数据科学项目中,正确地划分数据集是至关重要的。然而,许多从业者在划分数据时犯了一些常见错误,其中一个主要错误是在设置训练集、验证集和测试集的比例时出现了偏差。错误比例设置的原因可能包括缺乏对项目要求的理解、对数据集特性的无视、以及对不同模型性能评估方法的认识不足。

错误比例设置的后果是多方面的。首先,如果训练集过小,模型可能无法学习到足够的模式,导致过拟合;验证集和测试集如果也相应较小,则无法提供足够的样本以进行有效的性能评估。相反,如果训练集过大,可能会浪费宝贵的资源,同时使得验证集和测试集过小,导致性能评估不够准确。此外,在极端情况下,模型的评估可能受到数据划分方式的影响,从而产生误导性的结论。

### 2.1.2 如何科学地设置数据划分比例

要科学地设置数据划分的比例,首先需要考虑数据的总量和模型的需求。对于较小的数据集,一种常见的实践是采用80/20或者70/30的规则,即70%-80%的数据用作训练集,剩下的20%-30%则分为验证集和测试集。对于大型数据集,可以使用更细的划分,例如60/20/20或者90/5/5。

除了基本比例之外,还应考虑到数据集的类别分布。例如,在处理不平衡数据集时,可能会采用分层抽样方法,确保每个子集(训练集、验证集、测试集)中各类别的比例与总体一致。这种比例设置对于确保模型能够公平地学习所有类别至关重要。

最后,数据划分的比例设置也应与模型评估的方法相结合。例如,在交叉验证中,数据可能会被划分为k份,每份轮流作为验证集,其余作为训练集。在这种情况下,整体数据的比例划分可能仍适用,但具体每份数据的划分需要仔细考虑。

## 2.2 数据集不均衡的处理问题

### 2.2.1 不均衡数据集的定义和影响

不均衡数据集是指在数据集中各类别数据的分布不均匀。在某些场景下,如欺诈检测、疾病诊断等领域,正面(少数)案例远远少于负面(多数)案例。这种不均衡严重影响机器学习模型的性能,使得模型倾向于对多数类别有更好的识别能力,而忽视少数类别,导致评估指标失真,特别是在需要对少数类别进行准确预测的场合。

### 2.2.2 解决数据集不均衡的策略

处理不均衡数据集的策略包括数据层面和算法层面的方法。数据层面,可以采用过采样(Oversampling)和欠采样(Undersampling)技术。过采样是指增加少数类别的样本来平衡数据集,但过采样可能会导致过拟合。欠采样则是减少多数类别的样本来达到平衡,但可能会丢失有用信息。

算法层面,可以使用一些特殊的算法,如成本敏感学习(Cost-sensitive learning),在训练过程中给予少数类别更高的错误惩罚。此外,可以采用集成方法,例如随机森林和Bagging,它们能够通过构建多个模型来减少过拟合风险,对不平衡数据集表现更好。

## 2.3 数据泄露问题

### 2.3.1 数据泄露的定义和后果

数据泄露是指在训练数据过程中意外地让模型看到了验证集或测试集中的信息。这通常发生在数据预处理时,如标准化特征时使用了整个数据集的统计信息,或者在处理缺失数据时混合了训练和测试数据集。数据泄露的后果是模型的性能在实际应用中通常会低于评估时的结果,因为它已经“记住”了验证集和测试集的数据特征,从而导致评估结果的不准确。

### 2.3.2 避免数据泄露的实践技巧

要避免数据泄露,可以采取一系列策略。首先,应该严格划分数据集,并在模型的整个生命周期内保持其不变。例如,应该先划分子集,然后再进行特征工程和模型训练。其次,进行交叉验证时,每次迭代都应使用独立的训练和验证集。此外,在处理缺失数据时,只能使用训练集的数据统计信息来进行填充,或者使用仅基于训练集的插补技术。

在实际操作中,可以使用一些自动化工具和框架来帮助管理数据集划分和数据泄露检查。例如,scikit-learn库提供了交叉验证的工具,其中`train_test_split`和`cross_val_score`等函数可以帮助开发者合理地进行数据集划分和模型评估。

```python

from sklearn.model_selection import train_test_split

from sklearn.ensemble import RandomForestClassifier

# 示例数据集划分和交叉验证的代码

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 使用随机森林进行交叉验证

scores = cross_val_score(RandomForestClassifier(), X_train, y_train, cv=5)

print(f"CV average score: {scores.mean()}")

```

通过严格遵循这些实践技巧,可以大幅度减少数据泄露的风险,确保模型评估结果的可靠性。

```mermaid

graph LR

A[开始划分数据集] --> B[确定数据集比例]

B --> C[避免不均衡问题]

C --> D[检查数据泄露风险]

D --> E[交叉验证]

E --> F[模型评估]

F --> G[调整模型]

```

以上代码块中的`train_test_split`函数用于划分训练和测试集,而`cross_val_score`函数用于交叉验证,这两个步骤都是避免数据泄露的关键环节。在进行划分时,`random_state`参数被设置为一个固定的值以确保结果的可复现性。通过交叉验证可以得到不同划分下的模型性能评分,帮助我们调整模型参数或选择更合适的模型结构。

# 3. 数据集划分的高级技术

随着数据分析的深入,传统的数据集划分方法已经无法满足复杂场景的需求。本章将探讨一些高级技术,以应对特定类型数据集划分的挑战,如时间序列数据、大数据集以及多模态数据集。

## 3.1 时间序列数据的划分策略

### 3.1.1 时间序列数据的特点和挑战

时间序列数据集在划分时面临两个主要挑战:时间依赖性和季节性。时间依赖性意味着数据点在时间上相互关联,前后时刻的数据往往有某种固定的模式或趋势。季节性则体现在数据在特定周期内的重复模式,如日周期、周周期或年周期等。

在时间序列划分中,必须保证训练集、验证集和测试集保持时间顺序,避免未来数据用于训练或验证历史数据的模型,否则会导致模型评估的严重偏差。

### 3.1.2 时间序列数据的有效划分方法

一种常用的方法是使用时间窗口划分,该方法通过定义一个起始时间点和窗口大小,将数

0

0