【C++内存管理秘籍】:std::make_shared的10种高效技巧及最佳实践

发布时间: 2024-10-23 09:46:44 阅读量: 37 订阅数: 25

# 1. C++内存管理概述

在现代编程中,内存管理是衡量软件质量和性能的关键因素之一。特别是在C++这种具有手动内存管理能力的语言中,如何有效控制内存,防止内存泄漏、野指针等问题,是每个开发者必须面对的挑战。C++提供了多种内存管理工具和技术,以帮助程序员更好地管理内存。理解这些工具的工作原理和最佳实践,对于开发高性能、稳定的C++应用程序至关重要。

在本章中,我们将首先探讨内存管理的基本概念,包括内存分配与释放的机制,以及智能指针如何帮助我们避免内存泄漏。接下来,我们将深入了解C++标准库中的内存分配和管理工具,比如`std::make_shared`,它通过减少内存碎片和提高资源利用率来优化内存分配。通过本章的学习,我们将为后续更深入地探讨C++内存管理打下坚实的基础。

# 2. std::make_shared的原理与优势

在现代C++中,智能指针已经成为管理动态内存的重要工具,而在所有智能指针中,std::shared_ptr因其引用计数的内存共享特性,成为了管理共享所有权资源的首选。std::make_shared是一个辅助函数,它能更高效地分配内存并创建std::shared_ptr实例。本章节将深入探讨std::make_shared的原理与优势,以及与传统new操作符的比较。

### 2.1 内存管理的基本概念

#### 2.1.1 内存分配与释放

在C++中,内存管理是指为程序运行时动态分配和释放内存的过程。传统上,动态内存的管理依赖于new和delete操作符。使用new操作符时,程序在堆上分配一块内存,并返回指向这块内存的指针。而delete操作符则释放先前通过new分配的内存。这种手动管理内存的方式虽然灵活,但也容易出错,例如遗忘释放内存或者释放已释放的内存。

```cpp

int* p = new int(10); // 动态分配内存并初始化

delete p; // 释放内存

```

#### 2.1.2 智能指针与内存泄漏

为了避免手动管理内存时可能出现的问题,C++11引入了智能指针。std::shared_ptr是一种共享所有权的智能指针,它可以记录有多少个std::shared_ptr实例共享同一块内存,并在最后一个实例被销毁时自动释放内存。这样,即使发生异常,程序也能保证资源得到正确释放,从而避免内存泄漏。

```cpp

#include <memory>

std::shared_ptr<int> sp = std::make_shared<int>(10); // 创建一个shared_ptr管理的int对象

// 使用sp时无需担心内存释放的问题

```

### 2.2 std::make_shared的内部机制

#### 2.2.1 分配策略与内存效率

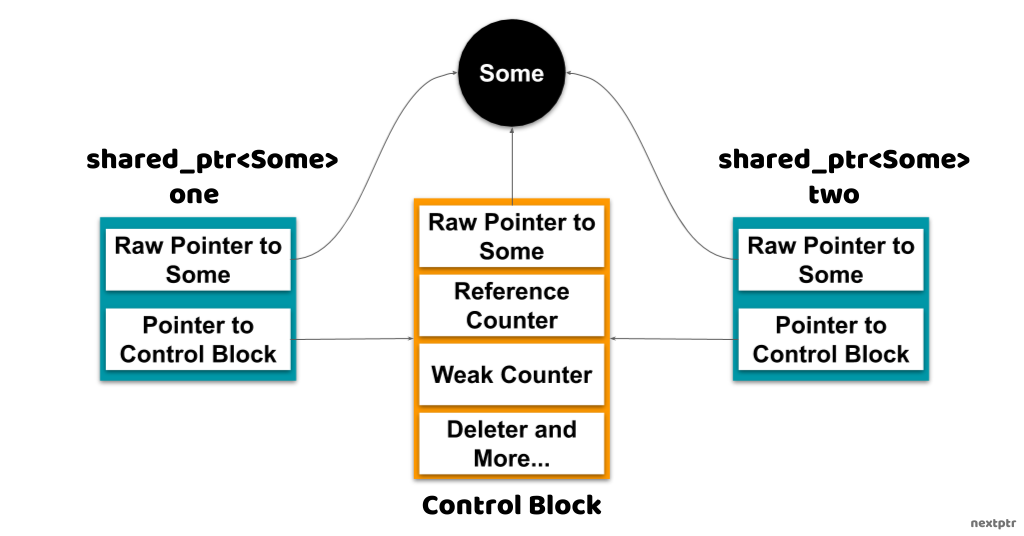

std::make_shared函数在创建std::shared_ptr时,内部实现了一个优化的内存分配策略。它通过一次性分配内存来创建控制块和实际对象,这样可以减少分配次数并减少内存碎片。由于控制块和对象存储在同一块内存上,std::make_shared在效率上有显著的优势。

```cpp

auto sp = std::make_shared<int>(10); // 创建并初始化一个shared_ptr

```

#### 2.2.2 std::make_shared与std::shared_ptr

std::make_shared与std::shared_ptr配合使用,能够高效地管理共享对象的生命周期。使用std::make_shared可以确保创建的对象和对应的控制块共用一块内存,这意味着内存的分配和初始化被优化。当对象不再被任何std::shared_ptr引用时,它们的析构函数会被调用,随后控制块和对象的内存被一次性释放。

### 2.3 与new关键字的比较分析

#### 2.3.1 性能对比

在性能方面,std::make_shared相比new操作符分配内存,通常能提供更高的性能。这是因为std::make_shared通过减少内存分配次数和减少控制块的创建来提高效率。从下面的代码示例中可以看到,std::make_shared只进行了一次内存分配,而通过new操作符则需要两次:一次分配对象内存,另一次分配控制块内存。

```cpp

auto sp = std::make_shared<int>(10); // 单次内存分配

std::shared_ptr<int> sp2(new int(10)); // 两次内存分配

```

#### 2.3.2 使用场景选择

std::make_shared虽然在性能上有优势,但在某些场景中new操作符可能更适用。例如,在需要自定义删除器时,使用std::make_shared可能不是最佳选择。另外,如果对象非常大,分配失败时std::make_shared会比new操作符抛出异常,这也需要在设计程序时考虑。

```cpp

auto sp3 = std::make_shared<int>(10); // 无自定义删除器

std::shared_ptr<int> sp4(new int(10), [](int* p) { delete p; }); // 带自定义删除器

```

在考虑是否使用std::make_shared时,开发者应该根据应用场景和具体需求,权衡其带来的性能提升和潜在限制。通过这种方式,程序不仅能从现代C++智能指针中受益,还能确保资源的高效和安全管理。

# 3. std::make_shared高效技巧详解

std::make_shared 是 C++11 标准库中提供的一个函数模板,用于创建一个 std::shared_ptr 对象,该对象共享底层对象的所有权。它不仅提高了内存的使用效率,还能减少代码冗余,是现代 C++ 中推荐的内存分配方式。在本章节中,我们将详细探索 std::make_shared 的使用技巧,深入理解其内部机制,并结合具体案例展示如何优化代码性能和异常安全性。

## 3.1 构造函数参数的传递技巧

std::make_shared 函数模板支持直接传递构造函数的参数,从而创建具有特定参数的共享对象。这种机制为我们提供了极大的灵活性,但也需要注意一些潜在的问题。

### 3.1.1 带参数构造的对象创建

当我们需要使用特定的参数来初始化 std::shared_ptr 管理的对象时,可以通过 std::make_shared 来简化代码,并保持异常安全。例如,如果有一个类 Complex,它有一个接受两个整数参数的构造函数:

```cpp

class Complex {

public:

Complex(int a, int b) : real_(a), imag_(b) {}

private:

int real_;

int imag_;

};

// 使用std::make_shared创建Complex实例

auto complex_ptr = std::make_shared<Complex>(10, 20);

```

### 3.1.2 避免构造函数的隐式转换问题

使用 std::make_shared 时,如果构造函数接受多个参数,需要确保参数能够正确匹配,避免隐式类型转换导致的编译错误。假设有如下代码:

```cpp

class Complex {

public:

// 仅接受int参数的构造函数

explicit Complex(int a) : real_(a), imag_(0) {}

Complex(int a, int b) : real_(a), imag_(b) {}

private:

int real_;

int imag_;

};

// 尝试使用int初始化Complex,失败

// auto complex_ptr = std::make_shared<Complex>(10);

// 正确使用std::make_shared,传入两个参数

auto complex_ptr = std::make_shared<Complex>(10, 20);

```

由于构造函数被声明为 explicit,无法进行隐式转换,直接使用 `std::make_shared<Complex>(10)` 将导致编译错误。解决办法是显式传递所有必需的参数。

## 3.2 自定义删除器的运用

std::shared_ptr 允许我们为其指定自定义删除器,这在对象的释放需要特殊处理时尤为有用。例如,当对象涉及文件系统或动态库时,自定义删除器可以确保资源被正确释放。

### 3.2.1 自定义删除器的基本用法

假设我们需要管理一个文件对象,我们可能希望在对象销毁时自动关闭文件。下面是一个使用 lambda 表达式作为删除器的示例:

```cpp

#include <iostream>

#include <fstream>

#include <memory>

int main() {

// 创建一个具有自定义删除器的shared_ptr

std::shared_ptr<std::ifstream> file_ptr(new std::ifstream("example.txt"), [](std::ifstream* ptr) {

ptr->close();

delete ptr;

});

// 使用file_ptr来操作文件

// ...

return 0;

}

```

### 3.2.2 自定义删除器的优势

使用自定义删除器可以保证在共享对象生命周期结束时,资源得到适当的释放,尤其适用于涉及系统资源、文件句柄或外部库对象的场景。在某些特定情况下,自定义删除器还能提高程序的性能,因为它允许我们执行自定义清理逻辑,而不仅仅是简单的 delete 操作。

## 3.3 std::make_shared与异常安全

在异常安全的代码中,使用 std::make_shared 可以提升安全性。当异常发生时,std::make_shared 能确保资源不会泄漏,而使用裸 new 的方式则需要程序员显式处理异常。

### 3.3.1 异常安全性的概念

异常安全性是指在程序的某部分抛出异常时,整个程序仍然能保持良好的状态,不会发生资源泄露、数据损坏等。

```cpp

void functionThatThrows() {

throw std::runtime_error("Error!");

}

int main() {

// 使用std::make_shared,异常安全

auto sp = std::make_shared<int>(42);

try {

functionThatThrows();

} catch (...) {

// sp会自动清理资源,不需要手动释放

}

// ...

}

```

### 3.3.2 std::make_shared与异常安全保证

使用 std::make_shared 创建的对象,当发生异常时,能够保证相关资源在 shared_ptr 对象析构时被正确释放,这是因为 std::make_shared 会分配足够的内存来同时包含对象和引用计数。这使得即便是在发生异常时,shared_ptr 对象仍然可以正确地清理其管理的资源。

在本章中,我们详细讨论了 std::make_shared 的高效使用技巧,从传递构造函数参数的方法到自定义删除器的运用,再到异常安全性的保证。每项技巧的掌握和运用都是提升 C++ 代码性能和可靠性的重要一环。通过这些详尽的分析,读者应该对如何在实际开发中更好地利用 std::make_shared 有了深刻的理解。下一章将深入探讨 std::make_shared 在并发编程、资源受限环境下的应用,以及与现代 C++ 库的整合,进一步拓展 std::make_shared 的使用边界。

# 4. std::make_shared最佳实践案例

在了解了std::make_shared的原理、优势和技巧之后,我们将探索其在实际编程中的最佳实践案例。本章将深入分析std::make_shared如何在并发编程、资源受限的环境优化以及与现代C++库整合中发挥作用。

## 在并发编程中的应用

### 多线程环境下的内存管理

当涉及到多线程编程时,合理管理内存变得至关重要。std::make_shared通过其内部的引用计数机制,天然支持线程安全,这使得它成为并发编程中的首选工具。

```cpp

#include <iostream>

#include <memory>

#include <thread>

#include <chrono>

void thread_function(std::shared_ptr<int> shared_int) {

std::this_thread::sleep_for(std::chrono::seconds(1));

*shared_int = 10;

}

int main() {

auto shared_int = std::make_shared<int>(0);

std::thread t1(thread_function, shared_int);

std::thread t2(thread_function, shared_int);

t1.join();

t2.join();

std::cout << *shared_int << std::endl; // 输出10

return 0;

}

```

代码段解释:在这个例子中,我们创建了一个 std::shared_ptr 实例,并将其传递给两个线程。每个线程都在修改同一个对象的状态。std::make_shared 确保了在多线程环境下,对共享资源的引用计数安全地进行修改。

### std::make_shared与线程安全

在多线程环境下,std::make_shared 不仅可以减少内存分配次数,避免了潜在的竞态条件,还能减少因多次分配而导致的线程同步开销。这使得它在并发编程中非常适用。

## 在资源受限环境下的优化

### 内存管理与系统资源

嵌入式系统和资源受限环境对内存管理提出了更高的要求。std::make_shared在这样的环境中可以优化内存使用,减少内存碎片,提高程序性能。

### std::make_shared在嵌入式系统中的运用

在资源受限的环境中,如嵌入式系统,使用std::make_shared可以减少内存分配次数,有助于避免由于内存分配失败导致的程序崩溃。

```cpp

#include <iostream>

#include <utility>

#include <memory>

struct ExpensiveResource {

ExpensiveResource() {

// 模拟资源消耗

std::cout << "Resource allocated." << std::endl;

}

~ExpensiveResource() {

// 模拟资源清理

std::cout << "Resource deallocated." << std::endl;

}

void operation() {

// 模拟操作

}

};

int main() {

auto shared_resource = std::make_shared<ExpensiveResource>();

shared_resource->operation();

return 0;

}

```

这段代码展示了如何使用std::make_shared创建一个资源消耗较大的对象,同时保证只有在真正需要时才进行资源分配。

## 与现代C++库的整合

### 标准模板库(STL)与std::make_shared

现代C++标准模板库(STL)中的许多容器,例如std::vector和std::map,都支持使用智能指针作为元素类型。std::make_shared与STL的整合,可以提升代码的资源管理能力。

```cpp

#include <iostream>

#include <vector>

#include <memory>

int main() {

std::vector<std::shared_ptr<int>> vec;

vec.push_back(std::make_shared<int>(42));

*vec[0] = 43;

std::cout << *vec[0] << std::endl; // 输出43

return 0;

}

```

本示例展示了如何在STL容器中使用std::make_shared来存储指向int的智能指针。

### 第三方库中的std::make_shared运用

在使用第三方库时,std::make_shared的使用也是一个重要的实践。例如,Boost库和一些现代C++库都支持std::make_shared,利用它可简化资源管理。

```cpp

#include <iostream>

#include <boost/smart_ptr/make_shared.hpp>

#include <boost/interprocess/shared_memory_object.hpp>

int main() {

auto shared_mem = boost::make_shared<boost::interprocess::shared_memory_object>(

boost::interprocess::open_or_create, "my_shared_memory", boost::interprocess::read_write);

// 使用shared_mem...

return 0;

}

```

此段代码向我们展示了如何使用Boost库中的make_shared函数来创建一个Boost.interprocess共享内存对象。

在本章中,我们通过多个实际案例展示了std::make_shared在并发编程、资源受限环境及现代C++库整合方面的应用。通过这些案例,我们可以看到std::make_shared如何有效地提高程序性能、简化资源管理和确保线程安全。在下一章,我们将深入探索std::make_shared的性能优化策略,进一步发掘其在高级内存管理中的潜力。

# 5. 深入探索std::make_shared的性能优化

## 5.1 内存分配器的自定义

### 5.1.1 标准内存分配器的局限性

在现代C++中,标准内存分配器是默认的选择,它被设计为足够通用,以应对多种不同的内存管理场景。然而,由于它需要覆盖如此广泛的使用案例,这往往意味着它可能不是在所有特定情况下性能最优的选择。当处理大量小对象或需要特定内存对齐时,标准分配器的性能可能会受限。

例如,标准分配器在分配大量小对象时,可能会因为频繁的内存请求而产生大量的内存碎片。这些碎片不仅降低了内存的利用效率,还会在某些情况下降低程序的运行速度。此外,标准分配器默认不支持自定义内存对齐,这在某些硬件上会成为性能瓶颈。

### 5.1.2 自定义内存分配器的优势

为了克服标准内存分配器的这些局限性,C++提供了自定义内存分配器的能力。通过实现`std::allocator`接口,开发者可以创建专门的内存分配器来优化特定应用的内存管理行为。

自定义内存分配器可以根据应用程序的需要进行优化。例如,在处理大量小对象时,可以使用预先分配的大块内存,并通过自定义分配器实现一个对象池来减少碎片。对于需要特殊内存对齐的场景,自定义内存分配器可以请求特定对齐的内存块,从而提高性能。

自定义内存分配器不仅可以提高内存管理的效率,还可以增加程序的可预测性。由于它们是由开发者控制的,因此可以根据需要精确地监控和调整内存分配行为。

### 5.1.3 自定义内存分配器的代码实现示例

```cpp

#include <memory>

template<typename T>

class MyAllocator {

public:

using value_type = T;

MyAllocator() noexcept = default;

template<typename U>

MyAllocator(const MyAllocator<U>&) noexcept {}

T* allocate(std::size_t n) {

if (n > static_cast<std::size_t>(-1) / sizeof(T)) {

throw std::bad_alloc();

}

void* p = operator new(n * sizeof(T));

return static_cast<T*>(p);

}

void deallocate(T* p, std::size_t n) noexcept {

operator delete(p);

}

template<typename U, typename... Args>

void construct(U* ptr, Args&&... args) {

::new(static_cast<void*>(ptr)) U(std::forward<Args>(args)...);

}

template<typename U>

void destroy(U* ptr) {

ptr->~U();

}

};

// Usage example

int main() {

std::vector<int, MyAllocator<int>> myVector(100);

return 0;

}

```

在这个例子中,`MyAllocator`是一个自定义的内存分配器,它重载了`allocate`和`deallocate`方法以自定义内存的分配和回收。同时,通过模板方法`construct`和`destroy`,它还提供了自定义对象构造和析构的能力。

### 5.1.4 自定义内存分配器的性能优化逻辑分析

在上面提供的自定义内存分配器示例中,开发者需要考虑如何实现`allocate`和`deallocate`方法以实现性能优化。例如,在`allocate`方法中,如果可以确定分配的对象大小不会导致溢出问题(如上例所示),则可以直接使用`operator new`进行内存分配,这是一种简单且直接的方法。

对于需要频繁分配和释放大量小对象的情况,可以考虑使用内存池技术。在`deallocate`方法中,可能不需要实际释放内存,而是回收到内存池中供下一次使用。这样的实现可以显著减少由于频繁调用操作系统的内存分配和释放接口而产生的开销。

请注意,自定义内存分配器可能会引入额外的复杂性,并可能需要与应用程序的特定部分紧密集成,这意味着它们通常用于性能关键部分,而不是整个应用程序。在实现自定义内存分配器时,开发者应该小心测试其性能提升,以确保它们确实为特定的使用案例带来了改进。

## 5.2 优化内存对齐

### 5.2.1 内存对齐的概念

内存对齐是指内存地址的整数倍,对于某些数据类型来说,如果其在内存中的起始地址是其类型的大小(或者一个更大的2的幂次倍)的倍数,则认为该数据类型得到了良好的对齐。良好的对齐可以提高访问速度,因为现代处理器通常可以更快地处理对齐的数据。

处理器访问未对齐的内存时,可能会导致性能下降,因为它需要执行更多的指令来处理这些数据。在某些情况下,未对齐的内存访问可能还会触发硬件异常。

### 5.2.2 通过std::make_shared实现内存对齐

使用`std::make_shared`时,可以通过模板参数来指定内存对齐的要求。`std::aligned_storage`是一个工具,可以用于获取类型所需的对齐空间,而不会实际构造任何对象。

```cpp

#include <memory>

#include <iostream>

template <std::size_t alignment, typename T>

std::shared_ptr<T> make_aligned_shared() {

// 使用std::aligned_storage来请求对齐的存储空间

auto sp = std::shared_ptr<T>(new(std::aligned_storage<sizeof(T), alignment>::type) T,

[](void* p) {

static_cast<T*>(p)->~T();

std::free(p);

});

return sp;

}

struct alignas(16) AlignedType {

int8_t buffer[16];

};

int main() {

auto aligned = make_aligned_shared<16, AlignedType>();

return 0;

}

```

在上面的代码中,`make_aligned_shared`函数模板使用`std::aligned_storage`来为`T`类型的对象请求对齐的内存空间。构造函数的lambda表达式用于删除动态创建的对象。

### 5.2.3 内存对齐的性能测试与分析

要测试内存对齐的实际性能影响,需要编写基准测试程序来比较不同对齐策略下的性能差异。比较对象包括对齐内存的创建、销毁以及读写操作的性能。基准测试应该在控制了其他所有变量的情况下进行,以确保结果的准确性和可重复性。

基准测试应该关注关键指标,如内存分配的速度、内存访问的速度以及整体程序的运行时间。这些测试结果可以帮助开发者了解对齐内存是否真的提高了性能,并且在何种程度上提高了性能。

## 5.3 性能测试与分析

### 5.3.1 基准测试的设置与执行

性能基准测试是任何优化过程中的关键部分。在进行性能测试时,首先需要定义测试目标和基准测试的范围。然后,编写测试用例,并确保它们能够在相同的环境和条件下重复执行。

为了评估`std::make_shared`的性能,基准测试应该涵盖各种不同大小和类型的对象创建和销毁操作。测试案例应该包括但不限于:

- 单独对象的创建和销毁

- 使用`std::make_shared`创建对象

- 使用自定义分配器的`std::make_shared`对象创建

- 内存对齐影响下的对象创建

此外,基准测试还应该包括异常安全性的考虑,例如在构造函数抛出异常时的资源清理行为。

### 5.3.2 std::make_shared的实际性能表现

基准测试完成后,需要对测试结果进行分析。这通常包括比较不同实现的执行时间、内存使用情况和异常安全性表现。通过这些数据,可以得出`std::make_shared`在特定场景下的性能表现。

例如,在处理大量小对象时,`std::make_shared`可能会比单独使用`new`关键字更快,因为`std::make_shared`会减少内存分配的次数,使用单个内存块来存储对象数据和引用计数。然而,对于大对象,这种优势可能会消失,因为对齐和额外引用计数的空间可能会抵消优化的收益。

性能测试和分析可以帮助开发者决定在特定的使用案例中是否应该使用`std::make_shared`。这不仅包括直接的性能表现,还包括代码的可维护性和可读性。

基准测试应定期重新进行,特别是在代码或硬件环境发生变化时,以确保性能评估的结果仍然是最新的。这是确保`std::make_shared`和任何其他性能优化措施持续有效性的关键部分。

# 6. C++内存管理的未来趋势与展望

## 6.1 C++11以后的内存管理工具

C++11引入了新的内存管理工具,如 `std::unique_ptr` 和 `std::weak_ptr`,这不仅提高了代码的安全性,而且让内存管理更加灵活和方便。`std::unique_ptr` 管理一个对象,确保同一时间只有一个所有者拥有该对象,当 `unique_ptr` 被销毁时,它所拥有的对象也会自动被释放。而 `std::weak_ptr` 则是 `std::shared_ptr` 的辅助工具,它不拥有指针的所有权,用于解决 `shared_ptr` 造成的循环引用问题。

在C++17和C++20中,标准库又引入了一系列新特性来进一步改进内存管理。C++17添加了 `std::make_unique` 和 `std::make_shared` 的异常安全版本,为创建智能指针提供了更为安全的方法。此外,C++20引入了对协程的支持,并提供了 `std::pmr`(polymorphic memory resources),这使得内存管理器可以是多态的,应用程序可以定制内存资源,以适应不同的性能和资源限制情况。

### 代码示例:使用 `std::unique_ptr`

```cpp

#include <memory>

#include <iostream>

void example_function() {

std::unique_ptr<int> ptr(new int(10));

std::cout << *ptr << std::endl;

// ptr 在这里会自动释放内存

}

int main() {

example_function();

return 0;

}

```

## 6.2 内存管理的未来方向

随着编程实践的发展,内存管理正朝着更加自动化和智能化的方向发展。未来的C++可能会进一步整合现代编程范式,比如函数式编程和响应式编程,以及增强的并发支持,这将导致内存管理变得更加透明和高效。

### 自动内存管理的可能性

自动内存管理或垃圾收集是编程语言中常见的功能,许多现代语言如Java和Python都使用了这种方式。对于C++而言,虽然目前主要依赖开发者手动管理内存,但是通过智能指针和内存分配器的改进,可以逐步向自动内存管理靠拢。例如,通过一些智能分析技术来预测对象的生命周期,从而减少内存泄漏和悬挂指针的风险。

### 与现代编程范式的融合

现代编程范式如反应式编程,强调数据流和变化传播,这要求内存管理系统能够在不影响性能的前提下,有效管理大量的短期生命周期的对象。与这些范式结合,C++需要提供更为丰富的内存管理工具和策略,以适应不同的应用场景。同时,C++社区也在不断探索将内存管理集成到编译器和运行时的可能性,以提高程序的可靠性和开发者的工作效率。

在当前阶段,C++开发者需要紧密关注语言标准的更新,同时积极利用现有的内存管理工具和最佳实践,以确保编写出既高效又安全的代码。随着C++的不断发展,我们可以期待未来的内存管理将会更加智能和自动化,为开发者带来更加友好的编程体验。

0

0