【高维数据降维挑战】:PCA的解决方案与实践策略

发布时间: 2024-11-22 23:53:24 阅读量: 85 订阅数: 30

# 1. 高维数据降维的基本概念

在现代信息技术和大数据飞速发展的背景下,数据维度爆炸成为了一项挑战。高维数据的降维可以理解为将高维空间中的数据点投影到低维空间的过程,旨在简化数据结构,降低计算复杂度,同时尽可能保留原始数据的重要特征。

高维数据往往具有以下特点:

- **维度灾难**:当维度数量增加时,数据点在高维空间中的分布变得稀疏,这使得距离和密度等概念变得不再适用。

- **计算开销**:高维数据处理所需时间和资源随着维度的增加呈指数级增长。

- **噪声敏感性**:高维空间中的数据可能包含大量无关紧要的特征,这些特征会干扰数据的本质结构。

为了解决这些问题,数据降维技术应运而生。降维不仅可以减小计算量,还能提高机器学习模型的性能,增强数据可视化的效果。接下来我们将深入探讨PCA降维技术,它是目前最受欢迎的降维方法之一。

# 2. PCA降维理论详解

## 2.1 主成分分析(PCA)的数学原理

### 2.1.1 数据向量和协方差矩阵

在PCA的数学模型中,原始数据首先被表示为一个多维向量空间中的集合。每个数据点是该空间中的一个向量,而数据集则可以看作是一组向量的集合。在分析之前,数据通常需要中心化,即将每个特征的平均值设为零。这样做的目的是为了消除不同特征间数量级的差异,便于后续处理。

数据集在进行中心化处理后,可以构建协方差矩阵。协方差矩阵反映的是数据中各个特征之间的线性相关程度。如果两个特征之间是完全线性相关的,协方差矩阵的对应项将是最大值;如果两个特征之间不相关,则对应项为零。

```python

import numpy as np

# 假设X是中心化后的数据矩阵,每一列是一个特征

X_centered = X - np.mean(X, axis=0)

# 计算协方差矩阵

cov_matrix = np.cov(X_centered, rowvar=False)

```

上述代码首先对数据集X进行了中心化处理,然后计算了协方差矩阵。协方差矩阵的每个元素表示的是对应两列(特征)之间的协方差。

### 2.1.2 特征值和特征向量的角色

在PCA中,特征值和特征向量扮演着核心角色。特征值的大小表示了在对应特征向量方向上的数据方差大小。特征值越大,说明该方向上的数据变化程度越大,这个方向上的信息量也就越多。主成分分析就是要找到那些方差最大的方向,它们代表了数据中的主要变化。

```python

# 计算协方差矩阵的特征值和特征向量

eigenvalues, eigenvectors = np.linalg.eigh(cov_matrix)

```

在这段代码中,`eigh`函数用于计算对称或厄米特矩阵的特征值和特征向量。特征向量按对应特征值的大小排序。

### 2.1.3 方差解释与主成分选取

主成分分析的目的是识别数据中的主要变化方向,并以尽可能少的成分来解释数据的方差。第一个主成分是具有最大方差的方向,第二个主成分是在与第一个主成分正交的条件下具有最大方差的方向,以此类推。

为了确定需要保留多少个主成分,通常会计算每个主成分解释的方差比例,并绘制一个累积方差解释图。选择那些累积贡献率达到一定阈值(如85%或90%)的主成分。

```python

# 计算每个主成分解释的方差比例

explained_variance = eigenvalues / np.sum(eigenvalues)

# 对应的特征向量

eigenvectors = eigenvectors[:, -explained_variance.size:]

# 累积方差解释图

plt.plot(np.cumsum(explained_variance))

plt.xlabel('Number of components')

plt.ylabel('Cumulative explained variance')

plt.show()

```

在这段代码中,我们首先计算了每个特征值占总特征值和的比例,然后选择了对应累积贡献率的特征向量。最后,绘制了一个累积方差解释图,帮助我们确定需要保留的主成分数量。

## 2.2 PCA算法的步骤和流程

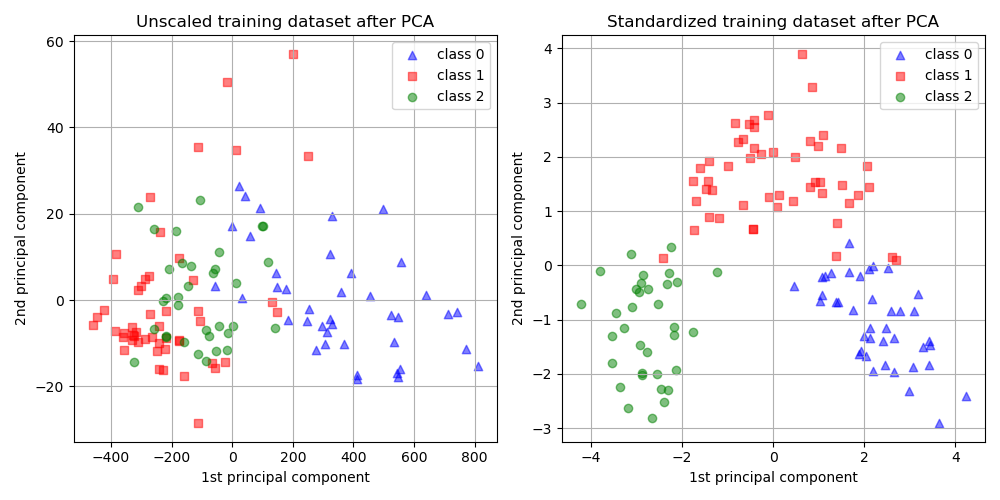

### 2.2.1 数据预处理和标准化

数据预处理是进行PCA之前非常关键的一步。在这一步骤中,需要处理数据集中的缺失值、异常值等。对于数值型数据,通常需要进行标准化处理,即将数据按其均值和标准差进行归一化,使得每个特征的均值为零,标准差为一。

### 2.2.2 计算协方差矩阵和特征值分解

在预处理后的数据上,计算协方差矩阵并进行特征值分解。特征值分解的结果将给出数据在不同方向上的方差大小和对应的特征向量。

### 2.2.3 确定主成分和构建投影矩阵

根据特征值分解的结果,我们可以确定哪些特征向量对应于最大的特征值,并以此构建投影矩阵。这个矩阵将用于将原始数据投影到选定的主成分上,从而得到降维后的数据。

## 2.3 PCA降维的理论限制与改进方法

### 2.3.1 PCA的局限性分析

尽管PCA是一种强大的工具,但它也有其局限性。例如,PCA依赖于协方差矩阵的计算,这要求数据样本数量要大于特征数量。此外,PCA对非线性结构的数据效果不佳。

### 2.3.2 相关扩展算法介绍

面对PCA的局限性,研究人员提出了许多扩展算法。例如,核PCA(Kernel PCA)使用核技巧将数据映射到更高维的空间中,在那里线性降维是可能的。

### 2.3.3 实际应用中的改进策略

在实际应用中,可以采取多种策略来改进PCA的效果。例如,通过特征工程来提取更有意义的特征,或者结合其他机器学习方法来提升数据的解释能力。此外,对于数据预处理步骤,也可以采取多种方法来优化,如使用不同的缩放策略或去除噪声。

# 3. PCA降维实践应用

## 3.1 数据预处理和标准化实践

### 3.1.1 缺失值处理

在应用PCA之前,数据预处理是非常关键的步骤。因为PCA是基于协方差矩阵来提取数据的主成分,所以任何含有缺失值的记录都需要被妥善处理,以避免影响整体分析的准确性。在Python中,可以使用`pandas`库来处理数据集中的缺失值。

```python

import pandas as pd

# 读取数据集

df = pd.read_csv('data.csv')

# 检测并处理缺失值

df.fillna(df.mean(), inplace=True) # 使用均值填充缺失值

# 或者使用

df.dropna(inplace=True) # 删除含有缺失值的记录

```

### 3.1.2 特征缩放和标准化技术

处理完缺失值后,需要对数据进行特征缩放和标准化,确保数据在PCA分析中不会被某个数值范围特别大的特征所支配。在PCA中,常用的方法是标准化(Z-score标准化),将数据集中的每一个特征转换为均值为0,方差为1的形式。

```python

from sklearn.preprocessing import StandardScaler

# 假设df是已经处理好缺失值的DataFrame

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df)

```

## 3.2 PCA降维代码实现

### 3.2.1 Python中的PCA实现

Python的`scikit-learn`库提供了非常方便的PCA实现。下面是一个基础的PCA降维的代码示例。

```python

from sklearn.decomposition import PCA

from sklearn.datasets import load_iris

# 加载数据集

iris = load_iris()

X = iris.data

y = iris.target

# 初始化PCA对象,设置要保留的主成分数量

pca = PCA(n_components=2)

# 执行PCA

X_pca = pca.fit_transform(X)

# 查看降维后的数据

print(X_pca)

```

### 3.2.2 R语言中的PCA实现

在R语言中,可以使用`prcomp`或`princomp`函数实现PCA。

```R

# 加载数据集

data(iris)

# 执行PCA

pca_result <- prcomp(iris[,1:4], scale. = TRUE)

# 查看结果

summary(pca_result)

```

### 3.2.3 应用案例分析

在实际应用中,如在股票市场分析中,我们可能想要通过PCA分析来识别股票价格的主要影响因素。以下是一个简化的案例。

```R

# 加载股票价格数据集

stock_prices <- read.csv("stock_prices.csv")

# 执行PCA

pca <- prcomp(stock_prices[,2:ncol(stock_prices)], scale. = TRUE)

# 绘制方差解释率

plot(pca)

```

## 3.3 PCA降维后的数据评估

### 3.3.1 累计方差贡献率的分析

在确定最终保留的主成分数量时,累计方差贡献率是一个重要指标。它表示保留的主成分对原始数据方差的总解释度。

```python

import matplotlib.pyplot as plt

# 使用之前得到的PCA对象

pca = PCA(n_components=10)

pca.fit(X)

# 绘制累计方差贡献率

plt.plot(range(1, 11), pca.explained_variance_ratio_.cumsum(), marker='o')

plt.xlabel('Number of Components')

plt.ylabel('Cumulative Explained Variance')

plt.show()

```

### 3.3.2 维度选择的可视化方法

在选择保留的主成分数量时,可视化累计方差贡献率是一个直观的方法。

```R

# 使用之前得到的PCA结果

plot(pca_result)

```

### 3.3.3 后续分析的准备

降维后,根据具体业务需求,可能需要对降维后的数据进行进一步的分析,比如聚类分析、回归分析等。

```python

from sklearn.cluster import KMeans

# 假设X_pca是降维后的数据

kmeans = KMeans(n_clusters=3)

kmeans.fit(X_pca)

```

在实际

0

0