爬虫与API数据抓取:合理合法使用API获取数据

发布时间: 2024-12-06 20:02:52 阅读量: 13 订阅数: 15

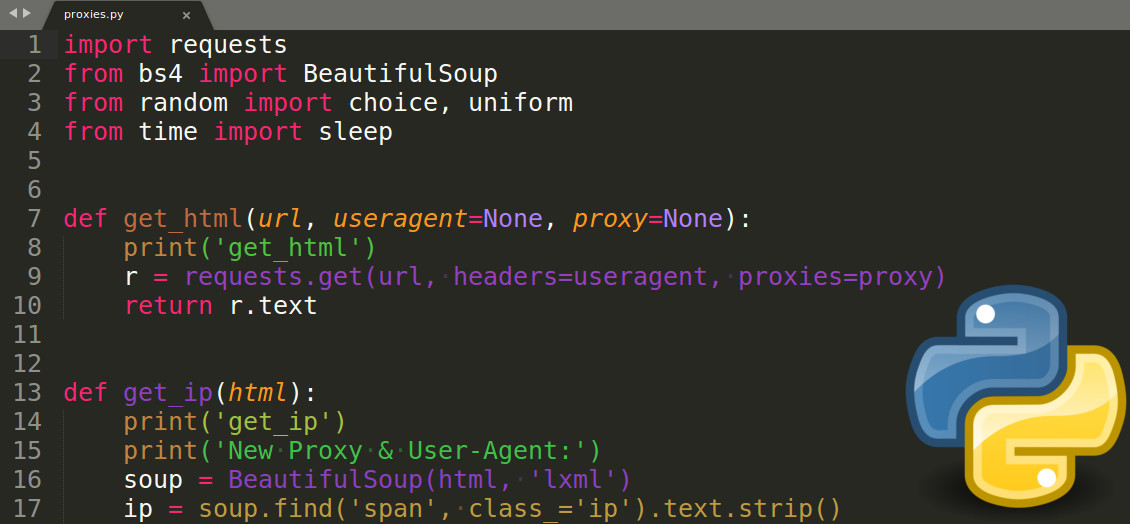

python爬虫抓取网页数据.docx

# 1. 爬虫与API数据抓取概述

## 1.1 爬虫技术简述

爬虫(Web Crawler)是一种自动获取网页内容的程序,它通过网络爬取网页数据,以供分析或存储。随着互联网信息的爆炸式增长,爬虫技术已成为数据科学家、市场分析师等专业人士的重要工具。爬虫技术的使用需严格遵守法律法规和网站的robots.txt协议,以确保数据抓取的合法性和道德性。

## 1.2 API数据抓取的优势

相比传统爬虫,API数据抓取具有明显优势。API(Application Programming Interface)是应用程序接口的缩写,它提供了一种标准方式来让应用程序之间进行交互。API数据抓取能够以结构化的形式直接获取数据,避免了复杂的网页解析过程,提高了数据抓取的效率和准确性。此外,API通常会提供更多的数据访问权限,并且在数据抓取过程中更加稳定和可靠。

## 1.3 爬虫与API抓取的并行使用

在实际工作中,爬虫和API抓取技术往往需要并行使用。爬虫可以应对那些没有提供API接口或者API功能有限的网站,通过解析HTML页面来抓取所需数据。而对于提供API的网站,使用API进行数据抓取则更为高效和安全。因此,掌握这两种技术能够灵活应对不同的数据抓取需求,是数据抓取工作中的重要技能。

# 2. API的工作原理及其数据抓取

## 2.1 API基础知识

### 2.1.1 什么是API及其工作原理

API,即应用程序编程接口(Application Programming Interface),是连接两个软件的中间件,允许软件之间相互交互。API通过一组规则(通常为HTTP请求)定义了软件之间的交互方式,使得开发者无需从头开始编写程序,而是能够使用现有的软件功能。API可以用来请求数据、执行命令、上传文件等。

在数据抓取领域,API是一种常用的技术手段。例如,当你使用一个社交媒体平台(如Twitter或Facebook)的应用程序时,你实际上是在使用该平台提供的API,应用程序通过API获取数据并向平台发送命令。而第三方开发者也可以利用API在无需直接访问数据库的情况下获取数据。

API工作原理通常遵循以下步骤:

1. **请求**:客户端发送HTTP请求到API端点,请求信息可以包含查询参数、头部信息、认证凭证等。

2. **处理**:服务器接收到请求后,根据请求中的信息进行处理。

3. **响应**:服务器处理完毕后,发送一个HTTP响应回客户端,响应内容通常为JSON或XML格式的数据。

```mermaid

sequenceDiagram

participant 客户端

participant 服务器

客户端->>服务器: 发送HTTP请求

Note right of 服务器: 请求处理

服务器-->>客户端: 返回HTTP响应

```

### 2.1.2 API的类型和使用场景

API的类型多种多样,根据其用途可以分为以下几种:

- **Web服务API**:如RESTful和SOAP,通过HTTP协议传输数据,允许不同的应用程序进行交互。

- **数据库API**:允许用户与数据库进行交互,如ODBC、JDBC等。

- **硬件API**:与硬件设备通信的接口,如打印机API、摄像头API等。

使用场景方面,API的应用极为广泛:

- **Web开发**:通过API从外部服务获取数据,例如天气信息、股票价格等。

- **移动应用**:移动应用通常利用API与后端服务器通信,获取用户数据或上传信息。

- **软件集成**:将多个软件的功能集成到一个程序中,提高工作效率。

## 2.2 API数据抓取的合法性和道德约束

### 2.2.1 合法性问题的界定

API数据抓取的合法性取决于多个因素,包括API的使用条款、数据的版权归属以及数据的使用方式等。通常,大多数API服务会在其使用条款中明确数据的使用限制。作为开发者或数据抓取者,必须仔细阅读并遵守这些条款,以避免潜在的法律风险。

在合法使用API数据时,需要注意以下几个方面:

- **服务条款**:理解并遵守API提供者的服务条款。

- **数据归属权**:尊重并保护数据归属者的版权和隐私权。

- **用户授权**:当涉及到个人数据时,确保已获得用户的明确授权。

### 2.2.2 道德约束与数据抓取的边界

数据抓取不仅需要合法,还应该符合道德约束。道德约束是数据抓取的非法律边界,主要涉及隐私保护和数据使用的合理性。

- **隐私保护**:在抓取数据时,不应侵犯个人隐私,如个人身份信息、私人通信等。

- **数据滥用**:不应当滥用数据,例如将数据用于不正当竞争、歧视性行为等。

道德约束在实际操作中很难具体界定,但以下做法是推荐的:

- **透明度**:对数据收集和使用的目的进行公开说明。

- **控制权**:给予用户对其数据的控制权,如提供数据删除的选项。

- **最小化**:仅收集完成任务所必需的数据,避免过度抓取。

## 2.3 实践:使用RESTful API获取数据

### 2.3.1 RESTful API的基本概念

RESTful API是一种基于REST架构风格的Web服务API,它使用HTTP标准方法实现API接口。RESTful API遵循无状态原则和统一接口原则,通过资源的URL进行标识,使用HTTP动词(GET、POST、PUT、DELETE等)描述操作。

RESTful API的一些关键概念:

- **资源**:Web上的任何可标识信息都是资源,例如一个用户、一张图片等。

- **资源标识符**:每个资源都有唯一的URL标识。

- **表现**:资源的数据表示,通常为JSON或XML格式。

### 2.3.2 实际操作:Python中的requests库

在Python中,可以通过requests库来访问RESTful API。Requests是一个优雅且简单的HTTP库,用于发送HTTP/1.1请求。

以下是一个使用Python requests库访问RESTful API的示例:

```python

import requests

# 示例:获取GitHub公开的用户信息

url = 'https://api.github.com/users/octocat'

response = requests.get(url)

# 检查响应状态码

if response.status_code == 200:

# 解析响应内容(假设响应体是JSON格式)

data = response.json()

print(data)

else:

print('Failed to retrieve data:', response.status_code)

```

代码解释:

1. 导入requests库。

2. 设置要访问的URL。

3. 使用`requests.get()`方法发送GET请求。

4. 检查HTTP响应状态码,如果是200表示请求成功。

5. 解析响应内容,假设响应体是JSON格式。

### 2.3.3 错误处理与异常管理

在使用API进行数据抓取时,可能会遇到各种异常情况,如网络问题、服务端错误、数据格式错误等。良好的错误处理和异常管理机制对于保证程序的健壮性和用户体验至关重要。

以下是一些常见的错误处理方法:

- **网络异常**:捕获网络请求过程中可能发生的异常,如连接超时、网络断开等。

- **服务端错误**:根据HTTP响应状态码进行错误处理,如404表示未找到资源,500表示服务器内部错误。

- **数据格式问题**:解析数据时可能发生的格式错误或数据不完整等问题,需要妥善处理。

示例代码:

```python

try:

response = requests.get(url)

response.raise_for_status() # 如果响应状态码表明请求失败,则抛出HTTPError异常

data = response.json()

except requests.exceptions.HTTPError as errh:

print("Http Error:", errh)

except requests.exceptions.ConnectionError as errc:

print("Error Connecting:", errc)

except requests.exceptions.Timeout as errt:

print("Timeout Error:", errt)

except requests.exceptions.RequestException as err:

print("OOps: Something Else", err)

```

以上代码展示了如何使用try-except语句捕获并处理可能发生的异常。

通过本章节的介绍,我们可以了解到API的基本概念、工作原理以及在实际中如何使用Python进行RESTful API的数据抓取。下一章,我们将深入探讨API数据抓取的高级技巧,包括API调用的认证机制、数据抓取中的速率限制和异常处理等。

# 3. API数据抓取的高级技巧

## 3.1 API调用的认证机制

### 3.1.1 API密钥与OAuth

在进行高级API调用时,认证机制是确保数据安全和

0

0