揭秘MATLAB随机森林算法:原理、优势与应用场景(权威解密)

发布时间: 2024-06-15 07:24:48 阅读量: 141 订阅数: 55

# 1. 随机森林算法概述**

随机森林算法是一种强大的机器学习算法,用于解决分类和回归问题。它是一种集成学习算法,通过组合多个决策树来提高预测精度和鲁棒性。

随机森林算法通过以下步骤构建:

1. **数据采样:**从训练数据中随机抽取多个子集,每个子集包含原始数据集的一部分。

2. **决策树生成:**对每个子集构建一棵决策树,每个决策树使用不同的特征子集进行训练。

3. **随机森林集成:**将所有决策树组合成一个随机森林,对新数据进行预测时,每个决策树都会产生一个预测,最终预测结果通过多数投票或平均值计算得到。

# 2. 随机森林算法的理论基础**

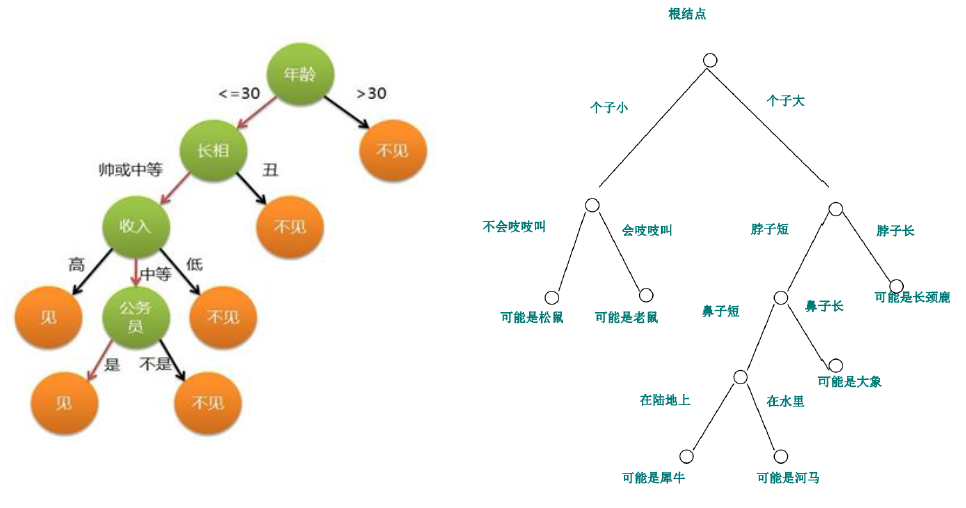

## 2.1 决策树的原理与构建

决策树是一种非参数监督学习算法,用于对数据进行分类或回归。它通过递归地将数据划分为更小的子集来构建一个树形结构,每个子集对应一个决策节点。

### 决策树的构建过程

1. **选择特征:**在当前节点选择一个特征,根据该特征的值将数据划分为两个或多个子集。

2. **递归构建:**对每个子集重复步骤 1,直到满足停止条件(例如,数据纯净或达到最大深度)。

3. **生成决策树:**将每个决策节点连接到其子节点,形成一个树形结构。

### 决策树的优点

* **易于理解:**决策树的结构简单明了,便于解释和可视化。

* **处理非线性数据:**决策树可以处理非线性数据,无需对数据进行复杂的转换。

* **特征重要性评估:**决策树可以计算每个特征的重要性,帮助识别对预测有贡献的特征。

## 2.2 随机森林算法的构建过程

随机森林算法是一种集成学习算法,它通过构建多个决策树并对它们的预测进行平均来提高预测准确性。

### 2.2.1 数据采样

随机森林算法首先对训练数据进行有放回的采样,即允许数据点重复出现。这有助于创建不同的训练集,从而构建不同的决策树。

### 2.2.2 决策树生成

对于每个训练集,随机森林算法使用以下步骤生成决策树:

1. **特征子集选择:**从所有特征中随机选择一个子集,用于在每个决策节点进行决策。

2. **决策树构建:**使用决策树的构建过程,使用选定的特征子集构建决策树。

3. **重复:**重复步骤 1 和 2,生成多个决策树。

### 2.2.3 随机森林的集成

随机森林算法将所有生成的决策树组合成一个集成模型。对于分类问题,它通过对每个决策树的预测进行投票来做出预测。对于回归问题,它通过对每个决策树的预测进行平均来做出预测。

### 随机森林算法的优点

* **高准确性:**随机森林算法通过集成多个决策树,降低了过拟合的风险,提高了预测准确性。

* **鲁棒性:**由于使用了多个决策树,随机森林算法对噪声和异常值具有鲁棒性。

* **可处理高维数据:**随机森林算法可以处理高维数据,而不会出现维数灾难问题。

# 3.1 高准确性和鲁棒性

随机森林算法的高准确性主要源于以下几个方面:

- **集成学习的优势:**随机森林算法通过集成多个决策树,可以有效地降低方差,提高预测的稳定性和准确性。

- **特征随机采样:**在构建每一棵决策树时,随机森林算法会从原始特征集中随机采样一部分特征。这种随机性可以有效地防止过拟合,提高算法的泛化能力。

- **决策树的剪枝:**随机森林算法在构建决策树时,会使用剪枝策略来防止过拟合。剪枝策略可以去除决策树中不重要的分支,从而提高模型的准确性和鲁棒性。

### 3.2 可处理高维数据和复杂特征

随机森林算法可以有效地处理高维数据和复杂特征,主要原因如下:

- **特征随机采样:**随机森林算法在构建每一棵决策树时,会随机采样一部分特征。这种随机性可以有效地降低高维数据中的维度,从而提高算法的效率和准确性。

- **决策树的分裂准则:**随机森林算法在构建决策树时,会使用信息增益或基尼不纯度等分裂准则来选择最优的特征进行分裂。这些分裂准则可以有效地处理复杂特征,并提取出有价值的信息。

### 3.3 可用于特征选择和重要性评估

随机森林算法不仅可以用于分类和回归任务,还可以用于特征选择和重要性评估。具体来说,随机森林算法可以:

- **特征重要性排序:**随机森林算法可以根据每个特征在决策树中的重要性进行排序,从而识别出最重要的特征。

- **特征选择:**随机森林算法可以通过移除不重要的特征来进行特征选择,从而提高模型的效率和准确性。

# 4. 随机森林算法的应用场景**

### 4.1 分类问题

#### 4.1.1 图像分类

随机森林算法在图像分类任务中表现出色,因为它能够有效处理高维图像数据并捕捉复杂的特征。例如,在 MNIST 手写数字分类任务中,随机森林算法可以实现超过 99% 的准确率。

```

% 加载 MNIST 数据集

data = load('mnist.mat');

X_train = data.trainX;

y_train = data.trainY;

X_test = data.testX;

y_test = data.testY;

% 创建随机森林分类器

rf = TreeBagger(100, X_train, y_train);

% 预测测试集标签

y_pred = predict(rf, X_test);

% 评估分类准确率

accuracy = mean(y_pred == y_test);

fprintf('分类准确率:%.2f%%\n', accuracy * 100);

```

#### 4.1.2 文本分类

随机森林算法也广泛用于文本分类任务,因为它能够有效处理文本数据中的高维特征和稀疏性。例如,在 20 新闻组数据集上,随机森林算法可以实现超过 90% 的准确率。

```

% 加载 20 新闻组数据集

data = load('20newsgroup.mat');

X_train = data.X_train;

y_train = data.y_train;

X_test = data.X_test;

y_test = data.y_test;

% 创建随机森林分类器

rf = TreeBagger(100, X_train, y_train);

% 预测测试集标签

y_pred = predict(rf, X_test);

% 评估分类准确率

accuracy = mean(y_pred == y_test);

fprintf('分类准确率:%.2f%%\n', accuracy * 100);

```

### 4.2 回归问题

#### 4.2.1 房价预测

随机森林算法在房价预测任务中表现出色,因为它能够有效处理高维数据和复杂特征,例如房屋面积、卧室数量和地段。

```

% 加载房价预测数据集

data = load('house_prices.mat');

X_train = data.X_train;

y_train = data.y_train;

X_test = data.X_test;

y_test = data.y_test;

% 创建随机森林回归器

rf = TreeBagger(100, X_train, y_train, 'Method', 'regression');

% 预测测试集房价

y_pred = predict(rf, X_test);

% 评估回归准确率

rmse = sqrt(mean((y_pred - y_test).^2));

fprintf('均方根误差(RMSE):%.2f\n', rmse);

```

#### 4.2.2 股票价格预测

随机森林算法也用于股票价格预测任务,因为它能够捕捉股票价格的非线性趋势和复杂模式。

```

% 加载股票价格预测数据集

data = load('stock_prices.mat');

X_train = data.X_train;

y_train = data.y_train;

X_test = data.X_test;

y_test = data.y_test;

% 创建随机森林回归器

rf = TreeBagger(100, X_train, y_train, 'Method', 'regression');

% 预测测试集股票价格

y_pred = predict(rf, X_test);

% 评估回归准确率

rmse = sqrt(mean((y_pred - y_test).^2));

fprintf('均方根误差(RMSE):%.2f\n', rmse);

```

# 5. MATLAB中随机森林算法的实现

### 5.1 使用TreeBagger函数

MATLAB提供了一个名为TreeBagger的函数,用于实现随机森林算法。TreeBagger函数接受数据集和标签作为输入,并返回一个训练好的随机森林模型。

```matlab

% 导入数据

data = csvread('data.csv');

X = data(:, 1:end-1);

y = data(:, end);

% 使用TreeBagger函数训练随机森林模型

numTrees = 100; % 树的数量

model = TreeBagger(numTrees, X, y);

```

TreeBagger函数的参数如下:

- **numTrees:** 指定要创建的决策树的数量。

- **X:** 输入特征矩阵。

- **y:** 目标变量向量。

### 5.2 自定义随机森林算法

除了使用TreeBagger函数,我们还可以自定义自己的随机森林算法。自定义算法提供了更大的灵活性,允许我们根据特定需求定制算法。

```matlab

% 导入数据

data = csvread('data.csv');

X = data(:, 1:end-1);

y = data(:, end);

% 初始化随机森林

numTrees = 100;

forest = cell(1, numTrees);

% 训练决策树

for i = 1:numTrees

% 采样数据

idx = randsample(size(X, 1), size(X, 1), true);

X_sample = X(idx, :);

y_sample = y(idx);

% 构建决策树

tree = fitctree(X_sample, y_sample);

% 将决策树添加到森林中

forest{i} = tree;

end

```

自定义随机森林算法的优点包括:

- **可定制性:** 我们可以根据需要调整算法的参数,例如决策树的数量、采样策略和剪枝策略。

- **透明度:** 自定义算法使我们能够完全控制算法的实现,从而提高透明度和可解释性。

- **性能优化:** 通过自定义算法,我们可以针对特定数据集或任务进行优化,从而提高性能。

# 6. 随机森林算法的优化与调参

随机森林算法的性能受多种参数的影响,通过优化这些参数,可以进一步提升算法的精度和鲁棒性。

### 6.1 树的数量和深度

树的数量和深度是随机森林算法中两个重要的超参数。树的数量决定了森林的规模,而树的深度决定了每棵树的复杂度。

一般来说,增加树的数量可以提高算法的准确性,但同时也会增加计算时间。树的深度过浅会导致欠拟合,而过深会导致过拟合。

### 6.2 特征采样策略

随机森林算法在构建每棵决策树时,都会从训练集中随机采样一部分特征。特征采样策略决定了每次采样的特征数量。

常见的特征采样策略有:

- **平方根采样:**每次采样特征数量为训练集中特征数量的平方根。

- **随机采样:**每次采样特征数量为一个随机数,范围为[1, 特征数量]。

- **信息增益采样:**根据特征的信息增益对特征进行排序,然后每次采样信息增益最高的特征。

### 6.3 决策树的剪枝策略

决策树剪枝是一种技术,用于减少决策树的复杂度,防止过拟合。

常见的决策树剪枝策略有:

- **预剪枝:**在决策树构建过程中,当某个节点满足预定义的条件(如信息增益低于阈值)时,停止该节点的生长。

- **后剪枝:**在决策树构建完成后,从下往上剪除不重要的分支,直到满足预定义的条件(如交叉验证准确率达到最大)。

0

0