PyTorch图像数据增强:最佳实践与小技巧

发布时间: 2024-12-12 05:36:41 阅读量: 11 订阅数: 11

B站刘二大人Pytorch课程学习笔记及课后作业

# 1. 图像数据增强的基础概念

在深度学习领域,数据增强是一项至关重要的技术,尤其是当可用的训练数据量有限时。通过数据增强,我们能够人为地扩充数据集,从而提高模型的泛化能力和鲁棒性。本章将介绍图像数据增强的基本概念、它的必要性和不同类型的增强技术。

数据增强的目的是通过对原始图像应用一系列变换来创造新的变体,而不改变图像的标注信息。这些变换可以是简单的翻转、旋转、缩放、平移,也可以是更复杂的颜色空间变换、随机裁剪或擦除等。不同的变换策略适用于解决不同问题,如过拟合、数据不足或不平衡数据集的情况。

理解数据增强背后的原理有助于我们更好地选择和应用适当的变换方法,以优化模型的训练效果。在接下来的章节中,我们将探讨PyTorch中的数据增强方法,如何构建有效的数据增强流水线,以及如何结合模型训练来实现数据增强的最佳实践。

# 2. PyTorch中的数据增强方法

## 2.1 基础变换操作

### 2.1.1 翻转和旋转

在PyTorch中,翻转和旋转是图像增强的两种常用基础变换操作。图像的翻转通常用于数据增强以增加数据多样性,而旋转操作则有助于模型学习在不同方向上的特征。以下示例代码展示了如何使用PyTorch中的`transforms`模块实现水平和垂直翻转、以及顺时针旋转图像。

```python

import torch

from torchvision import transforms as T

# 加载图像并将其转换为PILImage格式

image = PILImage.open('path_to_image.jpg')

# 创建变换组合:首先翻转图像,然后旋转

transform = T.Compose([

T.RandomHorizontalFlip(p=0.5), # 水平翻转概率为0.5

T.RandomVerticalFlip(p=0.5), # 垂直翻转概率为0.5

T.RandomRotation(degrees=(0, 90)) # 在0到90度之间随机旋转

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像(需要显示库如matplotlib)

```

**逻辑分析:** 上述代码首先导入了必要的模块,并加载了一张图像。然后,它定义了一个变换组合,包括随机水平翻转、随机垂直翻转和随机旋转。每个变换操作都有概率控制,以决定是否执行该操作。最后,应用定义的变换序列到加载的图像,并可以使用像matplotlib这样的库来显示结果。

### 2.1.2 缩放和平移

图像缩放和平移变换能够模拟相机移动或物体位置变化带来的视角变化,是数据增强中的重要组成部分。缩放操作可以改变图像的尺寸,而平移则在图像上进行水平或垂直移动。以下代码展示了如何使用`transforms`模块来实现这些变换。

```python

# 创建变换组合:缩放和平移

transform = T.Compose([

T.Resize(size=(200, 200)), # 缩放图像至200x200像素

T.RandomCrop(size=(180, 180)), # 在缩放后的图像上随机裁剪出180x180区域

T.RandomAffine(degrees=0, translate=(0.1, 0.1)) # 以较小的概率平移图像

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像

```

**逻辑分析:** 在这段代码中,图像首先被缩放到一个固定尺寸。接着,`RandomCrop`操作从缩放后的图像中随机裁剪出一个较小的区域。`RandomAffine`用于对图像执行仿射变换,这里设置为只进行平移,没有旋转或缩放(`degrees=0, scale=None`),而且平移的概率很小。这些变换能有效模拟真实世界中的图像变化,帮助模型提升鲁棒性。

## 2.2 高级变换技术

### 2.2.1 颜色空间变换

颜色空间变换通过改变图像的颜色表示方法来增强数据集。在PyTorch中,可以使用`transforms.ColorJitter`来实现颜色的随机变化,包括亮度、对比度、饱和度以及色调的调整。

```python

# 创建变换组合:颜色空间变换

transform = T.Compose([

T.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2, hue=0.1) # 调整亮度、对比度、饱和度和色调

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像

```

**逻辑分析:** `ColorJitter`是一个常用于数据增强的高级变换技术。在上述代码中,定义了变换组合来调整图像的亮度、对比度、饱和度和色调。这些参数可以设置为一个范围,意味着实际应用中颜色属性将在这个范围内随机变化,从而增加数据多样性。

### 2.2.2 随机裁剪和擦除

在深度学习训练过程中,随机裁剪可以通过抽取图像的子区域来增强数据集。此外,随机擦除是一种随机地在图像上引入遮挡,模拟现实世界中的遮挡问题,从而提高模型对遮挡物体识别的鲁棒性。

```python

# 创建变换组合:随机裁剪和擦除

transform = T.Compose([

T.RandomCrop(size=(128, 128)), # 随机裁剪出128x128像素的图像区域

T.RandomErasing(p=0.5, scale=(0.02, 0.33), ratio=(0.3, 3.3)) # 随机擦除操作,概率为0.5

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像

```

**逻辑分析:** 上述代码中使用了`RandomCrop`进行随机裁剪,并指定了裁剪后的大小为128x128像素。接着,使用了`RandomErasing`来实现随机擦除操作,该操作会随机地擦除图像的一部分。`RandomErasing`的参数`p`定义了擦除操作的概率,而`scale`和`ratio`则控制了擦除区域的大小和形状比例。这可以帮助模型学到在不完整信息条件下的识别能力。

## 2.3 自定义变换

### 2.3.1 使用Lambda变换

在PyTorch中,`transforms.Lambda`允许我们定义自己的自定义变换函数。这在需要进行一些非标准变换操作时非常有用。

```python

# 定义自定义变换函数

def custom_function(image):

image = image.filter(ImageFilter.SHARPEN) # 使用PIL库的Sharpen滤镜增强图像

return image

# 创建变换组合:使用Lambda变换

transform = T.Compose([

T.Lambda(lambda img: custom_function(img)) # 将自定义函数应用于图像

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像

```

**逻辑分析:** 这段代码展示了如何使用`Lambda`变换将自定义函数应用到图像上。在这个例子中,我们使用了PIL库的Sharpen滤镜来增强图像的边缘,这可以有助于提高模型对细节的识别能力。`Lambda`变换为我们提供了灵活性,可以进行几乎任何类型的自定义处理。

### 2.3.2 创建复合变换

当需要应用多个变换操作时,可以使用`transforms.Compose`来创建一个复合变换。这允许将多个变换步骤组合成一个单一操作,使得代码更加整洁且易于管理。

```python

# 创建复合变换组合:包括基础和高级变换

transform = T.Compose([

T.Resize(size=(224, 224)), # 将图像尺寸调整为224x224像素

T.RandomHorizontalFlip(), # 水平翻转图像

T.RandomRotation(degrees=(0, 90)), # 随机旋转图像

T.ColorJitter(brightness=0.5, contrast=0.5), # 调整图像的颜色

])

# 应用变换到图像

transformed_image = transform(image)

# 显示原始和变换后的图像

```

**逻辑分析:** 代码中的`Compose`方法将多个变换步骤组合在一起,形成一个复合变换。首先,图像被缩放到一个标准的输入尺寸,然后通过水平翻转、旋转和颜色变化操作进行增强。这种复合变换方式在实际应用中非常实用,因为我们可以简单地通过调用一个方法来执行一系列变换操作,提高了代码的可维护性和可读性。

# 3. PyTorch数据增强的最佳实践

在本章中,我们将深入探讨如何在实际项目中应用PyTorch提供的数据增强功能。我们将重点介绍构建高效的数据增强流水线、针对特定问题使用数据增强,以及将数据增强与模型训练结合起来的策略。

## 3.1 构建有效的数据增强流水线

构建一个有效的数据增强流水线是确保深度学习模型性能的关键步骤。在这个过程中,正确地选择和参数化数据增强策略可以显著提升模型的泛化能力。

### 3.1.1 确定流水线的组成

数据增强流水线通常由一系列不同的变换操作组成,每个操作都是流水线中的一个节点。在PyTorch中,使用`transforms`模块来定义流水线。一个基本的流水线可能包括裁剪、旋转、缩放和平移等变换。

```python

import torchvision.transforms as transforms

# 创建一个数据增强流水线的示例

data_augmentation_pipeline = transforms.Compose([

transforms.RandomCrop(64), # 随机裁剪图像到64x64大小

transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.RandomRotation(10), # 随机旋转图像

transforms.ColorJitter(brightness=0.1, contrast=0.1), # 随机调整亮度和对比度

])

```

在上面的代码示例中,我们首先导入了`torchvision.transforms`模块,并使用`Compose`方法创建了一个包含多个变换操作的流水线。每个操作都由一个具体的变换类实例化,这些变换将按顺序应用于每个图像。

### 3.1.2 调整流水线参数

构建数据增强流水线后,合理地调整每个变换操作的参数至关重要。参数的选择通常基于数据集的特性,以及模型对特定类型的变换的敏感度。

例如,对于图像分类任务,我们可能希望在不显著改变图像类别信息的前提下,增加图像的变异性和多样性。对于旋转操作,旋转角度的大小和是否允许水平翻转可能会根据具体情况进行调整。

```python

# 参数调整示例

data_augmentation_pipeline = transforms.Compose([

transforms.RandomCrop(64, padding=4), # 使用4像素的填充进行裁剪

transforms.RandomHorizontalFlip(p=0.5), # 50%的概率进行水平翻转

transforms.RandomRotation(10, resample=transforms.InterpolationMode.NEAREST), # 最近邻插值进行旋转

transforms.ColorJitter(brightness=0.1, contrast=0.1), # 固定调整亮度和对比度

])

```

在上面的代码中,我们为`RandomCrop`添加了4像素的填充,为`RandomHorizontalFlip`设置了50%的概率触发,同时指定了`RandomRotation`使用最近邻插值方法进行图像旋转,最后调整了颜色抖动的参数。

## 3.2 使用数据增强解决特定问题

数据增强不仅可以增加模型的泛化能力,还可以帮助我们解决特定问题,例如过拟合和不平衡数据集。

### 3.2.1 过拟合和数据不足

当训练数据有限时,过拟合成为训练深度学习模型的主要障碍之一。通过数据增强,我们可以人为地增加训练样本的多样性,从而减少过拟合的风险。

```python

import numpy as np

# 假设我们有一个小型训练集

class小型数据集:

def __init__(self):

self.images = np.zeros((10, 3, 32, 32)) # 10张32x32的图像

self.labels = np.zeros((10,)) # 10个标签

小型数据集 = 小型数据集()

# 数据增强流水线示例

data_augmentation_pipeline = transforms.Compose([

transforms.RandomCrop(32, padding=4),

transforms.RandomHorizontalFlip(),

transforms.RandomRotation(10),

])

# 通过流水线增强图像

增强图像列表 = [data_augmentation_pipeline(np.array(image)) for image in 小型数据集.images]

```

在这个例子中,我们模拟了一个小型数据集,并使用了简单的数据增强流水线来增加样本的多样性。实际应用中,可能需要尝试更复杂的变换和参数设置。

### 3.2.2 不平衡数据集

在处理分类问题时,数据集不平衡是一个常见问题。对于那些出现频率低的类别,模型往往缺乏足够的训练样本。数据增强可以用来增加这些类别的样本数量。

```python

# 假设我们有一个不平衡数据集

class不平衡数据集:

def __init__(self):

self.images = {

'类别A': np.zeros((10, 3, 32, 32)),

'类别B': np.zeros((5, 3, 32, 32))

}

self.labels = {

'类别A': np.zeros((10,)),

'类别B': np.zeros((5,))

}

不平衡数据集 = 不平衡数据集()

# 针对类别B使用更多的数据增强变换

增强类别B图像列表 = [data_augmentation_pipeline(np.array(image)) for image in 不平衡数据集.images['类别B']]

```

在上面的代码中,我们假设类别A的样本数量比类别B多,然后我们使用更复杂的数据增强操作来增加类别B的样本多样性,以便模型可以在类别B上获得更好的性能。

## 3.3 结合模型训练的数据增强策略

结合模型训练时,数据增强策略可以进一步优化。通过动态调整增强,我们可以在训练过程中实时反映数据集的特征。

### 3.3.1 在训练中动态调整增强

在训练过程中,可以通过调整数据增强的参数来更好地适应模型的学习状态。例如,随着训练的进行,可以逐渐增加图像的变换强度。

```python

# 动态调整增强的伪代码

for epoch in range(总训练周期):

for batch_idx, (images, labels) in enumerate(训练数据加载器):

# 基于epoch或batch_idx调整变换强度

# 如果当前epoch较早,则增加图像的变换强度

# 如果当前epoch已接近结束,则减少变换强度,以稳定模型训练

current_augmentation = dynamic_augmentation调整(images.size())

images = current_augmentation(images)

...

训练模型(模型, images, labels)

```

在这个伪代码示例中,我们引入了一个`dynamic_augmentation调整`函数,该函数根据当前训练的周期(epoch)或批次索引(batch_idx)动态调整数据增强策略。随着训练的深入,我们可以逐渐减少变换的强度,以帮助模型稳定下来。

### 3.3.2 预处理和在线增强的对比

预处理(Preprocessing)和在线增强(Online Augmentation)是数据增强的两种不同应用方式。预处理通常在数据加载时就完成,而在线增强是在训练过程中实时进行。

```mermaid

flowchart LR

A[原始数据] -->|预处理| B[预处理数据]

A[原始数据] -->|在线增强| C[在线增强数据]

B -->|训练循环| D[训练模型]

C -->|训练循环| D[训练模型]

```

- 预处理:在数据加载阶段完成所有的变换,之后将数据提供给模型进行训练。这种方法减少了训练过程中的计算开销,但限制了变换的灵活性。

- 在线增强:在模型训练过程中对每个批次的数据实时应用变换。这种方式可以提供更高的变换灵活性,但也引入了额外的计算负担。

选择哪种方法取决于模型的复杂性、计算资源以及训练时间的要求。通常,在训练初期使用在线增强以获得灵活性,而在后期切换到预处理以加快训练速度。

在本章中,我们探讨了构建高效数据增强流水线的方法、针对特定问题应用数据增强的策略,以及结合模型训练过程中的数据增强策略。接下来的章节,我们将继续深入了解PyTorch数据增强的小技巧和技巧,进一步提升数据处理和模型训练的能力。

# 4. PyTorch数据增强的小技巧和技巧

## 4.1 优化数据加载速度

### 4.1.1 使用多线程和多进程

在深度学习模型训练过程中,数据加载速度往往是限制整体训练效率的一个重要因素。PyTorch提供了多种方法来优化数据加载的速度,其中之一就是使用多线程和多进程。

PyTorch的`DataLoader`类允许我们通过设置`num_workers`参数来指定加载数据的进程数量。`num_workers`的默认值是0,表示在主进程中加载数据;当其设置为一个大于0的整数时,`DataLoader`会为数据集创建指定数量的工作进程。

为了利用多进程,推荐在你的系统上安装`ninja`库,因为它会加速PyTorch的C++扩展构建过程。以下是使用多进程加载数据的代码示例:

```python

from torch.utils.data import DataLoader

from torchvision import datasets

from torchvision.transforms import Compose, Resize, ToTensor

transform = Compose([Resize((224, 224)), ToTensor()])

dataset = datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

# 使用4个worker进程加载数据

data_loader = DataLoader(dataset, batch_size=64, shuffle=True, num_workers=4)

```

在这个例子中,`num_workers=4`意味着将有4个子进程用于并行数据加载。根据具体的硬件环境,选择一个合适的`num_workers`值可以显著加快数据加载的速度。

### 4.1.2 使用缓存和预加载

除了多线程和多进程之外,另一个提高数据加载效率的技巧是使用缓存。PyTorch允许我们将数据集预加载到内存中,避免在每个epoch结束时重复加载数据。这可以通过设置`DataLoader`的`pin_memory`和`persistent_workers`选项来实现。

`pin_memory`选项会将数据加载到固定内存中,这在GPU训练时可以加速数据传输。`persistent_workers`设置为True时,如果设置了`num_workers`大于0,则数据加载器的工作进程会在完成一次epoch后持续存在,而不会被销毁并重新创建。

```python

data_loader = DataLoader(dataset, batch_size=64, shuffle=True, num_workers=4, pin_memory=True, persistent_workers=True)

```

此外,对于数据集不经常变化的情况,可以考虑将数据集中的数据先转换为`torch.Tensor`类型,并保存到磁盘上,这样在训练过程中可以直接从磁盘读取预先处理好的数据,进一步提高速度。

## 4.2 集成外部库和工具

### 4.2.1 集成OpenCV进行图像预处理

在进行图像数据增强时,除了PyTorch自带的图像变换功能外,还可以利用外部库如OpenCV来实现更多样化的图像处理操作。OpenCV是一个强大的图像处理库,提供了大量高效的图像处理函数。

集成OpenCV到PyTorch数据增强流程中,首先需要安装OpenCV库:

```bash

pip install opencv-python

```

然后可以通过将图像转换为NumPy数组,使用OpenCV进行图像处理后再转换回张量:

```python

import cv2

import numpy as np

import torch

from torchvision import transforms

# 定义一个使用OpenCV的自定义变换

class OpenCVTransform:

def __call__(self, image):

image_np = np.array(image) # 将PIL图像转换为NumPy数组

image_np = cv2.cvtColor(image_np, cv2.COLOR_RGB2BGR) # 使用OpenCV转换颜色空间

image_np = cv2.resize(image_np, (224, 224)) # 使用OpenCV进行图像缩放

image = Image.fromarray(cv2.cvtColor(image_np, cv2.COLOR_BGR2RGB)) # 再转换回PIL图像

return transforms.ToTensor()(image) # 转换为PyTorch张量

```

在实际应用中,你可以通过这种方式轻松地添加自定义的OpenCV图像处理步骤到PyTorch的`transforms`管道中。

### 4.2.2 使用TensorBoard监控增强效果

TensorBoard是TensorFlow提供的一个强大的可视化工具,但同样可以与PyTorch一起使用,特别是在监控数据增强效果方面。

首先需要安装TensorBoard:

```bash

pip install tensorboard

```

在训练脚本中,可以通过以下方式将PyTorch的`DataLoader`与TensorBoard集成:

```python

from torch.utils.tensorboard import SummaryWriter

# 实例化SummaryWriter

writer = SummaryWriter(log_dir="runs/my_dataloader")

# 在DataLoader的迭代器上使用Writer

for i, data in enumerate(data_loader):

images, labels = data

grid = torchvision.utils.make_grid(images)

writer.add_image('images', grid, i)

writer.close()

```

在命令行中运行`tensorboard --logdir=runs`命令启动TensorBoard服务。在浏览器中打开显示的URL,就可以看到数据集的图像样本。通过这种方式,你可以直观地监控到数据增强的效果,如颜色变化、几何变换等是否按预期进行。

## 4.3 应用案例研究

### 4.3.1 实际应用中的数据增强策略

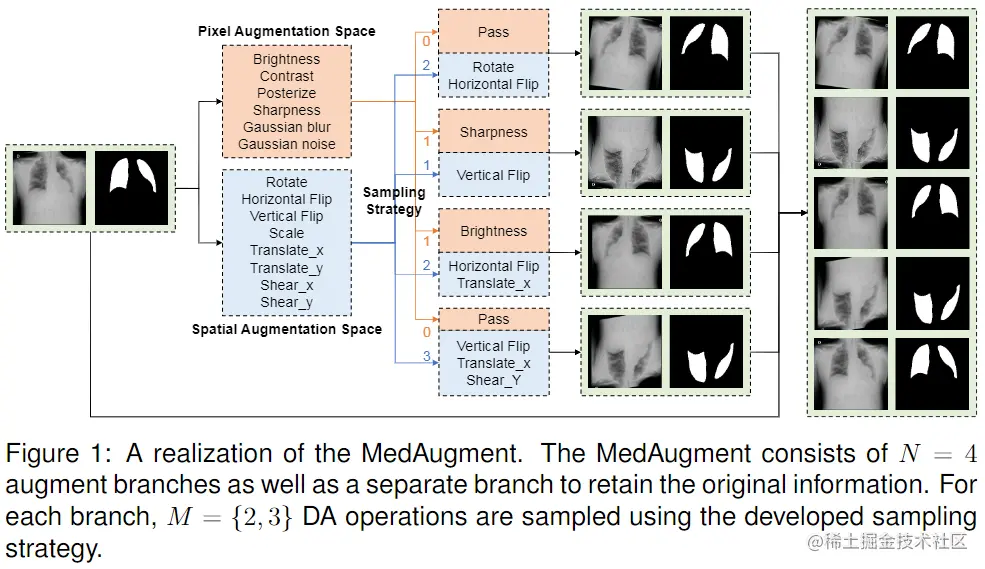

在实际应用中,数据增强往往需要结合特定问题来设计。以医疗影像分析为例,图像增强不仅要考虑增强数据的多样性,还要保证增强后的图像仍然保持医学诊断的准确性。例如,对于X光图像,可以使用旋转、缩放、裁剪等增强方法,但要确保解剖结构仍然清晰可识别。

下面是一个结合实际应用问题的数据增强策略的示例:

```python

from torchvision import transforms as T

transform_train = T.Compose([

T.RandomResizedCrop(224), # 随机裁剪并缩放

T.RandomHorizontalFlip(), # 随机水平翻转

T.RandomRotation(10), # 随机旋转

T.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2, hue=0.1), # 颜色抖动

T.ToTensor(),

])

```

### 4.3.2 从研究到生产环境的数据增强迁移

在将数据增强策略从研究环境迁移到生产环境时,需要特别注意保持增强操作的一致性和可重复性。在生产环境中,数据增强通常需要在模型部署阶段实时进行,这就要求增强操作既高效又稳定。

在迁移过程中,应避免使用如随机增强这类在每次运行时都产生不同结果的操作,除非它们对于模型训练至关重要。更常见的做法是预先生成大量的增强数据集,然后在生产环境中只使用固定的数据增强策略。

例如,在生产环境中,可以使用预定义的数据增强流水线:

```python

transform = T.Compose([

T.Resize(256),

T.CenterCrop(224),

T.ToTensor(),

])

```

这样,无论何时何地,应用这个`transform`都会得到一致的结果,从而保证生产环境中的模型表现与训练时保持一致。此外,应记录和保存每个增强步骤的详细信息,以便在必要时进行复现和调试。

以上章节内容展示了PyTorch数据增强中的高级技巧和实践案例,通过这些策略,可以进一步提升深度学习模型的性能和泛化能力。

# 5. 未来趋势和展望

随着深度学习模型复杂度的提升和数据集的日益庞大,数据增强技术也在不断进化以满足新的需求。在这一章节中,我们将探讨数据增强未来可能的发展方向,并审视PyTorch生态中可能出现的新兴工具。

## 数据增强的发展方向

### 自动化数据增强方法

为了应对日益增长的图像数据和有限的标注资源,自动化数据增强技术应运而生。它旨在自动寻找最优的数据增强策略,以最大化提升模型性能。自动化增强的核心挑战在于如何设计智能算法,能够根据模型反馈和数据特性自适应地选择或生成增强操作。

```python

from autoaugment import AutoAugment

# 创建自动化数据增强策略的示例

auto_aug = AutoAugment()

transform = transforms.Compose([

auto_aug,

transforms.ToTensor(),

])

```

### 增强方法的可解释性

随着模型变得越来越复杂,增强方法的可解释性成为了研究的热点。理解数据增强如何影响模型决策,可以帮助我们更好地设计和调整增强策略。目前已经有学者提出了一些方法来评估和解释数据增强对模型训练的影响。

```mermaid

graph TD;

A[数据增强策略] --> B[影响模型训练]

B --> C[特征表示变化]

C --> D[模型决策改变]

D --> E[可解释性分析]

```

## PyTorch生态中的新兴工具

### PyTorch相关数据增强库的更新

PyTorch生态中的数据增强库不断地更新和优化。例如,`albumentations`库就提供了一系列高级且快速的图像变换操作。该库的更新通常会加入新的变换方法和更快的执行速度,从而让研究人员和开发者更容易地集成先进的数据增强技术。

```python

import albumentations as A

from albumentations.pytorch import ToTensorV2

# 使用 albumentations 进行图像增强

transform = A.Compose([

A.HorizontalFlip(p=0.5),

A.ShiftScaleRotate(p=0.5),

ToTensorV2(),

])

```

### 集成学习和数据增强的结合

集成学习是机器学习领域的一个强大范式,它通过结合多个模型来提高最终的预测性能。随着研究的深入,集成学习与数据增强的结合已经成为提升模型鲁棒性的重要方向。通过这种结合,可以为模型提供更加多样化的训练数据,进而提高模型在面对新数据时的表现。

```python

from sklearn.ensemble import BaggingClassifier

from torchvision.models import resnet18

# 通过集成学习增强模型性能的示例

base_model = resnet18(pretrained=True)

ensemble_models = [base_model] * 5

# 实例化集成学习模型

ensemble_clf = BaggingClassifier(base_estimator=base_model, n_estimators=5)

```

尽管未来的发展充满变数,但可以预见的是,数据增强技术将继续演进,以适应不断发展的深度学习模型和日益增长的数据需求。通过自动化和集成学习等前沿方法的探索,数据增强将在未来的AI应用中扮演着越来越重要的角色。

0

0