MapReduce金融行业应用实战:风险分析与欺诈检测专家教程

发布时间: 2024-10-26 06:04:00 阅读量: 53 订阅数: 49

大数据实战项目教程等

# 1. MapReduce金融应用概述

MapReduce是大数据处理领域中的一种编程模型,它通过“映射(Map)”和“归约(Reduce)”两个步骤来处理大规模数据集。在金融行业中,MapReduce的应用主要集中在数据处理与分析上,如风险评估、欺诈检测、信用评分、报告生成等。MapReduce的并行处理能力使其在处理大量金融数据时表现出色,提高了处理速度并降低了成本。本文将概述MapReduce在金融领域的应用,并引导读者深入了解其理论基础和具体案例。

# 2. MapReduce理论基础与金融风险分析

## 2.1 MapReduce编程模型

### 2.1.1 MapReduce的工作原理

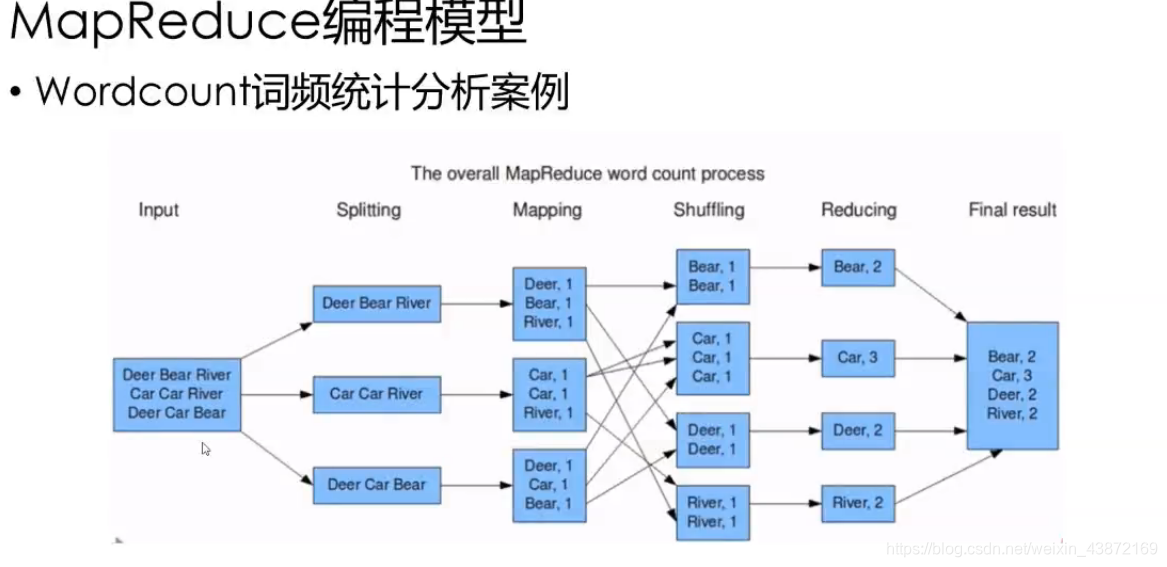

MapReduce是一种编程模型,用于处理和生成大数据集。它的核心思想是将计算任务分解成两个阶段:Map(映射)阶段和Reduce(归约)阶段。Map阶段处理输入数据,将它们转换成一系列中间键值对;Reduce阶段则对这些中间键值对进行合并处理,输出最终结果。

在MapReduce模型中,Map函数接收原始输入数据,并对其进行处理,输出中间键值对。这些键值对随后被传递到Reduce函数,后者对具有相同键的所有值进行合并处理,生成最终结果。MapReduce框架负责处理数据分片、任务调度、错误恢复等,从而简化了并行计算。

#### 关键组件:Mapper与Reducer

Mapper是MapReduce模型中的核心组件之一,它负责处理输入数据并输出键值对。每个Mapper独立运行,处理输入数据的一部分,其输出被排序并分组后发送到Reducer。

Reducer接收来自Mapper的键值对,并将具有相同键的值组合起来进行处理。Reducer的输出是最终的结果数据。它的工作是合并和转换中间数据,完成具体的数据聚合任务。

### 2.1.2 关键组件:Mapper与Reducer

在MapReduce框架中,Mapper和Reducer是两个关键的操作组件,它们共同协作以实现复杂的数据处理任务。

#### Mapper

Mapper处理的输入数据来自于数据源(如HDFS文件系统),它首先读取这些数据,然后进行一系列的处理,这包括数据清洗、过滤、映射等。处理之后,Mapper将数据转换成键值对的形式,这些键值对是中间数据的一部分,为之后的Reducer操作做准备。

每个Mapper的执行是独立的,它们处理数据的子集,互不干扰。例如,在处理日志文件时,不同的Mapper可以同时处理日志的不同部分。在Mapper阶段,数据被初步处理和分割,形成中间结果,为之后的汇总和聚合做准备。

#### Reducer

Reducer接收来自Mapper的中间结果,这些结果首先需要经过排序和分组,保证具有相同键的值聚集在一起。Reducer的任务是处理这些键值对集合,并进行聚合操作。例如,它可以计算每个键对应值的总和、平均值或其他统计信息。

Reducer通常有多个实例运行,但与Mapper不同的是,每个Reducer处理的是具有相同键的所有值。这样设计的目的是为了确保最终结果的全局一致性。在处理完所有中间数据后,Reducer输出最终结果。

## 2.2 金融风险分析的理论框架

### 2.2.1 风险分析的重要性与方法论

金融风险分析在投资决策、贷款评估、市场分析等金融活动中扮演着至关重要的角色。准确的风险评估能够帮助金融机构理解潜在的损失风险,制定相应的管理策略,从而保护资产安全,最大化投资回报。

风险分析的方法论包括定量分析和定性分析。定量分析侧重于使用统计和数学模型来衡量风险,例如计算标准差、VaR(Value at Risk)等。定性分析则依赖专家经验和市场情报来评估风险,例如考虑政治、经济等外部因素。

### 2.2.2 MapReduce在风险评估中的作用

MapReduce在金融风险评估中的作用体现在其对大数据的处理能力上。它能够对大规模的金融数据集进行并行计算,从而加速数据处理过程,提供实时或接近实时的风险分析结果。

使用MapReduce,金融机构可以处理如历史交易数据、市场趋势、信用记录等大量数据。这不仅有助于更准确地评估风险,而且能够基于最新的市场和交易情况,做出快速反应。例如,在信贷风险管理中,MapReduce可用于处理和分析大量借款人的信用历史数据,以预测违约概率。

## 2.3 MapReduce案例分析:信用评分

### 2.3.1 信用评分的数据处理流程

信用评分是评估借款人违约风险的重要手段。在信用评分的数据处理流程中,MapReduce可用于处理和分析大量的交易和行为数据,以便为借款人生成准确的信用评分。

在Map阶段,原始的信用数据会被加载到系统中,每个Mapper处理一部分数据,并输出中间键值对。这些键值对通常包括用户标识和相关特征数据。在Reduce阶段,所有具有相同用户标识的数据被汇总,并进行信用评分的计算。

### 2.3.2 实现与优化策略

实现MapReduce信用评分任务需要精心设计Map和Reduce函数,以确保算法的准确性。优化策略可能包括减少Map任务和Reduce任务之间的数据传输、优化数据存储格式以提高读写效率、并行化计算过程以缩短处理时间。

在实际应用中,可能需要对信用评分模型进行调优,以适应不同的业务场景和数据特性。例如,可以采用机器学习算法对信用评分模型进行训练,以识别和预测用户的风险行为。

### 系统设计与数据流程图

在设计一个基于MapReduce的信用评分系统时,需要确保数据流的高效处理。数据流程图可以展示数据如何从输入到Map任务,再到Reduce任务,最终生成信用评分。以下是数据流程图的一个简单示例。

```mermaid

graph LR

A[输入数据] -->|分割| B(Map任务)

B -->|键值对| C[排序]

C -->|分组| D(Reduce任务)

D -->|汇总| E[信用评分]

```

### 编程实践:MapReduce任务编写与部署

编写MapReduce任务需要对Hadoop的API有深入理解。以下是编写一个简单的MapReduce任务的基本框架:

```java

public class CreditScoreMap extends Mapper<LongWritable, Text, Text, IntWritable> {

public void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 处理输入数据,输出中间键值对

}

}

public class CreditScoreReduce extends Reducer<Text, IntWritable, Text, IntWritable> {

public void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

// 处理键值对,输出最终的信用评分

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

Job job = Job.getInstance(conf, "credit score");

job.setJarByClass(CreditScore.class);

job.setMapperClass(CreditScoreMap.class);

job.setReducerClass(CreditScoreRe

```

0

0