MapReduce自然语言处理应用:文本分析与模式识别进阶教程

发布时间: 2024-10-26 06:19:05 阅读量: 38 订阅数: 33

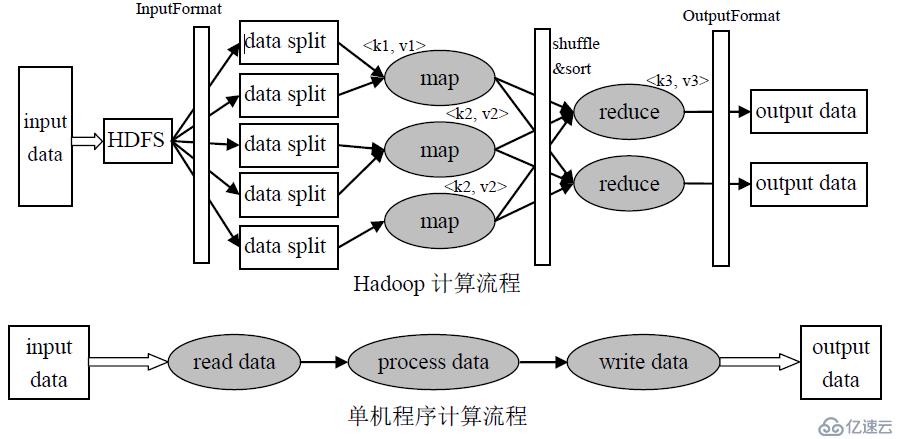

# 1. MapReduce自然语言处理概述

MapReduce是一个由Google提出的大数据处理编程模型,特别适合于在分布式系统上进行大规模数据集的处理。在自然语言处理(NLP)领域,MapReduce提供了一种有效的手段来应对复杂的数据分析问题,使得处理如文本挖掘、情感分析等任务时,可以扩展到PB级别的数据上。

自然语言处理是计算机科学和人工智能领域中与人类语言相关的理论和技术的研究。MapReduce为NLP提供了一种并行化处理的可能,使得一些原本需要长时间运行的任务能够在较短时间内完成。通过MapReduce,我们可以有效地利用集群资源,进行任务的分割和负载均衡。

本章将为读者介绍MapReduce如何与NLP相结合,以及它在处理自然语言时的一些优势和面临的挑战。我们将探讨MapReduce框架的基本工作原理,并讨论其在NLP中的应用,如文本分析和模式识别等核心议题。通过学习本章内容,读者将对MapReduce在NLP中的应用有一个全面的理解,并为后续章节的学习奠定基础。

# 2. 文本分析基础与实践

## 2.1 文本预处理技术

文本预处理是自然语言处理中不可或缺的步骤。在开始分析文本之前,需要对原始文本数据进行清洗和格式化,从而得到高质量、可用于后续分析的数据。

### 2.1.1 分词与词性标注

分词是将一段连续的文本切分成有意义的最小单位,即词语。在英文中,分词相对简单,因为单词之间通常由空格分隔。然而,在中文中,由于没有明确的分隔符,分词成为了一个复杂的任务,通常需要借助特定的算法和词库。

词性标注则是对分词后的每个词语赋予一个词性,如名词、动词、形容词等。这一步骤有助于后续文本分析的准确性。

以下是使用Python中nltk库进行中文分词和词性标注的代码示例:

```python

from nltk import word_tokenize, pos_tag

import jieba

# 中文分词

sentence = "自然语言处理是人工智能领域的重要分支。"

words = jieba.lcut(sentence)

# 词性标注

tags = pos_tag(words)

print(tags)

```

在上述代码中,我们首先使用`jieba`库对中文文本进行分词,然后通过`pos_tag`函数对分词结果进行词性标注。运行结果将展示每个词语及其对应的词性标签。

### 2.1.2 停用词过滤与词频统计

停用词是指在文本中频繁出现但对文本意义贡献较小的词,如“的”、“是”、“在”。过滤停用词有助于减少数据分析的噪声并提高效率。

以下是使用Python进行停用词过滤和词频统计的代码示例:

```python

from collections import Counter

import jieba

# 中文分词

sentence = "自然语言处理是人工智能领域的重要分支。"

words = jieba.lcut(sentence)

# 过滤停用词

stopwords = set(['是', '在', '的'])

filtered_words = [word for word in words if word not in stopwords]

# 词频统计

word_counts = Counter(filtered_words)

print(word_counts)

```

在这个示例中,我们首先定义了一个停用词集,然后过滤掉分词结果中的停用词。接着,我们使用`collections.Counter`对过滤后的词语进行词频统计,并打印出结果。

## 2.2 MapReduce文本分析实践

### 2.2.1 单词计数案例分析

单词计数是最简单的MapReduce任务之一,也是理解MapReduce原理的典型示例。以下是一个用Python编写的简单MapReduce程序,用于计算文档中单词的频率。

```python

from mrjob.job import MRJob

import re

WORD_RE = ***pile(r"[\w']+")

def words(text):

return WORD_RE.findall(text)

class MRWordFrequencyCount(MRJob):

def mapper(self, _, line):

for word in words(line):

yield (word.lower(), 1)

def reducer(self, word, values):

yield (word, sum(values))

if __name__ == '__main__':

MRWordFrequencyCount.run()

```

在这个示例中,`mapper`函数处理输入的每一行,使用正则表达式提取单词并输出单词及计数1。`reducer`函数随后对所有相同的单词进行计数求和。

### 2.2.2 复杂文本处理流程设计

复杂的文本处理流程通常涉及多个MapReduce作业,这些作业可以串行执行,形成数据的处理管道。设计这样一个流程需要仔细规划每个作业的输入输出以及它们之间的依赖关系。

一个典型的复杂文本处理流程可能包含如下步骤:

1. 分词与词性标注

2. 过滤停用词

3. 词频统计

4. 深度文本分析(如情感分析、主题模型)

每个步骤都可以通过MapReduce作业实现,然后将前一个作业的输出作为下一个作业的输入。这样的设计使得处理流程更加模块化,便于维护和优化。

## 2.3 高级文本分析技巧

### 2.3.1 n-gram模型的构建

n-gram模型是一种基于统计语言模型,用于预测给定n-1个词之后可能出现的词。在文本分析中,n-gram可以用于构建简单的预测模型或用于生成文本。

以下是使用Python构建一个简单的bigram模型的代码示例:

```python

from nltk.util import ngrams

from collections import Counter

# 假设有一个分词后的句子列表

sentences = [

['自然语言', '处理', '是', '人工智能', '领域', '的'],

['一个', '重要', '分支']

]

# 合并所有句子为一个大的文本

bigram_list = ngrams(sentences, 2)

# 统计bigram出现的频率

bigram_freq = Counter(bigram_list)

print(bigram_freq)

```

在这个例子中,我们首先使用`nltk`库中的`ngrams`函数生成bigrams,然后使用`Counter`统计bigrams的频率。

### 2.3.2 主题模型与文本聚类应用

主题模型是一种从文档集合中自动发现文本主题的技术,它能够揭示数据中隐藏的语义信息。文本聚类是将大量文本数据集根据相似度分组的过程。

以下是使用LDA(Latent Dirichlet Allocation)模型进行主题建模的代码示例:

```python

from sklearn.decomposition import LatentDirichletAllocation

import pandas as pd

# 假设有一个文档-词矩阵

doc_term_matrix = pd.DataFrame(...)

# 定义LDA模型

lda = LatentDirichletAllocation(n_components=5, random_state=0)

# 拟合LDA模型

lda.fit(doc_term_matrix)

# 获取每个文档的主题分布

doc_topic_distribution = lda.transform(doc_term_matrix)

```

在这个例子中,我们使用`sklearn`库中的`LatentDirichletAllocation`类来构建一个LDA模型,并将其拟合到文档-词矩阵上。最后,我们得到每个文档的主题分布。

以上就是第二章“文本分析基础与实践”部分的详细内容。在本章节中,我们重点介绍了文本分析的基础技术,包括预处理技术、MapReduce文本分析实践和一些高级分析技巧,如n-gram模型和主题模型。这些分析方法和技巧为后续更复杂自然语言处理任务奠定了基础。接下来的章节将进一步深入讨论模式识别理论与算法,并展示MapReduce在这些算法中的应用。

# 3. 模式识别理论与算法

模式识别是自然语言处理领域的核心技术之一,它涉及到从数据中识别模式和结构的过程。本章将探讨模式识别的基础理论、常用算法以及在文本处理中的应用。在深入分析之前,有必要了解模式识别的基本框架,以便更好地理解其在自然语言处理中的作用。

## 3.1 统计模式识别基础

统计模式识别是基于统计学原理,通过提取数据特征并使用概率模型来进行模式分类。在自然语言处理中,统计模型为文本分析提供了强大的工具,可以有效地处理文本的不确定性和模糊性。

### 3.1.1 概率论与随机过程

概率论是处理不确定性问题的重要工具,而随机过程则涉及随时间变化的随机事件。在模式识别中,文本数据通常被视为一个随机过程的产物,每个词语的出现都有一定的概率。以下是概率论在模式识别中的应用实例:

假设我们有以下简单的文本数据集:

```plaintext

文本1: "自然语言处理是有趣的话题"

文本2: "文本挖掘是技术进步的关键"

文本3: "数据分析帮助我们理解世界"

```

为了识别文本中的模式,我们可以先提取关键词,然后计算它们出现的概率。比如“语言”、“文本”、“数据”等词的出现概率较高,我们可以根据这些信息对新文本进行分类。

### 3.1.2 信息论基础

信息论是研究信息的度量、传输和处理的科学。在模式识别中,信息论常用于特征选择和优化模型复杂度。熵(Entropy)是信息论中的一个核心概念,用于描述系统的不确定性。

例如,我们可以通过计算词汇在文本中的信息熵来评估这些词汇对分类的重要性。信息熵越高的词汇对区分不同文本类别可能越有用。下面是一个简化的计算信息熵的代码示例:

```python

def calculate_entropy(counts):

probabilities = [count / sum(counts) for count in counts]

entropy = -sum(p * math.log2(p) for p in probabilities if p > 0)

return entropy

# 假设词汇在不同类别文本中的计数

counts = [10, 20, 5, 15]

entropy = calculate_entropy(counts)

print(f"信息熵: {entropy}")

```

## 3.2 常用模式识别算法

0

0