【自然语言处理】:R语言文本挖掘与情感分析入门指南

1. 自然语言处理和R语言基础

自然语言处理(NLP)是计算机科学和人工智能领域的一个分支,旨在让计算机能够理解人类语言。随着大数据时代的到来,NLP在文本分析、信息检索、语音识别等方面的应用变得越来越广泛。R语言作为一种开源的统计编程语言,具有强大的数据处理和可视化功能,它在NLP领域的应用也越来越受到重视。本章将带领读者了解自然语言处理的基础知识,以及R语言在处理语言数据时的基本语法和功能。

1.1 R语言简介

R语言以其数据处理和统计分析的能力被广泛应用于数据科学领域。它具有丰富的第三方库,能够支持文本挖掘和自然语言处理的各种任务。本小节将简要介绍R语言的安装、环境配置以及R语言的主要数据结构,为后续章节中涉及的NLP任务打下基础。

- # R语言安装与环境配置示例代码

- install.packages("tidyverse")

- library(tidyverse)

- # 查看当前环境中的对象

- ls()

1.2 自然语言处理基础

自然语言处理利用计算机技术来处理和理解人类语言。它涉及的范围非常广泛,包括语言模型、文本分类、情感分析等。本小节将介绍NLP的一些基本概念,如分词、词性标注、句法分析等,为读者进一步学习和应用NLP打下理论基础。

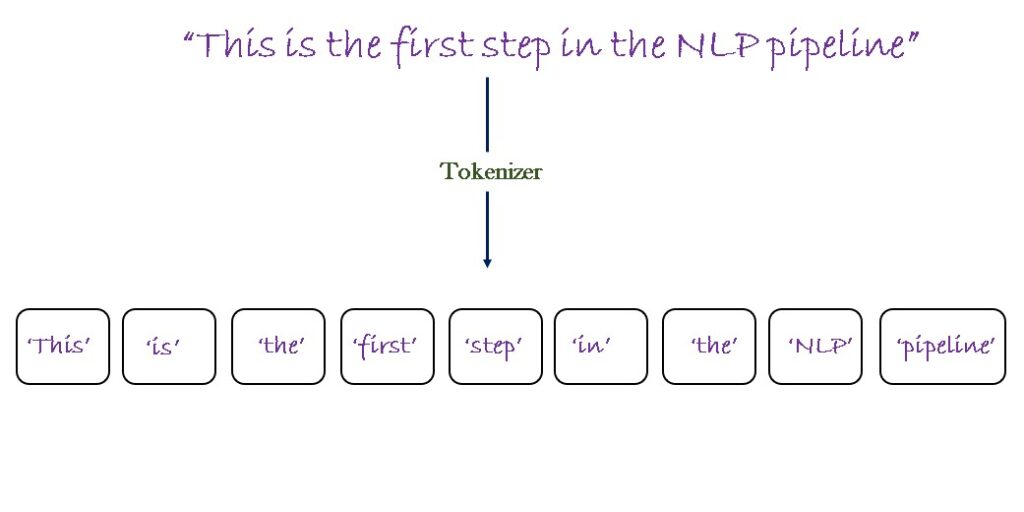

- 分词(Tokenization):将连续的文本分割成有意义的词汇单元。

- 词性标注(POS Tagging):为文本中的每个单词分配语法类别,如名词、动词等。

- 句法分析(Syntactic Parsing):分析句子的结构,确定词汇之间的关系。

通过掌握NLP的基本概念,读者可以更好地理解文本数据,并为后续的文本挖掘和情感分析打下坚实的基础。接下来的章节将会深入探讨如何在R语言环境中准备和清洗文本数据。

2. 文本数据的准备与清洗

2.1 文本数据的获取方法

2.1.1 网络爬虫技术简介

网络爬虫是自动化获取网页数据的一种技术,它是文本数据准备阶段的重要工具。爬虫的工作原理是模拟人类用户在网络中浏览的行为,通过发送HTTP请求到目标网站,并解析返回的HTML内容来提取所需信息。

在R语言中,rvest包提供了网络爬虫的基本功能。使用rvest进行数据爬取的流程一般包括:确定目标网页的URL,使用read_html读取网页内容,然后利用html_nodes和html_text提取特定标签中的文本。

- library(rvest)

- # 确定目标网页URL

- url <- "***"

- # 读取网页内容

- webpage <- read_html(url)

- # 提取网页中的文章标题

- titles <- webpage %>%

- html_nodes("h1") %>%

- html_text()

- # 提取网页中的段落文本

- paragraphs <- webpage %>%

- html_nodes("p") %>%

- html_text()

- # 输出提取结果

- print(titles)

- print(paragraphs)

以上代码展示了如何使用rvest包从一个示例网页中提取标题和段落文本。解析HTML时,确保了解目标网站的结构以便准确选择合适的标签。

2.1.2 公共数据集的获取途径

除了爬虫技术外,公共数据集是文本数据准备的另一重要来源。这些数据集可能是由研究机构、政府机关或其他组织公开提供的,它们可以帮助研究者或开发者在研究或开发产品时节省大量的数据收集时间。

一个访问公共数据集的流行平台是Kaggle,它提供了各种类型的数据集,包括文本数据。另外,UCI机器学习库也包含了很多可用的数据集。除了这些在线资源,许多研究论文在出版时也会附带数据集,可从中获取数据。

获取公共数据集后,通常需要对数据集进行格式化,以便在文本挖掘项目中使用。这可能包括转换数据格式、处理缺失值、数据类型转换等。

2.2 文本数据的预处理技术

2.2.1 分词与文本规范化

分词是将文本切分成最小的有意义单元(通常是单词)的过程,而文本规范化是对这些分词后的单元进行处理,包括转换为小写、去除停用词、词干提取等,目的是减少数据的复杂性,同时保留对后续分析最有用的信息。

使用R语言进行分词,我们可以借助stringi包进行操作。stringi提供了丰富的字符串处理函数,如stri_split_fixed可以实现简单的分词。文本规范化可能需要结合多个函数处理,如小写转换可以使用tolower函数。

- library(stringi)

- # 示例文本

- text <- "Natural language processing and R programming are powerful!"

- # 分词,这里以空格为分隔符

- words <- stri_split_fixed(text, boundary="word")

- # 转换为小写

- words_lower <- tolower(words)

- # 输出分词和规范化的结果

- print(words)

- print(words_lower)

执行逻辑说明:上述代码首先定义了一个包含特定文本的变量text。使用stri_split_fixed函数以单词为边界对文本进行分词。然后,通过tolower函数将所有单词转换为小写,以实现文本的规范化。

2.2.2 常见的数据清洗方法

在文本数据准备的后续阶段,清洗工作是必不可少的。这可能包括去除无意义的字符(如标点、特殊符号)、删除重复的记录或填充缺失值等。

stringr包提供了一系列用于字符串处理的函数,可以方便地进行清洗工作。比如,str_replace_all可以用来替换文本中的特定字符或字符串,str_detect用于检测字符串中是否包含特定模式等。

- library(stringr)

- # 示例文本

- text <- "Natural language processing and R programming are powerful! But, it's complex."

- # 去除标点符号

- text_no_punctuation <- str_replace_all(text, "[[:punct:]]", " ")

- # 移除空格

- text_clean <- str_replace_all(text_no_punctuation, " ", "")

- # 输出清洗后的结果

- print(text_no_punctuation)

- print(text_clean)

执行逻辑说明:在这段代码中,首先定义了一个包含标点的示例文本text。使用str_replace_all函数去除文本中的标点符号,其中[[:punct:]]正则表达式用于匹配任何标点字符。第二次使用str_replace_all函数去除所有的空格。最终得到的text_clean变量是去除标点和空格后的清洗文本。

2.3 文本数据的特征提取

2.3.1 Bag-of-Words模型

Bag-of-Words模型是一种用于文本特征提取的简单方法,它忽略了文本中单词的顺序和语法,将文本视为一组词频向量。在Bag-of-Words模型中,每个文档被表示为一个向量,向量的每个维度对应一个唯一词汇。

在R中,可以使用DocumentTermMatrix函数实现Bag-of-Words模型。首先需要创建一个语料库(Corpus),然后构建一个文档-词项矩阵。

- library(tm)

- # 创建一个语料库

- corpus <- Corpus(VectorSource(paragraphs))

- # 预处理:转换为小写、移除停用词等

- corpus <- tm_map(corpus, content_transformer(tolower))

- corpus <- tm_map(corpus, removePunctuation)

- corpus <- tm_map(corpus, removeNumbers)

- corpus <- tm_map(corpus, removeWords, stopwords("english"))

- # 构建文档-词项矩阵

- dtm <- DocumentTermMatrix(corpus)

- # 输出矩阵信息

- print(dtm)

执行逻辑说明:首先,使用VectorSource和Corpus函数创建了一个语料库。然后,通过一系列tm_map函数调用对语料库进行预处理,包括转换为小写、移除标点和数字以及停用词。最后,使用DocumentTermMatrix函数创建了文档-词项矩阵。

2.3.2 TF-IDF算法的原理与应用

TF-IDF(Term Frequency-Inverse Document Frequency)算法是文本分析中的一种常用加权技术,用于评估一个词在文档集合或语料库中的重要性。一个词的TF-IDF值会随着它在文档中出现的频率的增加而增加,但是当它在语料库中的文档中普遍出现时,它的权重会相应减少。

在R中,可以使用tfidf函数来计算词项的TF-IDF权重。

- library(tm)

- # 假设dtm已经是构建好的文档-词项矩阵

- tfidf_weights <- weightTfIdf(dtm)

- # 输出TF-IDF权重矩阵信息

- print(tfidf_weights)

执行逻辑说明:这段代码使用weightTfIdf函数对先前创建的文档-词项矩阵dtm进行了TF-IDF权重计算。weightTfIdf函数会返回一个包含TF-IDF权重的矩阵。

表格示例

| 特征提取方法 | 描述 | 使用场景 | | ------------ | -