PyTorch数据重组艺术:张量合并与分割教程

1. PyTorch张量的基础知识

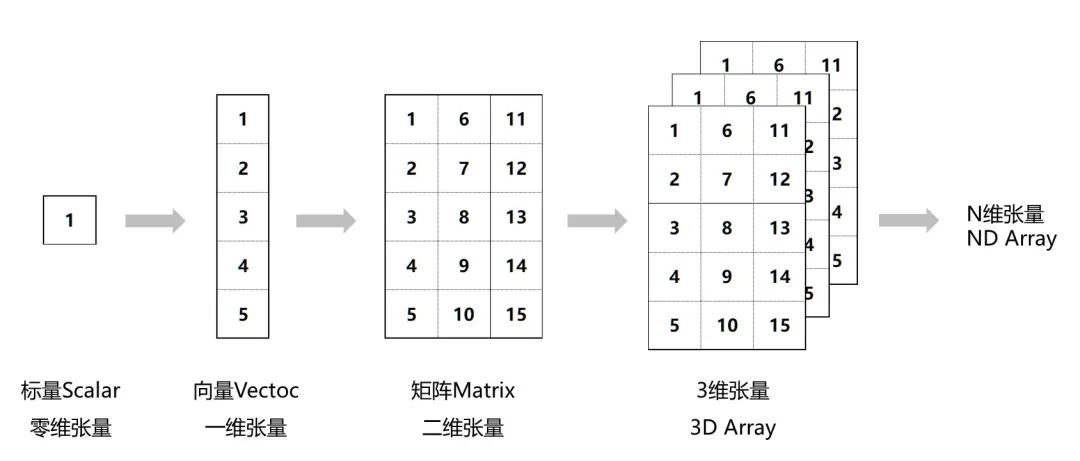

在深度学习领域,PyTorch已经成为一种主流的框架,它为数据科学和机器学习提供了强大的工具。PyTorch核心是基于张量(Tensor)的操作,张量可以看作是多维数组,是进行数据运算和模型训练的基础。

张量的定义与属性

首先,张量是对多维数组的一种抽象,它具有数据类型和维度信息。在PyTorch中,张量可以包含各种类型的数据,如浮点数、整数、布尔值等。张量的属性包括其形状(shape)、数据类型(dtype)以及存储在设备上的位置(如CPU或GPU)。

- import torch

- # 创建一个形状为(3, 3)的浮点张量

- tensor = torch.tensor([[1., 2., 3.], [4., 5., 6.], [7., 8., 9.]], dtype=torch.float32)

- print(tensor)

输出张量的属性:

- tensor shape: torch.Size([3, 3])

- tensor dtype: torch.float32

张量的形状指的是它的维度大小,例如上面的torch.Size([3, 3])表示这是一个二维张量,每个维度有3个元素。

张量操作的种类

在PyTorch中,张量操作可以分为基础操作和高级操作。基础操作涉及张量的创建、索引、切片、形状变换等,而高级操作则可能涉及数学运算、归一化、标准化等。随着深度学习模型的复杂性增加,对张量的操作要求也会变得更加高级。

- # 张量的形状变换

- reshaped_tensor = tensor.view(1, 9)

- print(reshaped_tensor.shape)

输出变换后的张量形状:

- torch.Size([1, 9])

在本章中,我们将探究PyTorch中张量的基础知识,从而为后续章节中更复杂的操作打下坚实的基础。随着章节的深入,我们将介绍如何高效地合并和分割张量,以及如何将这些操作应用于实际的数据处理和模型训练中。

2. PyTorch张量的合并操作

2.1 张量合并的基本概念

2.1.1 合并的定义和应用场景

在PyTorch中,张量的合并操作指的是将多个张量按照一定的维度拼接在一起,形成一个新的张量。这一操作在机器学习模型构建中非常常见,如拼接不同层的输出或整合多个样本的数据。通过合并操作,我们可以有效地组织和利用数据,使得模型能够更好地学习到数据的深层次特征。

在进行神经网络训练时,常常需要将不同批次的样本特征合并,以便一次性进行前向传播和反向传播。在一些复杂的网络结构中,如循环神经网络(RNN),合并操作还会用于拼接不同时间步的隐藏状态,便于捕捉序列中的时间依赖关系。

2.1.2 合并与广播的关系

PyTorch中的合并操作与广播机制紧密相关。广播允许不同形状的张量在某些维度上进行算术运算。当我们将两个形状不同的张量进行合并时,若它们在非合并维度上的大小一致或者其中一方在该维度大小为1时,这些张量可以利用广播规则,在合并后自动扩展至相同的形状以进行运算。

2.2 张量合并的具体方法

2.2.1 cat()函数的使用

torch.cat()函数是PyTorch中最常用的合并张量的方法之一。它的基本用法是沿着指定的维度将张量序列合并成一个新的张量。在使用时,我们需要先定义一个维度参数,这决定了张量被合并的维度。

- import torch

- # 定义两个张量

- tensor1 = torch.tensor([[1, 2], [3, 4]])

- tensor2 = torch.tensor([[5, 6], [7, 8]])

- # 沿着维度0合并张量

- concatenated_tensor = torch.cat((tensor1, tensor2), 0)

- print(concatenated_tensor)

上面的例子展示了如何将两个2x2的张量沿第一个维度(dim=0)进行合并。cat()函数可以灵活地沿任意维度进行合并,只需要更改dim参数即可。

2.2.2 stack()与concat()的对比

除了cat()之外,torch.stack()也是合并张量的常用函数。与cat()不同,stack()函数会增加一个新的维度来合并张量。在stack()中,所有输入张量都必须具有相同的维度。

- # 沿着新维度合并张量

- stacked_tensor = torch.stack((tensor1, tensor2), 0)

- print(stacked_tensor)

在上述代码中,原本是2x2的两个张量在合并后变成了一个3x2x2的张量。stack()提供了另一种张量合并的方式,使我们可以创建更高维度的数据结构。

2.2.3 广播机制在合并中的应用

在合并张量时,如果涉及的张量在非合并维度上的大小不一致,则需要借助广播机制来处理。比如,如果我们将一个2x3的张量与一个3x1的张量合并,由于它们在第一个维度上不一致,我们需要利用广播机制使它们能够合并。

- # 定义一个2x3和一个3x1的张量

- tensor3 = torch.tensor([[1, 2, 3], [4, 5, 6]])

- tensor4 = torch.tensor([1, 2, 3])

- # 无法直接合并,需要使用广播机制

- # 首先需要将tensor4增加一个维度

- tensor4_expanded = tensor4.view(-1, 1)

- # 然后使用torch.cat()合并

- broadcasted_tensor = torch.cat((tensor3, tensor4_expanded), 1)

- print(broadcasted_tensor)

在上述代码中,我们通过使用view()方法改变了tensor4的形状,使其能够在第二个维度上与tensor3进行广播合并。

2.3 合并操作的高级技巧

2.3.1 使用view()和reshape()调整形状

在进行张量操作时,我们经常需要调整张量的形状。view()和reshape()函数允许我们改变张量的维度而不需要复制数据,这对于合并操作而言非常有用。通过调整形状,我们能够将不同形状的张量整合到一起,为合并操作提供便利。

- # 将一个2x2的张量变形为2x1x2的张量

- reshaped_tensor = tensor1.view(2, 1, 2)

- print(reshaped_tensor)

2.3.2 神经网络中张量合并的典型应用

在构建神经网络时,常常需要将不同层的输出进行合并操作,以便进行后续的处理。例如,在多任务学习中,我们可能需要将不同任务的预测结果拼接在一起,再进行损失计算。

- class MultiTaskNet(torch.nn.Module):

- def __init__(self):

- super(MultiTaskNet, self).__init__()

- self.layer1 = torch.nn.Linear(in_features=10, out_features=5)

- self.layer2 = torch.nn.Linear(in_features=10, out_features=5)

- def forward(self, x):

- task1_output = self.layer1(x)

- task2_output = self.layer2(x)

- # 将两个任务的输出沿新维度合并

- combined_output = torch.stack((task1_output, task2_output), 2)

- return combined_output

- model = MultiTaskNet()

在上述模型定义中,我们定义了两个线性层来处理输入x,并使用stack()函数将两个任务的输出在新维度上合并。这允许了模型可以同时学习多个任务的特征表示。

3. PyTorch张量的分割操作

3.1 张量分割的基本概念

3.1.1 分割的定义和应用场景

在深度学习中,数据预处理是一个至关重要的步骤。在某些情况下,我们需要将一个大的张量分割成更小的部分,以便于进行进一步的分析或训练模型。这个过程称为“分割”。

分割操作可以应用于各种不同的场景,例如,你可以将一张高分辨率的图片分割成多个小的图像块,这样可以用于训练图像识别模型,或者在时间序列数据中,将长序列分割成多个较短的序列,便于训练循环神经网络。

- import torch

- # 假设我们有一个形状为(10, 3, 256, 256)的随机张量,代表10张图片,每张图片有3个通道,分辨率为256x256

- tensor = torch.randn(10, 3, 256, 256)

- # 分割图片

- # 假设我们每次分割两张图片

- # 使用split()函数可以将张量按指定维度分割成若干个子张量,这里我们按第0维(即图片批次维度)进行分割

- split_tensors = torch.split(tensor, 2, dim=0)

- # split_tensors现在是一个包含5个元素的元组,每个元素是一个形状为(2, 3, 256, 256)的张量

3.1.2 分割与索引的关系

分割操作和索引操作有很多相似之处,但它们在本质上是不同的。索引操作通常用来选取张量中特定的元素或元素集合,而分割操作则是将一个张量分成多个子张量。

- # 使用索引选择张量的一部分

- indexed_tensor = tensor[0:2, :, :, :] # 选择前两张图片

- # 这与分割不同,因为索引返回的是原始张量的视图,而不是创建新的张量

- # 分割则是创建了新的张量

3.2 张量分割的具体方法

3.2.1 split()函数的使用

在PyTorch中,torch.split()函数用于将张量分割成若干个子张量。该函数需要至少两个参数:要分割的张量和分割的大小(可以是单个整数或一个整数列表,指定了每个分片的大小)。

- # 使用split()函数将张量分割为更小的张量

- # 如果我们希望把每张图片分割成4个256x128的小块,我们可以这样做:

- split_tensors = torch.split(tensor, [256, 256], dim=2) # 沿着第2维(高度)进行分割

- # 如果要将张量分割成相同大小的多个部分,可以使用None参数

- # 下面的代码将会分割成3个相同大小的小张量

- split_tensors = torch.split(tensor, None, dim=0)

- `