PyTorch张量操作全攻略:零基础入门到数据结构构建

发布时间: 2024-12-12 02:57:46 阅读量: 11 订阅数: 19

# 1. PyTorch张量操作概述

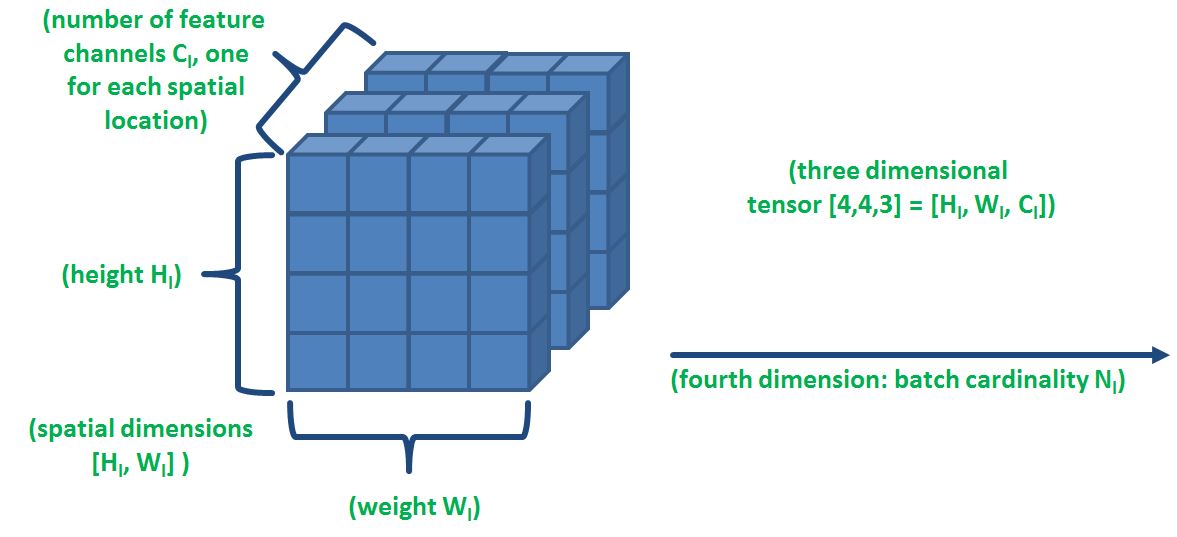

在人工智能和深度学习领域,PyTorch 已经成为开发者们青睐的深度学习框架之一。张量(Tensor)是PyTorch中最基本的数据结构,它与NumPy中的数组类似,但提供了对GPU加速计算的支持。本章将简要介绍PyTorch张量操作的概况,为后续章节的深入探讨打下基础。

首先,让我们从张量的概念入手,了解它在PyTorch中的角色和重要性。PyTorch张量可以看作是多维数组,这些数组不仅支持各种数学运算,而且还可以自动计算梯度,这对于深度学习模型训练来说至关重要。

接下来,我们将概览PyTorch张量操作的几个主要领域,包括张量的创建、属性访问、数学运算、索引和切片,以及数据结构的构建。掌握这些基础操作对于从事深度学习的IT专业人士来说是必不可少的。通过阅读本章内容,读者将能够熟练运用PyTorch中的张量进行数据操作,为进一步研究深度学习模型打下坚实基础。

# 2. PyTorch基础张量操作

## 2.1 张量的创建与属性

### 2.1.1 创建不同类型的张量

在PyTorch中,我们可以创建不同类型的张量,包含但不限于:常数张量、随机张量、从已有数据构造张量等。下面我们将分别介绍如何创建这些不同类型的张量。

```python

import torch

# 创建常数张量

constant_tensor = torch.full((3, 3), 2)

print("Constant Tensor:", constant_tensor)

# 创建随机张量

random_tensor = torch.rand(2, 2)

print("Random Tensor:", random_tensor)

# 从已有数据创建张量

data = [[1, 2], [3, 4]]

data_tensor = torch.tensor(data)

print("Tensor from data:", data_tensor)

```

- `torch.full(size, fill_value)`:创建一个指定形状`size`且所有值为`fill_value`的张量。

- `torch.rand(size)`:创建一个指定形状`size`的张量,并用[0, 1)区间内均匀分布的随机数填充。

- `torch.tensor(data)`:根据提供的数据`data`创建一个张量,数据类型可为列表、元组等。

### 2.1.2 张量的基本属性和方法

张量的基本属性包括形状(shape)、数据类型(data type)、设备(device)等。我们可以通过属性访问这些信息,并对张量执行各种操作。

```python

# 张量属性和方法示例

print("Shape of constant_tensor:", constant_tensor.shape)

print("Data type of random_tensor:", random_tensor.dtype)

print("Device of data_tensor:", data_tensor.device)

```

- `tensor.shape`:返回张量的形状。

- `tensor.dtype`:返回张量的数据类型。

- `tensor.device`:返回张量所在的设备,如CPU或GPU。

## 2.2 张量的数学运算

### 2.2.1 点对点运算

点对点运算也称为逐元素运算,指的是在张量的元素级别上进行的运算。PyTorch支持各种数学运算符来实现这一点。

```python

# 点对点运算示例

tensor_a = torch.tensor([1, 2, 3], dtype=torch.float32)

tensor_b = torch.tensor([4, 5, 6], dtype=torch.float32)

# 加法

addition = tensor_a + tensor_b

print("Addition:", addition)

# 乘法

multiplication = tensor_a * tensor_b

print("Multiplication:", multiplication)

```

### 2.2.2 线性代数运算

线性代数运算是深度学习中不可或缺的一部分。在PyTorch中,线性代数运算功能强大且易于使用。

```python

# 线性代数运算示例

eye_matrix = torch.eye(3)

print("Identity Matrix:\n", eye_matrix)

# 矩阵乘法

matrix_multiplication = tensor_a @ eye_matrix

print("Matrix Multiplication:\n", matrix_multiplication)

```

- `torch.eye(n)`:创建一个n×n的单位矩阵。

- `tensor_a @ tensor_b`:进行矩阵乘法。

## 2.3 张量的索引、切片与合并

### 2.3.1 索引技巧与视图操作

索引是访问张量元素的重要方法。PyTorch中索引的用法与NumPy类似,支持多维索引。

```python

# 索引与视图操作示例

print("First element:", constant_tensor[0, 0])

# 视图操作可以改变数据的形状而不复制数据

reshaped_view = constant_tensor.view(9)

print("Reshaped View:", reshaped_view)

```

### 2.3.2 张量的合并与分割

合并是指将多个张量合并为一个,而分割则相反。PyTorch提供了多个函数来实现这些操作。

```python

# 合并与分割示例

tensor_c = torch.cat((tensor_a, tensor_b), dim=0)

print("Concatenated Tensor:", tensor_c)

# 分割张量

split_tensor = torch.split(tensor_c, split_size_or_sections=2, dim=0)

print("Split Tensors:", split_tensor)

```

- `torch.cat(tensors, dim=0)`:沿指定维度`dim`连接序列`tensors`中的张量。

- `torch.split(tensor, split_size_or_sections, dim=0)`:将张量`tensor`分割为等长的子张量,每个子张量的大小由`split_size_or_sections`定义。

通过本章节的介绍,我们已经掌握PyTorch中基础张量操作的核心内容。下一章节我们将深入探讨张量的数据结构构建,这将涉及形状操作、高级索引以及广播机制等更为高级的操作技巧。

# 3. 张量的数据结构构建

## 3.1 张量的形状操作

张量的形状是定义张量结构的关键要素,它决定了数据的维度和每个维度的大小。在PyTorch中,对张量形状的操作允许我们进行灵活的数据重组,这是进行高效数据处理和模型构建的基础。

### 3.1.1 改变张量的形状

改变张量形状的常见操作包括改变张量的维度和每个维度的大小。在PyTorch中,`view`方法是用来改变张量形状的常用工具,它不会复制张量的数据,只是改变数据的解释方式。

```python

import torch

# 创建一个随机张量

tensor_a = torch.randn(2, 3, 4)

print(tensor_a.shape) # 输出原始张量形状

# 改变张量形状为(4, 3, 2)

tensor_b = tensor_a.view(4, 3, 2)

print(tensor_b.shape) # 输出新形状

```

在上面的代码中,`view`方法将一个三维张量(2x3x4)转换为另一个三维张量(4x3x2)。需要注意的是,`view`方法要求在新的形状中元素总数必须与原始张量保持一致。

### 3.1.2 扩展和压缩维度

扩展和压缩张量维度是对数据进行升维和降维的操作。扩展维度通常用于为张量添加新的维度,而压缩维度则相反,常用于移除不必要的维度,以便于进行后续操作。

```python

# 扩展一个维度

tensor_c = tensor_a.unsqueeze(1) # 在第二个维度添加一个维度

print(tensor_c.shape) # 输出(2, 1, 3, 4)

# 压缩一个维度

tensor_d = tensor_c.squeeze(1) # 移除第二个维度

print(tensor_d.shape) # 输出(2, 3, 4)

```

在上述代码示例中,`unsqueeze`方法在指定位置添加了一个维度,而`squeeze`方法则是移除了一个维度。这些操作在处理图像数据、批处理数据时非常有用。

## 3.2 张量的高级索引

高级索引是PyTorch中张量操作的重要组成部分,它提供了在张量上进行复杂索引的能力,是处理非规则数据集的关键。

### 3.2.1 布尔索引和花式索引

布尔索引使用一个布尔张量来选择数据,而花式索引则可以同时使用多个索引张量来选取数据。

```python

# 创建一个2x3的张量

tensor_e = torch.tensor([[1, 2, 3], [4, 5, 6]])

# 布尔索引示例

bool_index = tensor_e > 3

tensor_f = tensor_e[bool_index] # 结果是[4, 5, 6]

# 花式索引示例

rows = torch.tensor([0, 1, 1])

cols = torch.tensor([1, 0, 2])

tensor_g = tensor_e[rows, cols] # 结果是[2, 4, 6]

```

上述代码中,我们首先创建了一个简单的2x3张量。然后,我们展示了如何使用布尔索引来筛选出大于3的元素。接着,我们使用花式索引从不同位置选取元素。

### 3.2.2 使用掩码和条件索引

掩码操作是通过创建一个与张量形状相同的布尔张量来对原始张量进行索引的方法。条件索引是一种特殊的掩码索引,它允许我们基于复杂的条件来选择数据。

```python

# 创建一个3x2的张量

tensor_h = torch.tensor([[1, 2], [3, 4], [5, 6]])

# 使用掩码进行索引

mask = tensor_h > 3

tensor_i = tensor_h[mask] # 结果是[4, 5, 6]

# 条件索引示例

tensor_j = tensor_h[tensor_h % 2 == 0] # 结果是[2, 4, 6]

```

在以上代码中,我们使用了一个掩码来选择`tensor_h`中大于3的元素。然后,我们展示了如何使用条件索引筛选出所有偶数元素。

## 3.3 张量的广播机制

在处理不同形状的张量时,PyTorch提供了一种高效的机制——广播,它允许不同形状的张量在某些维度上执行逐元素操作。

### 3.3.1 广播规则

PyTorch中的广播遵循特定的规则,这些规则决定了如何扩展较小的张量以匹配较大张量的形状。

- 如果两个张量的维度数不同,较小的张量的形状会从右边开始填充1。

- 如果在任何维度上,一个张量的大小是1而另一个不是,较小的张量在该维度上会被广播。

- 如果一个张量在某个维度上的大小既不是1也不是与另一张量相同,那么这两个张量在该维度上是不兼容的,不能进行广播。

### 3.3.2 广播应用实例

```python

# 广播应用示例

tensor_k = torch.tensor([1, 2, 3])

tensor_l = torch.tensor([[4], [5], [6]])

# 结果 tensor_k + tensor_l: tensor([[5, 6, 7], [6, 7, 8], [7, 8, 9]])

```

在这个例子中,`tensor_k`的形状是`(3,)`,而`tensor_l`的形状是`(3, 1)`。根据广播规则,`tensor_k`在第二个维度上被扩展为`(3, 3)`,之后两个张量就可以进行逐元素相加操作。这个机制极大地简化了代码的复杂性并提高了效率。

通过广播,我们可以有效地扩展小张量以进行复杂的数学运算,这对于深度学习中的矩阵操作、特征扩展等非常有用。广播不仅节省了内存,还提高了运算速度。

以上就是第三章张量的数据结构构建的详细内容。通过形状操作、高级索引和广播机制,我们可以对PyTorch中的张量进行高效的处理,为机器学习和深度学习任务打下坚实的基础。

# 4. PyTorch张量操作的进阶技巧

## 4.1 张量的自动化梯度计算

### 4.1.1 梯度计算的基本原理

在深度学习中,梯度计算是理解模型参数对输出的影响程度的关键步骤。在PyTorch中,这一过程通过自动梯度(autograd)引擎自动进行。梯度计算的目的是确定损失函数关于模型参数的梯度,这些梯度用于梯度下降算法,进而更新模型参数以最小化损失。

自动梯度计算依赖于动态计算图(Dynamic Computational Graph),即在执行时构建计算图,而不是在运行前静态定义。这种动态性质使得PyTorch可以轻松实现复杂的模型,特别是在需要动态控制流程的情况下,如循环和条件语句。

### 4.1.2 动态计算图与自动微分

自动微分是实现梯度自动计算的核心技术,它涉及反向传播算法。PyTorch中使用的是后向模式自动微分。在前向传播过程中,每个操作都会构建一个计算图节点。一旦前向传播完成,可以使用`.backward()`方法执行反向传播,这会递归地计算所有叶节点(即模型参数)的梯度。

```python

# 示例:PyTorch中的自动梯度计算

import torch

# 创建一个张量并设置requires_grad=True,启用梯度跟踪

x = torch.tensor([1.0, 2.0, 3.0], requires_grad=True)

# 进行一系列操作,构建计算图

y = x * 2

z = y * y * 3

# 计算z关于x的梯度

z.backward(torch.tensor([1.0, 1.0, 1.0]))

# 输出计算出的梯度

print(x.grad) # 输出: tensor([ 6., 12., 18.])

```

### 4.2 张量的转换与内存管理

#### 4.2.1 张量与NumPy数组的转换

PyTorch提供了一系列与NumPy兼容的接口,使得从NumPy数组转换为PyTorch张量,或者反之变得十分方便。这使得在数据处理和模型训练之间转换数据变得无缝,尤其是在与机器学习库集成时。

```python

import numpy as np

import torch

# NumPy数组转换为PyTorch张量

np_array = np.random.rand(3, 3)

tensor_from_np = torch.from_numpy(np_array)

# PyTorch张量转换回NumPy数组

tensor = torch.rand(3, 3)

np_array_from_tensor = tensor.numpy()

```

#### 4.2.2 内存管理和异步计算

PyTorch提供了多种内存管理技术,包括显式内存释放和异步计算。显式内存释放允许用户删除不再需要的中间张量,以避免内存泄漏。异步计算则允许在同一时间运行多个操作,这可以显著提高性能。

```python

# 异步执行

stream = torch.cuda.Stream()

with torch.cuda.stream(stream):

a = torch.empty((10, 10), device='cuda')

b = torch.empty((10, 10), device='cuda')

c = a + b

# 下面的操作将与c的计算在不同流上异步执行

print(c.is_cuda) # 输出: True

stream.synchronize() # 等待流执行完毕

```

## 4.3 PyTorch中的自定义张量操作

### 4.3.1 编写自定义的CUDA核函数

在需要高度优化的场景下,可以使用CUDA编写自定义核函数。CUDA核函数允许用户直接在GPU上进行计算,以达到最佳性能。PyTorch提供了用于定义核函数的接口,即`torch.cuda`下的相关函数。

```python

import torch

import torch.nn.functional as F

# CUDA核函数示例

@torch.jit.script

def custom_kernel(points):

# 这里定义核函数内部计算

...

# 使用核函数

points = torch.rand(10000, 3, device='cuda')

result = custom_kernel(points)

```

### 4.3.2 利用PyTorch扩展实现自定义操作

对于一些特定的操作,PyTorch还提供了扩展机制,允许使用C++编写自定义操作。PyTorch C++扩展模块(LibTorch)提供了丰富的API,可以用于创建高效的自定义模块和操作。这一机制为研究者和开发者提供了更大的灵活性和性能优势。

```cpp

#include <torch/torch.h>

using namespace torch;

// 自定义操作示例

TORCH_LIBRARY(MyOps, m) {

m.def("my_custom_op", [](Tensor self, double value) {

return self * value;

});

}

// 在Python中使用自定义操作

import torch

import custom_ops # 确保已编译自定义操作

a = torch.ones(5)

print(a.my_custom_op(2)) # 输出: tensor([2., 2., 2., 2., 2.])

```

本章节介绍了PyTorch张量操作的进阶技巧,涵盖了自动化梯度计算、张量转换与内存管理、以及自定义张量操作。通过这些技巧,可以有效提升深度学习模型的性能和灵活性,为研究和开发工作提供更加坚实的支撑。在下一章节中,我们将探讨这些高级张量操作在数据处理及模型构建中的具体应用,深入理解PyTorch作为深度学习框架的多面性。

# 5. PyTorch张量操作在数据处理中的应用

## 5.1 张量在机器学习数据预处理中的应用

### 5.1.1 数据加载与批量处理

在深度学习项目中,数据的加载和预处理是至关重要的第一步。PyTorch通过`DataLoader`类提供了一种便捷的方式来批量加载数据,并支持多线程加载。借助张量操作,可以高效地将原始数据转换为模型所需的格式。

```python

from torch.utils.data import DataLoader, TensorDataset

import torch

# 假设已有数据集X和对应的标签y

# X, y = ...

# 将数据和标签转换为张量

X_tensor = torch.tensor(X, dtype=torch.float32)

y_tensor = torch.tensor(y, dtype=torch.float32)

# 创建TensorDataset对象

dataset = TensorDataset(X_tensor, y_tensor)

# 创建DataLoader对象以实现批量加载和打乱数据

batch_size = 32

data_loader = DataLoader(dataset, batch_size=batch_size, shuffle=True)

```

通过设置`batch_size`参数,可以控制每次喂给模型的数据量。`shuffle=True`表示在每个epoch结束时随机打乱数据集,以避免数据加载的顺序对模型训练产生影响。

### 5.1.2 数据增强技术

数据增强是机器学习中常用的技术,用于扩大训练数据集的规模和多样性,提高模型的泛化能力。PyTorch提供了多个变换函数,这些函数可以将张量数据应用到不同的图像增强技术。

```python

from torchvision import transforms

# 定义数据增强的变换序列

transform = transforms.Compose([

transforms.RandomHorizontalFlip(), # 随机水平翻转

transforms.RandomRotation(10), # 随机旋转

transforms.ColorJitter(brightness=0.2, contrast=0.2, saturation=0.2), # 随机改变亮度、对比度和饱和度

])

# 假设transformed_dataset是经过增强的图像张量数据集

# transformed_dataset = ...

# 在DataLoader中应用数据增强

data_loader = DataLoader(transformed_dataset, batch_size=batch_size, shuffle=True)

```

以上代码展示了如何结合PyTorch的`transforms`模块对图像数据进行随机水平翻转、旋转和颜色抖动等增强操作。

## 5.2 张量在深度学习模型构建中的角色

### 5.2.1 搭建简单的深度学习模型

PyTorch的张量操作不仅仅是数据预处理的工具,还可以直接用于深度学习模型的构建。张量可以作为模型的参数,与`nn.Module`类一起创建可微分的计算图。

```python

import torch.nn as nn

import torch.nn.functional as F

class SimpleMLP(nn.Module):

def __init__(self):

super(SimpleMLP, self).__init__()

self.fc1 = nn.Linear(in_features=28*28, out_features=256)

self.fc2 = nn.Linear(256, 10)

def forward(self, x):

x = F.relu(self.fc1(x))

x = self.fc2(x)

return x

# 实例化模型

model = SimpleMLP()

# 假设输入数据已经被转换为张量并准备好

# input_tensor = ...

# 通过模型进行前向传播

output = model(input_tensor)

```

在这个简单的多层感知机(MLP)例子中,`nn.Linear`用于创建全连接层。输入张量经过模型的每一层变换后产生输出张量。

### 5.2.2 张量操作对模型性能的影响

深度学习模型的性能往往受到张量操作效率的影响。使用高效的操作可以加快模型的训练速度并提升性能。例如,减少不必要的数据复制、使用适当的批量大小和并行计算。

```python

# 假设我们有一个大型的输入张量和权重张量

# input_large = torch.randn(1024, 128)

# weights_large = torch.randn(128, 10)

# 使用适当的批量大小和并行计算

output_large = torch.matmul(input_large, weights_large)

```

`torch.matmul`是一个高效的矩阵乘法操作,能够利用GPU加速,对于大规模数据尤其有效。

## 5.3 张量操作与深度学习框架的协同

### 5.3.1 PyTorch的模块化组件与张量操作

PyTorch的模块化组件设计允许开发者灵活地构建深度学习模型。通过组合不同的`nn.Module`子类,我们可以构建复杂的神经网络结构。张量操作是这些模块的基础。

```python

class MyModule(nn.Module):

def __init__(self):

super(MyModule, self).__init__()

self.fc = nn.Linear(10, 5)

self.relu = nn.ReLU()

def forward(self, x):

x = self.fc(x)

x = self.relu(x)

return x

# 实例化并使用自定义模块

my_module = MyModule()

output = my_module(input_tensor)

```

在这个例子中,我们定义了一个包含全连接层和ReLU激活函数的自定义模块。`forward`方法描述了张量在模型中的流动路径。

### 5.3.2 高效的数据流管道构建

为了实现高效的数据流处理,PyTorch提供了数据管道的概念。数据管道包括数据预处理、数据加载和模型训练等步骤。合理设计数据管道能够确保训练过程的流畅和高效。

```python

from torch.utils.data import DataLoader

# 创建数据集和数据加载器

dataset = MyDataset()

data_loader = DataLoader(dataset, batch_size=64, shuffle=True, num_workers=4)

# 在训练循环中使用数据加载器

for inputs, targets in data_loader:

# 前向传播

predictions = model(inputs)

# 计算损失

loss = loss_function(predictions, targets)

# 反向传播和参数更新

optimizer.zero_grad()

loss.backward()

optimizer.step()

```

在这个训练循环中,`DataLoader`负责批量加载数据、打乱数据顺序,并在多个工作线程中预处理数据,从而实现高效的数据流。

以上章节展示了PyTorch张量操作在数据处理、模型构建和高效数据流管道构建中的应用。通过深入理解张量操作,开发者可以构建出性能强大且高效的深度学习应用。

0

0