【社交网络分析利器】:决策树技术在用户行为预测中的应用

发布时间: 2024-09-04 23:09:52 阅读量: 144 订阅数: 45

【java毕业设计】智慧社区教育服务门户.zip

# 1. 决策树技术概述

决策树是一种广泛使用的机器学习算法,通过构建一个树形结构来进行决策。它的核心是将数据集分成多个子集,这些子集通过一系列的测试来区分,最终使得每个子集都尽可能属于同一类别。这种分裂过程基于不同的特征和属性,通过最大化信息增益或最小化基尼不纯度等标准来选择最佳的分割属性。

决策树因其结构直观、易于理解和解释而在多个领域得到广泛应用。它可以用于分类任务,也可以通过修改来解决回归问题。尽管决策树模型简单易懂,但在实际应用中,仍需要针对特定问题进行优化,例如防止过拟合,提高模型的准确性和泛化能力。

本章将深入探讨决策树的基本原理、构建过程以及如何在实际应用中进行优化和调参。我们将通过分析决策树的算法流程,理解其在分类和预测中的优势和局限性,并初步了解其在社交网络用户行为预测中的应用潜力。

# 2. 社交网络用户行为数据的基础分析

在社交媒体的浪潮下,用户的行为数据无时不刻不在产生,这些数据是理解用户需求、预测用户行为以及制定市场策略的重要依据。本章将详细介绍社交网络用户行为数据的特点、收集方法以及预处理、特征提取和数据探索与可视化的实践技巧。

## 2.1 用户行为数据的特点与收集

### 2.1.1 社交网络中的用户行为类型

在社交网络上,用户的活跃度和参与方式多种多样,而这些行为都可以被抽象为一系列的数据点。用户行为数据类型主要可以分为以下几类:

1. **互动行为数据**:包括点赞、评论、分享等互动活动,这类数据通常数量庞大,具有高度的实时性和时间序列特性。

2. **内容发布数据**:用户在社交平台上发布的内容,如文字、图片、视频等,这些数据往往包括文本、元数据等,可以用来分析用户的内容偏好和情绪变化。

3. **连接关系数据**:用户之间的关注、好友关系以及社交网络结构等,用于了解用户的社交圈子和影响力。

4. **浏览行为数据**:用户浏览的内容记录,可反映用户的兴趣点和行为模式。

### 2.1.2 数据收集方法与工具

收集社交网络用户行为数据的方法多种多样,常见的方法和工具有:

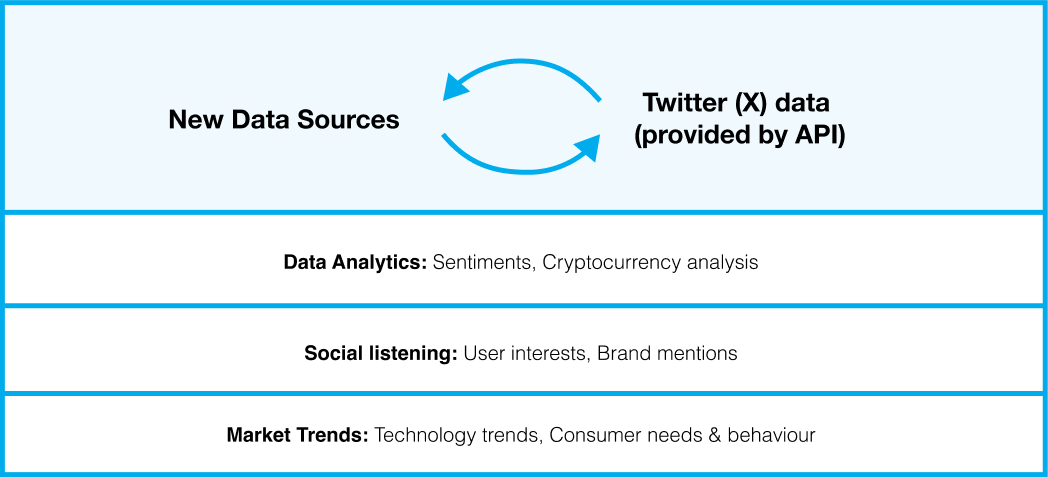

- **API采集**:利用社交网络平台提供的API接口进行数据采集是最为常见的方式,如Twitter API、Facebook Graph API等。

- **爬虫技术**:通过编写网络爬虫程序,可以自动化地从网站中抓取数据。但需注意社交平台的反爬虫策略。

- **第三方数据服务**:很多公司提供用户行为数据分析服务,并提供了API接口供用户直接获取分析结果。

- **日志文件**:通过分析服务器日志文件,能够获得用户在网站上的活动轨迹。

### 2.1.3 代码块与逻辑分析

下面的Python代码示例演示了如何使用Tweepy库调用Twitter API来收集用户的推文数据。

```python

import tweepy

# Twitter API的认证信息

auth = tweepy.OAuthHandler("CONSUMER_KEY", "CONSUMER_SECRET")

auth.set_access_token("ACCESS_TOKEN", "ACCESS_TOKEN_SECRET")

# 创建API对象

api = tweepy.API(auth)

# 用户ID

user_id = "USER_ID"

# 获取用户的推文

tweets = api.user_timeline(user_id=user_id, count=200)

# 打印推文

for tweet in tweets:

print(tweet.text)

```

**参数说明:**

- `CONSUMER_KEY` 和 `CONSUMER_SECRET` 是在Twitter开发者平台上申请的API和密钥。

- `ACCESS_TOKEN` 和 `ACCESS_TOKEN_SECRET` 是用户授权后的访问令牌和密钥。

- `USER_ID` 是目标用户的ID。

**代码逻辑:**

- 首先导入` tweepy`模块并设置API的认证信息。

- 创建一个API对象,用于与Twitter API进行交互。

- 通过用户的ID获取推文,并将推文的内容打印出来。

## 2.2 数据预处理和特征提取

### 2.2.1 缺失值处理与异常检测

在收集到的数据中,经常会出现缺失值或异常值,正确的处理方法可以提高后续分析的准确性和有效性。

**缺失值处理**:

- **删除缺失值**:适用于数据量大,缺失值占比小的情况。

- **填充缺失值**:可以使用均值、中位数、众数或者基于模型预测的值来填充。

**异常检测**:

- **统计方法**:通过分析数据的分布,使用Z-score或IQR(四分位距)来判断异常。

- **聚类分析**:利用K-means等聚类算法识别异常点。

### 2.2.2 特征选择与数据标准化

特征选择可以减少模型复杂度和提高模型性能,常用的方法包括:

- **过滤方法**:根据统计测试来选择特征,如卡方检验、信息增益等。

- **包装方法**:使用特定的模型来评估特征组合的性能,如递归特征消除(RFE)。

- **嵌入方法**:特征选择和模型训练同时进行,如Lasso回归。

数据标准化是将特征缩放至统一的范围或分布,常用的标准化方法有:

- **最小-最大标准化**:将数据缩放到[0,1]区间内。

- **Z分数标准化**:将数据转化为具有0均值和单位方差的分布。

### 2.2.3 代码块与逻辑分析

以下使用Python进行缺失值处理和数据标准化的代码示例。

```python

import pandas as pd

from sklearn.preprocessing import StandardScaler

# 加载数据集

df = pd.read_csv("user_behavior.csv")

# 删除缺失值

df.dropna(inplace=True)

# 使用Z分数标准化

scaler = StandardScaler()

df_scaled = scaler.fit_transform(df.select_dtypes(include=[np.number]))

# 将标准化后的数据转换回DataFrame

df_scaled = pd.DataFrame(df_scaled, index=df.index, columns=df.columns)

# 保存标准化后的数据集

df_scaled.to_csv("user_behavior_scaled.csv")

```

**参数说明:**

- `user_behavior.csv`:包含用户行为数据的CSV文件。

- `StandardScaler`:用于Z分数标准化的工具类。

**代码逻辑:**

- 加载存储用户行为数据的CSV文件到DataFrame。

- 使用`dropna()`方法删除包含缺失值的行。

- 利用`StandardScaler`对数值类型数据进行标准化处理。

- 将标准化后的数据转换回DataFrame并保存。

## 2.3 数据探索与可视化

### 2.3.1 描述性统计分析

描述性统计分析可以对数据集的中心趋势、分散程度、分布形状等进行描述。常用的描述性统计量包括均值、中位数、众数、方差、标准差等。

### 2.3.2 可视化技术在数据分析中的应用

数据可视化是数据分析中非常重要的一步,它可以帮助我们直观地理解数据。常用的数据可视化工具和技术包括:

- **散点图**:用于展示两个变量之间的关系。

- **直方图**:显示数据的分布情况。

- **箱型图**:展示数据的分散程度,可以快速发现异常值。

- **热力图**:适用于展示数据矩阵中的值的大小。

### 2.3.3 代码块与逻辑分析

下面是一个使用Python中的`matplotlib`和`seaborn`库来创建散点图和箱型图的代码示例。

```python

import matplotlib.pyplot as plt

import seaborn as sns

# 设置绘图风格

sns.set(style="whitegrid")

# 加载数据

data = pd.read_csv("user_behavior_scaled.csv")

# 创建散点图矩阵

sns.pairplot(data, kind='scatter')

# 创建箱型图展示特定变量的分布

variable = 'num_of_shares' # 假设我们想看分享次数的分布

sns.boxplot(data=data[variable])

```

0

0