网络爬虫实战:requests、BeautifulSoup、Scrapy的综合运用

发布时间: 2024-12-12 23:24:10 阅读量: 9 订阅数: 10

解析Python网络爬虫:核心技术、Scrapy框架、分布式爬虫全套教学资料

# 1. 网络爬虫基础概念与技术选型

## 1.1 网络爬虫基础概念

网络爬虫是一种自动化程序,它按照一定的规则,自动访问互联网上的网页,并从中提取所需数据。网络爬虫对于数据采集、搜索引擎索引构建、市场分析等众多互联网相关领域具有极其重要的价值。

## 1.2 技术选型的重要性

在网络爬虫的开发过程中,选择合适的技术栈是成功的关键。技术选型依赖于项目的复杂度、数据抓取的效率、数据处理的方便性以及最终的可扩展性。接下来,让我们深入探讨不同的技术选项,并给出实践建议。

# 2. 使用requests库进行HTTP请求处理

## 2.1 requests库的安装与基础使用

### 2.1.1 安装requests库

在Python中,`requests`库是最受欢迎的HTTP库之一,它提供了一种简单的方式来进行HTTP请求处理。安装`requests`库非常简单,可以使用pip(Python包管理器)完成安装,打开命令行工具执行以下命令:

```bash

pip install requests

```

一旦安装完成,便可在Python脚本中导入该模块,进行后续的HTTP请求操作。下面是一个简单的示例,展示如何导入`requests`模块:

```python

import requests

```

### 2.1.2 发送GET和POST请求

#### GET请求

`requests.get`方法用于发送GET请求。其基本语法如下:

```python

response = requests.get('http://example.com')

```

GET请求常用于获取网页内容。下面的代码演示了如何发起GET请求并获取响应状态码和网页内容:

```python

response = requests.get('http://httpbin.org/get')

print(response.status_code)

print(response.text)

```

#### POST请求

对于需要发送数据到服务器的场景,通常使用`requests.post`方法。其基本语法如下:

```python

response = requests.post('http://example.com', data=payload)

```

其中`data`参数是一个字典类型,包含了要发送的数据。下面的示例代码展示了如何发起POST请求:

```python

payload = {'key1': 'value1', 'key2': 'value2'}

response = requests.post('http://httpbin.org/post', data=payload)

print(response.status_code)

print(response.text)

```

**代码逻辑分析**

在上述代码中,我们首先导入了requests库,并创建了`GET`和`POST`请求。使用`requests.get`方法获取了HTTPBin的GET请求示例页面,并打印出了返回的状态码和响应内容。随后,我们模拟了一个表单提交的场景,创建了一个包含键值对的字典`payload`,通过`requests.post`方法发送到HTTPBin的POST请求示例页面,并同样打印出了状态码和响应内容。

## 2.2 高级HTTP请求特性

### 2.2.1 带有会话保持的请求

在`requests`库中,可以使用`requests.Session()`对象来维护会话,这样可以让我们保持某些参数,例如cookies、headers等,对于多个请求保持一致。

```python

session = requests.Session()

session.get('http://httpbin.org/cookies/set/sessioncookie/123456789')

response = session.get('http://httpbin.org/cookies')

print(response.text)

```

在这个例子中,我们创建了一个会话,并首先通过GET请求设置了一个cookie。之后的请求中,即使没有显式传递cookies,之前的cookie也会被自动发送。

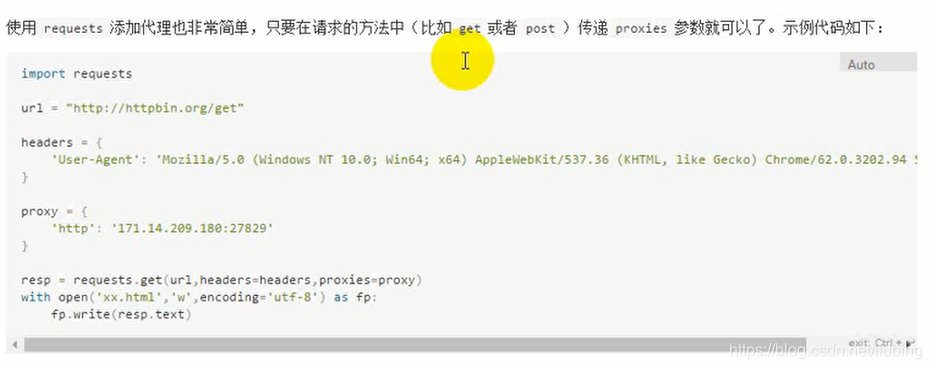

### 2.2.2 请求头部的自定义与伪装

当需要模拟浏览器访问时,我们通常需要自定义请求头部。使用`headers`参数可以轻松实现:

```python

headers = {'User-Agent': 'My User Agent 1.0'}

response = requests.get('http://httpbin.org/get', headers=headers)

print(response.text)

```

这里,我们通过设置`User-Agent`头部来模拟一个特定浏览器的访问。

### 2.2.3 异常处理与会话管理

在进行网络请求时,遇到异常是常见的情况。`requests`库通过异常处理机制提供了错误的处理方式:

```python

try:

response = requests.get('http://httpbin.org/get', timeout=1)

except requests.exceptions.Timeout:

print('Request Timeout')

```

在这个例子中,我们通过设置`timeout`参数来限制请求时间,超时后会触发`Timeout`异常。

## 2.3 requests库的实战演练

### 2.3.1 爬取网页内容

使用`requests`库可以轻松爬取网页内容。首先,通过发送GET请求获取HTML文档:

```python

url = 'http://example.com'

response = requests.get(url)

html_content = response.text

```

获取到的内容`html_content`是一个字符串,可以进一步解析。

### 2.3.2 数据提取与解析

提取数据通常使用`BeautifulSoup`库配合`requests`库一起使用。下面的代码演示了如何结合两者提取网页中的标题:

```python

from bs4 import BeautifulSoup

# 使用requests获取页面内容

response = requests.get('http://example.com')

# 使用BeautifulSoup解析HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 提取页面标题

title = soup.find('h1').text

print(title)

```

在上述代码中,我们首先使用`requests.get`获取到页面的HTML内容,然后通过`BeautifulSoup`解析HTML文档,并使用`.find()`方法定位并提取`h1`标签内的文本内容。

**mermaid 流程图**

为了更直观展示上述请求和解析的过程,我们可以用一个mermaid流程图表示:

```mermaid

graph LR

A[开始] --> B{请求网页}

B -->|成功| C[获取HTML内容]

C --> D[使用BeautifulSoup解析]

D --> E[提取数据]

E --> F[结束]

B -->|失败| G[异常处理]

G --> F

```

这个流程图展示了从发起请求到数据提取完成的整个过程。在执行请求时,可能会遇到异常,所以需要进行异常处理。

以上章节内容为第二章的详细解读,涉及requests库的安装、基础使用和一些高级特性,以及在实战演练中与BeautifulSoup的结合使用。这一章节对于理解如何使用Python中的requests库进行有效的HTTP请求处理提供了全面的介绍和示例。

# 3. 使用BeautifulSoup解析HTML/XML

## 3.1 BeautifulSoup的安装与基础

### 3.1.1 安装BeautifulSoup库

BeautifulSoup是一个Python库,用于解析HTML和XML文档。它能够遍历、搜索和修改解析树,非常适合于网络爬虫中进行数据提取。安装BeautifulSoup非常简单,可以通过pip包管理器来完成。

在命令行中,执行以下命令可以安装BeautifulSoup库:

```bash

pip install beautifulsoup4

```

你还需要一个HTML或XML解析器,如lxml,因为BeautifulSoup本身不是一个独立的解析器。lxml库可以提供更快的解析速度,安装如下:

```bash

pip install lxml

```

安装完成后,你可以开始使用BeautifulSoup了。

### 3.1.2 解析HTML和XML文档

BeautifulSoup提供了一个非常简单的接口来解析文档,并从文档中提取所需的信息。以下是一个简单的例子,展示了如何使用BeautifulSoup解析一个简单的HTML文档:

```python

from bs4 import BeautifulSoup

# 示例HTML文档

html_doc = """

<html>

<head>

<title>示例网页</title>

</head>

<body>

<p class="title"><b>这是一个标题</b></p>

<p class="content">这是一个段落。</p>

</body>

</html>

# 创建BeautifulSoup对象,并指定解析器为'lxml'

soup = BeautifulSoup(html_doc, 'lxml')

# 打印出文档的title标签

print(soup.title)

# <title>示例网页</title>

```

在这个例子中,我们首先导入了BeautifulSoup类,然后创建了一个BeautifulSoup对象,这个对象代表了我们要解析的HTML文档。通过指定解析器为'lxml',我们使用了lxml库来解析HTML。最后,我们通过访问`.title`属性来获取文档的title标签。

## 3.2 数据定位与抽取技巧

### 3.2.1 标签选择器的使用

使用标签选择器是最简单直接的从HTML文档中提取信息的方式。BeautifulSoup提供了直观的接口来访问文档中的标签。

```python

# 获取所有的<p>标签

p_tags = soup.find_all('p')

for p in p_tags:

print(p.get_text())

# 这是一个标题

# 这是一个段落。

```

在这个例子中,我们使用`.find_all()`方法来找到所有的`<p>`标签,并通过`.get_text()`

0

0